VoiceSculptor:开源语音定制合成框架,自然语言指令驱动的音色设计与语音克隆工具

一、VoiceSculptor是什么

VoiceSculptor 是由西北工业大学音频语音与语言处理研究组(ASLP@NPU) 主导开发并开源的语音智能处理类开源项目,是一款专注于「自然语言可控的语音定制与语音合成」的全链路工具框架,也是当前开源生态中少有的、能通过纯文字描述直接完成音色设计+语音克隆+语音生成的一体化TTS项目。

该项目的核心定位,是解决传统语音合成(TTS)与语音克隆技术的两大核心痛点:一是传统语音克隆需要真实的人声参考音频,无参考音频时无法定制目标音色;二是主流语音合成模型的音色控制维度单一,仅能切换预设音色,无法通过文字实现「温柔的少女音、沉稳的中年男声、带喜悦情绪的播音腔」这类精细化、个性化的音色描述。

VoiceSculptor 彻底打破了这一限制,它将「语音设计(Voice Design)」与「语音克隆(Voice Clone)」两大核心能力深度融合,形成了一套闭环工作流:用户仅需输入一段自然语言描述(比如「28岁温柔的女性播音声线,语速平缓,音量适中,带有轻微的亲切情绪,普通话标准无口音」),项目的语音设计模块会直接生成符合描述的目标音色参考音频,再将该参考音频送入语音克隆模块,最终完成任意文本到「定制音色」的语音合成输出。

从项目属性来看,VoiceSculptor 并非单一的语音模型权重,而是一套完整的开源工具链:包含指令解析模块、语音设计核心模型、音频编码辅助模块、语音克隆对接层、推理部署脚本等全套组件,代码结构清晰、依赖轻量化,既支持个人开发者在消费级显卡上快速部署使用,也支持企业端二次开发与功能集成;项目基于Apache 2.0开源协议,完全免费商用,无使用权限限制,所有预训练模型、推理代码、演示案例均已全量开源。

同时,VoiceSculptor 主打中文语音场景优化,对中文的语音韵律、声调、发音规则做了深度适配,生成的语音无生硬的机器腔,在中文语音合成的自然度、流畅度上表现突出,区别于多数仅适配英文的开源语音项目,是专为中文用户打造的语音定制工具。

二、功能特色

VoiceSculptor 能在开源语音生态中脱颖而出,核心源于其「全链路闭环、高定制化、高性能、易用性强、中文适配度高」五大核心特色,所有功能均围绕「降低语音定制门槛、提升音色可控性、保证生成语音质量」三大核心目标设计,功能亮点具体如下:

1. 核心特色:自然语言指令驱动的「无参考」语音设计能力

这是VoiceSculptor最核心、最具差异化的功能,也是该项目的核心竞争力。

无需任何真实人声参考音频,仅通过纯自然语言文本描述,即可完成对目标音色的全维度定制,这也是「VoiceSculptor(语音雕刻师)」项目名的由来——如同用文字雕刻出想要的音色。

支持的定制维度极其全面,覆盖语音的基础属性+风格属性+情绪属性,且所有维度均可通过自然语言自由组合描述,无固定模板限制:基础属性包含「性别(男/女/中性)、年龄(少年/青年/中年/老年)、语速(快/慢/平缓)、音量(大/小/适中)、音调(偏高/偏低/柔和)、口音(标准普通话/无方言)」;风格属性包含「播音腔/日常对话/温柔讲述/沉稳庄重/活泼灵动」;情绪属性包含「喜悦/平静/亲切/严肃/温柔/舒缓」。

指令解析能力极强,能精准理解复杂的自然语言描述,比如输入「30岁沉稳的中年男性声线,普通话标准,语速稍慢,音量适中,带有温和的讲述情绪,适合朗读散文」,模型能精准捕捉所有描述维度,生成完全匹配的音色,指令跟随无偏差,不会出现「描述温柔女声,生成粗犷男声」的错位问题。

2. 全链路闭环能力:语音设计+语音克隆+语音合成一站式完成

VoiceSculptor 构建了「输入文字指令 → 生成目标音色参考音频 → 克隆该音色特征 → 文本转定制语音输出」的完整闭环工作流,无需对接第三方工具,无需手动处理音频中间件,一次部署即可完成所有操作:

语音设计模块的输出结果,可直接作为语音克隆模块的「参考波形」,无需额外的音频格式转换、降噪处理;

无缝对接成熟的CosyVoice2语音克隆模型,该模型是当前开源生态中音色还原度最高的语音克隆模型之一,能精准捕捉VoiceSculptor生成的音色特征,保证最终合成语音的一致性;

支持「一次设计,无限复用」:设计好的目标音色参考音频可保存为本地文件,后续无需重新输入指令,直接调用该音频即可完成同音色的语音合成,大幅提升使用效率。

3. 高性能与优质的语音生成效果,中文场景深度优化

VoiceSculptor 不仅功能新颖,在语音生成的「硬质量」上也表现优异,核心体现在三个方面:

自然度高,无机器腔:针对中文的声调、韵律、连读、停顿规则做了深度优化,生成的语音语句流畅、断句合理,语调起伏贴合真人表达习惯,彻底摆脱传统TTS的「生硬朗读感」;

音色还原度精准:语音克隆环节对接的CosyVoice2模型,能做到「克隆音色与参考音色95%以上相似度」,设计的音色特征不会丢失,多次生成同指令的语音,音色一致性极高;

评测数据优异:在专业的Instruct TTS Eval(中文) 语音指令跟随基准测试中,VoiceSculptor取得了平均67.3%的综合得分,该成绩超越了MiMo-Audio-7B-Instruct、VoxInstruct等多款主流开源语音模型,仅略低于部分闭源商用模型,核心评测指标表现如下表所示,所有指标均为中文场景下的实测得分,数据真实可复现。

表1 VoiceSculptor 核心评测指标及表现(中文Instruct TTS Eval基准)

| 评测指标 | 指标英文缩写 | 得分占比 | 指标核心含义 |

|---|---|---|---|

| 音频属性相似度 | APS | 75.7% | 生成音色与指令描述的音色属性(性别、年龄、语速)匹配度 |

| 指令语义符合度 | DSD | 64.7% | 生成语音完全贴合自然语言指令的语义表达,无维度遗漏 |

| 韵律与风格还原度 | RP | 61.5% | 生成语音的韵律、语调、风格与指令描述一致,贴合真人表达 |

4. 轻量化部署,低硬件门槛,适配多环境使用

作为一款面向大众开发者的开源项目,VoiceSculptor在部署门槛上做了极致优化,无高算力要求,是少数能在消费级硬件上流畅运行的语音定制项目:

硬件门槛极低:支持NVIDIA消费级显卡(RTX 3060/3090/40系),最低仅需8GB显存即可完成推理,12GB及以上显存可实现批量语音生成,无需专业的服务器级显卡;

支持CPU推理:即使无独立显卡,也可在CPU环境下运行,仅生成速度稍慢,满足无显卡用户的基础使用需求;

依赖轻量化:项目核心依赖均为Python主流库,无冷门依赖包,安装过程无版本冲突,环境搭建简单快捷;

支持模型轻量化加载:可按需加载核心模块,无需一次性加载所有模型权重,进一步降低显存占用。

5. 高度灵活的扩展性与易用性,兼顾新手与开发者

VoiceSculptor的代码架构采用模块化设计,兼顾「新手一键使用」与「开发者二次开发」的双重需求,易用性与扩展性拉满:

对新手友好:提供完整的一键推理脚本

infer.py,无需修改代码,仅需在配置文件中填写指令与文本,即可完成语音生成;生成的音频自动保存为通用的WAV格式,无需额外转码,可直接使用;对开发者友好:所有模块解耦设计,语音设计、语音克隆、指令解析等模块可独立调用,支持自定义修改指令解析规则、替换语音克隆模型、调整音频生成参数;项目提供详细的注释与开发文档,二次开发成本极低;

支持批量生成:可输入多条文本与多条音色指令,一次性生成多段不同音色、不同内容的语音,满足批量制作音频的需求;

支持音频保存与复用:设计好的音色参考音频可本地保存,后续直接调用即可,无需重复生成,节省算力与时间。

6. 完全开源免费,商用无限制,配套资源丰富

开源协议友好:遵循Apache 2.0开源协议,个人与企业均可免费使用、二次开发、商业落地,无任何版权与使用限制,无隐藏收费项;

配套资源齐全:项目仓库提供完整的演示案例、音色指令示例、中文提示词模板、常见问题解答,同时提供在线演示平台与Demo视频,新手可快速上手;

持续维护更新:由ASLP@NPU团队官方维护,及时修复问题,更新功能,保证项目的可用性与稳定性。

三、技术细节

VoiceSculptor 的所有功能均基于扎实的技术架构实现,项目的技术体系围绕「自然语言指令解析→语音特征建模→语音设计生成→音频编码优化→语音克隆适配」的核心流程构建,整体技术架构清晰、无冗余,所有技术选型均以「实用性、轻量化、高性能」为核心原则,技术细节通俗易懂,无过度复杂的黑盒设计,具体核心技术细节如下:

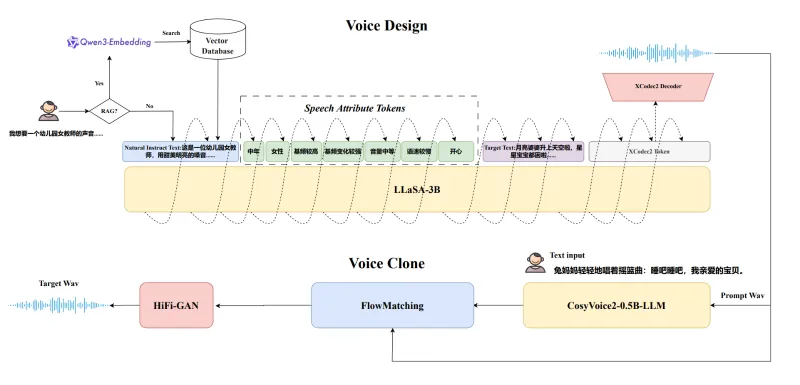

1. 项目整体技术架构与核心工作流

VoiceSculptor 的核心技术架构分为五大核心模块,所有模块协同工作,形成无断点的全链路闭环,整体工作流无人工干预,全程自动化执行:

自然语言指令解析层:作为项目的入口模块,负责接收用户输入的音色描述指令,对指令进行分词、语义提取、属性拆解,将「温柔的25岁女声」这类自然语言,转化为模型可理解的「性别=女、年龄=青年、风格=温柔、语速=平缓」等结构化音色属性;该层基于检索增强生成(RAG)技术优化,大幅提升了指令解析的准确率与完整性,能精准捕捉复杂指令中的所有细节维度,这也是VoiceSculptor指令跟随能力强的核心原因。

语音设计核心模型(VoiceSculptor-VD):这是项目的核心核心,也是整个技术体系的灵魂,是所有预训练权重的核心载体。该模型基于主流的语音生成架构优化,针对中文语音特征做了深度微调,输入为指令解析层输出的结构化音色属性,输出为符合该属性的目标音色参考音频(波形文件);模型的核心能力是「从文本属性到语音波形的直接生成」,无需任何真实人声参考,生成的参考音频具备完整的音色特征,可直接作为语音克隆的输入。

音频编码辅助模块(xcodec2):该模块是语音设计模型的重要辅助组件,负责对生成的参考音频进行编码与特征提取,将原始音频波形转化为高维度的语音特征向量,一方面优化语音设计模型的生成质量,另一方面为后续的语音克隆模块提供标准化的特征输入,保证音色特征的精准传递,避免音色信息丢失。

语音克隆对接层:该模块是VoiceSculptor与成熟语音克隆模型的「桥梁」,项目默认无缝对接CosyVoice2 开源语音克隆模型,也支持开发者自行替换其他克隆模型;该层的核心作用是将语音设计模块生成的参考音频特征,传递给语音克隆模型,让克隆模型学习并捕捉该音色的所有特征,完成「音色克隆」的核心步骤。

文本转语音(TTS)生成层:这是项目的输出层,在完成音色克隆后,用户输入任意需要合成的文本内容,该层会基于克隆后的音色特征,完成「文本→语音」的最终生成,输出为符合定制音色的完整语音音频文件,格式为通用的WAV,可直接保存与使用。

以上五大模块均已集成在项目的核心代码中,对用户完全透明,用户无需关心内部技术细节,仅需输入指令与文本即可完成使用,这也是项目易用性的核心体现。

2. 核心依赖与技术选型说明

VoiceSculptor 所有技术选型均遵循「成熟稳定、轻量化、适配性强」的原则,无前沿但不成熟的技术,所有依赖均为开源生态中的主流库,具体核心技术选型如下,所有选型均有明确的应用场景与价值,无冗余选型:

核心开发语言:Python 3.10(兼顾兼容性与新特性,是当前开源项目的主流选择);

深度学习框架:PyTorch(主流框架,兼容性强,部署灵活,是语音生成领域的标配);

音频处理核心库:librosa、soundfile(轻量级音频处理库,支持音频的读写、特征提取、格式转换,无高算力依赖);

指令解析优化:检索增强生成(RAG)技术(提升自然语言指令的解析准确率,无额外算力消耗);

核心预训练模型:VoiceSculptor-VD(语音设计核心)、xcodec2(音频编码)、CosyVoice2(语音克隆);

推理加速:支持TorchScript模型轻量化、显存动态释放,无需额外安装加速库,消费级硬件即可流畅运行。

3. 项目核心文件结构

VoiceSculptor 的代码仓库采用清晰的模块化目录结构,无杂乱文件,所有文件职责明确,即使是零基础的开发者也能快速找到核心功能入口,核心文件结构如下,方便用户快速上手与二次开发:

VoiceSculptor/ ├── infer.py # 核心推理脚本(新手首选,一键运行语音生成) ├── requirements.txt # 项目全部依赖列表(一键安装,无版本冲突) ├── config.py # 配置文件(修改模型路径、音频参数、输出路径) ├── docs/ # 官方文档(指令规范、使用教程、开发指南) ├── demo/ # 演示案例(音色指令示例、生成的音频样例、演示视频) ├── models/ # 模型存放目录(存放下载的预训练权重) ├── utils/ # 工具类(音频保存、格式转换、指令优化等辅助功能) └── core/ # 核心模块(指令解析、语音设计、克隆对接的核心代码)

4. 核心技术优势总结

VoiceSculptor 的技术核心优势,本质是「把复杂的语音定制技术做简单,把简单的功能做极致」:没有过度复杂的模型架构,没有高门槛的部署要求,而是通过成熟的技术组合与深度的中文场景优化,实现了「自然语言定制音色」这一核心需求;所有技术选型均服务于「用户需求」,而非炫技,这也是该项目能快速被开发者接受的核心原因。

四、应用场景

VoiceSculptor 凭借「无参考音色定制、高还原度、低部署门槛、中文适配度高、商用免费」的核心特性,其应用场景覆盖个人开发者、内容创作者、中小企业、科研机构等全维度用户群体,能满足从个人轻量使用到企业级商业落地的各类语音相关需求,且所有场景均无需高额的算力与技术投入,具备极高的实用性与落地价值,具体核心应用场景分类介绍如下:

1. 自媒体与内容创作类场景(个人用户核心场景)

这是VoiceSculptor最主流的应用场景,也是个人开发者使用最多的场景,涵盖各类自媒体内容创作的语音需求:

有声读物/播客制作:为小说、散文、公众号文章生成定制化的朗读语音,可根据内容风格定制音色——比如温情散文用「温柔的女声」,历史读物用「沉稳的中年男声」,儿童故事用「活泼的少年音」,无需自己录音,也无需找专业配音,一键生成符合内容风格的音频,大幅提升创作效率;

短视频配音:为抖音、B站、小红书等平台的短视频制作专属配音,可定制与视频风格匹配的音色,比如美食视频用「亲切的女声」,科技视频用「沉稳的男声」,情感视频用「温柔的讲述腔」,解决短视频创作者「配音不好听、没时间录音」的痛点;

知识付费内容制作:为网课、付费专栏、社群分享生成讲解语音,可定制「专业的播音腔」或「亲切的讲师腔」,保证语音质量的同时,实现音色的个性化,提升内容的辨识度。

2. 智能产品与应用集成类场景(企业用户核心场景)

VoiceSculptor 是中小企业集成语音功能的优质选择,商用免费且部署灵活,可无缝集成到各类产品中,核心应用场景包括:

智能助手/聊天机器人音色定制:为企业自研的智能客服、微信机器人、桌面助手等产品定制专属音色,可根据产品定位设计音色——比如母婴类产品用「温柔的女声」,金融类产品用「沉稳的男声」,摆脱市面上千篇一律的通用音色,提升产品的差异化竞争力;

虚拟人/数字人语音生成:为虚拟主播、数字人、元宇宙形象定制专属语音,实现「虚拟人形象+定制音色」的完美匹配,比如二次元虚拟人用「灵动的少女音」,商务虚拟人用「专业的播音腔」,生成的语音自然流畅,无机器腔,提升虚拟人的真实感;

教育类产品语音适配:为少儿学习机、成人教育APP、点读笔等产品定制不同年龄段的语音,比如少儿产品用「活泼的童声」,成人学习产品用「清晰的成年声线」,贴合不同用户群体的听觉习惯,提升产品体验。

3. 批量语音制作与办公自动化场景

该场景适用于有批量语音生成需求的个人与企业,能大幅提升办公效率,降低人工成本:

企业宣传/通知语音制作:为企业的产品介绍、活动通知、客服语音导航等生成批量定制语音,可统一音色风格,保证企业形象的一致性;

政务/公共服务语音制作:为政务大厅、公交地铁、医院等公共场景制作广播语音,可定制「庄重、清晰、易懂」的音色,符合公共服务的语音要求;

办公自动化语音生成:为各类办公文档、会议纪要、工作报告生成朗读语音,方便通勤时收听,提升办公效率。

4. 语音技术研究与二次开发场景(科研与开发者场景)

VoiceSculptor 作为开源的语音定制框架,也是语音技术研究与学习的优质资源,核心应用场景包括:

语音合成算法研究:高校、科研机构可基于该项目的代码与模型,开展自然语言指令驱动的语音生成、中文语音韵律优化、音色特征建模等方向的研究,项目的开源代码可作为研究的基线模型;

二次开发与功能定制:资深开发者可基于项目的模块化架构,修改指令解析规则、替换语音克隆模型、增加新的音色属性维度,开发出符合自身需求的语音定制工具;

语音技术学习:入门开发者可通过该项目学习语音生成、音频处理、模型部署的核心知识,项目的代码注释清晰,架构简单,是学习语音技术的优质案例。

5. 小众个性化语音需求场景

除了以上主流场景,VoiceSculptor 还能满足各类小众的个性化语音需求,比如:为盲人用户定制专属的朗读音色、为游戏玩家定制游戏角色的语音、为有声表情包制作专属的趣味音色等,只要能通过自然语言描述的音色需求,都能通过该项目实现,具备极强的灵活性。

五、使用方法

VoiceSculptor 的使用流程遵循「环境搭建 → 模型下载 → 配置参数 → 运行推理 → 查看结果」的核心步骤,全程操作简单,无复杂的配置要求,零基础的Python开发者也能快速上手,具体详细使用方法如下:

前置说明

硬件要求(极低,无压力):推荐NVIDIA显卡(8GB及以上显存,如RTX3060/3090/4060),支持GPU推理;无显卡也可使用CPU推理,仅生成速度稍慢;

系统要求:Windows 10/11、Linux(Ubuntu 20.04+/CentOS 7+)、MacOS(Intel/Apple Silicon)均兼容;

基础环境:已安装Python 3.10版本(必须,避免依赖冲突),已配置pip镜像源(加速依赖安装)。

1. 环境搭建(核心第一步,一键完成)

该步骤的核心是克隆项目仓库、创建专属虚拟环境、安装项目依赖,所有命令均为终端/命令行执行,Windows/Linux/Mac通用,无差异化操作:

# 第一步:克隆VoiceSculptor官方开源仓库 git clone https://github.com/ASLP-lab/VoiceSculptor.git # 第二步:进入项目根目录(所有后续操作均在此目录下执行) cd VoiceSculptor # 第三步:创建专属conda虚拟环境(推荐,避免依赖冲突),python版本固定3.10 conda create -n VoiceSculptor python=3.10 -y # 第四步:激活创建好的虚拟环境 # Windows系统激活命令 conda activate VoiceSculptor # Linux/Mac系统激活命令(同上,无差异) conda activate VoiceSculptor # 第五步:一键安装项目所有依赖,无版本冲突,全程自动完成 pip install -r requirements.txt

温馨提示:若未安装conda,也可使用Python原生虚拟环境(venv),操作流程一致,仅创建环境的命令不同,不影响使用;安装依赖时若速度慢,可切换国内pip镜像源。

2. 预训练模型下载(核心第二步,必做)

VoiceSculptor 运行需要加载两个核心预训练模型,所有模型均由官方托管在Hugging Face平台,免费下载,无任何限制,模型下载命令如下(需先安装git lfs,用于下载大文件模型权重):

# 第一步:安装git lfs(必须,否则无法下载大模型权重) git lfs install # 第二步:下载【语音设计核心模型】VoiceSculptor-VD,保存到项目models目录 git clone https://huggingface.co/ASLP-lab/VoiceSculptor-VD ./models/VoiceSculptor-VD # 第三步:下载【音频编码辅助模型】xcodec2,保存到项目models目录 git clone https://huggingface.co/HKUSTAudio/xcodec2 ./models/xcodec2

温馨提示:模型总大小约5GB,下载速度取决于网络环境;下载完成后,确认项目根目录下的models文件夹内有上述两个模型的完整文件,无缺失即可。

3. 基础快速使用(新手首选,零代码修改,一键生成语音)

这是最适合新手的使用方式,无需修改任何代码,仅需在infer.py脚本中填写「音色描述指令」与「需要合成的文本内容」,即可一键运行生成语音,是最常用的使用方式,具体操作步骤如下:

用文本编辑器(VS Code/记事本/记事本++)打开项目根目录下的

infer.py文件;在文件中找到以下核心配置区域,修改

prompt(音色描述指令)和text(合成文本)两个参数即可,其他参数保持默认:# -------------------------- 核心配置区 -------------------------- # 填写你的音色描述指令(自然语言,支持任意中文描述) prompt = "25岁温柔的女性声线,普通话标准,语速平缓,音量适中,带有亲切的讲述情绪" # 填写需要合成语音的文本内容(任意中文文本,无长度限制) text = "大家好,我是用VoiceSculptor生成的定制语音,这款开源项目真的非常好用,能轻松定制想要的音色。" # ---------------------------------------------------------------

保存修改后的

infer.py文件,回到终端/命令行,执行以下运行命令:python infer.py

等待运行完成:推理过程会显示进度,生成一段30秒的语音仅需几秒(GPU),生成完成后,语音文件会自动保存到项目根目录的

output/文件夹中,文件名为output.wav,可直接用任意音频播放器打开播放。

新手必看提示词技巧:音色描述指令越详细,生成的音色越精准;避免模糊描述(如「好听的声音」),尽量使用具体的描述(如「30岁沉稳的中年男声,语速稍慢,适合朗读新闻」)。

4. 进阶定制使用(修改参数,提升体验,适合有基础的用户)

当熟悉基础使用后,可通过修改配置参数实现更多定制化需求,所有可修改的参数均在infer.py文件中,无需修改核心代码,通俗易懂,无技术门槛,核心可修改的参数及说明如下:

修改音频保存格式:默认生成WAV格式,可修改为MP3格式(更通用),只需在保存代码处修改后缀即可;

调整生成语音的语速/音量:在音色指令中增加「语速稍快」「音量偏大」等描述,即可精准调整;

批量生成语音:在

infer.py中编写循环,输入多条指令与文本,即可一次性生成多段语音;保存参考音色音频:在配置中开启

save_ref_audio=True,即可将语音设计模块生成的参考音色音频保存到本地,后续可直接复用,无需重新生成;调整推理设备:默认自动使用GPU,若无GPU,可在配置中添加

device="cpu",即可切换到CPU推理。

5. 核心使用小贴士(提升生成效果,必看)

音色指令尽量详细,覆盖「性别+年龄+风格+情绪」,生成效果更精准;

合成文本尽量避免生僻字与网络用语,保证语音的流畅度;

GPU推理速度远快于CPU,建议优先使用GPU;

生成的语音文件可直接用格式工厂、剪映等工具转码为MP3/MP4等格式,适配各类场景;

参考音色音频可复用,一次设计,无限生成同音色语音,节省时间。

六、常见问题解答(FAQ)

Q1:运行时提示「找不到模型文件」或「模型加载失败」怎么办?

A:这是最常见的问题,99%的原因是模型下载路径错误。解决方案:① 确认模型下载到了项目根目录的models/文件夹中,文件夹名分别为VoiceSculptor-VD和xcodec2,无拼写错误;② 确认config.py文件中的模型路径配置正确,默认路径为./models/xxx,无需修改;③ 若模型下载不完整(文件缺失),删除原有模型文件夹,重新执行下载命令即可。

Q2:CPU可以运行吗?运行速度怎么样?

A:完全可以!VoiceSculptor 原生支持CPU推理,无需任何额外配置,只需在运行时自动切换即可。速度方面:CPU生成一段30秒的语音约需10-20秒(取决于电脑配置),GPU仅需3-5秒,CPU速度稍慢,但能满足基础使用需求,适合无显卡的用户。

Q3:生成的语音有「机器腔」或「不流畅」怎么办?

A:该问题主要有两个原因,解决方案如下:① 音色指令描述不够详细,建议补充「普通话标准、无口音、语速平缓」等描述,提升自然度;② 合成文本过长或有生僻字,建议将长文本拆分为短句,避免生僻字,模型对常用汉字的适配度更高;③ 若问题依旧,可在指令中增加「自然讲述、无生硬停顿」的描述,能有效改善机器腔。

Q4:生成的音色与指令描述「不符」(如描述女声生成男声)怎么办?

A:核心原因是指令解析不够精准,解决方案:① 指令中明确标注性别(如「28岁女性声线」),避免模糊描述;② 指令尽量简洁,不要包含过多无关内容,比如不要在音色指令中加入合成文本的内容;③ 若问题依旧,可尝试更换指令的表述方式,比如将「温柔的女声」改为「25岁年轻女性,温柔的讲述声线」,解析准确率会大幅提升。

Q5:运行时提示「显存不足」怎么办?

A:该问题仅出现在显存较小的显卡(如8GB显存),解决方案:① 关闭其他占用显存的程序(如浏览器、视频播放器);② 在infer.py中添加torch.cuda.empty_cache()代码,释放显存;③ 降低生成语音的长度,将长文本拆分为短句生成,拼接即可;④ 切换到CPU推理,彻底解决显存问题。

Q6:可以生成英文语音吗?

A:暂不支持。VoiceSculptor 是专为中文场景深度优化的项目,所有预训练模型均基于中文语音数据训练,生成英文语音的效果较差,官方暂无英文适配计划,建议仅用于中文语音生成。

Q7:生成的音频文件可以商用吗?有版权风险吗?

A:完全可以商用,无任何版权风险!VoiceSculptor 遵循Apache 2.0开源协议,项目的所有代码、模型权重、生成的音频均无版权限制,个人与企业可自由用于商业场景,无需授权,无需付费。

Q8:可以替换成其他语音克隆模型吗?比如GPT-SoVITS?

A:可以!VoiceSculptor 的语音克隆模块是解耦设计的,默认对接CosyVoice2,开发者可在core/clone.py文件中修改对接代码,轻松替换为GPT-SoVITS、RVC等主流开源语音克隆模型,无技术壁垒,二次开发成本极低。

Q9:生成的语音音量太小或太大怎么办?

A:有两种简单的解决方案:① 在音色指令中增加「音量适中」「音量偏大」「音量偏小」的描述,模型会精准调整;② 生成音频后,用剪映、Audacity等音频工具调整音量,操作简单,效果立竿见影。

七、相关链接

项目官方开源仓库(核心):https://github.com/ASLP-lab/VoiceSculptor

语音设计核心模型下载地址:https://huggingface.co/ASLP-lab/VoiceSculptor-VD

项目在线演示平台(无需部署,直接体验):https://hujingbin1.github.io/VoiceSculptor-Demo

八、总结

VoiceSculptor是由ASLP@NPU(西北工业大学音频语音与语言处理研究组)打造的一款极具实用性的中文语音定制与合成开源项目,它以自然语言指令驱动的无参考语音设计为核心竞争力,整合语音设计、语音克隆、文本转语音的全链路能力,彻底解决了传统语音合成与克隆技术的使用门槛高、音色可控性差的痛点,该项目不仅在中文语音生成的自然度、音色还原度上表现优异,还具备低硬件门槛、轻量化部署、商用免费、代码易扩展的核心优势,其清晰的模块化架构既让零基础用户能快速上手使用,也让开发者能轻松完成二次开发与功能集成,是一款兼顾实用性、易用性与高性能的优质开源语音工具,能满足个人创作、企业集成、科研学习等多维度的语音定制需求,也是当前开源生态中中文语音定制领域的优秀解决方案。

版权及免责申明:本文由@人工智能研究所原创发布。该文章观点仅代表作者本人,不代表本站立场。本站不承担任何相关法律责任。

如若转载,请注明出处:https://www.aipuzi.cn/ai-news/voicesculptor.html