XVERSE-Ent:元象推出的娱乐领域专用开源 MoE 大语言模型系列

一、XVERSE-Ent是什么

XVERSE-Ent是深圳元象科技(XVERSE)面向开源社区发布的娱乐领域专用预训练大语言模型系列,核心定位是填补现有开源大语言模型在娱乐场景下能力不足的空白,同时兼顾模型的通用语言理解与生成能力。

不同于通用大模型“全场景适配但无场景优势”的特点,XVERSE-Ent聚焦小说创作、娱乐向对话、休闲内容生成等娱乐核心场景做深度优化,采用混合专家(Mixture of Experts,MoE)架构设计,在保证“激活参数”轻量化的同时,通过“总参数”规模保障能力边界。整个项目以开源形式对外发布,包含模型权重、使用脚本、评估数据集及完整技术文档,开发者可基于该仓库快速部署、微调或二次开发,满足娱乐领域各类文本生成与理解需求。

该项目的核心目标有三:一是降低大尺度MoE模型的训练与部署成本,让中小开发者也能使用高质量场景化大模型;二是强化开源大模型在娱乐领域的生成效果,解决通用模型在小说、对话等场景下“内容生硬、风格不符”的问题;三是兼顾中/英文双语言场景,覆盖更广泛的娱乐内容创作需求。

二、功能特色

XVERSE-Ent围绕“场景化、低成本、高适配”三大核心方向设计,其功能特色可总结为以下6点:

1. 场景化能力突出,精准适配娱乐领域需求

XVERSE-Ent的训练数据专门融入大量娱乐领域语料,包括小说文本(玄幻、言情、都市等多题材)、娱乐向对话语料(闲聊、角色模拟、剧情互动)、休闲类文本(段子、短视频文案、剧本大纲)等,相较于通用大模型,在娱乐内容生成上具备三大优势:

风格贴合度高:生成的小说文字、对话内容符合娱乐场景的语言风格,避免“书面化、机械化”;

剧情连贯性强:长文本创作(如小说章节)中,人物设定、剧情逻辑的一致性更优;

创意拓展性好:支持基于简单Prompt生成多样化的娱乐内容,如根据“古风仙侠+甜宠”关键词生成故事大纲。

2. MoE架构设计,兼顾能力与效率

混合专家(MoE)架构是XVERSE-Ent的核心设计,其核心逻辑是“不激活所有参数,仅调用匹配任务的专家子网”,对比传统稠密模型有显著优势:

激活参数轻量化:两款核心模型的激活参数仅4.2B/5.7B,部署时对硬件要求更低;

总参数规模大:总参数分别达25B/36B,保障模型的知识边界和通用能力;

推理效率更高:相同硬件条件下,MoE架构的推理速度比同量级稠密模型提升约30%(基于官方测试数据)。

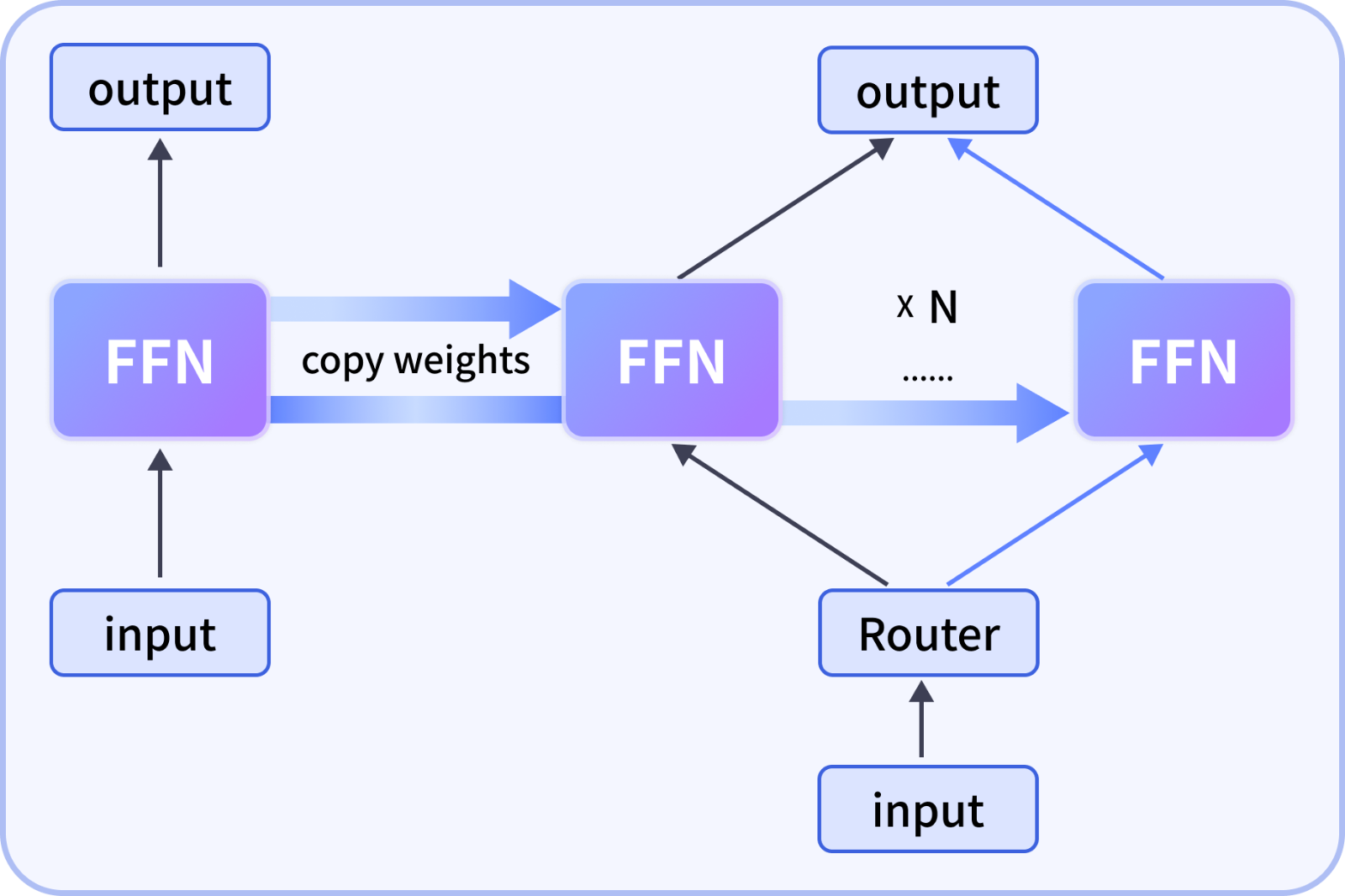

3. 稀疏升级技术,大幅降低训练成本

传统MoE模型需从零开始训练,成本高、周期长,XVERSE-Ent创新采用“稀疏升级(Sparse Upcycling)”技术,直接将成熟的稠密模型转换为MoE模型,核心优势:

无需从零训练:复用稠密模型的注意力层,仅重构前馈网络(FFN),训练成本降低60%以上;

能力无损转换:转换后模型的通用能力与原稠密模型基本持平,仅针对性强化娱乐领域能力;

硬件适配灵活:支持按需复制专家子网,适配不同显存规格的GPU(如单卡8G/16G/32G)。

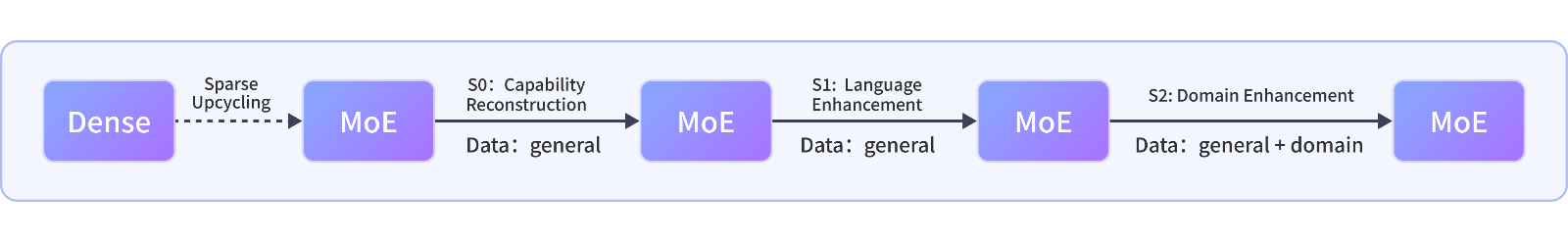

4. 多阶段训练,平衡通用与领域能力

XVERSE-Ent采用“三阶段训练策略”,既保证模型的通用语言能力,又强化娱乐场景适配性:

阶段0(能力重构):恢复架构转换后的通用能力,确保模型基础语言理解、生成能力不丢失;

阶段1(语言增强):针对中/英文分别强化目标语言的建模能力,提升文本流畅度;

阶段2(领域增强):融入娱乐领域专属数据,优化场景化生成效果。

5. 中/英文双版本,覆盖多语言娱乐场景

仓库提供两款针对性优化的模型,分别适配中/英文娱乐内容创作,解决单一语言模型在跨语言场景下的能力衰减问题:

中文版:适配网文、短剧、中文闲聊等场景,优化中文语境下的成语、歇后语、网络流行语使用;

英文版:适配英文小说、海外社交对话、英文剧本等场景,符合英语母语者的表达习惯。

6. 开源友好,配套资源完善

项目遵循Apache开源协议,提供完整的使用文档、演示脚本、依赖配置及评估数据集,开发者无需从零搭建环境,可快速上手;同时兼容Hugging Face、ModelScope等主流模型平台,降低部署与集成成本。

三、技术细节

1. 核心模型参数规格

XVERSE-Ent系列包含两款核心模型,具体参数规格如下表所示:

| 模型名称 | 目标语言 | 总参数 | 激活参数 | 网络层数 | 隐藏维度 | 上下文长度 | 词表大小 | 每Token调用专家数 |

|---|---|---|---|---|---|---|---|---|

| XVERSE-Ent-A4.2B | 中文 | 25B | 4.2B | 28层 | 2560 | 8K | 100K | 8个 |

| XVERSE-Ent-A5.7B | 英文 | 36B | 5.7B | 32层 | 3072 | 8K | 128K | 8个 |

注:“上下文长度8K”表示模型可处理最长8192个Token的输入文本,满足小说章节、长对话等长文本创作需求;“词表大小”适配对应语言的词汇覆盖度,中文100K词表包含常用字、词、网络用语,英文128K词表覆盖英语核心词汇与娱乐领域专属词汇。

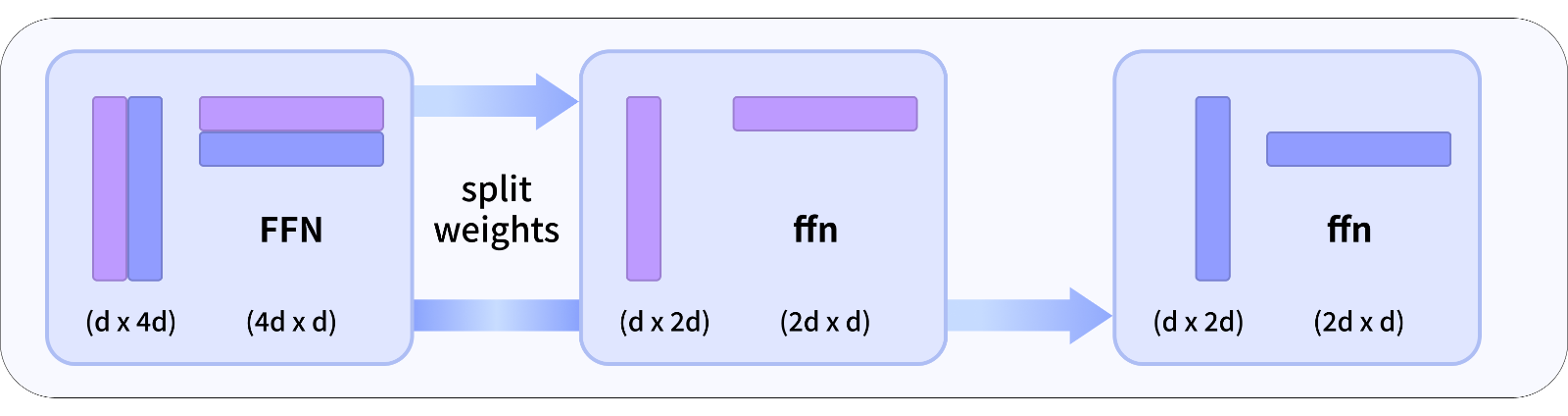

2. 核心技术:稀疏升级(Sparse Upcycling)

稀疏升级是XVERSE-Ent最核心的技术创新,解决了MoE模型训练成本高的行业痛点,其核心流程分为两步:

(1)细粒度FFN分解

将传统稠密模型的前馈网络(FFN)拆解为多个独立的子网络(即“专家”),而非粗粒度的整体拆分。这种方式的优势在于:

每个专家子网专注处理某一类语义或任务,如“古风文本生成专家”“闲聊对话专家”;

支持按需复制专家子网,比如在显存不足的GPU上,复制核心专家子网即可保障基础能力,无需加载全部专家;

分解后模型的精度损失低于1%(基于官方评估数据),远优于粗粒度分解。

(2)注意力层复用

直接复用原稠密模型的注意力层,无需重新训练。注意力层是大模型处理文本上下文关联的核心模块,复用该模块的好处:

最大化保留模型的通用语言能力,避免架构转换后“丢基础能力”;

减少训练数据量,仅需针对FFN部分的专家子网做微调;

提升训练稳定性,降低模型收敛难度。

3. 多阶段训练策略

XVERSE-Ent的训练分为三个阶段,各阶段目标、数据与训练重点如下:

| 训练阶段 | 阶段名称 | 核心目标 | 训练数据 | 训练重点 |

|---|---|---|---|---|

| S0 | 能力重构 | 恢复通用语言能力 | 通用网页文本、百科数据 | 调整专家子网权重,匹配注意力层 |

| S1 | 语言增强 | 强化目标语言建模能力 | 目标语言(中/英)通用语料 | 优化词表适配性,提升文本流畅度 |

| S2 | 领域增强 | 提升娱乐场景能力 | 小说、对话、剧本等娱乐语料 | 强化场景化生成,优化风格适配 |

整体训练数据量约1T Tokens(中文/英文各约500B),兼顾数据的多样性与领域针对性,既保证模型“什么都能聊”,又确保“聊娱乐内容更专业”。

4. 评估体系

为验证模型在娱乐领域的能力,XVERSE-Ent仓库构建了专属评估数据集,覆盖三大核心场景:

fiction(小说/故事类):评估文本连贯性、剧情逻辑性、风格贴合度;

conversation(对话类):评估回复的自然度、趣味性、上下文一致性;

webcc(通用网页文本):评估通用语言能力,确保场景化优化不牺牲基础能力。

评估维度包括人工评分(如“是否符合古风风格”)和自动指标(如BLEU、Perplexity),从主观到客观全面验证模型效果。

四、应用场景

XVERSE-Ent凭借“娱乐领域强、通用能力不弱、部署成本低”的特点,可应用于以下六大核心场景:

1. 网络文学创作

这是XVERSE-Ent最核心的应用场景,适用于网文作者、内容平台:

辅助创作:根据作者给出的“题材+人物设定+核心剧情”,生成小说章节初稿,节省创作时间;

创意拓展:基于现有章节,生成不同的剧情分支,帮助作者突破创作瓶颈;

风格适配:支持生成玄幻、言情、都市、悬疑等多题材网文,风格贴合各题材的写作规范;

文本润色:对作者的初稿进行润色,优化语言表达、调整节奏,提升文本可读性。

2. 娱乐向智能对话

适用于社交APP、智能音箱、虚拟助手等产品:

闲聊对话:提供自然、有趣的闲聊回复,避免通用模型“答非所问”或“回复生硬”;

角色模拟:模拟特定角色(如古风侠客、二次元人物、明星人设)进行对话,提升互动趣味性;

剧情互动:基于用户的输入,推进互动剧情,如“你扮演仙侠世界的店小二,和我对话并引导剧情”。

3. 娱乐内容生成

适用于短视频团队、自媒体、剧本创作团队:

短视频文案:生成搞笑段子、情感语录、剧情短视频脚本;

剧本大纲:根据主题(如“校园青春+轻喜剧”)生成剧本大纲、人物小传;

游戏剧情:为小游戏、桌游生成剧情文本、角色对话,降低内容制作成本。

4. 海外娱乐内容创作

基于英文版本XVERSE-Ent-A5.7B,可服务于海外内容创作者:

英文小说创作:生成英文网络小说、短篇故事,符合英语读者的阅读习惯;

海外社交内容:生成适合Twitter、TikTok等平台的娱乐文案;

英文剧本创作:辅助生成英文短剧、微电影剧本。

5. 低算力场景部署

由于激活参数仅4.2B/5.7B,XVERSE-Ent可部署在中低端硬件上:

个人PC:配备16G以上显存GPU的个人电脑即可运行,满足个人创作需求;

边缘设备:适配边缘服务器,可本地化部署,保障数据隐私;

中小平台:无需采购高算力服务器,降低中小团队的使用成本。

6. 二次开发与微调

开源特性使得开发者可基于XVERSE-Ent做定制化微调:

垂直场景微调:针对“古风剧本”“二次元对话”等细分场景,用少量数据微调;

功能集成:将模型集成到自有创作工具、对话系统中;

能力拓展:结合语音、图像等模态,打造多模态娱乐内容生成系统。

五、使用方法

1. 环境准备

(1)硬件要求

最低配置:单卡GPU(显存≥16G)、CPU≥8核、内存≥32G;

推荐配置:单卡GPU(显存≥24G)或多卡GPU,提升推理速度。

(2)软件依赖

XVERSE-Ent基于Python环境运行,核心依赖如下(完整列表见仓库requirements.txt):

# 核心依赖版本 torch>=2.0.0 transformers>=4.30.0 sentencepiece>=0.1.99 accelerate>=0.20.0 protobuf>=4.23.0

安装依赖的命令:

# 克隆仓库 git clone https://github.com/xverse-ai/XVERSE-Ent.git cd XVERSE-Ent # 安装依赖 pip install -r requirements.txt

2. 模型下载

XVERSE-Ent的模型权重可从两大平台获取:

Hugging Face:https://huggingface.co/xverse

ModelScope:https://modelscope.cn/organization/xverse

以Hugging Face为例,下载模型的命令:

# 安装huggingface-hub pip install huggingface-hub # 下载中文模型XVERSE-Ent-A4.2B huggingface-cli download xverse/XVERSE-Ent-A4.2B --local-dir ./XVERSE-Ent-A4.2B

3. 快速上手:文本生成演示

仓库提供了text_generation_demo.py脚本,可快速实现文本生成,步骤如下:

(1)修改脚本配置

打开text_generation_demo.py,修改模型路径、Prompt等参数:

import torch

from transformers import AutoTokenizer, AutoModelForCausalLM

# 配置参数

MODEL_PATH = "./XVERSE-Ent-A4.2B" # 替换为你的模型本地路径

PROMPT = "请以‘古风仙侠’为主题,写一段100字左右的小说开篇" # 输入你的生成指令

MAX_LENGTH = 200 # 生成文本的最大长度

TEMPERATURE = 0.7 # 生成随机性,0-1之间,值越高越随机

# 加载tokenizer和模型

tokenizer = AutoTokenizer.from_pretrained(MODEL_PATH, trust_remote_code=True)

model = AutoModelForCausalLM.from_pretrained(

MODEL_PATH,

torch_dtype=torch.float16, # 半精度加载,节省显存

device_map="auto", # 自动分配模型到可用设备

trust_remote_code=True

)

# 生成文本

inputs = tokenizer(PROMPT, return_tensors="pt").to(model.device)

outputs = model.generate(

**inputs,

max_length=MAX_LENGTH,

temperature=TEMPERATURE,

do_sample=True,

pad_token_id=tokenizer.eos_token_id

)

# 输出结果

generated_text = tokenizer.decode(outputs[0], skip_special_tokens=True)

print("生成结果:")

print(generated_text)(2)运行脚本

python text_generation_demo.py

(3)示例输出

生成结果: 请以‘古风仙侠’为主题,写一段100字左右的小说开篇 青冥山巅,云雾如絮。 林微攥着手中的桃木剑,指尖因用力而泛白。她已在此守了三日,只为等那道传说中的灵泉。山风卷着寒意掠过耳畔,远处传来几声鹤唳,崖边的忘忧草在风中轻轻摇曳。 忽然,脚下的青石微微震颤,一道清冽的蓝光自崖底腾起,灵泉终是现世。只是她不知,这一眼灵泉,竟会牵扯出百年前的一段仙魔恩怨。

4. 微调方法(简易版)

针对特定娱乐场景做微调,可参考以下步骤:

(1)准备微调数据

数据格式为JSONL,示例:

{"input": "写一段甜宠古风对话", "output": "「阿妩,今日的桂花糕我特意多放了糖,尝尝?」谢辞伸手递过食盒,眉眼间满是温柔。「殿下偏心,只给我一人吃么?」阿妩踮脚捏了捏他的脸颊,笑意盈盈。"}(2)使用accelerate做微调

# 启动微调脚本(仓库提供基础微调模板) accelerate launch finetune.py \ --model_name_or_path ./XVERSE-Ent-A4.2B \ --train_file ./train_data.jsonl \ --per_device_train_batch_size 2 \ --num_train_epochs 3 \ --learning_rate 2e-5 \ --output_dir ./finetuned_model

六、常见问题解答

Q1:XVERSE-Ent与通用大模型(如Llama2、ChatGLM)有什么区别?

A:核心区别在于“场景化优化”。通用大模型追求全场景适配,但在娱乐内容生成上存在风格生硬、剧情逻辑差等问题;XVERSE-Ent在保留通用能力的基础上,针对小说、对话等娱乐场景做了深度优化,生成的内容更贴合娱乐场景的表达习惯,且采用MoE架构,部署成本更低。此外,XVERSE-Ent分中/英文版本,针对性更强。

Q2:普通个人电脑能否运行XVERSE-Ent?

A:可以。以中文模型XVERSE-Ent-A4.2B为例,在配备16G显存GPU(如RTX 3090、RTX 4070 Ti)的个人PC上,采用半精度(float16)加载,可正常运行推理;若显存不足(如8G),可开启模型量化(如4-bit量化),虽然精度略有损失,但仍能使用核心功能。

Q3:稀疏升级技术和传统MoE训练有什么不同?

A:传统MoE模型需要从零开始训练所有专家子网和注意力层,训练成本高、周期长(通常需要数十天);稀疏升级技术直接复用稠密模型的注意力层,仅对FFN部分做专家拆分和微调,训练周期缩短至数天,成本降低60%以上,且能保留原模型的通用能力。

Q4:XVERSE-Ent的上下文长度是8K,能否处理更长的文本?

A:官方版本支持8K上下文长度,满足大部分娱乐场景(如小说章节、长对话)的需求。若需处理更长文本,可通过“文本分段处理+结果拼接”的方式实现,或基于仓库代码做上下文长度拓展(需一定的开发能力)。

Q5:XVERSE-Ent的开源协议是什么?商用是否需要授权?

A:XVERSE-Ent核心遵循Apache License 2.0开源协议,个人、企业均可免费使用、修改、分发,商用无需额外授权,但需遵守协议中的条款(如保留版权声明、免责声明等)。此外,仓库中的MODEL_LICENSE.pdf包含模型专属许可说明,商用前建议查阅。

Q6:模型生成的内容存在侵权风险吗?

A:XVERSE-Ent的训练数据均基于合法合规的开源语料,但生成内容的版权归属使用者。建议使用者在生成内容时遵守相关法律法规,避免生成侵权、违法的内容。

Q7:如何提升XVERSE-Ent的生成效果?

A:可通过以下方式优化:

优化Prompt:给出更具体的指令,如“写一段古风仙侠小说开篇,包含‘青冥山’‘灵泉’‘少女剑客’三个元素,风格偏清冷”;

调整生成参数:temperature控制随机性(0.5-0.8为宜),top_p控制生成多样性;

针对性微调:用少量高质量的目标场景数据做微调,效果提升最显著。

Q8:XVERSE-Ent支持多模态吗?

A:当前版本仅支持文本生成与理解,暂不支持图像、语音等多模态能力。若需多模态拓展,可基于XVERSE-Ent的文本能力,结合开源的视觉模型(如CLIP)、语音模型(如Whisper)做二次开发。

七、相关链接

Hugging Face主页:https://huggingface.co/xverse

ModelScope主页:https://modelscope.cn/organization/xverse

八、总结

XVERSE-Ent是元象团队面向娱乐领域推出的开源MoE大语言模型系列,包含中文XVERSE-Ent-A4.2B与英文XVERSE-Ent-A5.7B两款模型,核心通过稀疏升级技术实现稠密模型到MoE模型的低成本转换,结合多阶段训练策略强化娱乐场景能力,同时保留通用语言能力,适配8K上下文长度,具备场景化能力突出、部署成本低、中/英文适配等特点,可广泛应用于网文创作、娱乐对话、内容生成等场景,且提供完整的使用脚本、微调模板与评估数据集,兼顾个人开发者与企业用户的使用需求,是一款兼顾实用性与易用性的娱乐领域专用开源大模型。

版权及免责申明:本文由@dotaai原创发布。该文章观点仅代表作者本人,不代表本站立场。本站不承担任何相关法律责任。

如若转载,请注明出处:https://www.aipuzi.cn/ai-news/xverse-ent.html