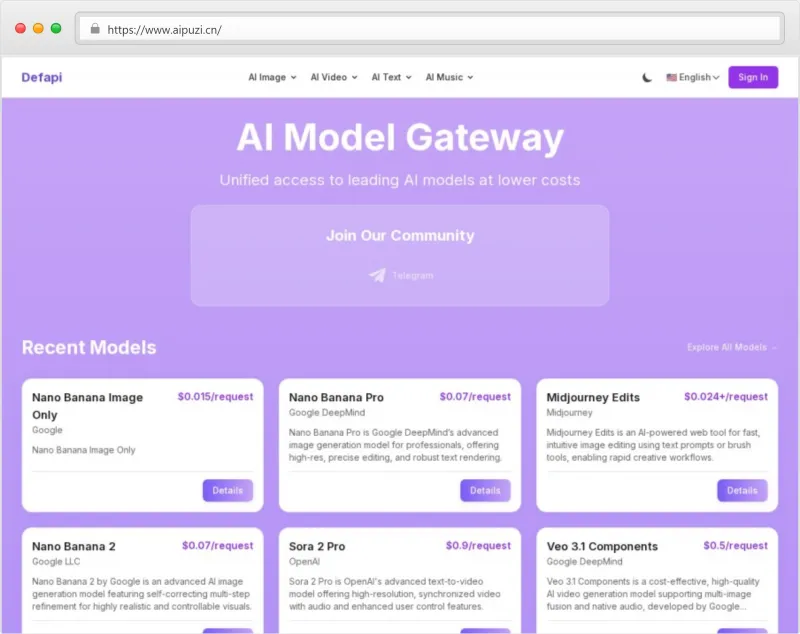

Defapi是什么?

Defapi是一个领先的AI模型API聚合平台,致力于为开发者、企业及个人用户提供一站式、低成本、高效率的全球主流AI模型接入服务。通过Defapi,用户无需分别对接OpenAI、Anthropic、Google等多家AI服务商,只需一个API接口,即可灵活调用包括GPT系列、Claude、Gemini在内的多种先进人工智能模型。

该平台的核心价值在于“统一接入 + 智能路由 + 成本优化”。它不仅简化了技术集成流程,还通过智能调度机制帮助用户在保证性能的前提下选择最经济的模型路径,显著降低AI使用成本。

Defapi的目标是成为“AI时代的云服务商中间件”,让每一位开发者都能以极低门槛拥抱前沿AI能力,专注于产品创新而非基础设施搭建。

产品功能

Defapi 提供六大核心功能模块,全面覆盖从模型调用到运维监控的全流程需求:

1. 大型语言模型(LLM)支持

支持调用 GPT-4、GPT-3.5、Claude 3、Gemini Pro 等主流大语言模型。

可用于文本生成、对话系统、内容创作、代码编写、翻译等多种场景。

自动识别最佳响应模型,提升输出质量与稳定性。

2. 视觉AI模型集成

集成图像生成(如DALL·E、Stable Diffusion)、图像理解、OCR识别等功能。

支持文生图、图生文、视觉问答(VQA)等多模态任务。

提供统一输入输出格式,降低跨平台开发难度。

3. 音频AI模型服务

包含语音识别(ASR)、语音合成(TTS)、情感分析、音频转录等能力。

支持多语种语音处理,适用于智能客服、播客自动化、语音助手等应用。

4. 专业AI API接口

提供特定领域专用接口,如法律文书生成、医疗摘要提取、金融数据分析等。

第三方合作模型持续接入中,构建垂直行业解决方案生态。

5. 实时监控与数据看板

提供详细的调用日志、响应时间、错误率、费用统计等可视化报表。

支持按项目、模型、时间段进行多维度分析,便于资源管理与成本控制。

6. 全球节点部署与低延迟访问

在北美、欧洲、亚太等地设有边缘节点,确保全球用户获得稳定低延迟的服务体验。

支持自定义区域路由策略,满足合规性与性能双重需求。

产品特色亮点

| 特色 | 描述 |

|---|---|

| 统一API接口 | 一套SDK即可调用上百种AI模型,避免重复开发和维护多个供应商接口。 |

| 智能成本优化 | 基于实时价格与性能表现,自动选择性价比最高的模型执行请求,最高可节省40%成本。 |

| 企业级安全保障 | 数据全程加密传输(TLS/SSL),支持私有化部署、IP白名单、RBAC权限控制,符合GDPR、ISO27001等标准。 |

| 开发者友好设计 | 提供Python、JavaScript、Java等多语言SDK,配套详尽文档与沙箱环境,快速上手无门槛。 |

| 多模型动态切换 | 当某一模型出现限流或故障时,系统自动切换至备用模型,保障服务连续性。 |

| 灵活扩展性强 | 支持自定义模型注册与插件式接入,未来可拓展至本地私有模型或第三方开源模型。 |

使用方法

使用 Defapi 极其简单,仅需三个步骤即可开始调用全球顶级AI模型:

第1步:注册账户

访问Defapi官网,点击“Sign Up”免费注册账号。支持邮箱注册或GitHub快捷登录。

第2步:获取API密钥

登录后进入控制台,在「API Keys」页面生成专属密钥(Secret Key),并设置访问权限范围(如仅读、全功能等)。

第3步:发起API调用

使用官方SDK或直接通过HTTP请求调用API,示例如下(Python):

import requests

url = "https://api.defapi.com/v1/chat/completions"

headers = {

"Authorization": "Bearer YOUR_API_KEY",

"Content-Type": "application/json"

}

data = {

"model": "gpt-4",

"messages": [{"role": "user", "content": "请写一首关于春天的诗"}]

}

response = requests.post(url, json=data, headers=headers)

print(response.json())💡 小贴士:可在控制台选择“推荐模型”模式,由系统自动匹配最优模型;也可手动指定特定厂商模型。

适合人群

| 用户类型 | 适用场景 | 使用收益 |

|---|---|---|

| 独立开发者 | 快速构建AI应用原型、开发个人项目、参与黑客松比赛 | 节省90%集成时间,两周内上线AI应用 |

| 初创科技公司 | 打造AI聊天机器人、内容生成工具、智能客服系统 | 减少运维负担,专注核心业务逻辑 |

| 中大型企业 | 实施多模型AI战略、实现容灾备份、优化采购成本 | 成本下降40%,服务可用性达99.9% |

| 教育机构/研究人员 | 进行AI教学实验、模型对比研究、学术论文辅助写作 | 获取多源模型数据,提升科研效率 |

| 内容创作者 | 自动生成文案、脚本、海报描述、短视频字幕 | 提升内容产出速度与多样性 |

常见问题解答(FAQ)

Q1:Defapi 到底是什么?

A:Defapi 是一个统一的AI模型API聚合平台,整合了来自 OpenAI、Anthropic、Google 等多家顶级AI服务商的模型能力,提供单一接口供开发者调用,极大简化集成流程。

Q2:如何开始使用 Defapi?

A:只需三步:① 注册账户 → ② 获取API密钥 → ③ 使用SDK或HTTP调用API。详细教程见官网文档中心。

Q3:Defapi 如何做到成本更低?

A:平台内置智能路由引擎,会根据当前各模型的价格、延迟、可用性等因素,自动选择最具性价比的模型执行请求,从而实现成本最优化。

Q4:Defapi 是否安全?能否用于企业生产环境?

A:是的。Defapi 提供企业级安全防护,包括端到端加密、访问控制、审计日志、合规认证等,已服务于多家金融与医疗行业客户。

Q5:是否支持私有模型或本地部署?

A:目前支持公有云调用为主,企业版即将推出私有化部署方案,支持将Defapi网关部署在自有服务器上。

Q6:是否有技术支持?

A:提供完整的开发者文档、社区论坛、GitHub示例代码;企业用户还可享受专属客服与SLA保障。

Q7:哪些AI模型可以通过 Defapi 调用?

A:目前已接入 OpenAI、Anthropic、Google、Meta(Llama系列)、Cohere、Hugging Face 等平台的主流模型,涵盖文本、图像、音频、专业API四大类。

Q8:能否同时调用多个模型进行对比?

A:可以!通过“Multi-Model Query”功能,一次请求可并发调用多个模型并返回对比结果,非常适合A/B测试与模型评估。

总结

在当今AI技术飞速发展的时代,企业和开发者面临的一大挑战是:如何高效、低成本地整合多样化的AI能力?

传统方式需要逐一接入不同厂商的API,面临接口不一致、价格不透明、运维复杂、成本难以控制等问题。而 Defapi 正是为解决这些痛点而生。

它的核心优势体现在:

极简接入:一个API搞定所有模型;

极致性价比:智能路由节省高达40%成本;

超强稳定性:多模型冗余保障服务不中断;

面向未来架构:支持多模态、多区域、可扩展的设计理念。

无论是想快速验证AI创意的个体开发者,还是寻求规模化AI部署的企业决策者,Defapi 都是一个值得信赖的技术伙伴。