零门槛部署本地大模型!Docker+Ollama 玩转 DeepSeek 全攻略

当 ChatGPT、Claude 等云端大模型成为日常工具时,“隐私泄露风险”“网络依赖限制”“API 调用成本” 却成了不少用户的痛点 —— 敏感数据不敢上传云端,断网时 AI 助手瞬间 “罢工”,高频使用的 API 账单也悄然攀升。有没有办法把强大的大模型 “搬” 到自己的电脑里,实现离线可用、隐私可控的 AI 体验?

答案是肯定的。DeepSeek 作为国内顶尖的开源大模型,凭借出色的推理能力和中文适配性备受关注;而 Docker 的容器化技术,能彻底解决 “环境配置千奇百怪、程序迁移一地鸡毛” 的难题;Ollama 则让本地大模型的运行像打开普通软件一样简单。

今天这篇全攻略,就将这三者完美结合:无需复杂的编程基础,不用纠结繁琐的依赖配置,从 Docker 安装到 DeepSeek 启动,每一步都有清晰指引。哪怕是 AI 部署新手,也能跟着流程零门槛搭建起属于自己的本地大模型服务,真正把 AI 算力握在自己手里。

一、基础知识

1、什么是Docker

Docker:就像一个“打包好的App”

想象一下,你写了一个很棒的程序,在自己的电脑上运行得很好。但当你把它发给别人,可能会遇到各种问题:

“这个软件需要 Python 3.8,但我只有 Python 3.6!”

“我没有你用的那个库,安装失败了!”

“你的程序要跑在 Linux,我的电脑是 Windows!”

💡 Docker 的作用:它就像一个“打包好的 App”,把你的软件、依赖、环境、系统配置等 全部封装到一个“容器” 里,别人拿到这个容器,就能直接运行,而不用关心它内部的细节。

🚀 把 Docker 想象成“集装箱”

传统运输 vs. 集装箱运输

以前(传统部署):

货物(程序)需要不同的包装方式(运行环境)

货物可能损坏(环境不兼容)

装卸麻烦(程序迁移难)

有了 Docker(容器部署):

货物装进标准化集装箱(Docker 容器)

不管运到哪里,集装箱里东西不变(程序环境一致)

码头和船只可以直接装卸(轻松部署到不同系统)

Docker 让软件像“集装箱”一样标准化、可移植、易部署! 🚢

2、什么是Ollama

Ollama 是一个本地运行大语言模型(LLM)的工具,它可以让你 在自己的电脑上直接运行 AI 模型,而不需要连接云端服务器。

💡 简单来说:Ollama 让你像运行普通软件一样,轻松在本地使用 ChatGPT、Llama、Mistral、Gemma 等大语言模型。

🚀 Ollama 的核心特点

本地运行 🏠

你不需要联网,也不用担心隐私问题,所有计算都在你的电脑上完成。

支持多种开源模型 📚

可以运行 Llama 3、Mistral、Gemma、Code Llama 等不同的大模型。

易于安装和使用 🔧

只需要几条命令,就能下载并运行 AI 模型。

轻量化优化 ⚡

适配 Mac(Apple Silicon)、Linux 和 Windows,支持 GPU 加速,让模型运行更快。

离线推理 🔒

适合不想依赖 OpenAI API 或其他云端 AI 服务的用户。

二、准备工作

1、操作系统

这里我们使用的操作系统为Centos 7.9,配置为4核8G,大家也可以使用其他的Linux发行版本,或者使用Windows。

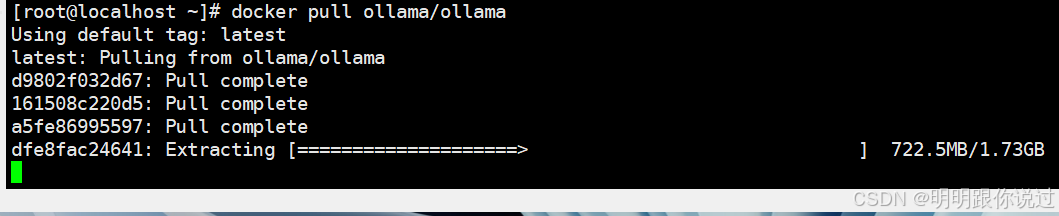

2、镜像准备

如果已经安装了Docker,可以提前准备好镜像,ollama/ollama,镜像比较大,拉取会耗一些时间

三、安装

1、安装Docker

1.关闭防火墙

systemctl stop firewalld && systemctl disabled firewalld

2.关闭SELinux

setenforce 0

3.更换yum源

rm -f /etc/yum.repos.d/* curl -o /etc/yum.repos.d/CentOS-Base.repo http://mirrors.aliyun.com/repo/Centos-7.repo yum clean all && yum makecache

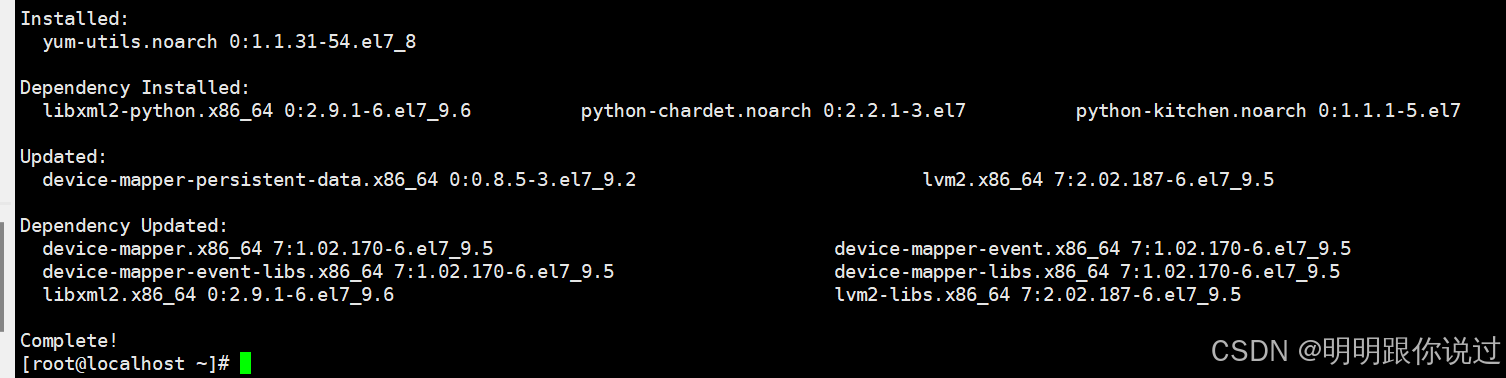

4.安装依赖项

yum install -y yum-utils device-mapper-persistent-data lvm2

5. 添加Docker源

yum-config-manager --add-repo http://mirrors.aliyun.com/docker-ce/linux/centos/docker-ce.repo

6.安装Docker

yum install docker-ce -y

7.添加Docker镜像加速器

vim /etc/docker/daemon.json

# 添加如下内容

{

"registry-mirrors": [

"https://docker.m.daocloud.io",

"https://noohub.ru",

"https://huecker.io",

"https://dockerhub.timeweb.cloud",

"https://0c105db5188026850f80c001def654a0.mirror.swr.myhuaweicloud.com",

"https://5tqw56kt.mirror.aliyuncs.com",

"https://docker.1panel.live",

"http://mirrors.ustc.edu.cn/",

"http://mirror.azure.cn/",

"https://hub.rat.dev/",

"https://docker.ckyl.me/",

"https://docker.chenby.cn",

"https://docker.hpcloud.cloud",

"https://docker.m.daocloud.io"

]

}8.启动Docker

systemctl start docker

2、启动Ollama

1.启动Ollama容器

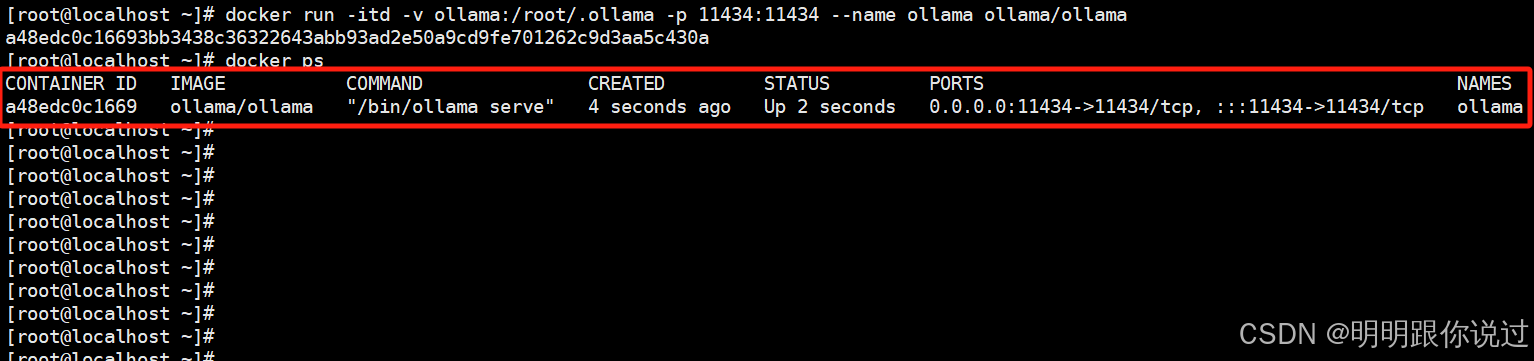

docker run -itd -v ollama:/root/.ollama -p 11434:11434 --name ollama ollama/ollama

docker run 运行一个新的 Docker 容器

-itd 组合多个选项:

✅ -i(保持标准输入)

✅ -t(分配终端)

✅ -d(后台运行容器)

-v ollama:/root/.ollama 挂载数据卷,把 ollama 这个 Docker 数据卷 绑定到容器的 /root/.ollama 目录,确保数据持久化(如下载的模型不会丢失)。

-p 11434:11434 端口映射,把 宿主机(本机)的 11434 端口 映射到 容器 内部的 11434 端口,这样宿主机可以通过 http://localhost:11434 访问 Ollama 服务。

--name ollama 指定 容器名称 为 ollama,方便管理和启动。

ollama/ollama 使用的 Docker 镜像,这里是 官方的 Ollama 镜像。

如果是使用GPU运行,则用下面的命令启动

docker run -itd --name ollama --gpus=all -v ollama:/root/.ollama -p 11434:11434 ollama/ollama

2.查看Ollama容器

docker ps

3、拉取Deepseek大模型

1.进入到容器中

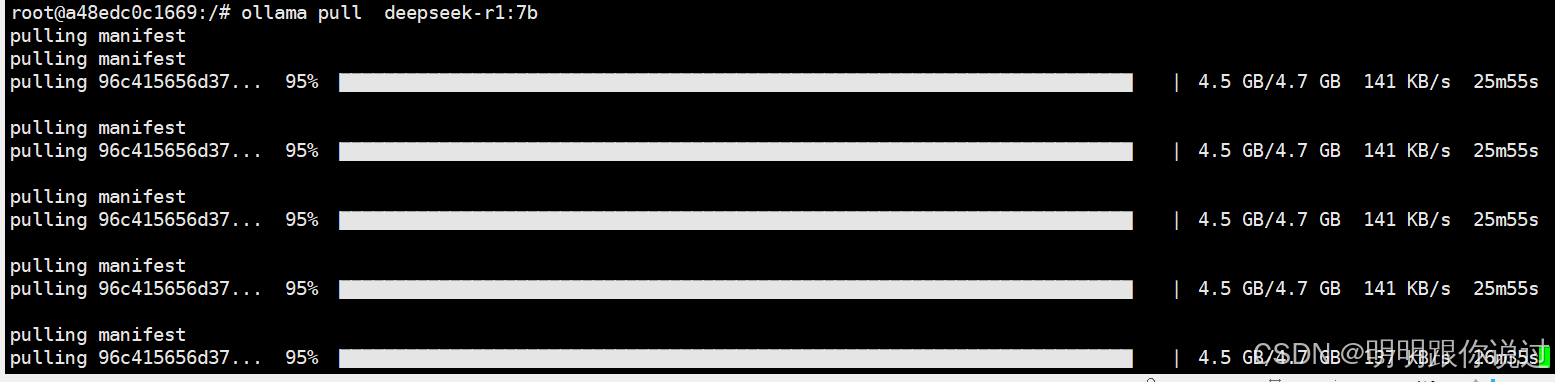

docker exec -it ollama /bin/bash

2.拉取模型

ollama pull deepseek-r1:7b

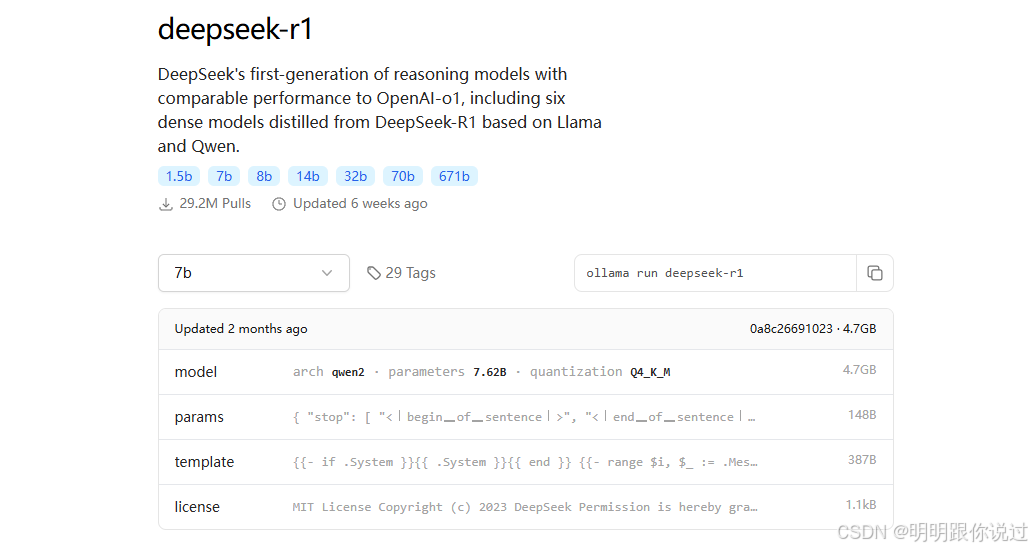

在官网中,有许多Deepseek的模型,这里主要是演示,所以拉取了一个较小的模型

官网地址:deepseek-r1

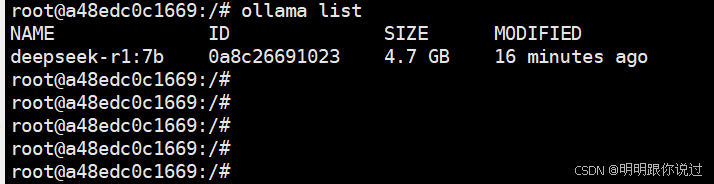

3.查看模型

ollama list

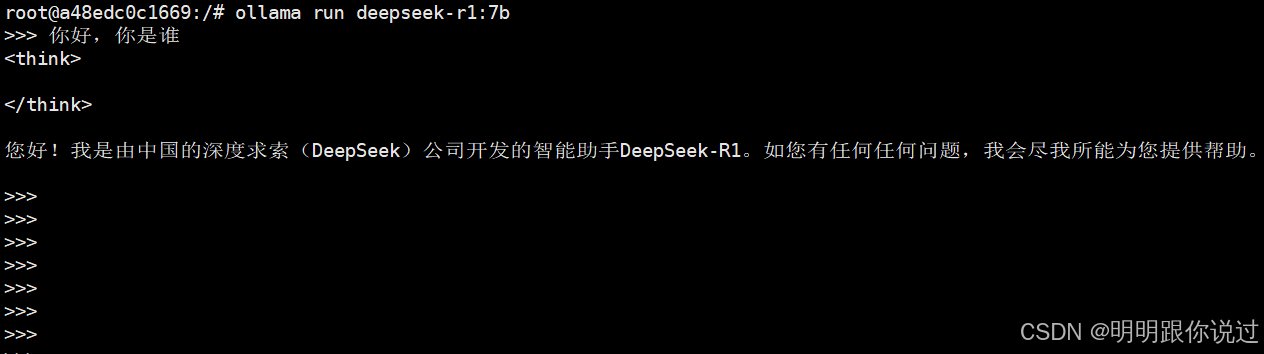

4、启动Deepseek

ollama run deepseek-r1:7b

总结

从 “担心隐私不敢用云端” 到 “本地离线畅玩大模型”,Docker+Ollama 的组合为 DeepSeek 部署提供了一套高效且低门槛的解决方案。

回顾整个流程,Docker 通过标准化容器消除了环境兼容的痛点,让 Ollama 及依赖得以在任何系统中稳定运行;Ollama 则简化了大模型的拉取与启动操作,即使是新手也能通过几条命令完成部署;而 DeepSeek-r1:7b 模型的轻量化特性,更让 4 核 8G 的基础配置也能轻松承载。从关闭防火墙、配置 Docker 镜像加速器,到挂载数据卷启动 Ollama 容器,再到拉取模型实现交互,每一步都印证了 “零门槛” 的核心优势 —— 无需专业运维知识,不用高端硬件支撑,就能拥有隐私可控、离线可用的 AI 助手。

这套部署范式不仅适用于 DeepSeek,更可迁移到 Llama 3、Mistral 等其他开源模型。掌握它,你就解锁了本地 AI 应用的无限可能:无论是日常问答、代码辅助,还是敏感场景下的数据分析,都能摆脱云端束缚,让大模型真正为自己 “专属服务”。

相关软件下载

Ollama

DeepSeek

版权及免责申明:本文来源于#明明跟你说过,由@AI铺子整理发布。如若内容造成侵权/违法违规/事实不符,请联系本站客服处理!该文章观点仅代表作者本人,不代表本站立场。本站不承担相关法律责任。

如若转载,请注明出处:https://www.aipuzi.cn/ai-tutorial/93.html