Ollama(开源AI本地大模型部署运行工具)

- 软件版本:0.11.10

- 软件类型:综合其它

- 软件语言:多语言

- 运行环境:Windows,MacOS

- 软件大小:672.2 MB

- 发布时间:

Ollama是什么

Ollama是一款专为本地运行和部署大型语言模型(LLM)而设计的开源工具,适用于开发者、研究人员以及AI爱好者。它提供了一种便捷的方式来在本地环境中运行各种流行的AI模型,如 Llama、Llama2、CodeLlama 等,无需依赖云服务,从而实现更高效、安全和私密的AI应用开发。

Ollama 是一个开源项目,致力于为用户提供本地部署和运行大型语言模型的完整解决方案。它不仅简化了模型的部署流程,还通过高效的资源管理优化了本地运行性能。Ollama 支持多种主流模型格式,并提供模型下载、管理、运行等功能,用户可以轻松地在自己的设备上构建AI推理环境。

Ollama 的设计目标是轻量、高效、易用,支持通过命令行或API接口进行操作,便于集成到各类项目中。该工具的架构设计考虑到了开发者的易用性和部署的灵活性,支持命令行操作和API调用,适合构建本地AI应用、原型设计、教育研究等场景。Ollama 还提供了详细的文档和活跃的社区支持,帮助用户快速上手和深入使用。

软件功能

本地模型部署

在本地计算机上部署和运行大型语言模型,无需依赖云端服务。

多模型支持

支持主流开源模型,如 Llama、Llama2、CodeLlama、Vicuna 等。

模型管理

提供模型下载、更新、删除和版本管理功能。

命令行操作

通过简洁的CLI界面快速调用和管理模型。

REST API 接口

支持通过HTTP请求与模型进行交互,便于集成到Web应用或桌面应用中。

资源优化

高效利用本地硬件资源,提升模型运行速度和响应效率。

软件特色

本地运行,数据隐私

所有数据处理都在本地完成,避免上传至云端,保障用户隐私和数据安全。

开源免费

Ollama 是一个开源项目,用户可以自由使用、修改和分发。

轻量高效

安装包体积小,运行占用资源少,适合在普通PC或服务器上部署。

易于集成

提供API接口,便于与各种开发框架和应用程序集成。

持续更新

社区活跃,模型和功能持续更新,适应AI技术的快速发展。

收费价格

Ollama 是完全免费且开源的工具,用户无需支付任何费用即可下载、使用和定制。目前没有商业版本或订阅服务,所有功能均对公众开放。

常见问题解答(FAQ)

Q1: Ollama 支持哪些操作系统?

A: Ollama 目前支持 Windows、 macOS 和 Linux系统。

Q2: 是否需要联网使用?

A: 首次下载模型时需要联网,模型下载完成后可在本地离线运行。

Q3: Ollama 支持哪些模型?

A: Ollama 支持多种主流开源模型,包括 Llama、Llama2、CodeLlama、Vicuna、Mistral 等。

Q4: 是否可以在企业中使用?

A: 可以。Ollama 是开源项目,企业可自由部署和使用,非常适合构建私有化的AI服务。

Q5: 如何获取技术支持?

A: 可通过 Ollama 官方网站、GitHub 仓库、社区论坛等渠道获取帮助。

总结

Ollama 是一款专为本地部署大型语言模型而设计的开源工具,凭借其轻量高效、易于集成和数据隐私保护等优势,成为开发者和研究人员的理想选择。无论你是希望在本地运行 Llama 系列模型,还是构建自己的AI应用,Ollama 都能提供强大的支持。

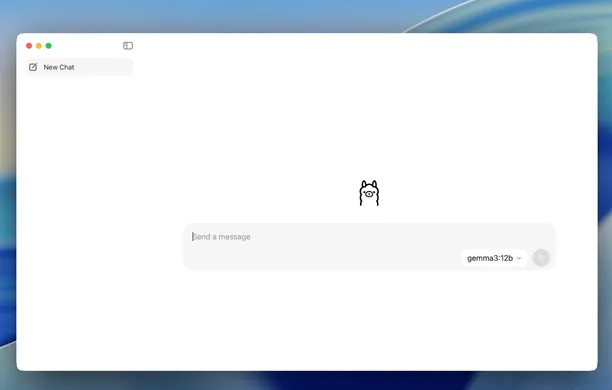

软件截图

Ollama下载地址

版权与来源声明:AI铺子提供的Ollama电脑客户端/APP,均转载自官方下载网站或经授权的可信分发渠道。相关软件的所有权、版权及知识产权均归原作者所有。本站不对任何软件进行二次修改或附加捆绑,确保文件的原始性与完整性。我们强烈建议用户支持正版软件,并通过官方渠道获取Ollama最新版本和专业技术支持。