模型剪枝的类型有哪些?结构化 vs 非结构化剪枝详解

在深度学习模型部署过程中,模型大小与推理效率的平衡始终是核心挑战。以ResNet-50为例,其原始参数量达2500万,若直接部署于移动端或边缘设备,将面临存储空间不足、推理延迟过高等问题。模型剪枝技术通过移除冗余参数,成为解决这一问题的关键手段。根据剪枝粒度与硬件适配性差异,模型剪枝可分为结构化剪枝与非结构化剪枝两大类型。本文AI铺子将从技术原理、操作对象、压缩效果及典型应用四个维度展开系统性对比。

一、技术原理:从参数剔除到结构优化

1.1 非结构化剪枝:基于参数重要性的细粒度剔除

非结构化剪枝以单个权重或神经元为最小操作单元,通过评估参数对模型输出的贡献度,移除绝对值接近零或梯度更新幅度小的连接。其核心逻辑可概括为:

基于幅度的剪枝:直接移除权重绝对值小于预设阈值的连接。例如,在BERT模型中,通过设定阈值0.01,可删除30%的权重而不显著影响精度。

基于梯度的剪枝:结合反向传播中的梯度信息,优先保留对损失函数影响大的权重。例如,在Transformer的注意力头中,梯度幅值较小的权重被视为冗余。

动态剪枝:在推理过程中根据输入数据动态决定是否剪枝某些路径。例如,Flash-LLM通过“稀疏加载和密集计算”(LSCD)方法,在GPU上实现非结构化稀疏矩阵的高效乘法。

技术挑战:非结构化剪枝生成的稀疏矩阵需专用硬件(如NVIDIA A100 GPU的Tensor Core)或软件库(如cuSPARSE)支持,否则难以实现实际加速。例如,在通用CPU上,稀疏矩阵计算可能因索引存储开销导致速度下降。

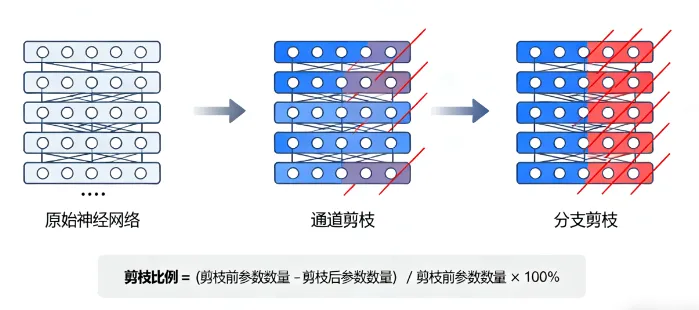

1.2 结构化剪枝:基于硬件适配的粗粒度优化

结构化剪枝通过移除整个神经元、滤波器或层来简化模型结构,其核心原则包括:

通道剪枝:删除卷积层的某个输出通道,减少后续层的计算需求。例如,在MobileNetV2中,通过基于BatchNorm层缩放因子(γ)的评估,可剪除γ值接近零的通道,压缩率达40%时精度仅下降1%。

滤波器剪枝:移除整个卷积核,直接减少参数量与计算量。例如,在ResNet-18中,通过L2范数评估滤波器重要性,剪除50%的滤波器后,模型体积缩小至原模型的1/3,推理速度提升2倍。

层剪枝:删除不重要的网络层,适用于深度冗余的模型。例如,在DenseNet中,通过依赖性检测算法识别可剪除的过渡层,压缩后模型参数量减少60%。

技术优势:结构化剪枝保持模型结构的规则性,可直接利用现有硬件(如GPU、NPU)的并行计算能力,无需依赖稀疏计算库。例如,剪枝后的YOLOv5模型在NVIDIA Jetson AGX Xavier上实现30FPS的实时检测,较原始模型提速4倍。

二、操作对象:从权重矩阵到模型架构

| 技术类型 | 操作对象 | 典型工具/框架 | 硬件适配性 |

|---|---|---|---|

| 非结构化剪枝 | 单个权重、神经元 | PyTorch Pruning API、TensorFlow Model Optimization | 需专用稀疏计算硬件 |

| 结构化剪枝 | 通道、滤波器、层 | TensorRT、OpenVINO、ONNX | 兼容通用硬件(GPU/NPU) |

2.1 非结构化剪枝:权重级操作

非结构化剪枝直接作用于权重矩阵,通过掩码(Mask)机制标记待删除的权重。例如,在PyTorch中,可通过以下代码实现L1范数非结构化剪枝:

import torch.nn.utils.prune as prune model = torch.nn.Linear(100, 100) prune.l1_unstructured(model, name='weight', amount=0.3) # 剪除30%的权重

操作特点:

灵活性高:可针对任意权重进行剪枝,压缩率理论上无上限。

存储开销大:需额外存储掩码矩阵,导致模型体积增加。

硬件利用率低:稀疏矩阵计算需专用指令集支持。

2.2 结构化剪枝:架构级操作

结构化剪枝通过修改模型结构实现压缩,其操作对象包括:

通道剪枝:基于BatchNorm层的γ值评估通道重要性。例如,在ConvNet中:

import torch class ConvNet(torch.nn.Module): def __init__(self): super(ConvNet, self).__init__() self.conv1 = torch.nn.Conv2d(3, 64, kernel_size=3, padding=1) self.conv2 = torch.nn.Conv2d(64, 128, kernel_size=3, padding=1) model = ConvNet() weights = model.conv1.weight.data.abs() channel_importance = torch.sum(weights, dim=[1, 2, 3]) # 计算每个通道的L1范数 threshold = torch.topk(channel_importance, k=32, largest=True).values[-1] # 保留32个通道 mask = channel_importance > threshold model.conv1.weight.data *= mask.view(-1, 1, 1, 1) # 应用掩码

滤波器剪枝:基于L2范数评估滤波器重要性。例如,在ResNet中:

prune.ln_structured(model.conv1, name='weight', amount=0.5, n=2, dim=0) # 剪除50%的滤波器

层剪枝:通过条件判断移除不重要的层。例如,在LayerPrunedNet中:

class LayerPrunedNet(torch.nn.Module): def __init__(self, use_layer=True): super(LayerPrunedNet, self).__init__() self.use_layer = use_layer self.conv1 = torch.nn.Conv2d(3, 64, kernel_size=3, padding=1) self.conv2 = torch.nn.Conv2d(64, 128, kernel_size=3, padding=1) def forward(self, x): x = self.conv1(x) if self.use_layer: x = self.conv2(x) return x model = LayerPrunedNet(use_layer=False) # 移除第二层

三、压缩效果:精度、速度与通用性的平衡

3.1 压缩比与精度保持

| 技术类型 | 典型压缩比 | 精度损失范围 | 适用场景 |

|---|---|---|---|

| 非结构化剪枝 | 10%-90% | 0%-5% | 研究探索、轻量化模型设计 |

| 结构化剪枝 | 40%-80% | 1%-5% | 边缘设备部署、实时推理系统 |

非结构化剪枝:在BERT-base模型中,通过INT8量化与非结构化剪枝结合,可将模型体积缩小16倍,在GLUE基准测试中精度损失仅1.2%。但极端剪枝(如90%压缩率)可能导致精度下降5%以上。

结构化剪枝:在MobileNetV2中,通过通道剪枝与微调,可在压缩50%参数量的情况下保持99%的原始精度。但激进剪枝(如移除70%通道)可能引发模型欠拟合。

3.2 推理速度提升

非结构化剪枝:在NVIDIA V100 GPU上,稀疏矩阵计算需依赖Tensor Core的稀疏模式,实际加速比通常低于理论值。例如,50%稀疏度的矩阵乘法仅实现1.3倍加速。

结构化剪枝:在NVIDIA Jetson TX2上,结构化剪枝后的YOLOv3模型推理速度提升3倍,功耗降低40%。

3.3 通用性与部署成本

非结构化剪枝:需针对不同硬件定制稀疏计算库,部署成本较高。例如,在ARM Cortex-M7微控制器上,稀疏矩阵计算需手动优化汇编代码。

结构化剪枝:与TensorRT、OpenVINO等推理框架无缝兼容,部署成本低。例如,剪枝后的ResNet-50可直接导出为ONNX格式,在多种硬件上运行。

四、典型应用场景解析

4.1 非结构化剪枝:高精度研究场景

大语言模型压缩:在OPT-175B模型中,通过SparseGPT方法实现60%的非结构化稀疏度,困惑度增加仅0.3%。该方法将剪枝视为稀疏回归问题,无需重新训练即可保持性能。

医疗影像分析:在3D CNN中,通过梯度敏感剪枝移除50%的权重,在肺结节检测任务中达到98%的敏感度,模型体积缩小至原模型的1/10。

4.2 结构化剪枝:硬件适配部署场景

嵌入式设备部署:在STM32微控制器上,将量化后的MobileNetV1结构化剪枝至50%参数量,实现每秒30帧的实时分类,功耗低于100mW。

自动驾驶系统:在NVIDIA Drive AGX平台上,通过通道剪枝将YOLOv5s压缩至原模型的1/3,推理延迟从35ms降至12ms,满足实时检测需求。

五、技术选型指南

5.1 根据硬件条件选择

支持稀疏计算的GPU(如NVIDIA Ampere):优先选择非结构化剪枝,结合Tensor Core实现高效稀疏计算。

通用CPU/移动端:结构化剪枝是首选,尤其是通道剪枝可显著提升推理速度。

无专用硬件的边缘设备:组合使用结构化剪枝与量化,例如先剪枝至50%参数量,再量化为INT8。

5.2 根据任务需求选择

高精度需求任务(如医疗诊断):知识蒸馏结合非结构化剪枝可最大限度保持性能。例如,将3D CNN教师的知识蒸馏至轻量学生模型,再通过非结构化剪枝优化。

实时性要求高的任务(如自动驾驶):结构化剪枝与量化组合是标准方案。例如,在YOLOv7中,先剪枝通道至40%参数量,再量化为INT8,最终模型在Jetson AGX Xavier上实现30FPS检测。

5.3 组合使用策略

剪枝+量化:先剪枝减少模型规模,再量化提升推理效率。例如,将ResNet-50剪枝至50%参数量后量化为INT8,模型体积缩小16倍,推理速度提升8倍。

剪枝+蒸馏:先剪枝教师模型,再用剪枝后的模型蒸馏学生模型。例如,将BERT-Large剪枝至60%参数量后蒸馏DistilBERT,可进一步提升学生模型性能。

六、结语:从理论到实践的桥梁

模型剪枝技术的核心在于平衡模型性能与压缩率。非结构化剪枝通过细粒度参数剔除实现高压缩比,但需硬件支持;结构化剪枝通过架构优化保障硬件效率,但可能损失更多精度。在实际部署中,**“结构化剪枝打底、量化加速、蒸馏提精”**的组合策略已成为主流。例如,在华为昇腾AI处理器上,通过结构化剪枝将YOLOv7压缩至40%参数量,再量化为INT8,最后用知识蒸馏优化边界框回归精度,最终模型在NVIDIA Jetson AGX Xavier上实现30FPS的实时检测,精度损失仅1.2%。

随着AI模型规模持续扩大,剪枝技术将向自动化、跨模态、硬件协同方向演进。对于开发者而言,理解结构化与非结构化剪枝的本质差异与组合逻辑,是构建高效AI系统的关键第一步。

版权及免责申明:本文由@AI铺子原创发布。该文章观点仅代表作者本人,不代表本站立场。本站不承担任何相关法律责任。

如若转载,请注明出处:https://www.aipuzi.cn/ai-tutorial/what-are-types-model-pruning.html