模型剪枝与其他压缩技术对比:剪枝、量化、蒸馏有何区别?

在人工智能模型部署过程中,模型大小、计算效率与推理精度始终是核心矛盾。随着深度学习模型参数量突破千亿级,模型压缩技术成为连接实验室研究与工业落地的关键桥梁。其中,模型剪枝(Pruning)、量化(Quantization)与知识蒸馏(Knowledge Distillation)作为三大主流压缩方法,因其技术路径差异显著,需通过系统性对比明确其适用场景。本文AI铺子将从技术原理、操作对象、压缩效果及典型应用四个维度展开深度解析。

一、技术原理:从冗余剔除到知识迁移

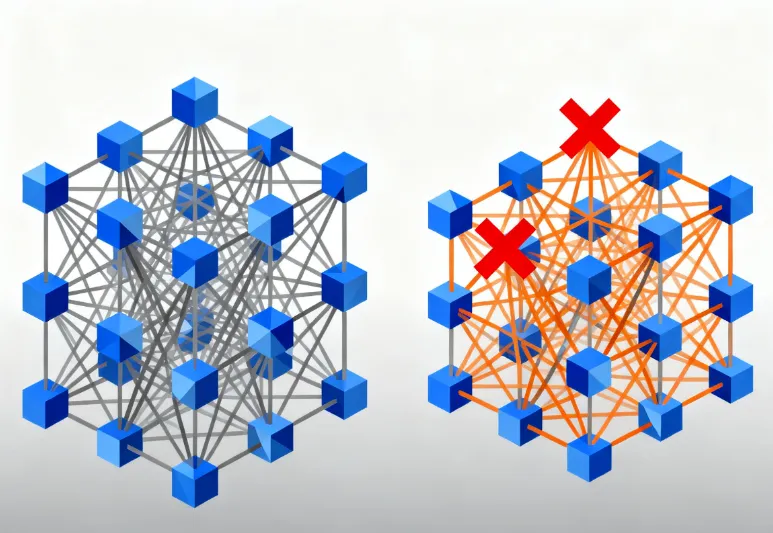

1.1 模型剪枝:结构化剔除冗余参数

模型剪枝的核心逻辑是通过评估参数重要性,移除对模型输出贡献最小的组件。其技术原理可细分为三类:

基于幅度剪枝:直接移除绝对值接近零的权重。例如,在ResNet-50中,通过设定阈值删除权重绝对值小于0.001的连接,可减少30%参数量而不显著损失精度。

基于梯度剪枝:利用反向传播中的梯度信息,剪除梯度更新幅度小的参数。此类方法在BERT模型压缩中,可精准定位对任务贡献度低的注意力头。

基于稀疏性约束训练:在训练阶段引入L1正则化项,迫使模型自动生成稀疏权重。例如,通过调整正则化系数λ,可使模型权重稀疏度达到90%以上。

关键挑战:非结构化剪枝生成的稀疏矩阵需专用硬件(如NVIDIA A100 GPU)支持,否则难以实现实际加速;结构化剪枝虽通用性强,但可能损失更多精度。

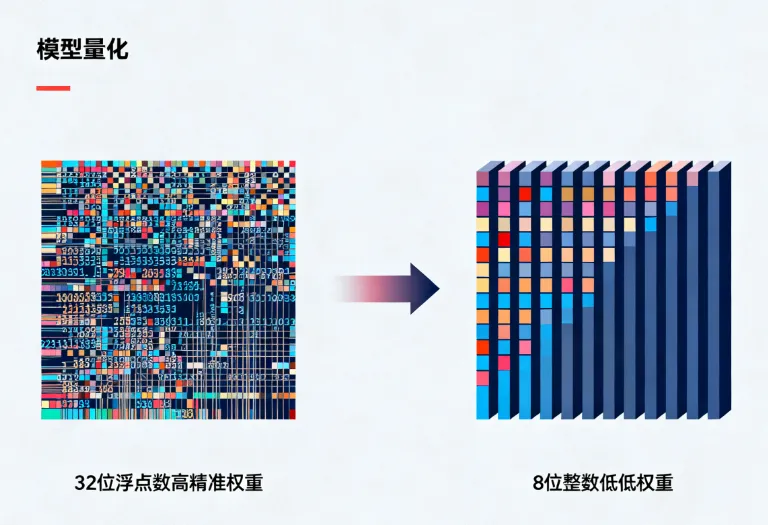

1.2 量化:数值精度降维

量化通过将高精度浮点数转换为低精度整数,实现存储与计算效率的双重优化。其数学本质为: 例如,将FP32(32位浮点数)量化为INT8(8位整数)时,若张量最大绝对值为3.4,则缩放因子为127/3.4≈37.35,原始值1.6将量化为60(1.6×37.35≈60)。

量化层级:

权重量化:仅压缩模型权重,激活值保持高精度,适用于推理阶段。

全量化:同时压缩权重与激活值,需在训练阶段引入模拟量化操作,防止精度崩塌。

典型误差:INT8量化可能引入3%-5%的精度损失,但通过量化感知训练(QAT)可恢复至原始精度的98%以上。

1.3 知识蒸馏:跨模型知识迁移

知识蒸馏通过构建“教师-学生”模型对,将大型教师模型的知识迁移至轻量学生模型。其核心机制包括:

软标签学习:学生模型不仅学习真实标签(硬标签),还拟合教师模型的输出概率分布(软标签)。例如,在图像分类任务中,教师模型对“猫”的预测概率为0.8,学生模型需学习这一概率分布而非单纯分类。

中间特征匹配:通过约束学生模型与教师模型的隐层特征相似度(如L2损失),强化知识传递。例如,在Transformer模型中,可对齐学生模型与教师模型的注意力权重矩阵。

典型架构:

同构蒸馏:教师与学生模型结构相似(如ResNet-152→ResNet-50),适用于模型轻量化。

异构蒸馏:教师与学生模型结构差异大(如CNN→Transformer),适用于跨架构知识迁移。

二、操作对象:从参数到模型关系的差异

| 技术类型 | 操作对象 | 核心修改方式 | 典型工具/框架 |

|---|---|---|---|

| 模型剪枝 | 单个模型的权重/神经元/通道 | 直接删除冗余组件 | PyTorch Pruning API、TensorFlow Model Optimization |

| 量化 | 模型的权重与激活值 | 降低数值精度 | TensorRT、TFLite、GGUF格式 |

| 知识蒸馏 | 两个独立模型的关系 | 通过损失函数引导学生模型学习 | HuggingFace DistilBERT、NVIDIA TRT-LLM |

2.1 模型剪枝:单模型内部优化

剪枝直接作用于原始模型,通过重要性评估准则(如权重幅度、梯度信息)识别冗余参数。例如:

L1-norm剪枝:计算每层权重的L1范数,删除范数值最小的权重。在VGG-16中,此方法可移除80%的权重而精度仅下降1%。

通道剪枝:基于BatchNorm层的缩放因子(γ)评估通道重要性,删除γ值接近零的通道。MobileNetV2通过此方法可压缩40%参数量,推理速度提升2倍。

2.2 量化:数值表示层优化

量化不改变模型结构,仅调整数据表示方式。其操作对象包括:

静态量化:在模型部署前完成量化,适用于推理阶段。例如,将BERT-base的权重从FP32量化为INT8,模型体积缩小4倍,推理延迟降低3倍。

动态量化:在推理过程中动态量化激活值,适用于RNN等序列模型。在语音识别任务中,动态量化可减少50%的内存占用。

2.3 知识蒸馏:跨模型知识传递

知识蒸馏涉及教师模型训练、学生模型设计、蒸馏损失设计三个阶段。例如:

教师模型训练:先训练一个高精度教师模型(如RoBERTa-Large),在GLUE基准测试中达到90%准确率。

学生模型设计:构建轻量学生模型(如DistilRoBERTa),参数量仅为教师的40%。

蒸馏训练:通过联合优化任务损失(交叉熵)与蒸馏损失(KL散度),使学生模型在MNLI任务中达到88%准确率,接近教师模型性能。

三、压缩效果:精度、速度与通用性的平衡

3.1 压缩比与精度保持

| 技术类型 | 典型压缩比 | 精度损失范围 | 适用场景 |

|---|---|---|---|

| 模型剪枝 | 10%-90% | 0%-5% | 硬件支持稀疏计算的场景 |

| 量化 | 4倍-16倍 | 1%-3% | 资源受限的边缘设备 |

| 知识蒸馏 | 5倍-20倍 | 0%-2% | 需要高泛化能力的实时系统 |

模型剪枝:在ResNet-50上,通过迭代剪枝与微调,可在压缩80%参数量的情况下保持99%的原始精度。

量化:INT8量化可使模型体积缩小4倍,在图像分类任务中精度损失低于1%;但极端量化(如4位)可能导致精度下降5%以上。

知识蒸馏:DistilBERT在压缩40%参数量的情况下,在GLUE基准测试中达到教师模型97%的性能。

3.2 推理速度提升

模型剪枝:结构化剪枝(如滤波器剪枝)在NVIDIA V100 GPU上可实现2倍推理加速;非结构化剪枝需专用硬件支持。

量化:INT8量化在CPU上可提升3倍推理速度,在GPU上提升1.5倍;激活量化可进一步加速。

知识蒸馏:学生模型因结构简化,推理速度通常提升2-5倍,且无需硬件修改。

3.3 通用性与部署成本

模型剪枝:需针对不同硬件调整剪枝策略,部署成本中等。

量化:需硬件支持低精度计算(如ARM Cortex-M7),部署成本较低。

知识蒸馏:学生模型可跨平台部署,但需重新训练教师模型,部署成本较高。

四、典型应用场景解析

4.1 模型剪枝:高压缩比需求场景

嵌入式设备部署:在无人机视觉系统中,通过剪枝将YOLOv5模型从27MB压缩至3MB,推理速度提升4倍,满足实时检测需求。

稀疏计算硬件优化:在Google TPU v4上,非结构化剪枝模型可利用稀疏核心(Sparse Core)实现10倍加速。

4.2 量化:资源受限边缘计算

移动端NLP模型:将BERT-base量化为INT8后,模型体积从110MB缩小至27MB,在iPhone 12上推理延迟从120ms降至35ms。

物联网传感器:在STM32微控制器上,量化后的CNN模型可实现每秒30帧的实时分类,功耗低于100mW。

4.3 知识蒸馏:跨架构知识迁移

医疗影像诊断:将3D CNN教师的知识蒸馏至2D CNN学生模型,在肺结节检测任务中达到98%的敏感度,模型参数量减少90%。

多模态学习:将CLIP视觉编码器的知识蒸馏至轻量Transformer,在图文匹配任务中实现与教师模型相当的性能,推理速度提升5倍。

五、技术选型指南

5.1 根据硬件条件选择

支持稀疏计算的GPU(如NVIDIA Ampere):优先选择非结构化剪枝,可实现最高压缩比。

通用CPU/移动端:量化是首选,尤其是INT8量化可平衡精度与速度。

无专用硬件的边缘设备:知识蒸馏结合轻量架构(如MobileNet)可实现最佳效果。

5.2 根据任务需求选择

高精度需求任务(如医疗诊断):知识蒸馏可最大限度保持性能,剪枝次之,量化需谨慎。

实时性要求高的任务(如自动驾驶):量化与结构化剪枝可显著提升速度。

跨模态/跨架构任务:知识蒸馏是唯一可行方案。

5.3 组合使用策略

剪枝+量化:先剪枝减少模型规模,再量化提升推理效率。例如,将ResNet-50剪枝至50%参数量后量化为INT8,模型体积缩小16倍,推理速度提升8倍。

剪枝+蒸馏:先剪枝教师模型,再用剪枝后的模型蒸馏学生模型。例如,将BERT-Large剪枝至60%参数量后蒸馏DistilBERT,可进一步提升学生模型性能。

六、结语:压缩技术的未来融合

模型剪枝、量化与知识蒸馏并非孤立技术,而是互补的压缩工具箱。在实际部署中,**“剪枝打底、量化加速、蒸馏提精”**的组合策略已成为主流。例如,在华为昇腾AI处理器上,通过结构化剪枝将YOLOv7压缩至40%参数量,再量化为INT8,最后用知识蒸馏优化边界框回归精度,最终模型在NVIDIA Jetson AGX Xavier上实现30FPS的实时检测,精度损失仅1.2%。

随着AI模型规模持续扩大,压缩技术将向自动化、跨模态、硬件协同方向演进。例如,AutoML可自动搜索最优剪枝比例与量化位宽;多模态蒸馏可实现文本-图像-音频的联合知识迁移;而与芯片厂商的深度合作将推动定制化压缩方案的普及。对于开发者而言,理解三大技术的本质差异与组合逻辑,是构建高效AI系统的关键第一步。

版权及免责申明:本文由@97ai原创发布。该文章观点仅代表作者本人,不代表本站立场。本站不承担任何相关法律责任。

如若转载,请注明出处:https://www.aipuzi.cn/ai-tutorial/model-pruning-compared-other-compression.html