为什么大模型需要量化?浅析计算效率与资源消耗的平衡策略

在人工智能进入大模型时代后,模型参数量呈现指数级增长。以GPT-3为例,其1750亿参数的模型在FP32格式下占用约350GB存储空间,单次推理需消耗128GB显存。这种资源消耗规模已...

在人工智能进入大模型时代后,模型参数量呈现指数级增长。以GPT-3为例,其1750亿参数的模型在FP32格式下占用约350GB存储空间,单次推理需消耗128GB显存。这种资源消耗规模已...

根据量化对象的不同,量化技术可分为三大核心类型:权重量化(Weight Quantization)、激活量化(Activation Quantization)和混合量化(Mixed-Precision Quantization)。...

在深度学习模型部署场景中,量化技术已成为平衡模型性能与硬件资源的关键手段。然而,量化级别的选择并非越激进越好,过度量化会导致模型精度损失超过5%,而保守量化则可能...

模型量化(Model Quantization)的本质是将神经网络中连续的浮点数值转换为离散的整数表示,通过降低数值精度实现模型压缩与加速。以FP32到INT8的转换为例,每个权重参数的...

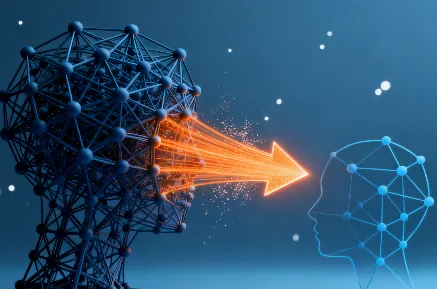

随着深度学习模型参数量突破千亿级,模型压缩技术成为连接实验室研究与工业落地的关键桥梁。其中,模型剪枝、量化与知识蒸馏作为三大主流压缩方法,因其技术路径差异显著,...