AntAngelMed:开源医疗大语言模型,三阶段训练打造权威基准领先性能

一、AntAngelMed 是什么

AntAngelMed 是一款面向医疗领域的开源大语言模型,由浙江省健康信息中心、蚂蚁医疗(Ant Healthcare)与浙江省安诊儿医学人工智能科技有限公司联合研发,核心定位是“提供专业、安全、高效的医疗AI能力”,填补开源医疗大模型在性能与实用性上的空白。

与通用大语言模型不同,AntAngelMed 并非简单将通用模型迁移至医疗场景,而是从底层训练流程到能力优化都深度聚焦医疗领域需求:通过大规模医疗语料注入专业知识,通过医疗场景指令微调适配临床实际需求,通过强化学习保障回答的安全性与伦理合规性,最终实现“医疗知识扎实、诊断推理严谨、安全边界清晰”的核心特性。

作为当前开源医疗大语言模型的标杆之作,AntAngelMed 具有三大核心身份:

性能领先的开源医疗模型:在 OpenAI 发布的 HealthBench、国家级 MedAIBench 等权威基准中,超越所有开源模型及多款闭源顶级模型,综合能力位居前列;

高效推理的轻量化解决方案:采用 MoE(混合专家模型)架构,在保证性能媲美 40B 稠密模型的同时,大幅降低推理时的参数激活量与算力消耗,支持高并发、低延迟场景;

全场景适配的医疗AI工具:覆盖医患沟通、临床辅助决策、医疗知识普及、医疗教育等多场景,既可为普通用户提供可靠的健康咨询,也能为医疗从业者、开发者提供专业的技术支撑。

简单来说,AntAngelMed 是一款“为医疗而生”的开源AI模型,它打破了医疗大模型“闭源垄断”的局面,让医疗AI技术的核心能力触手可及,既满足科研机构的技术探索需求,也能支撑企业级医疗应用的快速落地。

二、功能特色

AntAngelMed 围绕“专业、高效、安全、易用”四大核心目标设计,其功能特色覆盖性能表现、医疗能力、推理效率、使用适配等多个维度,具体如下表所示:

| 功能特色分类 | 具体功能点 | 核心价值 |

|---|---|---|

| 权威基准顶尖表现 |

1. HealthBench(OpenAI):开源模型首位,HealthBench-Hard子集优势显著 2. MedAIBench(国家级):跻身顶级梯队,医疗知识与安全伦理表现突出 3. MedBench(中文医疗):综合排名第一,五大核心维度全面领先 | 经过权威评测验证,医疗专业能力与可靠性有明确数据支撑,可放心用于医疗相关场景 |

| 全面医疗专业能力 |

1. 医疗知识问答:覆盖内科、外科、儿科等多科室疾病知识,精准解答病因、症状、治疗方案等问题 2. 诊断推理:支持基于症状描述的多轮问诊与初步诊断建议 3. 安全伦理合规:严格遵循医疗伦理规范,拒绝超出能力范围的诊断承诺,提示就医建议 4. 医疗文本处理:理解病历、学术论文等专业文本,支持摘要、分析等功能 | 深度适配医疗场景需求,具备从基础咨询到专业辅助的全链条医疗能力 |

| 极致高效推理性能 |

1. 高效MoE架构:100B参数量仅激活6.1B参数,性能媲美40B稠密模型 2. 高速推理:H20硬件上达200 tokens/s,是36B稠密模型的3倍 3. 长上下文支持:128K tokens上下文长度,适配长文本病历、多轮复杂问诊 4. 量化优化:FP8量化+EAGLE3优化,32并发下吞吐量大幅提升 | 降低算力门槛与使用成本,支持高并发、低延迟的实际应用场景,适配不同硬件条件 |

| 灵活易用的部署特性 |

1. 多平台支持:兼容 Hugging Face、ModelScope 模型仓库,支持主流框架调用 2. 多硬件适配:支持 Nvidia A100、Ascend 910B 等 GPU/NPU 硬件 3. 多部署方式:支持离线批量推理、在线API服务部署 4. 轻量化版本:提供 FP8 量化版本,进一步降低部署成本 | 降低开发者使用门槛,适配科研、企业、临床等不同场景的部署需求 |

除上述核心功能外,AntAngelMed 还具备以下细节优势:

多轮对话能力:支持复杂医疗场景的多轮交互,可根据用户补充的症状、病史等信息动态调整回答,模拟真实问诊流程;

中文适配优化:在中文医疗基准 MedBench 中表现顶尖,针对中文医疗术语、病历格式、医患沟通习惯进行专项优化,适配国内医疗场景;

低幻觉特性:通过强化学习与事实性校验机制,大幅降低医疗知识类回答的幻觉率,保证信息的准确性与可靠性;

开源开放特性:模型权重、训练思路、使用教程完全开源,支持二次开发与定制化优化,推动医疗AI技术生态共建。

三、技术细节

AntAngelMed 的核心竞争力源于其先进的技术架构与严谨的训练体系,核心技术可拆解为“三阶段训练流程”“高效 MoE 架构设计”“推理优化技术”三大模块,以下展开详细说明:

3.1 核心技术栈

AntAngelMed 基于成熟的大模型技术生态构建,核心技术栈如下:

基础框架:PyTorch(模型训练与推理核心框架)、Transformers(模型加载与调用)、vLLM/SGLang(高效推理引擎);

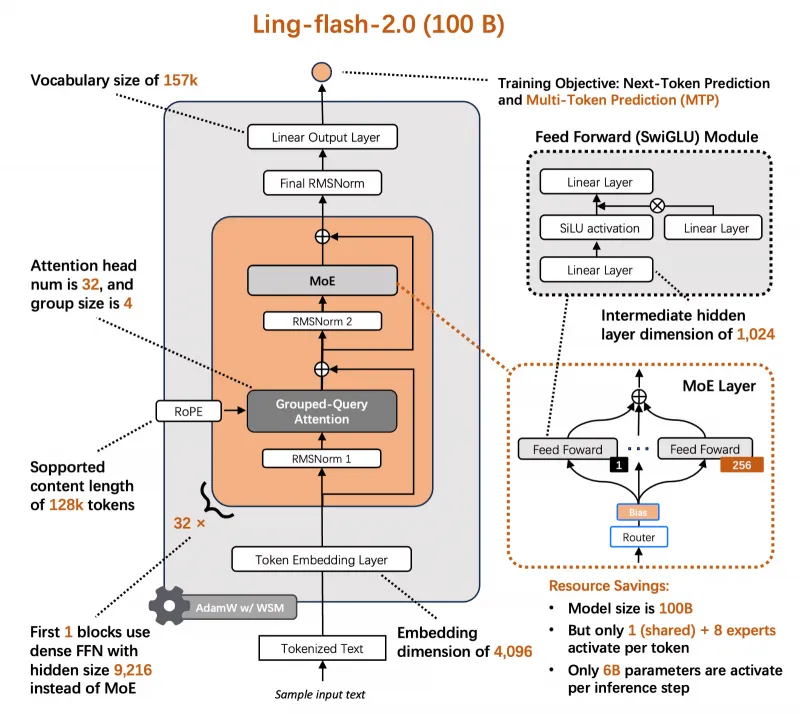

模型架构:Ling-flash-2.0(基础模型架构)、MoE(混合专家模型)、Grouped-Query Attention(分组查询注意力);

训练技术:持续预训练(CPT)、监督微调(SFT)、强化学习(GRPO 算法);

优化技术:FP8 量化、EAGLE3 优化、YaRN 上下文外推、QK-Norm 归一化;

硬件支持:Nvidia GPU(A100/H20)、Ascend NPU(910B),支持张量并行、专家并行等分布式训练/推理策略。

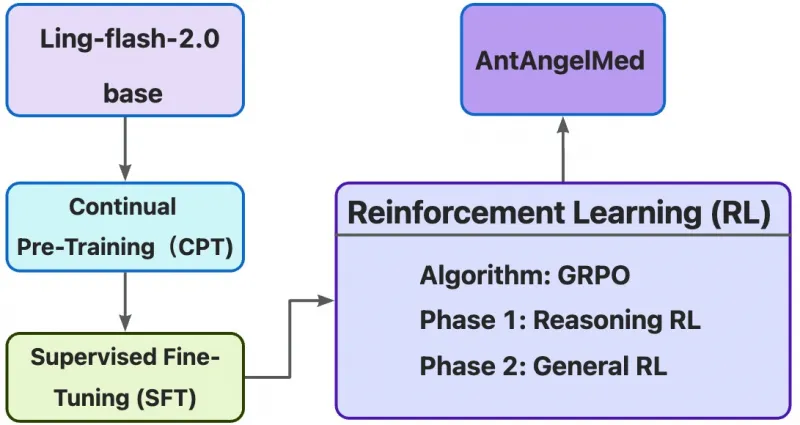

3.2 三阶段训练体系:构建医疗专业能力

AntAngelMed 采用“持续预训练→监督微调→强化学习”的三阶段训练流程,层层递进注入医疗知识与专业能力,是模型性能领先的核心原因:

3.2.1 第一阶段:持续预训练(Continual Pre-Training)

基础模型:基于 Ling-flash-2.0 模型进行扩展,该模型具备 100B 参数量、157K 词汇表,支持多token预测(MTP)训练目标;

语料输入:大规模高质量医疗语料库,涵盖医学百科、临床指南、学术论文、权威医疗网页文本等,同时补充部分通用语料以保留基础推理能力;

训练目标:通过 next-token prediction(下一个token预测)与 MTP(多token预测)任务,让模型学习医疗知识的语义结构、术语关联与逻辑关系,构建扎实的医疗知识底座。

3.2.2 第二阶段:监督微调(Supervised Fine-Tuning, SFT)

数据集构建:构建多源异构的高质量指令数据集,分为两大类别:

通用能力数据:包含数学、编程、逻辑推理等任务,强化模型的核心思维链(Chain-of-Thought)能力;

医疗场景数据:涵盖医患问答、诊断推理、病历分析、医疗伦理判断等场景,均经过专业医疗人员审核,确保数据的专业性与合规性;

训练目标:让模型学习“理解医疗需求→输出专业回答”的映射关系,适配医疗场景的对话逻辑,同时强化对医疗指令的精准理解能力。

3.2.3 第三阶段:强化学习(Reinforcement Learning, RL)

算法选择:采用 GRPO(Generative Reward Policy Optimization)算法,结合任务专属奖励模型(Reward Model)进行训练;

训练分两阶段:

推理强化(Phase 1):优化复杂医疗病例的推理能力,鼓励模型基于证据链推导结论,减少主观臆断;

通用强化(Phase 2):强化回答的共情能力、结构清晰度与安全边界,确保回答既专业又易懂,同时严格遵守医疗伦理,不替代医生诊断;

核心价值:通过强化学习进一步降低模型幻觉率,提升回答的一致性与可靠性,让模型在真实医疗场景中更具实用性。

3.3 高效 MoE 架构:平衡性能与推理效率

AntAngelMed 继承 Ling-flash-2.0 的先进 MoE 架构设计,通过“少量专家激活”实现“大参数量模型性能+小参数量推理效率”的平衡,核心架构细节如下:

3.3.1 架构核心参数

| 架构参数 | 具体配置 |

|---|---|

| 总参数量 | 100B |

| 激活参数量 | 6.1B(仅激活 1/32 专家,1个共享专家+8个任务专家) |

| 词汇表大小 | 157K |

| 注意力头数 | 32 头,采用分组查询注意力(Grouped-Query Attention),组大小为4 |

| 隐藏层维度 | 9216 |

| 中间层维度 | 1024(SwiGLU 激活函数) |

| 上下文长度 | 128K(通过 YaRN 外推技术实现) |

| 训练目标 | Next-Token Prediction + Multi-Token Prediction(MTP) |

3.3.2 架构优化设计

专家路由机制:采用 sigmoid 路由策略,无辅助损失函数,让模型自动为不同医疗任务匹配最优专家,提升任务适配性;

层结构优化:包含 RMSNorm 归一化、MTP 层、QK-Norm 等优化组件,减少训练不稳定性,提升模型收敛速度与推理效率;

无偏置设计:模型各层均不使用偏置项,降低参数冗余,同时提升推理速度;

性能对标:6.1B 激活参数的性能媲美 40B 稠密模型,而推理效率提升 3-7 倍,实现“性能不打折,效率大幅提升”。

3.4 推理优化技术:提升部署实用性

为适配不同场景的部署需求,AntAngelMed 引入多项推理优化技术,进一步降低使用门槛:

FP8 量化+EAGLE3 优化:在不显著损失性能的前提下,将模型量化为 FP8 精度,结合 EAGLE3 优化策略,32 并发下推理吞吐量大幅提升(HumanEval 提 71%、GSM8K 提 45%、Math-500 提 94%);

长上下文支持:通过 YaRN 外推技术,将上下文长度扩展至 128K tokens,可处理完整病历、多轮复杂问诊等长文本场景,输出长度越长相对提速越显著(最高达 7 倍);

多推理引擎适配:支持 vLLM、SGLang 等主流高效推理引擎,支持批量推理与在线 API 服务部署,适配高并发场景;

硬件兼容性优化:同时支持 Nvidia GPU(A100/H20)与 Ascend NPU(910B),提供针对性的部署方案,降低硬件选型门槛。

四、应用场景

AntAngelMed 凭借“专业能力扎实、推理效率高、安全合规”的核心优势,可广泛应用于医疗健康领域的多个场景,覆盖普通用户、医疗从业者、科研人员、教育机构等不同群体,具体如下:

4.1 医患沟通与健康咨询场景

适用人群:普通用户、社区医生、基层医疗机构;

核心用途:

健康问题初步咨询:用户可通过自然语言描述症状、病史,模型提供初步的健康建议、可能的病因分析与就医指导,避免盲目就医或忽视病情;

慢病管理辅助:为高血压、糖尿病等慢病患者提供日常护理建议、用药提醒、饮食指导,辅助患者进行自我健康管理;

医患沟通辅助:基层医生可借助模型快速生成通俗易懂的病情解释、治疗方案说明,提升医患沟通效率,减少信息不对称。

核心价值:提供 7x24 小时可及的健康咨询服务,缓解基层医疗资源紧张问题,同时引导用户科学就医。

4.2 临床辅助决策场景

适用人群:临床医生(尤其是基层医生、年轻医生);

核心用途:

病例分析辅助:医生输入患者症状、检查结果等信息,模型提供可能的诊断方向、鉴别诊断建议、进一步检查项目推荐,为临床决策提供参考;

治疗方案优化:针对具体疾病,模型提供基于临床指南的治疗方案建议,包括用药推荐、剂量参考、注意事项等,帮助医生优化治疗方案;

病历结构化处理:将非结构化的病历文本(如病程记录、出院小结)自动转换为结构化数据,便于病历管理与数据分析。

核心价值:作为医生的“AI助手”,弥补年轻医生经验不足的短板,提升诊断准确性与治疗规范性,降低医疗风险(注:模型输出仅为参考,不可替代医生最终诊断)。

4.3 医疗教育与培训场景

适用人群:医学生、规培医生、医疗培训机构;

核心用途:

知识问答与复习:医学生可通过模型查询医学知识点、解析疑难问题,进行考前复习与知识巩固;

病例模拟训练:模型可生成多样化的模拟病例,医学生通过分析病例、给出诊断与治疗方案,提升临床思维能力;

教学资源生成:教师可借助模型快速生成教学课件、习题集、病例分析材料,丰富教学内容,提升教学效率。

核心价值:构建低成本、可复用的医疗教育工具,提升医疗人才培养质量与效率。

4.4 医疗科研与产品开发场景

适用人群:医疗科研人员、AI开发者、医疗科技企业;

核心用途:

科研数据处理:辅助科研人员解析医学文献、提取关键信息、进行文献综述,加速科研进程;

医疗AI产品开发:基于开源模型进行二次开发,快速搭建医疗问答机器人、智能病历系统、健康管理APP等产品,降低开发成本;

算法优化研究:作为开源医疗大模型基准,为科研人员提供技术参考,推动医疗AI算法的创新与优化。

核心价值:降低医疗AI领域的科研与开发门槛,促进技术创新与产业落地。

4.5 医疗知识普及场景

适用人群:健康科普工作者、媒体机构、公共卫生部门;

核心用途:

科普内容生成:快速生成通俗易懂的医疗科普文章、短视频脚本、图文素材,覆盖疾病预防、健康生活方式、公共卫生事件应对等主题;

个性化科普推送:根据不同人群(如老年人、儿童、孕妇)的需求,生成针对性的科普内容,提升科普效果;

公共卫生宣传:在传染病防控、突发公共卫生事件等场景中,快速生成权威科普信息,引导公众科学应对。

核心价值:提升医疗科普的传播效率与覆盖面,增强公众健康素养。

五、使用方法

AntAngelMed 提供了灵活多样的使用方式,支持从“快速调用体验”到“大规模部署应用”的全场景需求,涵盖 Hugging Face、ModelScope 平台调用,以及 Nvidia/Ascend 硬件部署,以下是详细使用指南:

5.1 环境准备

无论选择哪种使用方式,需先准备基础环境,核心要求如下:

操作系统:Linux(推荐 Ubuntu 20.04+),Windows/macOS 仅支持小规模测试;

Python 版本:3.8+;

核心依赖:transformers、torch、vllm(或 sglang)、modelscope(可选);

硬件要求:

测试体验:GPU 显存 ≥16GB(如 Nvidia RTX 3090/4090);

正式部署:Nvidia A100(40GB/80GB)或 Ascend 910B(64*8GB),支持张量并行与专家并行。

5.2 快速调用:Hugging Face Transformers

通过 Hugging Face Transformers 库可快速调用模型,适合小规模测试与开发,步骤如下:

安装依赖

pip install transformers torch accelerate

调用代码示例

from transformers import AutoModelForCausalLM, AutoTokenizer # 模型名称或本地路径 model_name = "MedAIBase/AntAngelMed" # 加载模型与Tokenizer(trust_remote_code=True 用于加载自定义模型结构) model = AutoModelForCausalLM.from_pretrained( model_name, device_map="auto", # 自动分配设备(CPU/GPU) trust_remote_code=True, dtype="bfloat16" # 数据类型,支持 bfloat16/float16 ) tokenizer = AutoTokenizer.from_pretrained(model_name, trust_remote_code=True) # 构建对话prompt(支持多轮对话) prompt = "我最近经常头痛,尤其是熬夜后更明显,该怎么办?" messages = [ {"role": "system", "content": "你是 AntAngelMed,一款专业的医疗助手,将为用户提供健康咨询建议,不替代医生诊断。"}, {"role": "user", "content": prompt} ] # 格式化对话文本 text = tokenizer.apply_chat_template( messages, tokenize=False, add_generation_prompt=True # 添加生成提示 ) # 模型输入处理 model_inputs = tokenizer([text], return_tensors="pt", return_token_type_ids=False).to(model.device) # 生成回答(可调整参数控制生成效果) generated_ids = model.generate( **model_inputs, max_new_tokens=16384, # 最大生成token数 temperature=0.6, # 随机性,0-1之间,越小越确定 top_p=0.95, # 核采样概率 repetition_penalty=1.05 # 重复惩罚,避免回答冗余 ) # 提取并解码生成结果 generated_ids = [ output_ids[len(input_ids):] for input_ids, output_ids in zip(model_inputs.input_ids, generated_ids) ] response = tokenizer.batch_decode(generated_ids, skip_special_tokens=True)[0] # 打印回答 print("AntAngelMed 回答:", response)

5.3 高效部署:Nvidia A100 硬件

对于需要高并发、低延迟的正式场景,推荐使用 vLLM 或 SGLang 推理引擎部署,以下以 vLLM 为例:

5.3.1 vLLM 部署步骤

安装 vLLM 依赖

pip install vllm==0.11.0

离线批量推理代码

from modelscope import AutoTokenizer from vllm import LLM, SamplingParams def main(): # 模型路径(Hugging Face 或 ModelScope 地址) model_path = "MedAIBase/AntAngelMed" # 加载Tokenizer tokenizer = AutoTokenizer.from_pretrained(model_path, trust_remote_code=True) # 配置采样参数 sampling_params = SamplingParams( temperature=0.6, top_p=0.95, top_k=20, repetition_penalty=1.05, max_tokens=16384, # 最大生成长度 ) # 加载模型(tensor_parallel_size 为张量并行数,需根据GPU数量调整) llm = LLM( model=model_path, trust_remote_code=True, dtype="bfloat16", tensor_parallel_size=4, # 4张GPU并行 gpu_memory_utilization=0.97 # GPU显存利用率 ) # 构建对话文本 prompt = "我最近经常头痛,尤其是熬夜后更明显,该怎么办?" messages = [ {"role": "system", "content": "你是 AntAngelMed,一款专业的医疗助手,将为用户提供健康咨询建议,不替代医生诊断。"}, {"role": "user", "content": prompt}, ] text = tokenizer.apply_chat_template( messages, tokenize=False, add_generation_prompt=True, ) # 批量生成(支持同时输入多个prompt) outputs = llm.generate([text], sampling_params) # 输出结果 for output in outputs: prompt = output.prompt generated_text = output.outputs[0].text print(f"用户提问:{prompt}") print(f"模型回答:{generated_text}\n") if __name__ == "__main__": main()

5.3.2 在线 API 服务部署

通过 vLLM 可快速搭建 OpenAI 兼容的 API 服务,支持高并发调用:

# 启动 API 服务 python -m vllm.entrypoints.openai.api_server \ --model MedAIBase/AntAngelMed \ --tensor-parallel-size 4 \ --max-num-seqs 200 \ --gpu-memory-utilization 0.97 \ --served-model-name AntAngelMed \ --max-model-len 32768 \ --port 8080 \ --trust-remote-code

调用 API 示例(curl)

curl http://0.0.0.0:8080/v1/chat/completions -d '{

"model": "AntAngelMed",

"messages": [

{

"role": "system",

"content": "你是 AntAngelMed,一款专业的医疗助手,将为用户提供健康咨询建议,不替代医生诊断。"

},

{

"role": "user",

"content": "我最近经常头痛,尤其是熬夜后更明显,该怎么办?"

}

],

"temperature": 0.6

}'5.4 Ascend 910B 硬件部署

AntAngelMed 支持 Ascend 910B NPU 部署,推荐使用 vLLM-Ascend 推理引擎,步骤如下:

环境准备(Docker 方式)

# 拉取 Ascend vLLM 镜像 docker pull quay.io/ascend/vllm-ascend:v0.11.0rc3 # 启动容器(需根据实际硬件调整设备映射) NAME=antangelmed-ascend MODEL_PATH=/path/to/local/model # 本地模型路径(可选) docker run -itd --privileged --name=$NAME --net=host \ --shm-size=1000g \ --device /dev/davinci0 --device /dev/davinci1 --device /dev/davinci2 --device /dev/davinci3 \ --device /dev/davinci4 --device /dev/davinci5 --device /dev/davinci6 --device /dev/davinci7 \ --device=/dev/davinci_manager --device=/dev/hisi_hdc --device /dev/devmm_svm \ -v /usr/local/dcmi:/usr/local/dcmi \ -v /usr/local/bin/npu-smi:/usr/local/bin/npu-smi \ -v /usr/local/Ascend/driver/lib64/:/usr/local/Ascend/driver/lib64/ \ -v $MODEL_PATH:$MODEL_PATH \ quay.io/ascend/vllm-ascend:v0.11.0rc3 \ bash # 进入容器 docker exec -u root -it $NAME bash

配置环境变量

export PYTORCH_NPU_ALLOC_CONF=expandable_segments:True export HCCL_OP_EXPANSION_MODE="AIV" export NPU_MEMORY_FRACTION=0.97 export TASK_QUEUE_ENABLE=1 export OMP_NUM_THREADS=100 export ASCEND_RT_VISIBLE_DEVICES=0,1,2,3,4,5,6,7 export VLLM_USE_MODELSCOPE=true # 使用 ModelScope 加速模型下载

离线推理代码

from transformers import AutoTokenizer from vllm import LLM, SamplingParams model_path = "MedAIBase/AntAngelMed" tokenizer = AutoTokenizer.from_pretrained(model_path, trust_remote_code=True) # 配置采样参数 sampling_params = SamplingParams( temperature=0.7, top_p=0.8, repetition_penalty=1.05, max_tokens=16384 ) # 加载模型 llm = LLM( model=model_path, dtype='float16', tensor_parallel_size=4, gpu_memory_utilization=0.97, enable_prefix_caching=True, enable_expert_parallel=True, trust_remote_code=True ) # 构建对话并生成 prompt = "我最近经常头痛,尤其是熬夜后更明显,该怎么办?" messages = [ {"role": "system", "content": "你是 AntAngelMed,一款专业的医疗助手,将为用户提供健康咨询建议,不替代医生诊断。"}, {"role": "user", "content": prompt} ] text = tokenizer.apply_chat_template(messages, tokenize=False, add_generation_prompt=True) outputs = llm.generate([text], sampling_params) # 打印结果 print(outputs[0].outputs[0].text)

5.5 量化版本使用(FP8)

为进一步降低部署成本,AntAngelMed 提供 FP8 量化版本,使用方式与基础版本一致,仅需替换模型路径:

Hugging Face:

MedAIBase/AntAngelMed-FP8ModelScope:

MedAIBase/AntAngelMed-FP8

量化版本在保持核心性能的同时,显存占用降低约 50%,推理速度进一步提升,适合显存有限的硬件环境。

六、常见问题解答

Q1:AntAngelMed 的回答可以替代医生诊断吗?

A:不可以。AntAngelMed 的核心定位是“医疗辅助工具”,其回答仅为健康咨询建议或参考信息,不能替代医生的专业诊断、治疗方案与医嘱。对于疾病诊断、治疗、用药等关键决策,必须由具备执业资格的医疗人员根据患者实际情况做出,模型输出仅作为辅助参考,不可直接采纳。

Q2:模型支持哪些医疗领域的问题?是否覆盖所有科室?

A:AntAngelMed 覆盖内科、外科、儿科、妇产科、皮肤科、急诊科等多个主流科室的常见疾病与健康问题,在医疗知识问答、症状分析、就医指导等方面表现突出。但对于极少数罕见病、专科手术细节、复杂影像学诊断等高度专业的场景,模型回答的准确性可能有限,建议优先咨询相关领域专科医生。

Q3:部署模型需要多少算力?普通GPU可以运行吗?

A:模型部署的算力需求因版本与使用场景而异:

测试体验:FP8 量化版本可在 16GB 显存的 GPU(如 RTX 3090/4090)上运行,但仅适合小规模测试,推理速度较慢;

正式部署:推荐使用 Nvidia A100(40GB/80GB)或 Ascend 910B 硬件,通过张量并行(4-8 卡)实现高并发、低延迟推理;

核心原则:显存越大、GPU/NPU 数量越多,推理速度与并发能力越强,建议根据实际使用规模选择硬件。

Q4:模型的中文支持效果如何?是否适配国内医疗场景?

A:AntAngelMed 针对中文医疗场景进行了专项优化,在中文医疗基准 MedBench(涵盖 70 万中文医疗样本)中综合排名第一,具备优秀的中文理解与生成能力。模型适配国内医疗术语习惯、病历格式与医患沟通场景,能够准确理解中文症状描述、医疗问题,并输出通俗易懂的中文回答,完全满足国内医疗场景的使用需求。

Q5:如何保证模型回答的安全性与伦理合规性?

A:模型通过多重机制保障安全性与伦理合规:

训练阶段:强化学习阶段专门优化安全边界,拒绝超出能力范围的诊断承诺,强制提示“不可替代医生”;

数据层面:训练数据均经过专业医疗人员审核,避免违规、错误信息;

生成阶段:通过 repetition_penalty、温度控制等参数,减少误导性回答,鼓励基于证据链推导;

系统提示:默认系统提示明确模型定位,限制其功能边界,引导用户科学使用。

Q6:模型支持长文本输入吗?最大能处理多少字符?

A:支持。AntAngelMed 通过 YaRN 外推技术,支持 128K tokens 的长上下文长度,约合 9-10 万字中文文本,可处理完整病历、多轮复杂问诊、长篇医学文献等长文本场景。随着输出长度增加,模型的相对推理速度会进一步提升,最长可生成 16384 tokens 的回答,满足复杂医疗场景的需求。

Q7:如何基于 AntAngelMed 进行二次开发?

A:作为开源模型,AntAngelMed 支持灵活的二次开发:

模型微调:可基于自有医疗语料(如特定科室病例、医院专属指南)进行增量预训练或监督微调,优化模型在特定场景的表现;

功能集成:可将模型集成到医疗APP、电子病历系统、健康管理平台等产品中,通过 API 或 SDK 提供服务;

技术优化:可针对特定硬件或场景,进一步优化推理引擎、量化策略、部署方案,提升性能与实用性;

注意事项:二次开发需遵守 MIT 许可证,保留原版权声明,同时确保应用符合医疗AI相关法律法规与伦理要求。

Q8:模型在哪些基准上表现突出?具体成绩如何?

A:模型在三大权威医疗基准中表现顶尖,核心成绩如下:

HealthBench(OpenAI):开源模型排名第一,综合得分 62.5,HealthBench-Hard 子集得分 60.1,超越所有开源模型及多款闭源模型;

MedAIBench(国家级):跻身顶级梯队,在医疗知识问答、医疗伦理/安全维度表现突出,综合能力与闭源顶尖模型持平;

MedBench(中文医疗):综合排名第一,覆盖 36 个数据集、70 万样本,在医疗知识问答、语言理解/生成、复杂推理、安全伦理五大维度均领先。

七、相关链接

GitHub 仓库:https://github.com/MedAIBase/AntAngelMed

Hugging Face 模型库:

ModelScope 模型库:

八、总结

AntAngelMed 是一款由三方联合研发的开源医疗大语言模型,凭借“三阶段训练体系+高效 MoE 架构”,在权威医疗基准中实现顶尖表现,同时兼顾推理效率与部署灵活性,成为开源医疗AI领域的标杆之作。该模型深度融合医疗专业知识与通用推理能力,覆盖医患问答、临床辅助、医疗教育、科研开发等多场景,既为普通用户提供可及的健康咨询服务,也为医疗从业者、开发者提供高性能的技术支撑。其开源特性打破了医疗大模型的技术壁垒,FP8 量化版本与多硬件适配方案降低了使用门槛,MIT 许可证保障了商业与非商业场景的灵活应用。作为一款“专业、安全、高效”的医疗AI工具,AntAngelMed 不仅填补了开源医疗大模型在性能上的空白,更推动了医疗AI技术的普及与创新,为医疗健康领域的智能化升级提供了可靠的开源解决方案。

版权及免责申明:本文由@97ai原创发布。该文章观点仅代表作者本人,不代表本站立场。本站不承担任何相关法律责任。

如若转载,请注明出处:https://www.aipuzi.cn/ai-news/antangelmed.html