BitNet:微软开源1-bit大语言模型高效推理框架

1. BitNet是什么

BitNet是微软推出的一个开源1-bit大语言模型推理框架,专门用于运行1-bit量化的大语言模型(LLM)。该项目最初是为了支持微软自研的BitNet b1.58模型而创建的,但现在已经扩展到支持多种1-bit量化模型。BitNet的核心优势在于能够在资源受限的设备上运行大规模语言模型。通过使用1-bit量化技术,模型大小可以减少到原始FP16模型的1/16,这使得即使是拥有100B参数的巨型模型也能在普通CPU上运行。

BitNet与传统LLM推理框架的区别:

| 特性 | BitNet | 传统LLM推理框架(如llama.cpp) |

|---|---|---|

| 量化精度 | 专注于1-bit(特别是1.58-bit)量化模型 | 主要支持4-bit、8-bit等更高精度量化 |

| 资源需求 | 极低,适合边缘设备和普通CPU | 较高,通常需要高性能CPU或GPU |

| 推理速度 | 在CPU上表现优异,接近人类阅读速度 | 在低资源设备上速度较慢 |

| 模型兼容性 | 专注于1-bit量化模型 | 支持多种精度和模型架构 |

2. 功能特色

2.1 高效的1-bit模型推理

BitNet的核心优势是其针对1-bit量化模型的优化推理引擎。与传统的4-bit或8-bit量化相比,1-bit量化能将模型大小减少到原来的1/4到1/8,极大降低了内存占用和计算需求。

2.2 多平台支持

BitNet支持多种硬件架构,包括:

x86架构:利用AVX2等指令集优化

ARM架构:针对NEON指令集进行了优化

GPU支持:最新版本已添加对GPU推理的支持

2.3 高性能与低能耗

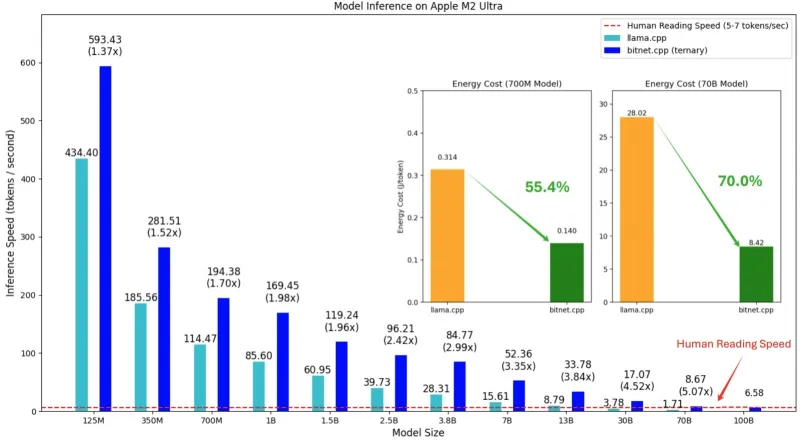

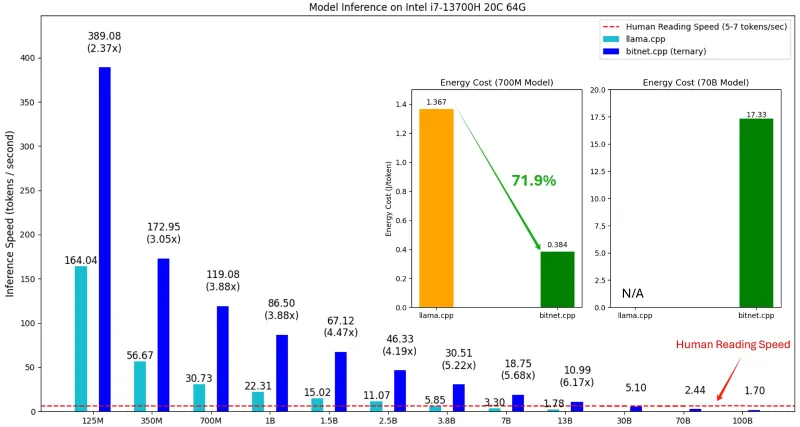

根据官方测试数据,BitNet在不同架构上的性能表现:

ARM架构:提速1.37x-5.07x,能耗降低55.4%-70.0%

x86架构:提速2.37x-6.17x,能耗降低71.9%-82.2%

2.4 广泛的模型兼容性

BitNet不仅支持微软自家的BitNet b1.58模型,还兼容Hugging Face上多种1-bit量化模型,包括:

1bitLLM/bitnetb158-large (0.7B参数)

HF1BitLLM/Llama3-8B-1.58-100B-tokens (8.0B参数)

tiiuae/Falcon3系列 (1B-10B参数)

2.5 易于使用和部署

BitNet提供了简洁的命令行接口和Python API,使得模型部署变得简单快捷。同时,项目提供了详细的文档和示例代码,帮助用户快速上手。

3. 技术细节

3.1 1-bit量化原理

1-bit量化是一种极端的模型压缩技术,它将每个权重从16位或32位浮点数压缩到仅1位。这种压缩率虽然惊人,但也带来了巨大的技术挑战。

BitNet采用了一种名为"1.58-bit"的混合量化方案,它实际上是一种基于块的量化方法,结合了1-bit权重和2-bit缩放因子。这种方法在保持极高压缩率的同时,能够更好地保留模型精度。

3.2 优化的计算内核

BitNet实现了多种优化的计算内核,以适应不同的硬件架构和模型类型:

I2_S内核:适用于对称量化的模型

TL1内核:适用于查找表(Table Lookup)方法的模型

TL2内核:另一种查找表方法的实现,适用于特定模型

这些内核针对不同的CPU指令集进行了深度优化,包括x86的AVX2和ARM的NEON指令集。

3.3 架构设计

BitNet基于llama.cpp框架构建,保留了其简洁高效的架构特点。项目结构清晰,主要包括:

preset_kernels:针对不同架构的优化内核实现

examples:示例代码和使用案例

scripts:辅助脚本,如模型转换工具

tests:测试代码

3.4 GPU支持

最新版本的BitNet添加了对GPU推理的支持,通过利用CUDA加速,可以进一步提升推理性能。这使得BitNet不仅适用于边缘设备,也可以在高性能计算环境中发挥作用。

4. 应用场景

4.1 边缘设备部署

BitNet的低资源需求使其成为边缘设备部署大模型的理想选择。例如:

在普通笔记本电脑上运行100B参数的模型

在嵌入式设备上部署AI助手

在移动设备上实现离线AI功能

4.2 低功耗环境应用

由于BitNet的高效设计,它在低功耗环境中表现出色:

延长移动设备的电池寿命

减少数据中心的能源消耗

支持可持续的AI应用部署

4.3 教育和研究

BitNet为AI研究人员和学生提供了一个低成本的大模型研究平台:

无需昂贵GPU即可进行大模型实验

便于研究量化技术对模型性能的影响

提供了学习高效推理引擎设计的实践机会

4.4 大规模部署

对于需要部署大量AI模型的组织,BitNet可以显著降低硬件成本:

减少服务器数量需求

降低内存和存储要求

简化部署和维护流程

5. 使用方法

5.1 环境准备

BitNet需要以下依赖:

Python 3.9+

CMake 3.22+

Clang 18+ (或其他支持C++20的编译器)

Git (用于克隆仓库)

推荐使用Conda创建独立的环境:

conda create -n bitnet python=3.10 conda activate bitnet

5.2 安装步骤

克隆仓库 (包含子模块):

git clone --recurse-submodules https://github.com/microsoft/BitNet.git cd BitNet

安装Python依赖:

pip install -r requirements.txt

下载模型: 可以通过Hugging Face Hub下载支持的模型,例如:

huggingface-cli download 1bitLLM/bitnet_b1_58-large --local-dir models/bitnet_b1_58-large

配置环境:

python setup_env.py

5.3 基本使用

命令行接口:

# 启动交互式聊天 ./bitnet -m models/bitnet_b1_58-large/ggml-model-q4_0.bin -i -r "User:" -p "User: Hello! What can you do?\nAssistant:" # 文本补全 ./bitnet -m models/bitnet_b1_58-large/ggml-model-q4_0.bin -p "The future of AI is"

Python API:

from bitnet import BitNet

# 加载模型

model = BitNet("models/bitnet_b1_58-large/ggml-model-q4_0.bin")

# 文本生成

output = model.generate("The future of AI is", max_tokens=50)

print(output)

# 聊天模式

chat_history = []

while True:

user_input = input("You: ")

if user_input.lower() in ["exit", "quit"]:

break

chat_history.append(f"User: {user_input}")

prompt = "\n".join(chat_history) + "\nAssistant:"

response = model.generate(prompt, max_tokens=100)

print(f"Assistant: {response}")

chat_history.append(f"Assistant: {response}")

6. 常见问题解答

6.1 硬件要求

最低配置:

CPU: 支持AVX2 (x86)或NEON (ARM)指令集

内存: 运行2B参数模型需要约2GB RAM

存储: 模型文件大小从几百MB到几GB不等

推荐配置:

多核CPU (8核或以上)

16GB或以上RAM

支持CUDA的GPU (用于GPU加速)

6.2 模型兼容性

BitNet主要支持1-bit量化的模型,特别是采用1.58-bit量化方案的模型。虽然项目也支持部分其他量化精度的模型,但性能优化主要针对1-bit模型。

6.3 性能优化建议

使用最新版本:BitNet正在快速发展,新版本通常包含性能改进

选择合适的内核:根据模型类型和硬件架构选择最佳内核

调整线程数:根据CPU核心数调整线程设置,通常设置为核心数的1-2倍

使用GPU加速:如果有支持CUDA的GPU,启用GPU推理可以显著提升性能

6.4 常见错误解决

编译错误:

确保编译器支持C++20标准

更新CMake到最新版本

检查依赖项是否完整安装

运行时错误:

确认模型文件路径正确

检查内存是否充足

验证模型与BitNet版本的兼容性

7. 相关链接

GitHub仓库: https://github.com/microsoft/BitNet

Hugging Face模型库: https://huggingface.co/models?search=bitnet

微软AI研究: https://www.microsoft.com/en-us/research/research-area/artificial-intelligence/

llama.cpp项目: https://github.com/ggerganov/llama.cpp

8. 总结

BitNet是一个革命性的开源项目,它通过1-bit量化技术和优化的推理引擎,使得在普通硬件上运行大规模语言模型成为可能。该项目不仅大大降低了AI部署的硬件门槛,还在保持模型性能的同时显著提高了推理效率。无论是在边缘设备、低功耗环境,还是在教育研究领域,BitNet都展现出了巨大的潜力。随着项目的不断发展和完善,我们有理由相信BitNet将成为推动大语言模型普及和应用的重要力量。

版权及免责申明:本文由@人工智能研究所原创发布。该文章观点仅代表作者本人,不代表本站立场。本站不承担任何相关法律责任。

如若转载,请注明出处:https://www.aipuzi.cn/ai-news/bitnet.html