GLM-TTS:智谱 AI 推出的开源文本转语音(TTS)合成工具

一、GLM-TTS是什么

GLM-TTS是由智谱AI团队开源的一款基于大语言模型(LLM)的高质量文本转语音(TTS)合成系统,其核心设计理念是将大语言模型的语义理解能力与语音合成技术相结合,突破传统TTS系统在情感表达、韵律控制和个性化克隆方面的局限性。

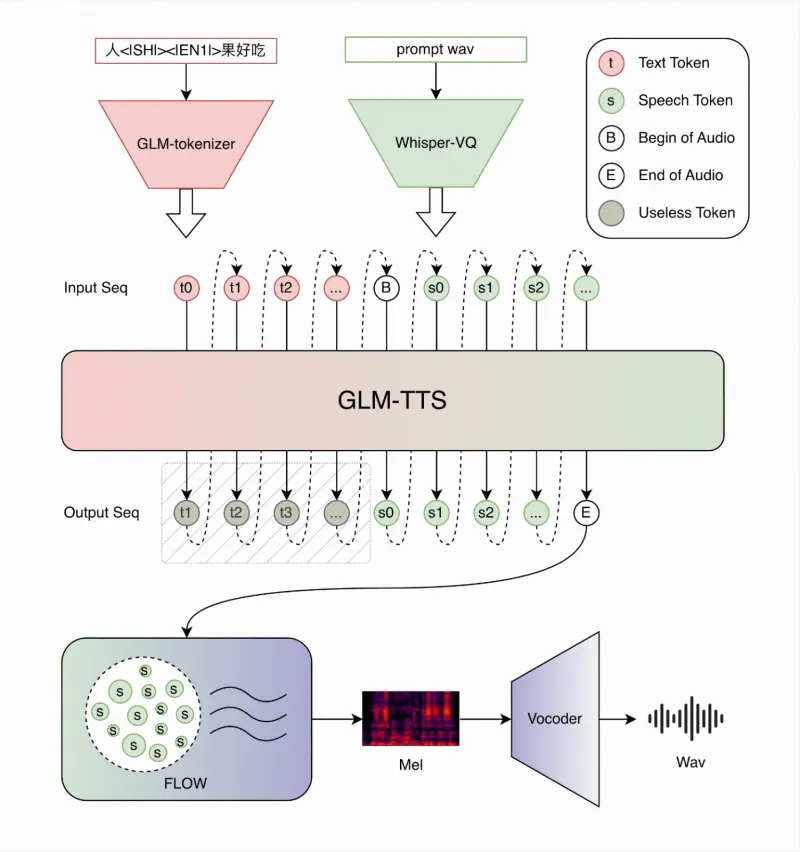

传统TTS系统通常采用“文本分析-声学模型-声码器”的三段式架构,这类架构在处理复杂语义文本、实现多样化情感表达时,往往存在韵律生硬、情感单一的问题。而GLM-TTS创新性地提出“LLM生成语音令牌+Flow模型生成音频波形” 的两阶段架构,通过大语言模型对文本语义进行深度解析,生成包含情感、韵律信息的语音令牌序列,再由Flow模型将令牌序列转换为高质量的音频波形,最终实现“语义-情感-语音”的精准映射。

作为一款开源项目,GLM-TTS基于Apache License 2.0协议发布,开发者可以自由下载、修改和商用,其代码仓库包含完整的推理脚本、模型配置、工具链和示例数据,降低了开发者的二次开发门槛。同时,该项目依托智谱AI在大语言模型和语音技术领域的积累,具备与商业级TTS系统媲美的合成质量,是开源社区中少有的兼顾“高性能”与“易用性”的TTS解决方案。

二、功能特色

GLM-TTS在功能上围绕“高质量、个性化、实时性”三大核心目标设计,相较于传统开源TTS工具,其特色功能可总结为以下7点:

1、零样本语音克隆,低成本实现个性化音色

零样本语音克隆是GLM-TTS的核心亮点功能。传统语音克隆技术通常需要收集目标说话人10分钟以上的高质量语音数据,且需要针对特定说话人进行微调训练,耗时耗力。而GLM-TTS仅需3-10秒的提示音频,即可快速克隆目标说话人的音色、语速和语调特征,无需额外的微调训练步骤。这一功能的实现,得益于模型对说话人嵌入特征的精准提取和建模,能够从短音频中捕获独特的声纹信息,满足个性化语音定制的需求。

2、强化学习增强的情感控制,语音表达更自然

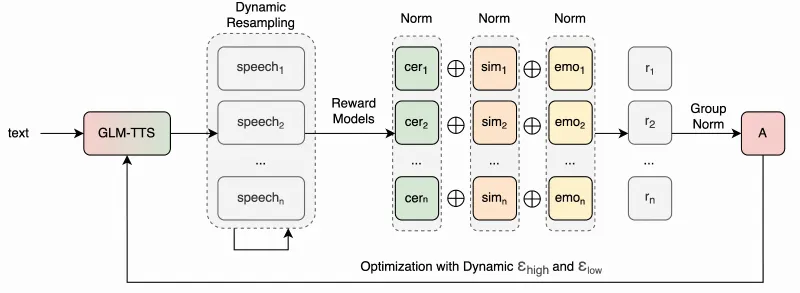

为解决传统TTS情感表达生硬的问题,GLM-TTS引入了多奖励强化学习框架(GRPO)。该框架通过设计多个奖励函数(如情感匹配度奖励、韵律自然度奖励、语音质量奖励),对模型生成的语音进行多维度评估和优化。在训练过程中,模型会根据奖励信号不断调整生成策略,最终实现“文本语义-情感表达”的精准匹配。例如,当输入文本为“今天是我的生日,我太开心了!”时,模型会自动生成欢快、高昂的语音;当输入文本为“我失去了很重要的东西”时,模型则会输出低沉、缓慢的语音,情感表现力显著优于传统TTS系统。

3、流式推理支持,满足实时交互需求

流式推理是GLM-TTS针对实时应用场景设计的核心功能。传统非流式TTS系统需要等待完整文本输入后,才能生成对应的音频,无法满足智能助手、实时语音播报等交互式场景的需求。而GLM-TTS采用流式Flow模型和增量解码策略,支持边输入文本边生成音频,端到端延迟可控制在几百毫秒内,能够为用户提供流畅的实时语音交互体验。

4、多语言合成能力,支持中英文混合文本

GLM-TTS的核心模型针对中文语音合成进行了深度优化,同时支持中英文混合文本的无缝合成。在处理包含英文单词、短语的中文文本时(如“我喜欢使用GLM-TTS生成语音”),模型无需额外的语言切换配置,即可自动识别并生成符合发音规范的混合语音,避免了传统TTS系统中英文发音生硬、语调不协调的问题。

5、音素级建模,提升语音合成精准度

音素是语音的最小单位,精准的音素建模是提升语音合成质量的关键。GLM-TTS采用音素级别的文本处理和建模策略,通过前端文本分析模块将输入文本转换为标准音素序列,再结合大语言模型对音素的韵律特征进行优化。这一设计能够有效解决生僻字、多音字的发音问题,提升语音合成的准确性和自然度。

6、灵活的推理策略,适配多样化需求

GLM-TTS支持多种推理采样策略,包括贪婪搜索、随机采样、温度调节等,开发者可以根据实际需求灵活配置。例如,在追求语音稳定性的场景(如新闻播报)中,可使用贪婪搜索策略;在追求语音多样性的场景(如有声读物)中,可通过调整温度参数实现多样化的语音生成。同时,项目提供命令行、Shell脚本、Web界面等多种推理方式,满足不同技术水平开发者的使用需求。

7、轻量化部署,降低硬件门槛

尽管GLM-TTS融合了大语言模型和Flow模型,但项目团队通过模型量化、LoRA适配器等技术,实现了模型的轻量化部署。开发者可以在普通GPU(如NVIDIA RTX 3090)上完成推理,无需依赖昂贵的算力资源,同时支持CPU推理(速度较慢,适合小规模测试),极大降低了项目的使用门槛。

三、技术细节

GLM-TTS的技术架构分为前端处理、LLM令牌生成、Flow模型波形合成、强化学习优化四个核心模块,各模块协同工作,共同实现高质量的语音合成。为了更清晰地展示模块间的关系,以下是GLM-TTS核心技术模块功能表:

| 技术模块 | 核心功能 | 关键技术 | 输出结果 |

|---|---|---|---|

| 前端处理模块 | 文本清洗、分词、音素转换、说话人嵌入提取 | 中文分词算法、音素映射表、说话人编码器 | 标准化音素序列、说话人嵌入特征 |

| LLM令牌生成模块 | 基于文本语义生成包含情感、韵律信息的语音令牌 | GLM大语言模型、上下文语义理解 | 语音令牌序列(含情感、韵律特征) |

| Flow模型波形合成模块 | 将语音令牌转换为高质量音频波形 | 流式Diffusion Transformer、声码器技术 | 原始音频波形数据 |

| 强化学习优化模块 | 对生成语音进行多维度评估与优化 | 多奖励GRPO算法、分布式奖励服务器 | 优化后的音频波形 |

3.1 前端处理模块

前端处理模块是语音合成的“预处理环节”,主要负责将原始文本转换为模型可识别的标准化数据,同时提取说话人嵌入特征。具体流程如下:

文本清洗:去除输入文本中的特殊符号、冗余空格,纠正错别字,确保文本的规范性。

分词与音素转换:采用中文分词算法将文本拆分为词语,再通过预定义的音素映射表,将每个词语转换为对应的标准音素序列。例如,将“你好”转换为“n i h a o”的音素序列。

说话人嵌入提取:针对语音克隆场景,模块会从用户提供的3-10秒提示音频中,提取独特的说话人嵌入特征。该特征是一个高维向量,能够精准表征说话人的音色、声纹等个性化信息。

3.2 LLM令牌生成模块

该模块是GLM-TTS的核心创新点,其核心作用是利用大语言模型的语义理解能力,生成包含情感、韵律信息的语音令牌。传统TTS的声学模型只能生成基础的语音特征,而GLM-TTS的LLM模块能够深度解析文本的语义和情感色彩,例如区分文本的“开心”“悲伤”“愤怒”等情感倾向,并将这些信息编码到语音令牌中。

具体来说,该模块采用GLM系列大语言模型作为基础模型,通过在大规模语音-文本配对数据上进行微调,使模型具备“文本到语音令牌”的生成能力。语音令牌是一种介于文本和音频之间的中间表示,包含音素、时长、基频、能量等关键语音特征,为后续的波形合成提供了精准的指导。

3.3 Flow模型波形合成模块

波形合成模块的作用是将LLM生成的语音令牌转换为可播放的音频波形,GLM-TTS采用流式Diffusion Transformer(流扩散变换器) 作为核心模型。相较于传统的声码器(如WaveRNN、MelGAN),Diffusion Transformer具有生成质量高、稳定性强的优势,能够更好地还原语音的细节特征。

同时,为了支持流式推理,该模块采用增量解码策略,将长文本拆分为多个文本片段,逐个片段生成语音令牌并转换为音频波形,实现“边输入边输出”的实时合成效果。

3.4 强化学习优化模块

为了进一步提升语音的自然度和情感表现力,GLM-TTS引入了多奖励强化学习框架(GRPO)。该框架的核心逻辑是:通过设计多个奖励函数,对模型生成的语音进行多维度评估,再根据评估结果调整模型参数,实现迭代优化。

具体来说,强化学习模块包含三个核心组件:

奖励函数:包含情感匹配度奖励(评估语音情感与文本情感的匹配程度)、韵律自然度奖励(评估语音的语速、停顿是否自然)、语音质量奖励(评估语音的清晰度、流畅度)。

分布式奖励服务器:负责并行计算多个奖励函数的得分,提升评估效率。

GRPO算法:基于奖励得分更新模型参数,使模型朝着“高奖励”的方向优化。

通过强化学习优化,GLM-TTS生成的语音能够更好地贴近人类自然语音的特征,情感表达更加丰富。

四、应用场景

GLM-TTS凭借其高质量、个性化、实时性的核心优势,可广泛应用于多个领域,以下是其典型应用场景的详细介绍:

4.1 智能语音助手

在智能音箱、车载语音助手、手机语音助手等场景中,GLM-TTS的流式推理能力和情感化语音生成能力能够显著提升用户体验。例如,当用户向智能助手提问时,助手可以边理解问题边生成语音回答,无需等待完整输入;同时,助手可以根据对话场景调整语音情感,如在回答“天气查询”时使用轻松的语气,在回答“导航路线”时使用清晰、干练的语气。

4.2 有声读物与内容创作

对于有声小说、教育课程、播客等内容创作领域,GLM-TTS的零样本语音克隆功能和多样化推理策略能够满足个性化需求。内容创作者可以克隆自己的声音,生成专属的有声读物;也可以通过调整模型参数,生成不同风格的语音(如沉稳的男声、温柔的女声),适配不同类型的内容。此外,GLM-TTS支持批量生成语音,能够显著提升内容创作的效率。

4.3 语音播报与通知

在新闻播报、政务通知、企业客服等场景中,GLM-TTS的高准确性和稳定性能够满足专业需求。例如,新闻客户端可以使用GLM-TTS将文字新闻转换为语音播报,为视障用户提供便利;企业可以使用GLM-TTS生成客服语音,实现24小时智能客服应答。同时,GLM-TTS支持中英文混合合成,能够满足跨境企业的多语言播报需求。

4.4 游戏与虚拟人

在游戏、虚拟主播、数字人等场景中,GLM-TTS的个性化语音克隆功能能够为虚拟角色赋予独特的声音。游戏开发者可以克隆配音演员的声音,为游戏角色生成大量对话语音;虚拟主播可以使用自己的声音,实现实时语音互动。此外,GLM-TTS的情感控制能力能够让虚拟角色的语音更加生动,提升用户的沉浸感。

4.5 无障碍辅助工具

对于视障人士、读写障碍人士等群体,GLM-TTS可以作为无障碍辅助工具,帮助他们获取文字信息。例如,将电子书、网页文本转换为语音,让视障人士能够“听”书;将复杂的文字说明转换为简洁的语音,帮助读写障碍人士理解信息。GLM-TTS的高自然度语音能够提升辅助工具的使用体验,降低信息获取的门槛。

五、使用方法

GLM-TTS的使用流程分为环境准备、模型下载、推理运行三个核心步骤,项目提供了多种推理方式,满足不同开发者的需求。以下是详细的使用指南:

5.1 环境准备

5.1.1 硬件要求

GLM-TTS对硬件的要求如下,不同推理方式的硬件需求有所差异:

GPU推理(推荐):NVIDIA GPU,显存≥10GB(如RTX 3090、RTX 4090),支持CUDA 11.0及以上版本。

CPU推理(测试用):多核CPU(如Intel i7-12700K),内存≥16GB,推理速度较慢,适合小规模测试。

5.1.2 软件环境配置

克隆代码仓库 打开终端,执行以下命令克隆GLM-TTS的代码仓库:

git clone https://github.com/zai-org/GLM-TTS.git cd GLM-TTS

创建并激活虚拟环境 推荐使用conda创建虚拟环境,避免依赖冲突:

conda create -n glm-tts python=3.10 conda activate glm-tts

安装依赖包 执行以下命令安装项目所需的依赖包:

pip install -r requirements.txt

注意:如果安装过程中出现CUDA相关的错误,请确保已正确安装CUDA和cuDNN,并配置好环境变量。

5.2 模型下载

GLM-TTS的预训练模型权重可以从HuggingFace Hub或ModelScope下载,项目仓库提供了详细的模型下载链接。以下是模型下载的注意事项:

模型分为基础模型和轻量化模型,基础模型合成质量更高,轻量化模型适合部署在算力有限的设备上。

下载完成后,将模型文件解压到项目根目录下的

models/文件夹中,确保目录结构符合配置文件的要求。

5.3 推理运行

GLM-TTS提供了三种推理方式,开发者可以根据需求选择:

5.3.1 命令行推理

命令行推理是最基础的使用方式,适用于开发者进行小规模测试。执行以下命令即可生成语音:

python glmtts_inference.py \ --text "你好,欢迎使用GLM-TTS文本转语音系统" \ --speaker_wav "examples/speaker.wav" \ --output_dir "outputs"

参数说明:

--text:需要转换的文本内容。--speaker_wav:提示音频路径(用于语音克隆,若使用默认音色可省略)。--output_dir:音频输出目录。

5.3.2 Shell脚本推理

对于批量生成语音的场景,可以使用Shell脚本推理。项目提供了glmtts_inference.sh脚本,修改脚本中的文本列表和参数配置后,执行以下命令即可批量生成语音:

bash glmtts_inference.sh

5.3.3 Gradio Web界面推理

为了方便非技术人员使用,GLM-TTS提供了基于Gradio的可视化Web界面。执行以下命令启动Web服务:

python tools/gradio_demo.py

启动成功后,在浏览器中访问http://localhost:7860,即可进入可视化界面。用户可以在界面中输入文本、上传提示音频、调整推理参数,点击“生成语音”按钮即可获取合成结果,操作简单直观。

六、常见问题解答

Q1:运行推理脚本时,出现“CUDA out of memory”错误怎么办?

A1:该错误表示GPU显存不足,解决方案如下:

降低模型的批量大小(batch size),在配置文件中设置

batch_size=1。使用轻量化模型,替换基础模型。

启用模型量化功能,在推理脚本中添加

--quantization 4参数(4位量化),降低显存占用。切换到CPU推理(仅适用于测试)。

Q2:语音克隆效果不佳,生成的语音与提示音频音色差异较大怎么办?

A2:语音克隆效果受提示音频质量影响较大,解决方案如下:

确保提示音频的时长在3-10秒之间,时长过短会导致音色特征提取不充分。

提示音频需满足:无背景噪音、无杂音、说话人发音清晰、语速适中。

避免使用经过特效处理的音频(如变声、混响)作为提示音频。

Q3:生成的语音存在断句不自然、语速过快/过慢的问题怎么办?

A3:可以通过调整推理参数优化语音韵律:

在推理脚本中添加

--speed 0.9参数调整语速(0.5-1.5之间,数值越小语速越慢)。在输入文本中添加适当的标点符号(如逗号、句号),帮助模型识别断句位置。

调整强化学习奖励函数中的韵律权重,提升韵律自然度(需要修改配置文件)。

Q4:GLM-TTS是否支持多语言合成?除了中英文之外,还支持哪些语言?

A4:目前GLM-TTS的核心模型主要针对中文和英文进行了优化,支持中英文混合合成。对于其他语言(如日语、韩语),模型的合成效果可能不佳。项目团队表示未来会考虑增加多语言支持,但目前暂无明确的时间表。

Q5:如何将GLM-TTS部署到服务器或嵌入式设备上?

A5:部署方案如下:

服务器部署:可以使用FastAPI或Flask封装推理接口,提供HTTP服务,供其他应用调用。

嵌入式设备部署:需要使用模型量化、剪枝等技术进一步压缩模型体积,同时适配嵌入式设备的硬件架构(如ARM架构)。项目提供了轻量化模型,可作为嵌入式部署的基础。

七、相关链接

模型下载(HuggingFace):https://huggingface.co/zai-org/GLM-TTS

模型下载(ModelScope):https://modelscope.cn/models/ZhipuAI/GLM-TTS

八、总结

GLM-TTS是一款基于大语言模型的高质量开源文本转语音合成系统,由智谱AI团队开发并开源,采用“LLM生成语音令牌+Flow模型生成音频波形”的创新架构,融合多奖励强化学习技术实现情感化语音生成,核心优势在于零样本语音克隆、流式推理和高自然度合成效果,同时支持中英文混合语音合成和轻量化部署,降低了开发者的使用门槛。该项目覆盖智能语音助手、有声读物、语音播报、游戏虚拟人等多个应用场景,为开发者提供了命令行、Shell脚本、Web界面等多种使用方式,基于Apache License 2.0协议可自由商用,是开源社区中兼顾性能与易用性的优秀TTS解决方案。

版权及免责申明:本文由@dotaai原创发布。该文章观点仅代表作者本人,不代表本站立场。本站不承担任何相关法律责任。

如若转载,请注明出处:https://www.aipuzi.cn/ai-news/glm-tts.html