InfinityStar:字节跳动开源的统一时空自回归视觉生成框架,高效产出 720p 图像与视频

一、什么是InfinityStar?

InfinityStar是字节跳动团队开发的开源视觉生成框架,核心基于统一时空自回归建模,实现了图像与视频生成的一体化解决方案。该框架突破传统自回归模型的局限,首次支持工业级720p高分辨率视频生成,同时覆盖文本到图像、文本到视频、图像到视频等多类生成任务。相较于扩散模型,其生成速度提升约10倍,在VBench基准测试中以83.74分的成绩表现优异,且提供完整的训练代码、推理工具、Web演示平台及预训练模型 checkpoint。

1.1 项目背景与核心目标

当前视觉生成领域存在两大主流技术路径:扩散模型(Diffusion Models)和自回归模型(Autoregressive Models)。扩散模型虽能生成高质量内容,但存在生成速度慢、推理成本高的问题;传统自回归模型虽推理速度快,但受限于建模能力,难以同时捕捉视觉数据的空间细节和时间连贯性,且难以支持高分辨率输出(如720p及以上视频)。

针对这一痛点,InfinityStar的核心目标的是:

构建统一架构:无需为图像、视频任务设计专用模块,用单一模型兼顾空间与时间依赖建模;

突破性能瓶颈:在保证生成质量的前提下,提升推理速度,支持工业级高分辨率(720p)视频生成;

降低使用门槛:开源完整的训练、推理代码及预训练模型,提供Web演示平台,适配不同用户需求;

覆盖多类任务:天然支持文本到图像、文本到视频、图像到视频等核心任务,拓展视觉生成的应用场景。

1.2 开发团队与开源定位

InfinityStar由字节跳动团队开发(该团队在计算机视觉、生成模型领域有深厚的技术积累),项目采用MIT开源协议,允许开发者自由使用、修改、二次开发及商业落地,核心定位是为科研人员、工程师、创作者提供“高效、高质量、易扩展”的视觉生成工具链。

二、功能特色

InfinityStar凭借其统一的时空自回归架构,具备以下核心功能特色,既兼顾技术先进性,又注重实际使用价值:

2.1 统一时空建模:图像与视频生成“一体化”

传统生成框架中,图像生成与视频生成往往需要独立的模型架构(如图像生成用2D网络,视频生成用3D网络),导致模型冗余、训练成本高、跨任务迁移困难。InfinityStar创新性地采用单一自回归架构,通过对视觉数据的“时空符号序列”进行建模,同时捕捉空间维度的像素/特征依赖(如图像的局部与全局关联)和时间维度的帧间连贯性(如视频中物体的运动轨迹)。

这种设计的优势在于:

模型轻量化:无需维护多套专用网络,降低训练和部署成本;

跨任务兼容性强:图像生成可看作“单帧视频”,视频生成可看作“多帧图像序列”,任务间切换无需修改核心架构;

生成连贯性优:视频生成时,帧间过渡自然,避免出现“跳帧”“画面割裂”等问题,尤其适合长时视频(如10秒以上)生成。

2.2 多任务全覆盖:一站式满足视觉生成需求

InfinityStar无需额外适配,天然支持四类核心视觉生成任务,覆盖从静态图像到动态视频的全场景需求:

| 任务类型 | 核心功能描述 | 典型应用场景 |

|---|---|---|

| 文本到图像(Text-to-Image) | 根据自然语言描述,生成高分辨率(最高支持720p)静态图像,细节丰富、语义对齐准确 | 插画创作、广告素材设计、概念图生成 |

| 文本到视频(Text-to-Video) | 根据文本描述,生成720p工业级视频(支持16帧、32帧等多种长度),运动流畅、内容贴合文本 | 短视频创作、影视预告片素材、产品宣传视频 |

| 图像到视频(Image-to-Video) | 以单张图像为输入,生成基于该图像的动态视频(如“让静态人物动起来”“让风景产生变化”) | 电商商品动态展示、虚拟人动作生成、教育演示视频 |

| 长交互视频合成(Long Interactive Video Synthesis) | 支持基于文本交互指令调整视频内容(如“让视频中的人物转向左侧”“增加背景中的花朵”),生成时长可达30秒以上 | 交互式内容创作、虚拟直播素材、游戏场景动态扩展 |

每个任务均具备“高分辨率+高语义对齐”的特点,例如文本到视频任务中,输入“一只白色的猫在草地上追逐蝴蝶,阳光明媚,背景有树木和野花”,生成的720p视频能准确还原“白色猫”“草地”“蝴蝶”等核心元素,同时猫的运动轨迹自然,阳光的光影效果符合物理逻辑。

2.3 性能碾压同类:质量与速度“双领先”

InfinityStar在生成质量、推理速度、分辨率支持上均处于行业领先水平,尤其在自回归模型中表现突出,部分指标甚至超越主流扩散模型:

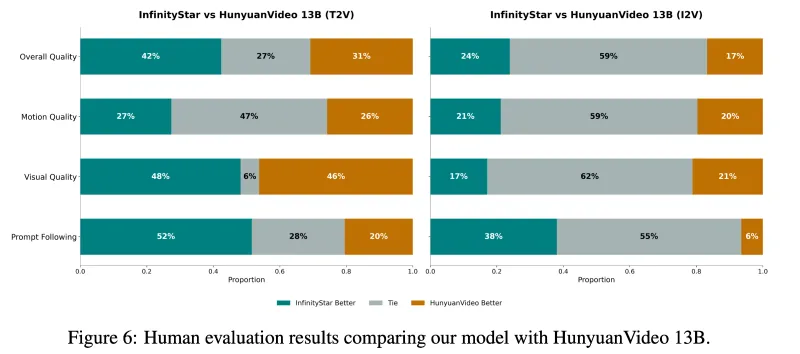

2.3.1 生成质量:基准测试成绩优异

在视频生成权威基准测试VBench(涵盖视频清晰度、运动流畅度、语义对齐度、视觉自然度等多个维度)中,InfinityStar以83.74分的成绩大幅超越其他自回归模型,同时超过HunyuanVideo等主流扩散模型(HunyuanVideo VBench得分约78-80分),具体对比如下:

| 模型类型 | 代表模型 | VBench得分 | 最高分辨率 | 生成速度(16帧720p视频) | 支持任务 |

|---|---|---|---|---|---|

| 扩散模型 | HunyuanVideo | ~79.5 | 720p | 约60秒/段 | 文本到视频、图像到视频 |

| 传统自回归模型 | VideoGPT | ~65.3 | 256x256 | 约15秒/段 | 视频生成 |

| 时空自回归模型 | InfinityStar | 83.74 | 720p | 约6秒/段 | 四类核心任务 |

注:测试环境为单张NVIDIA A100 GPU,生成速度为“从输入指令到输出完整视频”的总耗时(含预处理、推理、后处理)。

2.3.2 推理速度:比扩散模型快10倍

由于自回归模型的“逐符号生成”特性,InfinityStar避免了扩散模型“多步迭代去噪”的低效过程,推理速度大幅提升:

720p图像生成:单张图像生成耗时约0.3秒(扩散模型约3秒),速度提升10倍;

720p视频生成(16帧,帧率15fps):单段视频生成耗时约6秒(扩散模型约60秒),速度提升10倍;

长时视频生成(32帧,720p):耗时约12秒,支持实时或近实时生成场景(如直播素材、交互式创作)。

2.3.3 分辨率突破:支持工业级720p输出

InfinityStar通过优化量化策略和注意力机制,突破了传统自回归模型“高分辨率生成困难”的瓶颈,支持720p(1280×720) 视频生成,达到工业级应用标准(如短视频平台、广告投放、影视素材等场景均要求720p及以上分辨率)。同时,模型支持动态分辨率调整,可根据硬件条件灵活设置输出分辨率(如360p、480p、720p),适配不同部署场景(如手机端、云端)。

2.4 易用性强:低门槛上手,多场景适配

InfinityStar注重用户体验,从代码设计、工具链支持到部署方式,均降低了使用门槛:

开源完整工具链:提供训练代码(train.py及scripts/训练脚本)、推理代码(支持批量生成、单例生成)、Web演示平台(无需编码即可在线体验);

预训练模型直接可用:在Hugging Face提供预训练模型 checkpoint(FoundationVision/InfinityStar),下载后可直接用于推理,无需从零训练;

丰富的配置选项:通过arg_util.py提供动态分辨率、混合精度训练、梯度裁剪、分布式训练等参数配置,支持用户根据需求自定义训练流程;

跨平台兼容性:基于PyTorch框架开发,支持CPU、GPU(NVIDIA CUDA)运行,适配Linux、Windows、MacOS系统(GPU加速需CUDA支持)。

2.5 灵活性高:支持自定义扩展与二次开发

InfinityStar的架构设计具备高扩展性,方便开发者进行二次开发:

量化器可替换:支持VectorQuantize、FSQ、GumbelQuantize等多种量化方法,用户可根据任务需求选择或自定义量化模块;

注意力机制可扩展:支持连续位置偏置(ContinuousPositionBias)的灵活调整,可适配不同分辨率、不同时长的生成任务;

训练流程可定制:支持多数据集混合训练(如COCO、WebVid等)、自定义损失函数、模型微调(Fine-tuning)等,适配特定场景需求(如行业专用素材生成)。

三、技术细节

InfinityStar的核心优势源于其精心设计的技术架构,从输入处理到生成输出,每个模块都围绕“高效时空建模”展开,以下是关键技术细节的通俗解读:

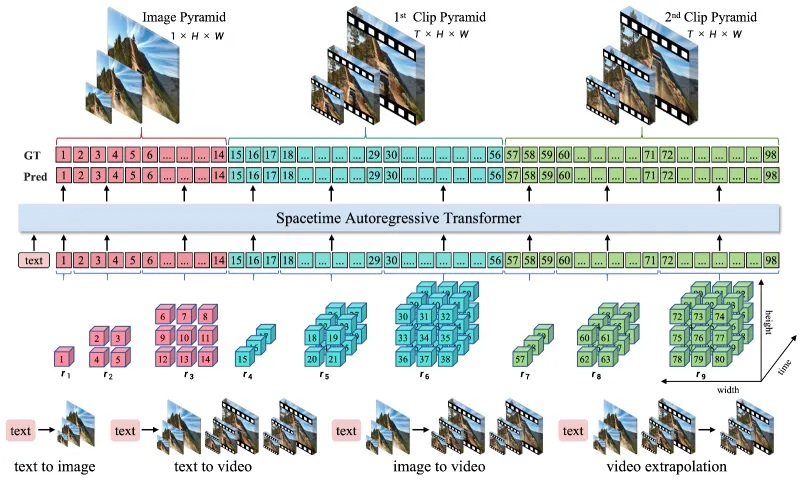

3.1 整体架构流程

InfinityStar的生成流程可概括为“输入编码→特征量化→时空自回归建模→解码生成”四步,整体架构如图(文字描述):

输入编码:将文本/图像输入转化为模型可处理的特征(文本用Transformer编码器,图像用CNN/ViT提取特征);

特征量化:将连续的视觉特征(如图像特征图、视频帧特征)离散化为“符号序列”(类似文字的拼音/字母),适配自回归建模;

时空自回归建模:通过带连续位置偏置的注意力机制,对“时空符号序列”进行逐元素预测(如根据前N个符号预测第N+1个符号),同时捕捉空间和时间依赖;

解码生成:将预测的离散符号序列解码为连续的图像/视频帧,输出最终结果。

整个流程的核心是“特征量化”和“时空自回归建模”,二者共同决定了模型的生成质量和效率。

3.2 核心模块1:特征量化器(离散化关键)

自回归模型的输入需要是“离散序列”(如文字、符号),而视觉数据(图像/视频)是连续的(如像素值0-255),因此需要通过“量化器”将连续特征转化为离散符号。InfinityStar提供了三种主流量化方法,用户可根据需求选择,具体对比如下:

| 量化方法 | 核心原理 | 优势 | 适用场景 |

|---|---|---|---|

| VectorQuantize(VQ) | 将连续特征映射到预设的“码本”(Codebook)中,每个特征向量对应一个码本索引(符号) | 训练稳定、生成质量高、计算成本低 | 图像生成、短时长视频生成 |

| FSQ(Flat Symbolic Quantization) | 采用扁平化符号量化,将特征按维度拆分并量化,支持更高的符号分辨率 | 符号表达能力强、适配高分辨率生成 | 720p视频生成、细节丰富的图像生成 |

| GumbelQuantize | 基于Gumbel-Softmax采样实现可微分量化,避免VQ的“硬分配”导致的梯度断裂问题 | 训练过程更平滑、梯度传播更稳定 | 模型微调、小数据集训练 |

量化器的核心作用是在“离散化精度”和“计算效率”之间找到平衡:量化后的符号序列越短,推理速度越快,但可能丢失细节;符号序列越长,细节越丰富,但计算成本越高。InfinityStar通过自适应码本大小(可配置codebook_size参数),让用户根据硬件条件和生成质量需求灵活调整。

3.3 核心模块2:时空自回归建模(注意力机制)

传统自回归模型(如GPT)的注意力机制仅能处理“一维序列”(如文字),而视觉数据是“二维空间+一维时间”的三维数据(视频)或“二维空间”的二维数据(图像)。InfinityStar通过连续位置偏置(ContinuousPositionBias) 解决了这一问题,让注意力机制同时适配2D(图像)和3D(视频)场景。

3.3.1 连续位置偏置的工作原理

位置偏置是注意力机制的重要组成部分,用于告诉模型“不同位置的元素之间的关联强度”。传统位置偏置(如绝对位置编码、相对位置编码)是离散的(如用固定向量表示位置),难以适配不同分辨率、不同时长的视觉数据。

InfinityStar的连续位置偏置采用“参数化函数”替代固定向量,核心思路是:

对空间位置(图像的x/y坐标、视频帧的x/y坐标)和时间位置(视频的帧索引t)进行归一化处理;

通过一个轻量级网络(MLP)学习“位置距离”与“关联强度”的映射关系(如空间上距离越近的元素关联越强,时间上相邻帧的元素关联越强);

生成连续的位置偏置矩阵,融入注意力计算中,让模型自适应不同分辨率(如360p→720p)和不同时长(如8帧→32帧)的输入。

3.3.2 时空注意力的高效计算

为了避免3D注意力(空间x×空间y×时间t)的计算量爆炸(复杂度为O(N³),N为时空符号总数),InfinityStar采用了“时空分离注意力”策略:

空间注意力:对单帧图像的符号序列计算注意力,捕捉空间依赖;

时间注意力:对多帧图像的对应位置符号计算注意力,捕捉时间依赖;

二者并行计算后融合结果,将复杂度降低为O(N²),在保证建模能力的同时,提升推理速度。

3.4 训练配置:灵活适配不同需求

InfinityStar通过arg_util.py提供了丰富的训练参数配置,支持用户根据硬件条件、数据集规模、任务需求自定义训练流程,核心可配置参数如下:

模型结构参数:码本大小(codebook_size)、注意力头数(n_heads)、网络层数(n_layers)、隐藏层维度(d_model);

训练策略参数:批量大小(batch_size)、学习率(lr)、训练轮数(epochs)、混合精度训练(mixed_precision)、梯度裁剪(gradient_clip);

数据相关参数:输入分辨率(image_size/video_size)、视频帧长度(video_frames)、数据集路径(data_path)、数据增强方式(augmentation);

部署优化参数:模型并行(model_parallel)、分布式训练(distributed)、 checkpoint保存频率(save_freq)。

例如,在GPU显存有限的情况下,用户可降低batch_size、启用mixed_precision(FP16)训练;在需要生成更高分辨率内容时,可增大codebook_size和image_size参数。

四、应用场景

InfinityStar的多任务支持、高分辨率输出、快速推理等特性,使其在多个行业和场景中具备落地价值,以下是典型应用场景详解:

4.1 内容创作领域:高效产出创意素材

4.1.1 静态图像创作

适用人群:插画师、设计师、自媒体创作者;

应用场景:快速生成海报素材、文章配图、社交媒体图片(如小红书封面、公众号头图)、创意插画;

核心优势:文本描述即可生成720p高清图像,细节丰富、风格多样(支持写实、卡通、油画等多种风格),无需专业绘画技能,提升创作效率(如原本需要2小时绘制的插画,用InfinityStar仅需0.3秒生成初稿,再微调即可使用)。

4.1.2 动态视频创作

适用人群:短视频博主、广告策划、影视从业者;

应用场景:生成产品宣传视频(如“展示一款手机的外观和功能”)、剧情类短视频(如“一只小狗在雪地里玩耍”)、影视预告片素材(如“科幻电影中的太空场景”)、直播背景视频;

核心优势:720p高清输出符合平台发布标准,生成速度快(16帧视频6秒完成),支持长时视频生成,避免帧间割裂,可快速迭代创意(如根据不同文案生成多个视频版本,选择最优方案)。

4.2 电商营销领域:提升商品展示效果

适用场景:商品动态展示(如“静态服装图片生成模特穿着走动的视频”)、虚拟试穿/试用视频(如“化妆品上脸效果动态演示”)、促销活动视频(如“节日促销文案生成动态海报视频”);

核心优势:图像到视频功能可复用现有商品图片,无需额外拍摄视频,降低营销成本;生成的视频可直接用于电商平台(淘宝、京东、抖音电商),提升商品吸引力和转化率。

4.3 教育科普领域:动态化知识传递

适用场景:生成教学演示视频(如“物理实验的动态过程”“数学公式的推导动画”)、科普短视频(如“地球公转的轨迹演示”“生物细胞的分裂过程”)、儿童教育内容(如“寓言故事的动画视频”);

核心优势:文本到视频功能可将抽象知识转化为直观的动态画面,帮助学生理解;生成速度快,教师可根据教学需求实时生成素材,丰富课堂内容。

4.4 游戏开发领域:降低场景/角色制作成本

适用场景:游戏场景生成(如“奇幻世界的森林场景”“科幻游戏的太空站内部”)、角色动画生成(如“游戏角色的跑步、攻击动作”)、道具动态展示(如“武器的特效动画”);

核心优势:支持高分辨率场景生成,细节丰富,可作为游戏场景的初稿或背景素材;角色动画生成无需手动关键帧制作,降低动画师工作量,缩短开发周期。

4.5 互动媒体领域:赋能交互式内容

适用场景:交互式视频(如“用户输入指令‘让视频中的人物举起右手’,模型实时调整视频内容”)、虚拟人直播(如“虚拟主播的动作和背景动态生成”)、元宇宙场景动态扩展(如“元宇宙中的天气变化、物体运动”);

核心优势:长交互视频合成功能支持实时指令响应,生成的内容连贯性强,适配交互式场景的实时性需求。

4.6 科研与工程领域:辅助视觉任务

适用场景:生成数据集(如“为目标检测任务生成带标注的图像/视频数据集”)、视觉效果模拟(如“模拟自然灾害的动态过程”)、机器人视觉训练(如“生成机器人操作物体的视频,用于训练视觉识别模型”);

核心优势:可批量生成多样化的视觉数据,解决真实数据集采集困难、标注成本高的问题;支持自定义场景生成,适配特定科研需求。

五、使用方法

InfinityStar提供了“在线演示→本地推理→自定义训练”三级使用路径,满足不同用户(小白用户、开发者、科研人员)的需求,以下是详细操作步骤:

5.1 前置准备

5.1.1 环境要求

操作系统:Linux(推荐)、Windows、MacOS;

硬件要求:CPU(任意,推理/训练建议用多核CPU)、GPU(NVIDIA GPU,显存≥16GB推荐,支持CUDA 11.3+,显存不足可降低分辨率/批量大小);

软件依赖:Python 3.8+、PyTorch 1.17+、transformers 4.30+、einops、wandb(训练日志可视化)、opencv-python(视频处理)、pillow(图像处理)。

5.1.2 依赖安装

克隆GitHub仓库:

git clone https://github.com/FoundationVision/InfinityStar.git cd InfinityStar

安装依赖包(推荐使用conda创建虚拟环境):

# 创建虚拟环境(可选) conda create -n infinitystar python=3.9 conda activate infinitystar # 安装依赖 pip install -r requirements.txt

5.2 快速体验:在线Web演示

无需本地部署,直接通过Web演示平台体验核心功能(适合小白用户):

访问官方Web演示地址(仓库README中提供,或通过Hugging Face Spaces搜索“FoundationVision/InfinityStar”);

选择任务类型(Text-to-Image/Text-to-Video/Image-to-Video);

输入文本描述(或上传图像),设置输出分辨率(如720p)、视频长度(如16帧);

点击“Generate”,等待几秒即可获取生成结果,支持下载。

5.3 本地推理:使用预训练模型生成内容

适合开发者快速验证功能,或批量生成内容,以“文本到视频”为例:

5.3.1 下载预训练模型

从Hugging Face下载预训练模型 checkpoint:

# 方式1:通过git克隆(需安装git-lfs) git lfs install git clone https://huggingface.co/FoundationVision/InfinityStar # 方式2:通过模型加载函数自动下载(推荐) # 推理时会自动从Hugging Face下载模型,无需手动克隆

5.3.2 文本到视频推理(单条生成)

运行推理脚本,输入文本描述生成视频:

python inference.py \ --task text2video \ --prompt "一只棕色的小狗在草地上奔跑,背景有蓝天白云,阳光洒在草地上" \ --model_path FoundationVision/InfinityStar \ --output_path ./output/video1.mp4 \ --resolution 720p \ --num_frames 16 \ --fps 15

参数说明:

--task:任务类型(text2img/text2video/img2video);

--prompt:文本描述(img2video任务无需该参数,需指定--image_path);

--model_path:模型路径(本地路径或Hugging Face模型名);

--output_path:输出文件路径;

--resolution:输出分辨率(360p/480p/720p);

--num_frames:视频帧数(仅text2video/img2video任务);

--fps:视频帧率(默认15)。

5.3.3 批量推理(多条生成)

创建文本文件(如prompts.txt),每行写一个文本描述,运行批量推理脚本:

# prompts.txt内容示例 一只猫在窗边晒太阳 海浪拍打沙滩,海鸥飞过 小女孩在花园里浇花 # 运行批量推理 python inference_batch.py \ --task text2video \ --prompt_file ./prompts.txt \ --model_path FoundationVision/InfinityStar \ --output_dir ./output/batch_videos \ --resolution 720p \ --num_frames 16

5.4 自定义训练:训练专属模型

适合科研人员或需要适配特定场景(如行业数据集)的开发者,以“文本到图像”任务微调为例:

5.4.1 准备数据集

数据集需满足以下格式:

dataset/ ├── image1.jpg ├── image1.txt # 对应image1的文本描述 ├── image2.jpg ├── image2.txt └── ...

5.4.2 修改训练配置

编辑configs/train_text2img.yaml文件,配置关键参数:

model: codebook_size: 8192 n_heads: 16 n_layers: 24 d_model: 1024 training: batch_size: 8 lr: 2e-5 epochs: 100 mixed_precision: True gradient_clip: 1.0 data: data_path: ./dataset image_size: 720 augmentation: True # 启用数据增强 logging: wandb_project: infinitystar_text2img save_freq: 10 # 每10个epoch保存一次checkpoint

5.4.3 启动训练

# 单GPU训练 python train.py --config configs/train_text2img.yaml # 多GPU分布式训练(4张GPU为例) torchrun --nproc_per_node=4 train.py --config configs/train_text2img.yaml --distributed True

5.4.4 训练后推理

使用自定义训练的checkpoint进行推理:

python inference.py \ --task text2img \ --prompt "自定义场景描述" \ --model_path ./checkpoints/epoch_100 \ --output_path ./output/custom_image.jpg \ --resolution 720p

5.5 Web演示本地部署

如需在本地部署Web演示平台(基于Gradio):

# 安装Gradio依赖 pip install gradio # 启动Web服务 python web_demo.py --model_path FoundationVision/InfinityStar

启动后,访问终端输出的本地地址(如http://127.0.0.1:7860),即可在浏览器中体验可视化操作界面。

六、常见问题解答(FAQ)

Q1:安装依赖时出现“torch版本不兼容”报错怎么办?

A1:InfinityStar要求PyTorch 1.17+,建议根据GPU型号安装对应CUDA版本的PyTorch,参考官网安装命令(https://pytorch.org/get-started/locally/),例如CUDA 12.1的安装命令:

pip3 install torch torchvision torchaudio --index-url https://download.pytorch.org/whl/cu121

Q2:GPU显存不足,无法运行推理/训练怎么办?

A2:可通过以下方式降低显存占用:

推理时:降低分辨率(如720p→480p)、减少视频帧数(如16帧→8帧);

训练时:降低batch_size(如8→4)、启用mixed_precision(FP16)、减小model的d_model/n_heads参数;

若只有CPU,可添加--device cpu参数(推理速度会变慢,不推荐训练)。

Q3:生成的内容与文本描述不符(语义对齐差)怎么办?

A3:可能的原因及解决方案:

文本描述不具体:补充细节(如“红色的苹果”→“一个红色的、带叶子的苹果,放在白色盘子上”);

模型未充分学习对应场景:使用自定义数据集微调模型,或更换更适配的预训练checkpoint;

调整生成参数:增大--num_samples(生成多个样本选择最优)、调整--temperature(温度参数,越低越贴合文本,越高越有创意)。

Q4:视频生成出现“跳帧”“画面模糊”怎么办?

A4:解决方案:

跳帧问题:增加视频帧数(如8帧→16帧)、降低生成速度(调整--temperature参数);

画面模糊:提高分辨率(480p→720p)、选择FSQ量化方法(修改--quantizer fsq)、增大码本大小(--codebook_size 8192)。

Q5:训练时loss不下降,或生成内容质量差怎么办?

A5:可能的原因及解决方案:

数据集规模过小:增加数据集样本数量(建议≥10k张图像/视频),或使用混合数据集训练;

学习率不合适:降低学习率(如2e-5→1e-5),或使用学习率调度器(在配置文件中启用--lr_scheduler);

模型参数过大/过小:调整d_model、n_layers等参数(参数过小则拟合能力不足,过大则过拟合);

数据预处理问题:检查数据集格式是否正确,启用数据增强(augmentation: True)提升泛化能力。

Q6:训练过程中断,如何恢复训练?

A6:训练时会自动保存checkpoint(默认保存在./checkpoints目录),恢复训练时指定--resume参数:

python train.py --config configs/train_text2img.yaml --resume ./checkpoints/epoch_50

Q7:是否支持中文文本描述?

A7:支持。预训练模型已适配中英文文本,直接输入中文描述即可(如“一只熊猫在吃竹子”),语义对齐效果良好。

Q8:MIT协议下,可用于商业项目吗?

A8:可以。MIT协议允许商业使用、修改、分发,无需向开发团队授权,但需保留原项目的版权声明(详见LICENSE文件)。

七、相关链接

Hugging Face模型库:https://huggingface.co/FoundationVision/InfinityStar

八、总结

InfinityStar作为字节跳动开源的统一时空自回归视觉生成框架,通过创新的单一架构实现了图像与视频生成的一体化,既突破了传统自回归模型在高分辨率和时空连贯性上的局限,又解决了扩散模型推理速度慢的痛点,其83.74分的VBench成绩、10倍于扩散模型的生成速度、720p工业级分辨率支持及多任务覆盖能力,使其在技术上处于行业领先水平。同时,项目提供了完整的开源工具链(训练/推理代码、预训练模型、Web演示),采用MIT协议,兼顾了易用性和扩展性,既适合科研人员进行技术探索,也能满足工程师、创作者的实际应用需求,在内容创作、电商营销、教育科普等多个领域具备广泛的落地价值,为视觉生成技术的普及和应用提供了高效、可靠的开源解决方案。

版权及免责申明:本文由@人工智能研究所原创发布。该文章观点仅代表作者本人,不代表本站立场。本站不承担任何相关法律责任。

如若转载,请注明出处:https://www.aipuzi.cn/ai-news/infinitystar.html