IQuest-Coder-V1:九坤投资开源的高性能代码生成与软件工程AI大模型

一、IQuest-Coder-V1是什么

IQuest-Coder-V1是一套专注于代码生成、代码理解与软件工程全流程任务的开源大语言模型(LLMs)系列,由国内量化私募头部机构九坤投资旗下至知创新研究院独立开发并开源。作为聚焦垂直领域的AI编程工具,该模型系列打破传统代码模型依赖静态代码片段训练的局限,通过创新的训练范式与架构设计,实现了“理解代码演化逻辑、精通工程实践操作、适配多场景部署需求”的核心定位。

从模型家族构成来看,IQuest-Coder-V1提供7B、14B、40B三种参数规模选择,每个规模均包含Instruct和Thinking两个基础版本,40B参数规模额外提供Loop架构变体,形成了覆盖轻量部署、高效应用与复杂推理的完整产品矩阵。Instruct版本侧重指令跟随与工程实用性,响应速度快,适合日常开发场景;Thinking版本强化复杂问题拆解与多步推理能力,虽响应时间较长,但能处理高难度编程任务;Loop版本则通过参数共享的循环Transformer设计,在仅增加5%训练成本的前提下,实现了参数利用率的大幅提升,达到数百亿参数MoE模型的性能水平。

该模型的核心使命是赋能软件工程全流程,不仅能“从零到一”生成完整可运行的代码项目,更擅长“在既有代码上精准动刀”,理解代码修改的前因后果与逻辑关联,真正贴合真实开发中的迭代式工作模式。其开源特性意味着开发者可自由获取、本地部署,企业团队也能根据自身需求进行二次优化,无需担忧数据安全与第三方依赖问题。凭借在多个权威代码基准测试中的顶尖表现,以及对消费级硬件的良好适配,IQuest-Coder-V1迅速成为全球科技界关注的焦点,被视为国产开源代码模型在垂直领域突破的重要代表。

二、功能特色

IQuest-Coder-V1在功能设计上围绕“工程实用性、性能顶尖化、部署轻量化”三大核心目标,形成了区别于传统代码模型的显著特色,具体如下:

1. 顶尖的代码任务性能表现

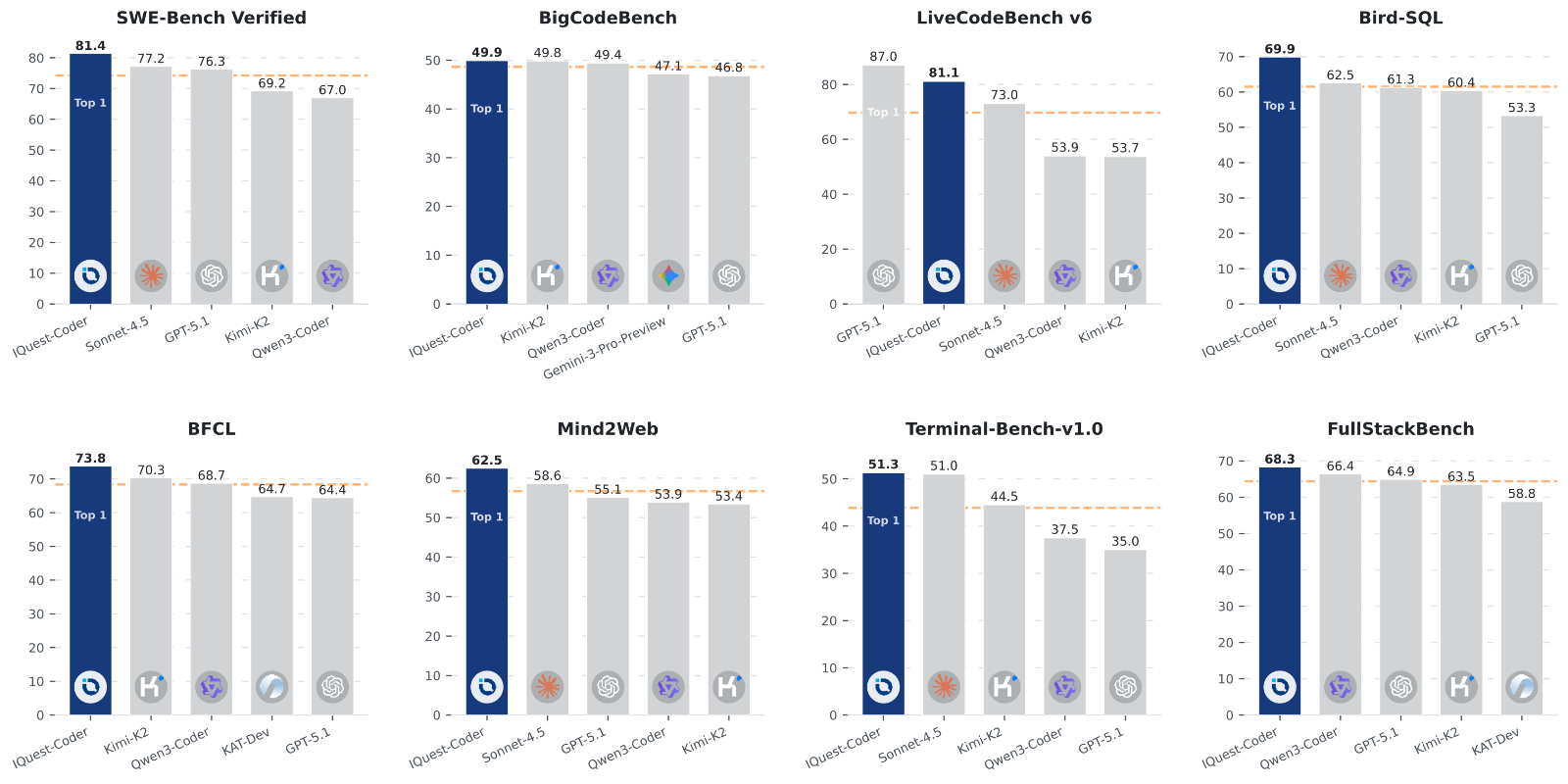

模型在多个国际权威代码基准测试中展现出全面领先的实力,尤其在衡量真实软件工程能力的核心榜单中成绩突出:SWE-Bench Verified(代码错误修复与功能实现任务)得分81.4%,超越外界推测参数规模达千亿至万亿级的Claude Opus-4.5和GPT-5.2;LiveCodeBench v6(综合编程能力测试)取得81.1%的高分;BigCodeBench(代码生成质量评估)达到49.9%。更值得关注的是,该模型在八个代码及Agentic相关榜单中均位居榜首,展现出在代码生成、逻辑推理、工具使用等多维度的均衡优势。

在实际应用场景中,模型能够生成高质量、可直接运行的复杂项目代码。例如,基于用户指令可一键生成支持多视角切换、行星信息展示的太阳系模拟网页,包含物理碰撞、计分系统的复古太空射击游戏,具备粒子交互效果的文本动画,以及支持实时调节参数的鸟群算法仿生模拟等。这些生成的代码不仅功能完整,在交互设计、视觉效果和性能优化上也达到专业开发者水准,可直接作为项目原型或基础框架使用。

2. 创新的代码流训练范式

不同于传统代码模型仅学习静态代码片段的训练方式,IQuest-Coder-V1采用独特的“代码流(Code-Flow)”多阶段训练策略,核心在于让模型学习代码的“动态演化过程”而非单纯的“静态结果”。研发团队通过构建(R_old, Patch, R_new)三元组训练数据,完整捕捉代码从稳定状态(R_old)到变更过程(Patch,即提交补丁)再到新状态(R_new)的全链路演化轨迹。

在数据选取上,团队特意避开项目早期不稳定的探索性代码和后期碎片化的维护性修改,专门聚焦于项目生命周期40%到80%区间的“成熟期”代码。这一阶段的代码库相对稳定,变更模式更能反映真实的软件开发逻辑,使模型能够学习到“为什么改、改了哪里、改完后如何适配整体结构”的深层逻辑,而非仅仅模仿代码语法。这种训练方式让模型在代码修改、错误修复、功能迭代等实际工程任务中表现尤为突出,真正理解“代码的来龙去脉”。

3. 双重专业化路径设计

模型在训练后期采用两条明确的专业化路径,分别适配不同使用场景的需求:

Instruct路径:以指令跟随为核心目标,通过通用代码指令数据进行监督微调与强化学习优化,注重响应速度与工程实用性,能够精准理解并执行用户的明确编程需求,适合日常开发中的代码生成、接口编写、单元测试生成等场景。

Thinking路径:强化复杂推理与问题拆解能力,通过包含显式推理轨迹的数据进行训练,具备自主错误恢复(error-recovery)能力。在处理多步骤编程任务、复杂架构设计、逻辑漏洞排查等场景时,能够像资深开发者一样逐步分析、迭代优化,即使出现中间错误也能自主修正,大幅降低用户的干预成本。

这种双重路径设计让模型既能满足普通开发者“高效完成基础工作”的需求,也能支撑高级开发者“攻克复杂技术难题”的诉求,实现了通用性与专业性的平衡。

4. 工程友好的架构特性

模型在架构设计上充分考虑真实开发环境的使用需求,展现出极强的工程适配性:

原生128K长上下文:无需依赖额外扩展技术,原生支持128K tokens的上下文长度,能够直接“读懂”完整的代码仓库、跨文件依赖关系以及大规模工程文档,彻底解决传统模型处理长代码时的信息断裂问题。

76800大词表设计:词表规模达到76800个tokens,专门优化了代码场景中频繁出现的路径名、标识符、专业符号等,更贴近真实编程环境的语言习惯,减少语义理解偏差。

GQA高效推理机制:采用分组查询注意力(Grouped Query Attention,GQA)技术,通过减少KV头数量降低推理阶段的显存占用与计算压力,在长上下文场景中表现出更优的运行效率。

Loop架构创新:40B参数的Loop变体采用共享参数的循环Transformer设计,通过两次固定迭代的计算模式,用重复计算换取更高的参数利用率,在不线性增大模型规模的前提下,显著降低HBM与KV Cache开销,提升吞吐量。

5. 低门槛的部署体验

IQuest-Coder-V1在性能优化的同时,大幅降低了部署门槛,让更多开发者能够便捷使用:

硬件要求友好:Int4量化版本可在消费级3090/4090 GPU(24GB显存)上流畅运行,基础版本与Loop版本均支持单卡H20推理,无需专业数据中心级算力支持。

环境适配广泛:兼容Windows与Linux操作系统,支持Python+CUDA运行环境,官方提供完整的推理脚本与配置指南,降低环境搭建难度。

生态工具兼容:支持Hugging Face Transformers库加载使用,提供VS Code扩展与终端交互式开发工具,兼容MCP协议工具生态,可无缝融入现有开发流程。

三、技术细节

IQuest-Coder-V1的卓越表现源于其在训练范式、模型架构、数据处理等多个技术层面的深度创新,以下从核心技术维度进行详细解析:

1. 代码流(Code-Flow)多阶段训练范式

模型的训练流程分为三个核心阶段,每个阶段各有侧重且层层递进,形成完整的能力培养链路:

(1)预训练阶段:基础能力夯实

首先使用通用文本数据与大规模开源代码数据进行打底训练,构建基础语言理解与代码语法能力。

随后通过高质量代码“退火(Annealing)”过程强化代码表征能力,筛选优质代码语料优化模型对代码结构、逻辑关联的基础认知,为后续复杂任务奠定基础。

(2)中期训练阶段:核心能力构建

第一阶段在32K上下文长度下,注入推理数据、Agent轨迹数据与代码数据的混合语料。其中推理数据提供符号层面的逻辑脚手架,Agent轨迹数据包含完整的“行动-观察-修正”循环(命令执行、日志输出、错误反馈、测试结果等),帮助模型学会根据环境反馈调整行为。

第二阶段将上下文长度扩展至128K,加入仓库级的长序列样本,让模型适应大规模代码场景的处理需求,掌握跨文件、长依赖的代码理解能力。

(3)后训练阶段:专业化能力分化

采用双路径训练策略,将模型分化为Instruct与Thinking两个版本:

Instruct路径:使用通用代码指令数据进行监督微调(SFT),再通过强化学习(RL)优化指令跟随精度与响应效率,确保能够精准理解并执行用户的明确需求。

Thinking路径:先通过包含显式推理轨迹的数据进行监督微调,再利用强化学习提升复杂推理与错误恢复能力,训练数据包含32K高质量轨迹数据,通过多智能体角色扮演(multi-agent role-playing)自动生成,模拟用户、Agent、Server三方交互场景,无需人工标注。

2. 三元组(R_old, Patch, R_new)数据构造

这是代码流训练范式的核心数据基础,其设计理念源于对真实软件开发过程的深刻洞察:

R_old:代表项目在某个稳定开发阶段的代码状态,即变更前的完整代码仓库或核心模块。

Patch:捕捉两个代码状态差异的提交补丁(commit变更),包含具体的代码修改内容、修改说明与逻辑意图。

R_new:代码迭代后的新状态,即应用Patch后的最终代码形态。

研发团队在数据选取上设定了严格标准:仅选取项目生命周期40%—80%区间的“成熟期”代码进行三元组构造。这一阶段的代码库结构稳定、变更逻辑清晰,能够最大程度传递“为什么改、改了哪里、如何适配”的有效训练信号,让模型不仅学习“代码是什么”,更理解“代码如何演化”,这也是模型在代码修改、错误修复等任务中表现突出的关键原因。

3. 模型架构核心参数与设计

IQuest-Coder-V1系列模型在架构设计上兼顾性能与效率,不同参数版本的核心架构参数保持一致性,仅在规模上有所区分,具体如下表所示:

| 架构特性 | 参数配置详情 |

|---|---|

| 基础架构 | Transformer变体(非Loop版本兼容Qwen2架构) |

| 参数规模 | 7B、14B、40B三种可选 |

| 上下文长度 | 原生支持128K tokens |

| 词表规模 | 76800个tokens |

| 注意力机制 | 分组查询注意力(GQA) |

| Loop变体架构 | 共享参数的循环Transformer,两次固定迭代(全局注意力+局部注意力混合) |

| 量化支持 | 支持Int4量化,兼容FP16/FP8精度推理 |

| 推理优化 | 减少KV头数量降低显存占用,优化KV Cache管理提升长上下文处理效率 |

其中,Loop变体的架构设计尤为亮眼,其核心逻辑是让参数共享的Transformer块执行两次固定迭代:

第一次迭代:正常处理输入嵌入,构建基础语义表征。

第二次迭代:同时计算两种注意力——全局注意力(第二迭代的查询关注第一迭代的所有键值对)与局部注意力(维持因果性的常规自注意力),两种输出通过基于查询表示的学习门控机制加权混合。

这种设计在不显著增加参数规模的前提下,通过增加计算步骤提升了模型的有效计算深度,实现了部署效率与模型能力的平衡,仅增加5%训练成本就达到了数百亿参数MoE模型的性能水平。

4. 性能优化关键技术

显存优化:通过GQA机制减少KV头数量,优化KV Cache存储策略,在处理128K长上下文时仍能控制显存占用,使消费级GPU具备运行能力。

推理加速:Loop架构通过参数共享提升吞吐量,减少重复计算带来的冗余开销,同时优化算子实现,确保推理速度满足实时开发需求。

精度保障:在量化过程中采用先进的量化算法,确保Int4量化版本在降低硬件门槛的同时,性能损失控制在可接受范围,保证代码生成质量。

四、应用场景

IQuest-Coder-V1凭借其全面的能力覆盖与灵活的部署特性,已在多个编程场景中展现出实用价值,无论是个人开发者的日常编码,还是企业团队的工程实践,都能发挥高效辅助作用,具体应用场景如下:

1. 代码生成场景

全栈项目开发:支持前端(HTML/CSS/JavaScript、Vue、React)、后端(Python、Java、Go)、移动端等多技术栈的代码生成,可根据用户需求从零构建完整项目,如网页应用、小游戏、API服务等。例如,仅需输入“用HTML5 Canvas写复古射击游戏,包含暂停键、计分系统、碰撞反馈”,即可生成单文件完整代码。

功能模块实现:针对特定功能需求生成独立模块代码,如用户登录认证、数据可视化图表、文件上传下载、支付接口对接等,减少重复开发工作。

示例代码生成:为学习新框架、新API提供示例代码,帮助开发者快速理解使用方法,降低技术学习门槛。

2. 代码优化与重构场景

代码重构:对 legacy 代码进行重构,优化代码结构、提升可读性与执行效率,同时保持功能不变,尤其擅长处理大型项目的模块化重构。

性能优化:识别代码中的性能瓶颈,如循环冗余、资源泄漏、低效算法等,提供优化方案并生成优化后的代码,提升程序运行速度与资源利用率。

兼容性适配:将代码适配不同浏览器、不同系统或不同版本的依赖库,自动处理兼容性问题,减少适配工作量。

3. 错误修复与调试场景

Bug定位与修复:根据错误日志、异常信息或用户描述,快速定位代码中的漏洞,生成修复补丁,尤其擅长处理逻辑错误、语法错误、边界条件错误等常见问题。

自主调试优化:Thinking版本具备自主错误恢复能力,在生成代码出现错误时,能够自动分析原因并迭代修正,无需用户手动干预,大幅提升调试效率。

测试用例生成:为目标代码生成单元测试、集成测试用例,覆盖核心逻辑与边界场景,帮助开发者完善测试体系,提升代码稳定性。

4. 文档与工程管理场景

代码注释生成:自动为现有代码添加清晰、规范的注释,包括函数说明、参数解释、返回值说明等,提升代码可维护性。

技术文档编写:根据代码逻辑生成API文档、接口说明、部署指南等技术文档,保持文档与代码的一致性,减少文档维护成本。

需求转化为代码:将自然语言描述的产品需求、功能规格转化为结构化的代码实现方案,搭建需求与开发之间的桥梁,提升沟通效率。

5. 教育与学习场景

编程教学辅助:为编程学习者提供个性化指导,根据学习进度生成练习题、讲解代码逻辑、解答疑问,帮助学习者快速掌握编程技能。

案例解析与拓展:对经典编程案例进行详细解析,提供多种实现方案,并拓展相关知识点,培养学习者的逻辑思维与解决问题的能力。

技术栈快速入门:针对特定技术栈(如AI框架、云计算服务)生成入门项目与教程,帮助开发者快速上手新领域技术。

6. 企业与团队协作场景

项目快速原型:在产品迭代初期快速生成项目原型,验证需求可行性与产品体验,缩短原型开发周期,加速产品迭代。

团队开发协作:统一代码风格与实现标准,自动生成通用工具类与公共组件,减少团队协作中的沟通成本与重复工作。

低成本技术验证:对于初创企业或小团队,无需投入大量人力即可完成技术方案验证与基础开发工作,降低技术落地门槛。

五、使用方法

IQuest-Coder-V1提供多种使用方式,从快速在线体验到本地部署均可灵活选择,以下为详细的使用指南,涵盖环境准备、模型加载、提示词技巧等核心内容:

1. 前期准备

(1)硬件要求

根据使用的模型版本与量化精度,硬件要求有所不同,具体推荐配置如下表所示:

| 模型版本 | 量化精度 | 推荐GPU配置 | 显存要求 | 存储要求 |

|---|---|---|---|---|

| 7B/14B Instruct/Thinking | FP16 | 消费级RTX 3090/4090 | ≥16GB | ≥20GB(含依赖) |

| 7B/14B Instruct/Thinking | Int4 | 消费级RTX 3090/4090 | ≥8GB | ≥10GB(含依赖) |

| 40B Instruct/Thinking | FP16 | 专业卡H20/RTX A6000 | ≥48GB | ≥80GB(含依赖) |

| 40B Instruct/Thinking | Int4 | 消费级RTX 4090/专业卡A100 | ≥24GB | ≥40GB(含依赖) |

| 40B Loop | FP16 | 专业卡H20 | ≥40GB | ≥70GB(含依赖) |

| 40B Loop | Int4 | 消费级RTX 4090/专业卡A100 | ≥20GB | ≥35GB(含依赖) |

(2)软件环境

操作系统:Windows 10/11 64位或Linux(Ubuntu 20.04+/CentOS 7+)

运行环境:Python 3.8+

核心依赖:transformers≥4.52.4、torch≥2.1.0、CUDA 11.8+(GPU加速必需)

其他依赖:accelerate、bitsandbytes(量化支持)、sentencepiece(分词器)

(3)依赖安装

打开终端或命令提示符,执行以下命令安装核心依赖:

# 基础依赖安装 pip install torch>=2.1.0 transformers>=4.52.4 accelerate sentencepiece # 量化支持依赖(Int4版本必需) pip install bitsandbytes>=0.41.1

2. 模型获取与加载

IQuest-Coder-V1的所有版本均已开源发布在Hugging Face Hub与GitHub,可通过以下方式获取并加载:

(1)通过Hugging Face Transformers加载

这是最常用的使用方式,支持灵活配置模型参数与推理选项,示例代码如下:

# 导入必要库 from transformers import AutoTokenizer, AutoModelForCausalLM, BitsAndBytesConfig # 模型名称(可替换为对应版本) model_name = "IQuestLab/IQuest-Coder-V1-40B-Instruct" # 量化配置(Int4版本使用,FP16版本可省略) bnb_config = BitsAndBytesConfig( load_in_4bit=True, bnb_4bit_use_double_quant=True, bnb_4bit_quant_type="nf4", bnb_4bit_compute_dtype=torch.float16 ) # 加载分词器与模型 tokenizer = AutoTokenizer.from_pretrained(model_name, trust_remote_code=True) model = AutoModelForCausalLM.from_pretrained( model_name, trust_remote_code=True, quantization_config=bnb_config, # Int4版本启用 device_map="auto", # 自动分配设备 torch_dtype=torch.float16 ) # 生成代码示例:创建一个简单的Python计算器 prompt = """请用Python编写一个命令行计算器,支持加减乘除四则运算,要求: 1. 支持用户输入两个数字和运算符 2. 包含输入验证(处理非数字输入、除数为零等异常) 3. 输出结果格式清晰 4. 提供循环交互,支持多次计算 """ # 格式化输入(遵循模型提示词格式) inputs = tokenizer(prompt, return_tensors="pt").to(model.device) # 生成配置 outputs = model.generate( **inputs, max_new_tokens=1024, # 最大生成长度 temperature=0.7, # 随机性控制,越低越精准 top_p=0.95, do_sample=True, eos_token_id=tokenizer.eos_token_id ) # 输出结果 print(tokenizer.decode(outputs[0], skip_special_tokens=True))

(2)在线体验

对于无需本地部署的用户,可通过以下方式快速体验:

Hugging Face Spaces:访问IQuestLab官方空间,直接在线输入指令生成代码。

Colab笔记本:使用官方提供的Colab示例,无需配置本地环境,直接在云端运行。

VS Code扩展:安装官方提供的VS Code插件,在编辑器内直接调用模型生成代码。

3. 提示词(Prompt)使用技巧

为了获得更精准、高质量的代码输出,使用时需注意提示词的编写技巧:

(1)明确目标与约束

具体描述功能需求:避免模糊表述,例如不说“写一个网页游戏”,而说“用HTML5 Canvas写复古太空射击游戏,WASD移动,鼠标瞄准,包含计分和Boss战”。

明确技术栈与环境:指定编程语言、框架版本、运行环境等,例如“用Python 3.10+和FastAPI写一个用户管理API,支持MySQL数据库”。

设定性能与格式要求:例如“代码运行帧率≥50fps”“输出单文件HTML”“遵循PEP8编码规范”。

(2)分步拆解复杂任务

对于大型项目或复杂功能,建议分步骤下达指令:

第一步:让模型生成项目架构与模块划分,例如“列出太阳系模拟网页的核心模块,包括页面结构、物理引擎、交互控制等”。

第二步:逐模块生成代码,例如“先实现太阳系行星的轨道计算与绘制模块”。

第三步:让模型进行自检与整合,例如“检查各模块代码的兼容性,整合为完整项目并修复潜在错误”。

(3)利用模型特性优化交互

调用Thinking版本处理复杂任务:在提示词中明确要求模型展示推理过程,例如“请分析这个排序算法的时间复杂度,并逐步优化为O(n log n),说明每一步优化思路”。

要求错误修复与迭代:当生成代码存在问题时,直接反馈错误信息,例如“运行代码后出现索引越界错误,错误位置在第23行,请修复并重新生成完整代码”。

4. 安全使用规范

沙盒验证:模型生成的代码需在沙盒环境中验证运行,避免直接在生产环境执行,防止潜在安全风险。

代码审计:上线前必须进行人工代码审计,检查逻辑漏洞、安全隐患与依赖安全性,尤其注意权限控制、数据加密等关键部分。

数据安全:禁止向模型输入敏感信息,如公司源码、密钥、客户数据等,本地部署时需做好数据隔离与访问控制。

合规检查:遵守开源协议相关规定,商用前需确认License条款,确保符合法律与合规要求。

六、常见问题解答(FAQ)

1. IQuest-Coder-V1与其他开源代码模型(如CodeLlama、DeepSeek-Coder)相比有何优势?

答:核心优势体现在三个方面:一是训练范式创新,通过代码流训练捕捉动态演化逻辑,在代码修改、错误修复等工程实践场景表现更优;二是性能领先,在SWE-Bench Verified等权威榜单中取得81.4%的顶尖成绩,超越多数同类模型;三是部署友好,Int4量化版本可在消费级3090/4090 GPU运行,Loop变体兼顾性能与效率。此外,模型原生支持128K长上下文与76800大词表,更适配真实大规模代码场景。

2. 模型生成的代码可以直接用于生产环境吗?

答:不建议直接用于生产环境。尽管模型生成的代码质量较高,但仍可能存在逻辑漏洞、安全隐患或性能问题。正确的使用方式是将生成代码作为基础原型,经过人工评审、代码审计、充分测试(包括单元测试、集成测试、安全测试)后,再根据生产环境要求进行优化调整,确保代码的稳定性与安全性。

3. 非技术背景的用户可以使用IQuest-Coder-V1吗?

答:可以,但需掌握基础的使用逻辑。对于非技术用户,建议使用Instruct版本并采用“具体化需求+明确约束”的提示词方式,例如“用HTML写一个个人简历页面,蓝色主题,包含个人信息、教育经历、工作经验三个板块,支持响应式布局”。同时可借助在线体验平台或VS Code扩展等可视化工具,降低操作门槛。若需实现复杂功能,建议分步骤下达指令,并邀请技术人员进行最终审核。

4. 模型支持哪些编程语言与技术栈?

答:支持主流编程语言与技术栈,包括但不限于:前端(HTML/CSS/JavaScript、Vue、React、Angular)、后端(Python、Java、Go、C++、PHP、Node.js)、移动端(Flutter、React Native)、数据科学(TensorFlow、PyTorch、Scikit-learn)、DevOps(Shell、Docker、Kubernetes)等。模型在Web开发、后端服务、数据分析等场景的支持尤为成熟,能够生成完整可运行的项目代码。

5. 本地部署时遇到显存不足怎么办?

答:可通过以下方式解决:一是选择更低量化精度的版本,例如将FP16版本替换为Int4量化版本,可大幅降低显存占用;二是减少生成长度,在模型.generate()中降低max_new_tokens参数;三是关闭不必要的功能,如禁用梯度计算、使用device_map="auto"自动分配设备;四是升级GPU硬件,对于40B全精度版本,建议使用显存≥48GB的专业显卡。此外,也可使用模型的Loop变体,其在相同参数规模下显存占用更低。

6. 模型的开源协议是什么?商用需要注意什么?

答:IQuest-Coder-V1采用开源协议发布(具体以GitHub仓库LICENSE文件为准),个人开发者可免费使用、修改与分发。商用用户需仔细阅读开源协议条款,确认是否需要获得官方授权;若用于闭源商业产品,需遵守协议中关于代码使用、版权声明、衍生作品分发等相关规定,避免侵权。同时,商用前建议进行合规评估,确保符合数据安全、隐私保护等相关法律法规。

7. 如何反馈模型存在的问题或提出功能建议?

答:用户可通过以下渠道反馈:一是GitHub仓库的Issues板块,提交问题描述、复现步骤、期望结果等详细信息;二是官方社区或Discord群组,与研发团队及其他用户交流;三是通过九坤投资至知创新研究院的官方联系方式提交反馈。反馈时建议附上完整的提示词、生成结果、运行环境等信息,以便研发团队快速定位问题并优化。

8. 模型的推理速度如何?能否满足实时开发需求?

答:推理速度与模型版本、硬件配置、量化精度相关。在消费级RTX 4090 GPU上,Int4量化的7B Instruct版本生成速度约为30-50 tokens/秒,14B版本约为20-30 tokens/秒,40B Loop版本约为10-20 tokens/秒,基本能够满足实时开发需求。若需进一步提升速度,可采用以下方式:使用更高级别的GPU、降低生成温度(temperature)、减少上下文长度(仅保留必要信息)、关闭do_sample参数(牺牲部分多样性换取速度)。

七、相关链接

GitHub官方仓库:https://github.com/IQuestLab/IQuest-Coder-V1

Hugging Face模型库:https://huggingface.co/IQuestLab

八、总结

IQuest-Coder-V1作为九坤投资至知创新研究院开源的代码大语言模型系列,以“代码流”多阶段训练范式为核心创新,通过捕捉代码仓库演化轨迹实现了对动态开发逻辑的深刻理解,在权威代码基准测试中取得顶尖成绩,展现出卓越的代码生成、错误修复与工程实践能力。该模型系列涵盖7B、14B、40B三种参数规模,提供Instruct、Thinking及Loop等多样化变体,既满足日常开发的高效需求,也能支撑复杂推理任务的完成,同时原生支持128K长上下文与76800大词表,适配真实大规模代码场景。在部署层面,模型兼顾高性能与轻量化,Int4量化版本可在消费级3090/4090 GPU运行,基础与Loop版本支持单卡H20推理,大幅降低了使用门槛。无论是个人开发者、编程学习者,还是企业团队,都能在代码生成、重构优化、调试测试等全流程软件工程场景中获得高效辅助。作为开源项目,IQuest-Coder-V1不仅提供了完整的模型与工具链支持,更通过开放的社区生态持续迭代优化,为国产代码模型的发展与应用奠定了坚实基础。

版权及免责申明:本文由@dotaai原创发布。该文章观点仅代表作者本人,不代表本站立场。本站不承担任何相关法律责任。

如若转载,请注明出处:https://www.aipuzi.cn/ai-news/iquest-coder-v1.html