Kani TTS:轻量级高性能开源文本转语音(TTS)框架,支持多语言与跨硬件优化推理

一、Kani TTS是什么

Kani TTS是由nineninesix-ai团队开发并开源的轻量级高性能文本转语音(Text-to-Speech,TTS)框架,旨在为开发者和企业提供快速、高效、类人化的语音生成解决方案。该项目基于先进的神经网络架构构建,核心聚焦于低资源消耗下的高质量语音输出,同时兼顾多语言适配与跨硬件部署能力。

不同于传统TTS工具存在的“硬件门槛高、语言支持单一、集成难度大”等问题,Kani TTS采用模块化设计理念,将音频编解码、语音合成、推理优化等核心功能解耦,既支持通过PyPi包快速集成到现有项目中,也提供完整的微调与训练Pipeline,满足从个人开发者到企业级应用的多样化需求。目前,Kani TTS已在GitHub开源,遵循Apache 2.0许可协议,允许开发者自由使用、修改和分发代码,同时支持社区贡献与二次开发。

二、Kani TTS功能特色

Kani TTS的核心优势在于“高性能、易部署、多适配”,其功能特色覆盖语音合成质量、硬件兼容性、开发便捷性等多个维度,具体如下:

1. 多语言全覆盖,支持跨语种语音生成

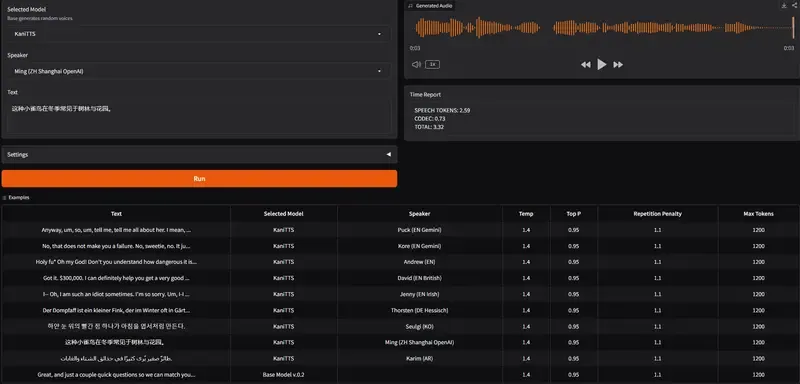

Kani TTS提供丰富的预训练模型库,涵盖英语、中文、德语、阿拉伯语、西班牙语、韩语、日语等主流语言,同时推出多语言通用模型,可实现单模型下的跨语种语音转换。针对不同语言的发音特点,模型在训练阶段融入了针对性的声学特征与韵律优化,生成的语音自然度高,避免了“机械腔”“口音混杂”等常见问题。

2. 跨硬件优化,适配全场景部署需求

为解决传统TTS模型“GPU依赖强、CPU推理慢”的痛点,Kani TTS针对不同硬件架构提供专项优化方案,覆盖从高性能计算设备到轻量级终端的全场景部署:

NVIDIA GPU优化:集成vLLM推理引擎,支持模型并行与动态批处理,大幅提升语音生成速度,同时提供OpenAI兼容API,降低集成成本;

Apple Silicon优化:推出MLX专用模型,充分利用M系列芯片的统一内存架构与神经网络引擎,在无独立GPU的情况下实现高效推理;

CPU通用支持:提供轻量化模型版本,在普通CPU设备上也能完成基础语音合成任务,满足低配置环境的部署需求。

3. 模块化设计,支持灵活扩展与二次开发

Kani TTS采用“编码器-解码器-编解码器”三层模块化架构,各组件之间通过标准化接口通信,开发者可根据需求替换或升级单个模块,无需重构整个系统。例如,用户可替换自定义的音频编解码器,或基于现有模型进行微调,适配特定场景的语音风格(如新闻播报、客服语音、儿童故事等)。

4. 一站式开发工具链,降低技术门槛

项目提供完整的开发与应用工具链,覆盖从模型调用到二次开发的全流程:

便捷的PyPi包:通过

pip install kani-tts即可快速安装,无需手动配置依赖环境;丰富的示例代码:在

examples目录下提供基础调用、vLLM推理、MLX优化等多个场景的演示代码,新手可快速上手;可视化集成支持:提供ComfyUI节点,支持通过拖拽式操作完成语音合成流程设计,无需编写代码;

完整微调Pipeline:配套数据集收集(Datamio工具)、数据预处理、模型微调、推理验证的全流程文档,支持开发者基于自定义数据集训练专属语音模型。

5. 类人化语音效果,兼顾自然度与可定制性

Kani TTS的预训练模型基于大规模多语种语音数据集训练,生成的语音在韵律、语调、停顿等方面更贴近真人发音。同时,模型支持调整语速、音量、音色等参数,开发者可根据应用场景定制个性化语音风格,例如为智能助手设置活泼的语音语调,为新闻播报场景设置沉稳正式的语音风格。

三、Kani TTS技术细节

Kani TTS的技术架构围绕“高效合成、低资源消耗、跨硬件适配”三大目标设计,核心涉及神经网络架构、音频编解码技术、推理优化方案等关键模块,以下从核心技术原理与架构设计两方面展开说明:

1. 核心技术原理

(1)神经网络音频编解码器:NeMo NanoCodec

Kani TTS采用NVIDIA NeMo框架提供的NanoCodec作为核心音频编解码组件,该技术的核心优势在于高效的音频压缩与还原能力。传统TTS模型直接生成原始音频数据,数据量较大,推理速度较慢;而NanoCodec通过将音频信号转换为离散的编码向量,大幅降低数据传输与存储成本,同时保证还原后的音频质量基本无损。

具体来说,NanoCodec的工作流程分为两步:

编码阶段:将输入的原始音频(如WAV格式)通过编码器转换为低维度的隐向量,实现音频数据的压缩;

解码阶段:将隐向量输入解码器,还原为与原始音频一致的波形数据,完成语音生成。

在Kani TTS中,NanoCodec与语音合成模型深度集成,既提升了推理效率,也降低了模型的显存占用,为低配置设备部署提供了技术基础。

(2)语音合成核心架构:Transformer-based TTS模型

Kani TTS的语音合成模型基于Transformer架构构建,相较于传统的Tacotron 2等模型,Transformer架构具备更强的长序列建模能力,能够更好地捕捉文本中的上下文语义信息,从而生成更自然的语音。

模型的训练流程分为三个核心步骤:

文本预处理:将输入文本转换为音素序列(Phoneme Sequence),解决不同语言的发音规则差异问题;

声学模型训练:基于音素序列与对应的语音数据,训练Transformer模型生成声学特征(如梅尔频谱);

声码器训练:将声学特征转换为原始音频波形,完成语音合成。

为提升模型的多语言适配能力,Kani TTS在训练阶段采用多语种混合数据集,并通过语言标识嵌入(Language Embedding)技术,让模型能够区分不同语言的发音特点,实现单模型多语言生成。

(3)推理优化技术:vLLM与MLX加速

为解决TTS模型推理速度慢的问题,Kani TTS针对不同硬件平台提供了专项优化方案:

vLLM加速(NVIDIA GPU):集成vLLM推理引擎,通过PagedAttention技术优化显存管理,支持动态批处理与模型并行,大幅提升批量语音生成的效率。同时,vLLM优化后的模型提供OpenAI兼容API,开发者可通过熟悉的接口调用语音合成功能;

MLX加速(Apple Silicon):针对Apple M系列芯片的架构特点,推出MLX专用模型版本,充分利用芯片的统一内存架构与神经网络引擎,实现低延迟推理。MLX优化后的模型在MacBook等设备上的推理速度相较于原生CPU版本提升3-5倍。

2. 架构设计

Kani TTS采用分层模块化架构,整体分为四层,各层之间通过标准化接口通信,便于功能扩展与二次开发。具体架构分层如下表所示:

| 架构层级 | 核心组件 | 功能描述 |

|---|---|---|

| 应用层 | ComfyUI节点、NextJS应用、Livekit助手 | 提供可视化操作界面与实际应用案例,支持快速集成到Web、实时语音等场景 |

| 推理层 | vLLM推理引擎、MLX推理引擎、CPU/GPU推理模块 | 负责模型推理加速,根据硬件类型自动选择最优推理方案 |

| 模型层 | 多语言TTS模型、声学模型、声码器、NeMo NanoCodec | 核心语音合成模块,包含预训练模型与编解码组件 |

| 数据层 | Datamio数据集收集工具、数据预处理Pipeline | 负责数据集的收集、清洗、格式转换,为模型训练与微调提供数据支持 |

3. 预训练模型资源

Kani TTS在Hugging Face平台提供了丰富的预训练模型资源,覆盖不同语言、不同硬件优化版本,开发者可根据需求直接下载使用。具体模型分类如下表所示:

| 模型类型 | 代表模型 | 适用场景 | 硬件要求 |

|---|---|---|---|

| 语言专用模型 | kani-tts-400m-en(英语)、kani-tts-300m-zh(中文) | 单语种高精度语音生成 | CPU/GPU均可,GPU推理速度更快 |

| 多语言通用模型 | kani-tts-370m | 跨语种语音生成,支持英语、中文、西班牙语等 | 建议使用GPU,支持批量推理 |

| 硬件优化模型 | kani-tts-370m-mlx | Apple Silicon设备专属推理 | Apple M系列芯片 |

| 微调检查点 | kani-tts-base-checkpoint | 基于自定义数据集微调模型 | GPU(建议显存≥8GB) |

四、Kani TTS应用场景

Kani TTS凭借多语言支持、跨硬件部署、易集成等特性,可广泛应用于各类需要语音合成能力的场景,以下是典型应用场景的详细说明:

1. 智能语音助手开发

在智能音箱、车载语音助手、手机语音助手等产品中,Kani TTS可提供自然流畅的语音交互能力。开发者可通过调整模型的语速、音色等参数,为助手定制个性化语音风格,同时利用多语言模型支持跨境产品的语音交互需求。例如,基于Kani TTS开发的车载语音助手,可实现中文导航播报、英文音乐播放控制等功能,且在车载CPU设备上也能保持低延迟推理。

2. 内容创作与媒体生产

在自媒体、新闻出版、教育内容制作等领域,Kani TTS可用于将文字内容快速转换为语音,降低音频制作成本。例如:

自媒体创作者可将文章转换为播客音频,发布到音频平台拓展传播渠道;

新闻机构可利用Kani TTS实现新闻稿件的自动语音播报,提升内容发布效率;

教育机构可将教材、习题转换为语音,制作有声读物或听力训练材料,适配不同学习场景。

3. 实时语音交互系统

在在线客服、实时会议、直播互动等场景中,Kani TTS可提供低延迟的实时语音生成能力。项目提供的Livekit实时语音助手示例,可实现文字消息到语音的实时转换,支持多人在线语音交互。例如,在跨境电商的在线客服系统中,客服输入文字内容,系统通过Kani TTS实时转换为客户的母语语音,提升沟通效率。

4. 无障碍服务与辅助技术

在无障碍领域,Kani TTS可用于为视障人士提供语音阅读服务。例如,将电子书、网页内容、手机界面文字转换为语音,帮助视障人士获取信息;同时,多语言支持特性可满足不同国家和地区视障用户的需求。此外,Kani TTS还可用于辅助语言学习,帮助学习者纠正发音,提升听力理解能力。

5. 嵌入式设备与物联网应用

在智能家居、智能穿戴设备、工业物联网终端等嵌入式设备中,Kani TTS的轻量化模型与跨硬件优化特性优势明显。例如,在智能手表中,可将短信、通知文字转换为语音播报,无需依赖手机端的语音服务;在工业物联网终端中,可将设备告警信息转换为语音,提醒工作人员及时处理故障。

五、Kani TTS使用方法

Kani TTS提供了多种使用方式,涵盖快速调用、高性能推理、可视化操作、自定义微调等场景,满足不同开发者的需求。以下是详细的使用步骤说明:

1. 环境准备

(1)硬件要求

根据使用场景的不同,硬件要求有所差异,具体推荐配置如下:

基础使用(CPU推理):任意多核CPU,内存≥8GB,适用于小型测试与开发;

GPU推理(NVIDIA):NVIDIA GPU显存≥8GB(建议16GB以上),支持CUDA 11.0及以上版本,适用于批量生成与模型微调;

Apple Silicon设备:Apple M1/M2/M3系列芯片,内存≥8GB,适用于本地轻量级推理。

(2)软件环境配置

Kani TTS支持Python 3.8及以上版本,推荐使用Anaconda创建虚拟环境,避免依赖冲突。具体步骤如下:

创建虚拟环境

conda create -n kani-tts python=3.10 conda activate kani-tts

安装依赖库 根据硬件类型选择对应的依赖安装方式:

通用版本(CPU/GPU)

pip install kani-tts

NVIDIA GPU优化版本(含vLLM)

pip install kani-tts[vllm]

Apple Silicon优化版本(含MLX)

pip install kani-tts[mlx]

2. 快速开始:基础语音合成

通过PyPi包安装后,可通过简单的Python代码实现语音合成,以下是中文语音合成的示例:

from kani_tts import KaniTTS

# 初始化模型(指定多语言模型)

model = KaniTTS.from_pretrained("nineninesix-ai/kani-tts-370m")

# 配置合成参数

text = "欢迎使用Kani TTS,这是一款轻量级高性能的开源文本转语音框架。"

output_path = "output.wav"

# 生成语音

model.tts_to_file(text=text, file_path=output_path, language="zh")

print(f"语音已保存至:{output_path}")代码说明:

from_pretrained方法:从Hugging Face加载预训练模型,支持指定模型名称或本地模型路径;tts_to_file方法:将文本转换为语音并保存为WAV文件,支持指定语言、语速、音量等参数;支持的语言参数:

en(英语)、zh(中文)、de(德语)、es(西班牙语)等。

3. 高性能推理:vLLM加速(NVIDIA GPU)

针对NVIDIA GPU用户,可使用vLLM推理引擎提升批量语音生成效率,同时支持OpenAI兼容API调用:

(1)vLLM推理示例

from kani_tts.vllm import KaniTTSVLLM

# 初始化vLLM优化模型

model = KaniTTSVLLM.from_pretrained(

"nineninesix-ai/kani-tts-370m",

tensor_parallel_size=1, # 模型并行数,根据GPU数量调整

gpu_memory_utilization=0.8 # GPU显存利用率

)

# 批量生成语音

texts = [

"Kani TTS支持批量语音生成。",

"vLLM推理引擎可大幅提升生成速度。"

]

output_paths = [f"output_{i}.wav" for i in range(len(texts))]

model.batch_tts_to_file(texts=texts, file_paths=output_paths, language="zh")(2)启动OpenAI兼容API

通过以下命令启动API服务,即可通过HTTP请求调用语音合成功能:

python -m kani_tts.vllm.server --model nineninesix-ai/kani-tts-370m --port 8000

API调用示例(curl命令):

curl http://localhost:8000/v1/audio/speech \

-H "Content-Type: application/json" \

-d '{

"input": "Hello, this is Kani TTS API.",

"model": "kani-tts-370m",

"language": "en",

"output_format": "wav"

}' --output api_output.wav4. Apple Silicon优化:MLX推理

针对Apple M系列芯片用户,可使用MLX优化模型实现本地高效推理,示例代码如下:

from kani_tts.mlx import KaniTTSMLX

# 初始化MLX优化模型

model = KaniTTSMLX.from_pretrained("nineninesix-ai/kani-tts-370m-mlx")

# 生成语音

text = "Apple Silicon设备上的Kani TTS推理速度更快。"

model.tts_to_file(text=text, file_path="mlx_output.wav", language="zh")5. 可视化操作:ComfyUI节点集成

Kani TTS提供了ComfyUI节点,支持通过拖拽式操作完成语音合成流程,无需编写代码:

安装ComfyUI:参考ComfyUI官方文档完成安装;

下载Kani TTS ComfyUI节点:将项目

examples/comfyui目录下的节点文件复制到ComfyUI的custom_nodes目录;启动ComfyUI:在界面中搜索“Kani TTS”相关节点,拖拽连接文本输入、模型加载、语音保存等节点,即可完成语音合成。

6. 自定义微调:训练专属语音模型

Kani TTS支持基于自定义数据集微调模型,适配特定语音风格或领域需求,具体步骤如下:

数据集准备:使用Datamio工具收集语音数据,或自行准备包含“文本-语音”配对的数据集,支持WAV、MP3等格式;

数据预处理:运行项目提供的预处理脚本,将语音数据转换为模型训练所需的格式(如梅尔频谱);

模型微调:参考

examples/finetune目录下的微调脚本,配置训练参数(如学习率、批次大小、训练轮数等);推理验证:使用微调后的模型进行语音生成,验证合成效果,并根据需要调整训练参数。

六、常见问题解答

1. 问题:安装Kani TTS后,运行代码提示“找不到模型文件”怎么办?

解答:出现该问题的原因通常是模型未成功下载或模型路径配置错误。解决方法如下:

检查网络连接:确保能够访问Hugging Face模型库,若网络受限,可手动下载模型文件到本地,然后通过

from_pretrained方法指定本地路径;确认模型名称:确保使用的模型名称与Hugging Face上的一致,例如多语言模型名称为

nineninesix-ai/kani-tts-370m;清理缓存:若模型下载过程中断,可删除Python缓存目录下的模型文件,重新运行代码。

2. 问题:GPU推理时出现“显存不足”错误,如何解决?

解答:显存不足是GPU推理中的常见问题,可通过以下方法优化:

降低模型并行数:在vLLM推理中,减小

tensor_parallel_size参数的值,例如从2调整为1;限制显存利用率:设置

gpu_memory_utilization参数(如0.7),避免模型占用过多显存;使用轻量化模型:选择参数规模较小的模型,例如

kani-tts-300m-zh相较于kani-tts-400m-en显存占用更低;批量推理优化:减小批量生成的文本数量,避免一次性处理过多数据。

3. 问题:生成的语音存在“机械腔”,如何提升自然度?

解答:提升语音自然度可从以下几个方面入手:

选择合适的模型:语言专用模型的自然度通常优于多语言通用模型,例如生成中文语音时优先选择

kani-tts-300m-zh;调整合成参数:通过设置

speed(语速)、pitch(音调)、volume(音量)等参数,优化语音韵律;文本预处理:对输入文本进行断句、添加标点符号,避免过长文本导致的韵律混乱;

模型微调:基于高质量的“文本-语音”配对数据集进行微调,提升模型在特定场景下的自然度。

4. 问题:Apple Silicon设备上推理速度较慢,如何优化?

解答:Apple Silicon设备用户需确保使用MLX优化版本的模型,具体方法如下:

安装MLX依赖:运行

pip install kani-tts[mlx],确保MLX库正确安装;使用MLX专用模型:从Hugging Face下载

kani-tts-370m-mlx模型,该模型针对Apple Silicon架构优化;关闭其他程序:推理时关闭占用内存和CPU的程序,避免资源竞争。

5. 问题:如何将Kani TTS集成到Web应用中?

解答:Kani TTS提供了NextJS应用示例,可参考以下步骤集成到Web应用:

参考

examples/nextjs目录下的代码,搭建基于React的前端界面;后端使用FastAPI或Flask框架,封装Kani TTS的语音合成接口;

前端通过HTTP请求调用后端接口,上传文本内容,获取生成的语音文件并播放。

6. 问题:Kani TTS支持哪些音频格式?如何转换为MP3格式?

解答:Kani TTS默认生成WAV格式的音频文件,若需要MP3格式,可通过以下方法实现:

使用第三方库转换:安装

pydub库,将生成的WAV文件转换为MP3格式,示例代码如下:

from pydub import AudioSegment

wav_audio = AudioSegment.from_wav("output.wav")

wav_audio.export("output.mp3", format="mp3")注意:使用

pydub需要安装FFmpeg,可通过conda install ffmpeg或手动下载安装。

七、Kani TTS相关链接

Hugging Face模型库:https://huggingface.co/nineninesix-ai

官方文档:https://nineninesix-ai.github.io/kani-tts/(详细使用教程、API文档)

八、总结

Kani TTS是一款由nineninesix-ai团队开发的轻量级高性能开源文本转语音框架,具备多语言支持、跨硬件优化、模块化设计等核心功能特色,其技术架构基于Transformer语音合成模型与NeMo NanoCodec音频编解码技术,通过vLLM与MLX推理引擎实现了不同硬件平台的高性能语音生成,同时提供丰富的预训练模型资源满足多样化需求;该项目可广泛应用于智能语音助手、内容创作、实时语音交互、无障碍服务等场景,支持快速调用、高性能推理、可视化操作、自定义微调等多种使用方式,开发者可通过官方GitHub仓库、Hugging Face模型库获取源码与预训练模型,遵循Apache 2.0许可协议进行二次开发与商业应用,是一款兼顾易用性与扩展性的优秀开源TTS工具。

版权及免责申明:本文由@97ai原创发布。该文章观点仅代表作者本人,不代表本站立场。本站不承担任何相关法律责任。

如若转载,请注明出处:https://www.aipuzi.cn/ai-news/kani-tts.html