MiMo-V2-Flash:小米开源的千亿级混合专家语言模型,高速推理与长上下文处理兼备

一、MiMo-V2-Flash是什么

MiMo-V2-Flash 是小米公司开源的千亿级混合专家(MoE)架构语言模型,核心定位为“高性能、低成本”,核心设计理念是在保证模型能力的前提下最大化降低推理开销,为开发者提供高性能、低成本的大模型应用解决方案。

该模型具备三大关键优势:一是参数配置均衡,总参数规模达3090亿,足以支撑复杂的语言理解、逻辑推理和生成任务,同时依托混合专家架构特性,仅需激活150亿活跃参数即可完成计算,大幅减少单次推理的算力消耗;二是技术架构创新,采用混合注意力架构与多令牌预测(MTP)技术,兼顾处理性能与效率;三是长文本处理能力突出,原生支持32k序列长度预训练,可扩展至256k超长上下文窗口,能轻松处理万字级长文本,填补了大模型在长文档场景应用的短板。凭借这些优势,模型在数学推理、代码生成、长文本处理等任务中表现优异,适配多种推理框架,可广泛应用于智能客服、代码助手、长文本分析等场景。

作为小米在大语言模型领域的重要开源成果,该模型采用 Apache License 2.0 协议开源,开发者可自由下载、使用、修改和二次分发,无学术研究与商业应用的授权限制。目前模型已在 HuggingFace 平台开放下载,配套提供详细的推理部署指南,有效降低了开发者的使用门槛。

二、功能特色

MiMo-V2-Flash 之所以能在众多开源大模型中脱颖而出,核心在于其四大核心功能特色,这些特色既解决了传统大模型的性能瓶颈,又拓展了模型的应用边界。

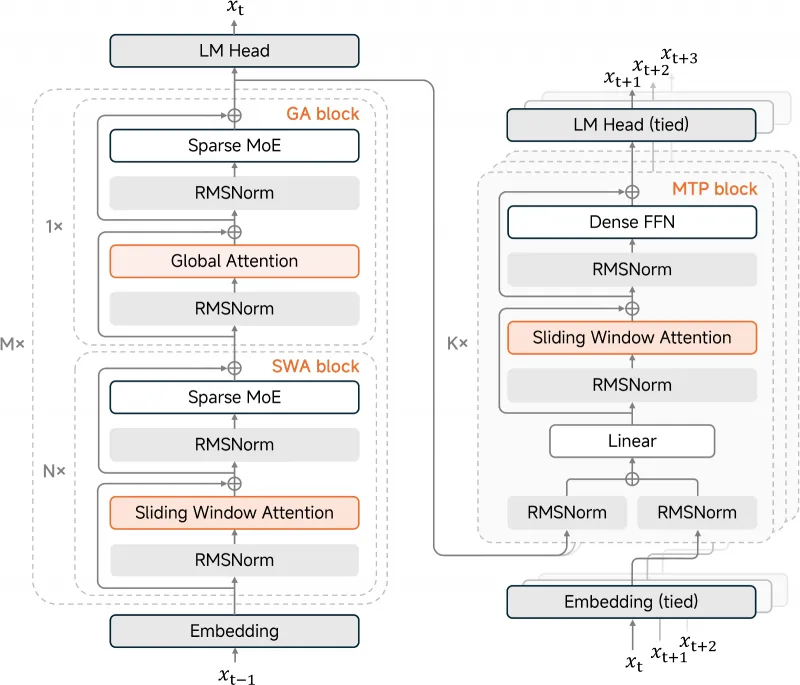

2.1 高速推理能力,推理效率提升三倍

模型内置多令牌预测(Multi-Token Prediction, MTP)模块,这一模块采用密集前馈神经网络(FFN)设计,单个模块仅占0.33亿参数,轻量化的结构不会增加过多的模型负担。在推理阶段,传统大模型通常一次只能生成一个令牌(Token),而 MTP 模块可实现一次生成多个令牌,直接将模型的输出速度提升三倍。这一特性对于实时对话、智能客服等需要快速响应的场景至关重要,能够显著提升用户交互体验。同时,MTP 模块还能加速强化学习(RL)训练中的“展开”过程,减少训练时间,降低研发成本。

2.2 长上下文处理,支持256k超长序列

与多数仅支持4k-32k上下文窗口的大模型不同,MiMo-V2-Flash 在预训练阶段就采用了32k原生序列长度,并通过技术优化实现了256k上下文窗口的扩展支持。256k的序列长度意味着模型可以一次性处理约20万字的文本内容(按中文单字对应一个Token计算),完全满足长文档总结、法律合同分析、学术论文精读、代码库理解等场景的需求。例如,开发者可直接输入一整份十万字的项目说明书,让模型生成核心摘要或提取关键信息,无需进行文本分段处理,大幅提升了工作效率。

2.3 混合注意力架构,兼顾性能与存储效率

模型创新采用滑动窗口注意力(Sliding Window Attention, SWA)+ 全局注意力(Global Attention, GA) 的混合注意力机制,两者以5:1的比例交错部署。滑动窗口注意力负责处理局部文本信息,计算效率高、存储开销小;全局注意力则负责捕捉文本中的长距离依赖关系,保证模型对文本整体逻辑的理解。这种混合设计既避免了纯全局注意力带来的巨大KV缓存压力,又解决了纯滑动窗口注意力无法处理长距离关联的问题。

同时,模型引入可学习的注意力sink偏置技术,进一步优化KV缓存的存储效率。测试数据显示,相比传统的全注意力架构模型,MiMo-V2-Flash 的 KV 缓存存储量减少了近6倍,这意味着在相同的硬件条件下,模型可以支持更多并发请求,或在低配硬件上实现流畅推理。

2.4 智能代理能力突出,复杂任务表现优异

为了提升模型在实际应用中的任务处理能力,MiMo-V2-Flash 在预训练完成后,采用了多教师在线策略蒸馏(Multi-Teacher Online Policy Distillation, MOPD) 和大规模智能代理强化学习技术进行优化。多教师蒸馏让模型能够吸收多个优秀模型的优点,强化自身的推理和生成能力;智能代理强化学习则针对代码调试、任务规划、逻辑推理等复杂场景进行专项训练。

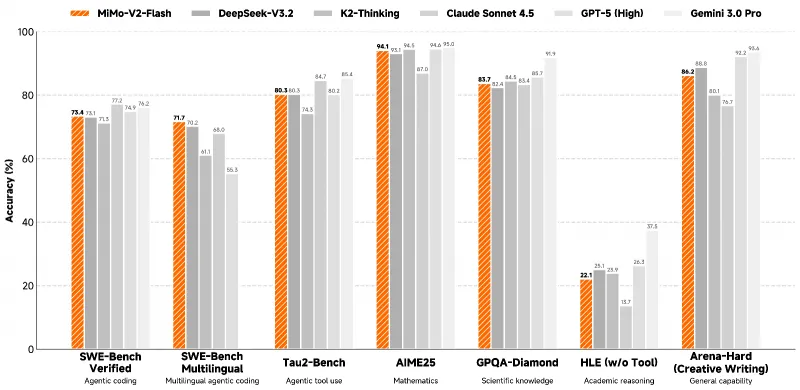

在权威基准测试中,模型在 SWE-Bench(代码修复任务)、GSM8K(小学数学推理)、MATH(高中数学推理)等数据集上均取得了优异成绩,充分证明了其在复杂任务中的处理能力。

三、技术细节

MiMo-V2-Flash 的卓越性能,源于其在模型架构、训练策略、推理优化三个层面的深度技术创新。以下从核心技术点出发,拆解模型的底层设计逻辑。

3.1 混合专家(MoE)架构设计

混合专家架构是 MiMo-V2-Flash 的核心基础,其本质是“分而治之”的计算思路。模型内部包含多个“专家网络”,每个专家网络负责处理特定类型的任务或数据分布。在实际推理过程中,模型会通过一个“门控网络”,根据输入文本的特征,选择最合适的1-2个专家网络进行激活,其他专家网络则处于休眠状态。

MiMo-V2-Flash 总参数达3090亿,正是由多个专家网络的参数总和构成;而活跃参数仅150亿,是因为每次推理仅需激活部分专家。这种设计的优势在于:在不损失模型性能的前提下,将单次推理的计算量控制在百亿级别,大幅降低了对硬件的要求。

3.2 混合注意力机制的实现

如前文所述,模型采用 SWA 与 GA 5:1交错的混合注意力架构,具体实现细节如下:

滑动窗口注意力(SWA):将输入文本划分为多个固定大小的窗口(窗口大小为128个Token),每个Token仅关注其所在窗口内的其他Token。这种局部注意力的计算复杂度为O(n)(n为序列长度),远低于全局注意力的O(n²),有效提升了计算效率。

全局注意力(GA):每隔5个SWA层插入1个GA层,GA层中的每个Token可以关注整个序列的所有Token,用于捕捉文本中的长距离依赖,例如一篇文章的开头与结尾的关联、逻辑推理中的前提与结论的对应关系。

注意力sink偏置:在注意力计算过程中,为序列的前几个Token(即注意力sink)添加可学习的偏置项,让模型能够更好地记住文本的开头信息。这一技术在长序列处理中尤为重要,解决了传统注意力机制在长文本中“遗忘”开头内容的问题。

通过上述设计,MiMo-V2-Flash 在长文本处理中,既保证了计算效率,又维持了对文本整体逻辑的理解能力。

3.3 高效训练策略

MiMo-V2-Flash 的训练过程采用了多项优化技术,以实现高效、低成本的模型训练:

FP8混合精度训练:传统大模型训练多采用FP16或BF16精度,而FP8精度的数值范围更小,能够减少显存占用。模型通过FP8混合精度训练,在保证训练稳定性的前提下,将显存消耗降低约一半,使得训练过程可以在更多普通GPU集群上进行。

32k原生序列长度预训练:多数大模型的预训练序列长度为2k或4k,后续通过位置插值技术扩展至更长序列,这种方式会损失部分性能。MiMo-V2-Flash 直接采用32k序列长度进行预训练,原生支持长文本处理,无需额外插值,保证了长上下文任务的性能。

27T令牌大规模训练数据:模型在27万亿个令牌的海量文本数据上进行预训练,数据涵盖了自然语言、代码、数学公式、多语言文本等多种类型,确保模型具备广泛的知识覆盖和任务处理能力。

3.4 智能代理能力优化技术

为了让模型更好地适配智能代理场景,团队采用了两大优化技术:

多教师在线策略蒸馏(MOPD):选择多个在不同任务上表现优异的模型作为“教师模型”,让 MiMo-V2-Flash 学习这些教师模型的推理路径和输出结果。与传统的离线蒸馏不同,在线蒸馏可以实时调整蒸馏策略,让学生模型更快地吸收教师模型的优点。

大规模智能代理强化学习:构建了包含代码调试、任务规划、多轮对话等多种场景的强化学习数据集,让模型在与环境的交互中不断优化自身的决策能力。例如,在代码修复任务中,模型会根据修复结果的正确性获得奖励,从而逐步提升代码处理能力。

四、应用场景

基于高速推理、长上下文处理、智能代理等核心能力,MiMo-V2-Flash 可广泛应用于多个领域,覆盖个人开发者、企业级应用等不同场景。

4.1 长文本处理场景

学术论文精读与总结:科研人员可将整篇学术论文(数万至十万字)输入模型,模型能够快速生成论文摘要、提炼核心观点、梳理实验方法与结论,还能回答关于论文内容的细节问题,例如“实验中使用的数据集是什么”“模型的对比指标有哪些”。

法律合同与文档分析:律师或企业法务人员可将冗长的法律合同、协议文本输入模型,模型可自动识别合同中的关键条款、风险点、权责划分,并生成合同解读报告。相比人工阅读,模型处理速度更快,且能避免遗漏细节。

小说与长文创作辅助:作家在创作长篇小说时,可将已完成的章节输入模型,模型能够根据前文的情节、人物设定,生成后续情节的发展建议,或对已写内容进行润色、修改,提升创作效率。

4.2 智能代理与代码开发场景

智能代码助手:开发者可使用模型进行代码生成、调试、重构等任务。例如,输入“写一个Python脚本,实现批量处理Excel文件的功能”,模型能直接生成完整代码;对于存在bug的代码,输入后模型可快速定位问题并给出修复方案。在 SWE-Bench 基准测试中的优异表现,证明了模型在代码任务中的可靠性。

自动化任务规划:企业可基于模型搭建自动化办公代理,代理能够理解用户的自然语言指令,分解任务步骤并执行。例如,用户输入“整理本周的销售数据,生成柱状图并发送给销售总监”,代理可自动调用数据接口、处理数据、生成图表,并通过邮件发送,实现办公流程的自动化。

4.3 实时交互与客服场景

智能客服机器人:由于模型具备高速推理能力,可应用于电商、金融等行业的智能客服系统。客服机器人能够快速理解用户的咨询问题,给出精准的回答,还能支持多轮对话,解决复杂的用户需求,例如“查询我的订单物流状态”“解释信用卡账单中的扣费项目”。相比传统客服机器人,MiMo-V2-Flash 生成的回答更自然、更贴合用户意图。

在线教育智能助教:在在线教育平台中,模型可作为智能助教,为学生提供实时答疑服务。学生输入数学题、物理题的题目内容,模型不仅能给出正确答案,还能提供详细的解题步骤和思路分析;对于语文、英语等文科科目,模型可辅助进行作文批改、阅读理解答疑等任务。

4.4 多语言与跨领域场景

多语言翻译与本地化:模型支持多种语言的处理,可用于文档翻译、网站本地化等任务。例如,将中文的产品说明书翻译成英文、日语等语言,模型能保证翻译的准确性和流畅性,同时保留专业术语的一致性。

跨领域知识问答:由于模型在海量多领域数据上进行了预训练,具备广泛的知识储备,可作为跨领域知识问答系统的核心引擎。用户可询问历史、科学、技术、生活等不同领域的问题,模型都能给出全面、准确的回答。

五、使用方法

MiMo-V2-Flash 提供了多种使用方式,开发者可根据自身需求选择合适的部署和推理方案。以下为详细的使用步骤,包括模型下载、环境准备、推理运行和参数设置。

5.1 模型下载

模型目前已在 HuggingFace 平台开放下载,提供两个版本,具体信息如下表所示:

| 模型版本 | 总参数 | 活跃参数 | 上下文长度 | 适用场景 | 下载地址 |

|---|---|---|---|---|---|

| MiMo-V2-Flash-Base | 309B | 15B | 256k | 学术研究、基础应用开发 | HuggingFace |

| MiMo-V2-Flash | 309B | 15B | 256k | 高性能应用、智能代理开发 | HuggingFace |

下载说明:

两个版本的模型架构一致,MiMo-V2-Flash 经过了多教师蒸馏和强化学习优化,在复杂任务上表现更优;

模型文件体积较大,建议使用 HuggingFace 的

transformers库自动下载,或通过迅雷等工具批量下载。

5.2 环境准备

推荐使用 Linux 系统进行部署,硬件需满足以下最低要求:

GPU:NVIDIA A100(40G显存)或更高规格GPU;若使用消费级GPU(如RTX 4090),需开启模型量化(如4-bit、8-bit量化)。

软件依赖:

Python 3.10+

PyTorch 2.0+

Transformers 4.35+

SGLang 0.1.0+(推荐,用于高速推理)

Accelerate、BitsAndBytes(用于模型量化)

环境安装命令:

# 创建虚拟环境 conda create -n mimo-v2 python=3.10 conda activate mimo-v2 # 安装PyTorch(根据CUDA版本调整) pip3 install torch torchvision torchaudio --index-url https://download.pytorch.org/whl/cu118 # 安装核心依赖 pip install transformers accelerate bitsandbytes sglang

5.3 推理运行

MiMo-V2-Flash 支持两种推理方式:基于 Transformers 库的通用推理和基于 SGLang 的高速推理,以下分别介绍。

5.3.1 基于 Transformers 库的推理

适用于快速验证模型功能,代码示例如下:

from transformers import AutoTokenizer, AutoModelForCausalLM

import torch

# 加载tokenizer和模型

model_name = "XiaomiMiMo/MiMo-V2-Flash"

tokenizer = AutoTokenizer.from_pretrained(model_name)

model = AutoModelForCausalLM.from_pretrained(

model_name,

torch_dtype=torch.bfloat16,

device_map="auto",

load_in_8bit=True, # 开启8-bit量化,降低显存占用

trust_remote_code=True

)

# 输入文本

prompt = "请总结以下论文的核心观点:[此处输入论文内容]"

inputs = tokenizer(prompt, return_tensors="pt").to("cuda")

# 生成文本

outputs = model.generate(

**inputs,

max_new_tokens=512, # 生成的最大Token数

temperature=0.7, # 生成随机性,越低越严谨

top_p=0.9,

repetition_penalty=1.1 # 避免重复生成

)

# 输出结果

response = tokenizer.decode(outputs[0], skip_special_tokens=True)

print(response)5.3.2 基于 SGLang 的高速推理

SGLang 是一款专为大模型设计的高速推理框架,能够充分发挥 MiMo-V2-Flash 的 MTP 模块优势,实现更快的推理速度。代码示例如下:

from sglang import function, system, user, Assistant

from sglang.lang.chat_template import get_chat_template

from sglang.runtime import Runtime

# 初始化运行时

runtime = Runtime(model_path="XiaomiMiMo/MiMo-V2-Flash", tp_size=1)

# 定义对话函数

@function

def chat(s, user_query: str):

s += system("你是一个专业的助手,擅长长文本总结和代码调试。")

s += user(user_query)

s += Assistant(role="assistant", max_tokens=1024)

# 运行推理

output = runtime.run(chat, user_query="请解释混合专家模型的工作原理")

print(output["output"].strip())5.4 推荐参数设置

不同场景下的参数设置会影响模型的生成效果,以下为推荐的参数组合:

| 应用场景 | temperature | top_p | max_new_tokens | repetition_penalty |

|---|---|---|---|---|

| 长文本总结 | 0.5 | 0.85 | 1024 | 1.1 |

| 代码生成 | 0.6 | 0.9 | 2048 | 1.2 |

| 数学推理 | 0.4 | 0.8 | 512 | 1.05 |

| 多轮对话 | 0.7 | 0.9 | 512 | 1.1 |

参数说明:

temperature:控制生成文本的随机性,值越低生成结果越固定,值越高越灵活;top_p:采用核采样策略,值越小生成结果越集中;max_new_tokens:限制生成文本的最大长度;repetition_penalty:防止模型重复生成相同的内容。

六、常见问题解答

Q:消费级GPU(如RTX 4090)能否运行该模型?

A:可以,但需要开启模型量化。RTX 4090(24G显存)可通过开启4-bit量化运行模型,推荐使用 bitsandbytes 库实现量化。量化后模型的显存占用约为15-20G,能够流畅进行推理,但生成速度会略低于专业GPU(如A100)。

Q:模型支持中文吗?表现如何?

A:支持。模型在预训练数据中包含了大量中文文本,在中文长文本总结、对话、推理等任务中表现优异。开发者可直接使用中文提示词进行交互,无需额外的中英文转换。

Q:256k上下文窗口如何开启?

A:模型默认支持256k上下文窗口,在推理时只需将 max_length 参数设置为256000即可。但需要注意,超长序列推理会增加显存占用,建议在高性能GPU上进行,或对输入文本进行适当分段。

Q:模型的训练数据包含哪些内容?是否涉及版权问题?

A:模型的预训练数据主要来自公开的学术论文、开源代码库、百科全书、合法授权的书籍等,所有数据均符合开源协议和版权法规。开发者使用模型进行商业应用时,需确保自身的输入数据不侵犯第三方版权。

Q:如何将模型部署为API服务?

A:可使用 FastAPI 或 Flask 框架封装推理代码,提供 HTTP API 服务。例如,基于 FastAPI 的部署代码可参考 HuggingFace 官方示例,或使用 SGLang 提供的服务部署功能,快速搭建高性能的API服务。

Q:模型在Windows系统上能否运行?

A:可以,但Windows系统对部分深度学习库的支持不如Linux系统完善。建议使用 WSL2(Windows Subsystem for Linux)安装Linux子系统,再按照Linux环境的步骤进行部署,以获得更好的兼容性和性能。

Q:MiMo-V2-Flash-Base 和 MiMo-V2-Flash 有什么区别?

A:两者的模型架构和参数规模完全一致,区别在于优化方式。MiMo-V2-Flash 经过了多教师蒸馏和智能代理强化学习优化,在代码推理、复杂任务处理等场景的表现更优;MiMo-V2-Flash-Base 是基础版本,更适合学术研究和模型二次开发。

七、相关链接

模型下载地址:

MiMo-V2-Flash-Base:https://huggingface.co/XiaomiMiMo/MiMo-V2-Flash-Base

MiMo-V2-Flash:https://huggingface.co/XiaomiMiMo/MiMo-V2-Flash

项目GitHub仓库:https://github.com/xiaomimimo/MiMo-V2-Flash

八、总结

MiMo-V2-Flash 是小米开源的一款高性能、低成本的千亿级混合专家语言模型,凭借3090亿总参数与150亿活跃参数的架构设计,实现了性能与推理效率的平衡,其创新的混合注意力机制与多令牌预测技术,不仅将KV缓存存储减少近6倍,还将推理速度提升三倍,同时原生支持256k超长上下文窗口,能够高效处理万字级长文本,经过多教师蒸馏与智能代理强化学习优化的模型,在数学推理、代码生成、智能客服等多个场景中表现优异,且采用 Apache License 2.0 协议开源,配套提供了完善的部署指南和推理工具,降低了开发者的使用门槛,为大模型在学术研究和商业应用领域的落地提供了可靠的解决方案。

版权及免责申明:本文由@人工智能研究所原创发布。该文章观点仅代表作者本人,不代表本站立场。本站不承担任何相关法律责任。

如若转载,请注明出处:https://www.aipuzi.cn/ai-news/mimo-v2-flash.html