MiniCPM-o 4.5:面壁智能开源的端侧离线全模态实时交互 AI 模型

一、MiniCPM-o 4.5是什么

MiniCPM-o 4.5是由面壁智能(OpenBMB)研发并开源的9B参数全双工全模态大语言模型,属于MiniCPM-V多模态模型系列的新一代旗舰版本,作为聚焦“全模态模型+端侧硬件”的重磅成果,该模型彻底打破传统多模态AI“一问一答、感知中断、反应滞后”的交互局限,以“开源+全双工+主动交互”为核心定位,实现了视频、音频、文本的实时流感知与输出,能在PC、手机、智能开发板等端侧设备上离线运行,无需依赖云端算力与网络。

区别于传统多模态模型仅能实现被动应答,MiniCPM-o 4.5真正做到了“边看边听、主动抢答、实时提醒”,就像一个具备自主感知能力的“智能伙伴”,可主动观察环境变化、监听声音信号,并在合适的时机主动发起交互,无需用户反复手动触发提问。同时,该模型开源免费,提供完整的SDK、推理工具链与二次开发文档,支持开发者自由优化定制,还推出了配套的“松果派”端侧硬件开发板,实现“模型+硬件”双赋能,无论是普通用户的日常使用,还是开发者的二次开发、企业的场景化落地,都能轻松适配,是目前端侧全模态AI领域兼顾性能、轻量化与交互体验的标杆性开源项目。

二、功能特色

MiniCPM-o 4.5围绕“端侧全模态实时交互”打造了五大核心功能,同时兼具多语言支持、隐私安全、生态适配等额外亮点,既贴合普通用户的日常高频使用场景,又能满足开发者的技术开发需求,核心功能特色可总结为以下五点:

1. 全模态实时感知,边看边听不中断

这是MiniCPM-o 4.5实现自然交互的核心基础,支持视频、音频、文本三大模态的同时输入,真正实现“视觉+听觉”双重在线且感知不中断。视觉层面,搭载自研3D-Resampler架构,可实现高刷视频画面识别,实时捕捉场景中的动态变化,比如电梯楼层跳动、公交车入站、货架商品位置等,同时融合高精度OCR与知识学习双模式,能精准识别画面中的文字信息,支持30+种语言的文字解析,还能高效处理180万像素的高分辨率图像与复杂文档、表格;听觉层面,可持续监听环境中的各类音效,比如空气炸锅的“叮”声、水壶的烧开鸣笛声、敲门声、公交报站声等,即使模型自身正在输出语音回应,也不会遗漏外界的声音信号,真正做到“耳听八方、眼观六路”。

2. 主动抢答+实时提醒,告别被动等待

打破传统AI“你不问、它不说”的被动应答局限,是MiniCPM-o 4.5最具辨识度的功能。该模型以1Hz的频率对感知到的多模态信息进行实时决策,可根据用户的前期指令或场景变化,主动发起交互、抢答问题、发出提醒。比如用户告知“空气炸锅叮了提醒我”,模型会持续监听音效,在设备发出提示音时主动提醒“加热好了哦”;候车时用户说“公交车来了叫我”,模型会通过摄像头持续观察站台画面,公交入站瞬间立即抢答“车来了”;在电梯中设置楼层提醒后,模型会实时识别楼层数字,精准提示“到你要的楼层了”。这一功能彻底解放了用户的注意力,让AI从“被动工具”升级为“主动助手”。

3. 全双工自由对话,可打断、能改口

MiniCPM-o 4.5采用原生全双工架构,无需依赖VAD语音检测机制,彻底打破了传统AI“说完再答、说听互斥”的回合制交互模式,实现了真正的自然对话体验。在模型输出语音或文本回应的过程中,用户可随时插入新的指令、打断原有对话,模型能实时捕捉并理解新的需求,在完成当前半句回应后,立即调整内容并抢答新问题。比如模型正在解说画面中的蓝色鸭子,用户突然插话“找小黄鸭”,模型会快速衔接并指出小黄鸭的位置,无需用户重新触发提问;日常聊天中,用户可随时更换话题、改口调整需求,交互过程与真人对话完全一致,自然不生硬。

4. 双模式推理,平衡性能与响应速度

为解决多模态模型“推理精度高则延迟高、响应速度快则能力弱”的行业痛点,MiniCPM-o 4.5内置常规模式与深度思考模式,可根据使用场景自动切换,同时借助RLPR混合强化学习技术,实现了性能与速度的最优平衡。常规模式下,模型专注于日常聊天、简单提醒、基础图像/语音理解等场景,响应速度快、无卡顿,首Token延迟仅0.6秒,能满足实时交互的需求;深度思考模式下,模型可应对复杂推理、复合型问题,比如结合画面文字进行信息分析、多步骤解读视频场景、复杂的视觉问答等,在保证推理精度的同时,通过轻量化设计避免了过高的延迟,兼顾了实用性与专业性。

5. 开源易部署,端侧离线全适配

MiniCPM-o 4.5坚持全程开源免费,无商业使用限制,同时做到了“低门槛部署、多设备适配、离线可运行”,让普通用户和开发者都能轻松上手。模型提供完整的SDK、推理工具链与二次开发文档,支持开发者自由进行二次优化、定制化开发,适配自身业务需求;部署层面,支持多端侧设备适配,无论是普通办公电脑、笔记本、安卓/苹果手机,还是面壁智能推出的配套“松果派”开发板,都能轻松安装运行,int4量化后显存占用仅需11GB,普通16G内存的电脑即可流畅运行;隐私与使用层面,模型支持完全离线运行,所有的视觉识别、语音监听、交互推理过程均在本地设备完成,无需将数据上传至云端,既节省了token成本,又从根本上保障了用户的隐私与数据安全,适配居家、户外、偏远地区等无网络场景。

额外亮点

除五大核心功能外,MiniCPM-o 4.5还具备语音克隆、多语言交互、生态高度适配等亮点:仅需几秒的声音样本,就能实现精准的语音克隆,并基于克隆音色进行角色扮演对话;语音生成的音色、拟人度大幅提升,能自动匹配合适的对话语气,英文长语音WER(词错误率)仅3.37%,远优于行业同类模型;生态层面,支持llama.cpp、Ollama、vLLM、SGLang等主流推理框架,还适配天数智芯、华为昇腾、平头哥、海光等6款芯片,端到端推理性能大幅提升。

三、技术细节

MiniCPM-o 4.5能实现端侧全双工全模态的实时交互,核心源于其在模型架构、训练技术、推理优化、跨平台适配四大方面的技术突破,同时兼顾参数规模与资源占用的平衡,让9B参数模型既能实现SOTA级的多模态能力,又能在端侧设备流畅运行,核心技术细节如下:

1. 核心模型架构:原生全双工+3D-Resampler

原生全双工架构:这是实现“边说边听、可打断”的核心,区别于传统模型通过外挂VAD语音检测实现的“伪双工”,MiniCPM-o 4.5从模型底层架构设计上支持输入流与输出流的并行处理,视频、音频的感知流与文本、语音的生成流互不阻塞,以1Hz的频率进行实时决策,判断是否需要主动发言或响应新指令,真正实现了感知与输出的同步进行。

3D-Resampler高刷视频理解架构:针对视频理解的低效率、高延迟问题,自研3D-Resampler架构,可实现高帧率视频的高效解析,采用3帧打包策略进行推理,在VideoMME视频理解评测集上的时间开销仅为同级模型的1/10,能实时捕捉视频中的动态变化,同时支持高分辨率图像的快速处理,兼顾视频理解的精度与速度。

2. 训练技术:RLPR混合强化学习+RLAIF-V轻量化训练

MiniCPM-o 4.5采用了创新的混合强化学习训练方案,解决了多模态模型推理精度与延迟的平衡问题,同时有效降低了模型幻觉:

RLPR混合强化学习:针对双推理模式设计专属训练方案,在强化学习过程中同时激活常规模式与深度思考模式,让模型在相同的训练时长内,既实现常规模式的性能显著提升,又保持深度思考模式的高推理能力。同时,RLPR技术从通用域多模态推理数据中获取高质量的奖励信号,大幅提升了模型在通用领域的推理能力,让模型能更好地理解复杂场景、应对复合型问题。

RLAIF-V轻量化训练:在强化学习后加入轻量化的RLAIF-V训练阶段,通过人工反馈的智能体强化学习,在保持模型推理能力的同时,显著降低了多模态模型常见的“幻觉问题”,让模型的回答更精准、更贴合实际场景,减少错误信息的输出。

3. 推理优化:低量化+低延迟+高能效比

为适配端侧设备的低资源特性,MiniCPM-o 4.5在推理阶段进行了全方位的优化,实现了“高性能、低开销、快响应”:

低精度量化支持:提供int4、int8等多种低精度量化版本,其中int4量化后显存占用仅需11GB,普通16G内存的PC即可流畅运行,手机端量化后可实现6~8 token/s的流畅解码,大幅降低了端侧部署的硬件门槛。

首Token延迟优化:通过轻量化的语音生成模块与推理框架优化,将模型的首Token延迟控制在0.6秒以内,让模型的响应更及时,满足实时交互的需求,避免用户产生等待感。

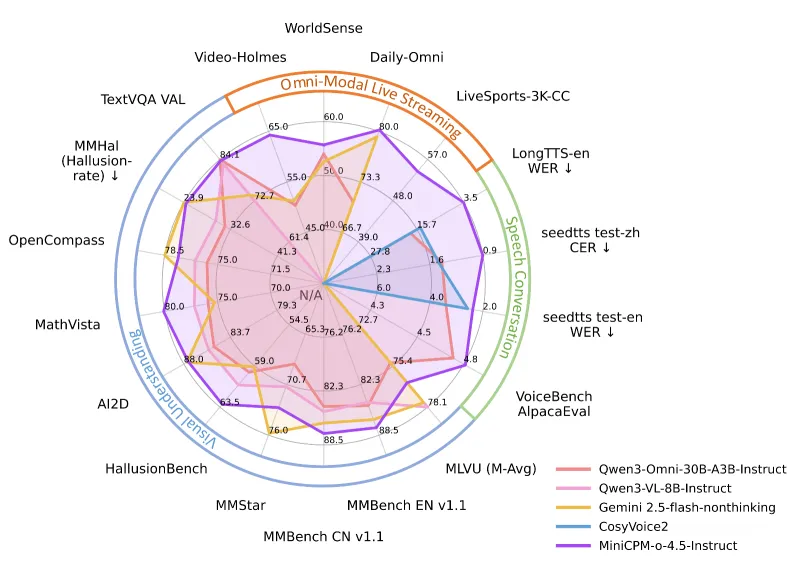

高推理能效比:在保证模型能力的前提下,通过模型结构剪枝、算子优化等方式,大幅提升了推理效率,在OpenCompass、MMBench、MathVista等核心多模态评测中,均达到同级模型的SOTA水平,同时推理时间与资源占用远低于同类模型。

4. 跨平台适配:统一软件栈+多硬件/框架兼容

为让模型能在更多端侧设备与开发框架中运行,MiniCPM-o 4.5打造了高度兼容的跨平台适配体系:

统一系统软件栈FlagOS:基于面壁智能自研的FlagOS统一软件栈,实现了跨芯片的适配优化,在天数智芯、华为昇腾、平头哥、海光、沐曦等6款国产及通用芯片上,均实现了端到端的推理性能提升,适配更多硬件场景。

多推理框架兼容:支持llama.cpp、Ollama、vLLM、SGLang等目前主流的大模型推理框架,同时开源了专属的llama.cpp-omni推理框架,配合WebRTC Demo,普通用户在MacBook、Windows PC等设备上可直接体验全双工全模态对话,开发者可根据自身需求选择熟悉的框架进行二次开发。

5. 模型参数与核心指标

MiniCPM-o 4.5的核心参数与关键性能指标做到了性能与轻量化的平衡,以下为核心参数与评测指标汇总表:

| 核心维度 | 具体指标 |

|---|---|

| 模型参数 | 9B |

| 支持模态 | 视频、音频、文本输入;文本、语音输出 |

| 首Token延迟 | ≤0.6秒 |

| int4量化显存占用 | 11GB |

| 英文长语音WER | 3.37% |

| OCR识别得分 | 89.0 |

| 视频推理时间开销 | 同级模型的1/10(VideoMME评测) |

| 支持部署设备 | PC、手机、松果派开发板、智能硬件 |

| 支持推理框架 | llama.cpp、Ollama、vLLM、SGLang等 |

四、应用场景

MiniCPM-o 4.5凭借全模态感知、主动交互、端侧离线、开源易部署的核心优势,可适配个人日常、办公生产、行业开发、智能硬件四大类场景,既满足普通用户的生活化需求,又能为开发者和企业提供高效的AI技术底座,核心落地场景如下:

1. 个人日常场景:居家生活与通勤出行

这是MiniCPM-o 4.5最贴近普通用户的场景,借助主动提醒、全模态感知能力,成为个人生活的“智能助手”,解放用户注意力。

居家智能提醒:在厨房、客厅等场景,可实现家电工作提醒(空气炸锅、烤箱加热完成)、安全预警(水壶烧开、煤气灶忘关)、物品识别(找冰箱里的牛奶、识别过期食品)等功能,所有操作离线完成,无需连接智能家居设备,普通电脑/手机即可实现。

通勤出行辅助:在公交、地铁、车站等场景,可实现候车提醒(目标公交/地铁入站)、路线指引(识别路牌、导航信息)、环境感知(提醒后方来人、识别红绿灯),同时支持离线运行,适配户外无网络场景,还能为视障人士提供视觉与听觉的双重引导,提升出行便利性。

2. 办公生产场景:高效办公与内容创作

在办公场景中,MiniCPM-o 4.5可借助多模态理解、深度推理能力,提升办公效率,成为办公助手:

多模态文档处理:可高效解析图片、PDF、扫描件中的复杂文档、表格,实现文字提取、信息整理、数据统计,无需手动打字录入,同时支持多语言文档的解析,适配跨境办公场景。

实时会议辅助:在视频会议中,可实时监听会议语音,提取关键信息、生成会议纪要,同时识别会议画面中的演示内容,配合语音进行解读,还能主动提醒会议时间、待办事项。

内容创作辅助:可为设计师、文案、视频创作者提供多模态创作支持,比如根据图片生成文案、根据视频内容进行解说词创作、根据语音需求生成文字内容,同时支持语音克隆,生成与创作者音色一致的解说语音。

3. 行业开发场景:二次开发与场景化落地

作为开源全模态模型,MiniCPM-o 4.5为开发者和企业提供了免费的技术底座,可进行二次开发与场景化定制,适配多个行业:

智能家居开发:可集成至智能音箱、智能屏、智能摄像头等智能家居设备,实现全双工语音交互、主动场景感知,让智能家居从“被动控制”升级为“主动服务”。

智能车载开发:可集成至车载系统,实现车载全双工语音对话、道路场景感知(识别交通标识、提醒路况)、车内环境监测,同时支持离线运行,适配车载无网络场景,提升驾驶安全性与体验感。

工业检测辅助:可在工业场景中,通过摄像头实时识别生产画面,检测产品缺陷、提醒设备异常,同时监听设备运行声音,实现音视频双重的工业检测,提升检测效率。

4. 智能硬件场景:模型+硬件双赋能

配合面壁智能推出的配套“松果派”端侧硬件开发板,MiniCPM-o 4.5实现了“模型+硬件”的双赋能,可落地更多具身智能场景:

个人知识助理:将模型部署至松果派开发板,打造便携式的个人知识助理,支持离线语音对话、图像识别、文档解析,适配户外、出差等场景,成为个人的“移动AI大脑”。

具身智能机器人:可将模型集成至小型服务机器人、教育机器人,让机器人具备全模态感知、主动交互能力,能实现自主场景识别、自然语音对话、主动服务,适配家庭、商场、学校等场景。

便携式检测设备:将模型与便携式摄像头、麦克风结合,打造便携式的多模态检测设备,可实现现场的图像/语音识别、信息分析,适配巡检、执法、户外作业等场景。

五、使用方法

MiniCPM-o 4.5针对普通用户和开发者分别提供了低门槛的快速使用方法与专业的二次开发方法,同时支持Docker、本地部署等多种部署方式,普通用户无需专业技术即可快速上手,开发者可根据需求进行定制化开发,以下为详细的使用方法,涵盖环境准备、快速体验、二次开发三大环节:

1. 环境准备

MiniCPM-o 4.5的环境依赖简单,支持Windows、Mac、Linux等主流操作系统,同时支持GPU/CPU部署,CPU部署满足基础使用,GPU部署可提升推理效率,核心环境要求如下:

硬件要求:CPU部署需16G及以上内存,GPU部署需NVIDIA GTX 1060及以上显卡(显存≥8G),int4量化版本GPU显存仅需11GB;手机端需安卓10.0及以上、苹果iOS 14.0及以上系统,内存≥8G。

软件要求:Python 3.8~3.11版本,依赖PyTorch 2.0+、Transformers 4.30+、OpenCV、FFmpeg等基础库,模型提供统一的requirements.txt文件,可一键安装依赖。

2. 普通用户:快速体验方法

普通用户可通过本地脚本运行和Docker镜像部署两种方式快速体验MiniCPM-o 4.5的核心功能,全程无需专业开发知识,操作步骤简单:

方式1:本地脚本快速运行(PC端)

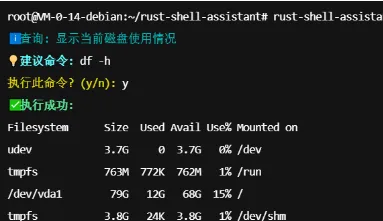

克隆项目仓库:在终端中执行命令

git clone https://github.com/OpenBMB/MiniCPM-o.git,将项目克隆至本地;进入项目目录:执行

cd MiniCPM-o,进入项目根目录;安装依赖:执行

pip install -r requirements.txt,一键安装所有环境依赖;启动模型:执行

python chat.py,启动模型的交互式对话界面,勾选“实时感知”“主动提醒”功能,开启摄像头与麦克风,即可体验全模态实时交互。

方式2:Docker镜像部署(跨平台)

拉取官方Docker镜像:执行

docker pull openbmb/minicpm-o:4.5,拉取最新的MiniCPM-o 4.5镜像;启动容器:执行

docker run -it --rm --gpus all -p 7860:7860 openbmb/minicpm-o:4.5,启动Docker容器,开启GPU支持并映射端口;体验交互:打开浏览器,访问

http://localhost:7860,进入模型的Web交互界面,开启摄像头与麦克风,即可体验全双工全模态交互。

方式3:手机端离线体验

下载官方移动端安装包:从项目GitHub仓库或面壁智能官方网站下载MiniCPM-o 4.5移动端开源版安装包;

安装并配置:在手机上安装后,开启“离线模式”,授予摄像头、麦克风权限;

开始使用:直接语音或文字输入指令,即可体验手机端的离线全模态交互,支持主动提醒、视觉问答等核心功能。

3. 开发者:二次开发与微调方法

MiniCPM-o 4.5为开发者提供了完整的SDK、微调代码与开发文档,支持LoRA轻量化微调、多框架二次开发,核心步骤如下:

步骤1:模型权重下载

从Hugging Face或ModelScope平台下载MiniCPM-o 4.5的模型权重,官方仓库提供了权重下载链接与快速下载脚本。

步骤2:LoRA轻量化微调

模型支持LoRA微调,仅需2张V100 GPU即可完成微调,核心微调命令如下:

swift finetune \ --model_id_or_path minicpm-o-4.5 \ --dataset_path your_dataset \ --lora_rank 8 \ --batch_size 4 \ --learning_rate 2e-4 \ --num_train_epochs 3 \ --save_total_limit 2 \ --logging_steps 5 \ --max_length 2048 \ --output_dir output

步骤3:微调后推理

微调完成后,执行以下命令进行推理,支持流式输出:

CUDA_VISIBLE_DEVICES=0 \ swift infer \ --adapters output/vx-xxx/checkpoint-xxx \ --stream true \ --load_data_args true \ --max_new_tokens 2048

步骤4:模型导出与部署

将微调后的模型导出为GGUF、ONNX等轻量化格式,可部署至端侧设备,也可推送到ModelScope平台进行共享:

swift export \ --adapters output/vx-xxx/checkpoint-xxx \ --push_to_hub true \ --hub_model_id '<your-model-id>' \ --hub_token '<your-sdk-token>'

4. 全双工交互体验:WebRTC Demo

官方提供了WebRTC Demo,可在Mac、Windows PC上体验低延迟的全双工全模态交互,步骤如下:

克隆llama.cpp-omni推理框架:

git clone https://github.com/OpenBMB/llama.cpp-omni.git;编译框架:按照官方文档完成框架编译,支持GPU加速;

启动WebRTC服务:执行官方提供的启动脚本,开启服务;

体验交互:打开浏览器访问指定地址,开启摄像头与麦克风,即可体验“边看边听、主动抢答”的全双工交互。

六、常见问题解答

Q1:MiniCPM-o 4.5需要付费使用吗?是否有商业使用限制?

A1:MiniCPM-o 4.5全程开源免费,无任何使用费用,同时无商业使用限制,普通用户、开发者、企业均可免费使用,可进行二次开发、场景化落地、商业产品集成等操作。

Q2:普通电脑没有独立显卡,能运行MiniCPM-o 4.5吗?

A2:可以,MiniCPM-o 4.5支持纯CPU部署,仅需16G及以上内存即可运行基础版本,满足日常的视觉问答、主动提醒等核心功能;如果需要更流畅的体验,建议搭配独立显卡,int4量化版本仅需11GB GPU显存。

Q3:MiniCPM-o 4.5支持苹果手机/电脑吗?

A3:支持,模型适配苹果MacOS系统(Intel/Apple Silicon均支持),可在MacBook、iMac等设备上流畅运行;苹果手机端支持iOS 14.0及以上系统,需8G及以上内存,官方提供了对应的移动端安装包,支持离线运行。

Q4:模型的主动提醒功能可以自定义吗?如何设置提醒的场景和方式?

A4:可以自定义,在模型的交互界面中,可勾选需要开启的主动提醒功能,同时可设置提醒的语气(男声/女声/童声)、提醒的灵敏度;也可通过语音或文字直接告知模型具体的提醒需求,比如“水烧开了提醒我”“公交10路来了叫我”,模型会自动识别并执行。

Q5:MiniCPM-o 4.5的离线运行模式,会泄露用户的隐私数据吗?

A5:不会,模型的离线运行模式下,所有的摄像头画面、麦克风语音、交互数据均在本地设备进行处理,不会上传至任何云端服务器,从根本上保障了用户的隐私与数据安全,用户可放心使用。

Q6:模型支持哪些语言?能否识别中文手写体和生僻字?

A6:模型支持30+种语言的交互与识别,核心支持中文、英文、日语、韩语等主流语言;视觉层面,支持中文手写体的识别,同时能精准识别生僻字、繁体字,OCR识别得分高达89.0,识别精度领先于行业同类模型。

Q7:MiniCPM-o 4.5与之前的MiniCPM-V 4.0/2.6版本有什么区别?

A7:MiniCPM-o 4.5是MiniCPM-V系列的重磅升级版本,核心区别在于:新增全双工全模态实时交互能力,实现边看边听、主动抢答;参数规模提升至9B,多模态能力大幅增强;新增语音克隆、多语言语音合成功能;推理效率与能效比进一步优化,端侧部署门槛更低;同时推出配套的松果派开发板,实现模型+硬件双赋能。

Q8:模型的语音克隆功能需要多少样本?克隆的音色是否自然?

A8:模型的语音克隆功能仅需几秒的声音样本(建议3~5秒),即可实现精准的音色克隆;克隆的音色自然度高,拟人度大幅提升,同时可基于克隆音色进行角色扮演、解说词生成等操作,英文长语音WER仅3.37%,远优于行业同类模型。

Q9:如何将MiniCPM-o 4.5部署至智能硬件?需要哪些开发基础?

A9:官方提供了完整的SDK与硬件部署文档,同时推出了配套的“松果派”开发板,可直接适配模型,无需复杂的硬件开发基础;如果需要部署至其他智能硬件,需具备基础的嵌入式开发知识,模型支持多种轻量化格式(GGUF、ONNX),可轻松集成至各类智能硬件。

七、相关链接

项目核心GitHub仓库:https://github.com/OpenBMB/MiniCPM-o

模型下载(Hugging Face):https://huggingface.co/openbmb/MiniCPM-o-4_5

模型下载(ModelScope):https://minicpm-omni.openbmb.cn/

官方llama.cpp-omni推理框架:https://github.com/OpenBMB/llama.cpp-omni

官方开发文档与教程:https://openbmb.github.io/MiniCPM-o/

面壁智能官方网站:https://www.openbmb.org/

八、总结

MiniCPM-o 4.5是面壁智能(OpenBMB)推出的开源9B参数全双工全模态大语言模型,作为MiniCPM-V系列的新一代旗舰版本,它以“端侧全模态实时交互”为核心,打破了传统多模态AI的被动应答局限,通过原生全双工架构、3D-Resampler视频理解架构、RLPR混合强化学习等核心技术,实现了视频、音频、文本的实时流感知与输出,做到了边看边听、主动抢答、实时提醒的自然交互体验,同时兼顾了高性能与轻量化,int4量化后显存占用仅11GB,可在PC、手机、智能硬件等端侧设备离线运行,无需依赖云端算力与网络。该模型全程开源免费,无商业使用限制,提供完整的SDK、推理工具链与二次开发文档,支持llama.cpp、Ollama等主流推理框架,还推出了配套的“松果派”开发板,实现模型+硬件双赋能,既满足普通用户居家、通勤、办公等日常场景的使用需求,又能为开发者和企业提供高效的AI技术底座,适配智能家居、智能车载、具身智能等多行业的二次开发与场景化落地,是目前端侧全模态AI领域兼顾交互体验、性能与部署便捷性的标杆性开源项目,为端侧AI的普及与落地提供了重要的技术支撑,让更多用户和开发者能轻松接触并使用顶尖的全模态AI技术。

版权及免责申明:本文由@97ai原创发布。该文章观点仅代表作者本人,不代表本站立场。本站不承担任何相关法律责任。

如若转载,请注明出处:https://www.aipuzi.cn/ai-news/minicpm-o-4-5.html