Qwen3-ASR:通义千问开源的多语言语音识别套件,覆盖52种语种方言与高精度强制对齐

一、Qwen3-ASR是什么

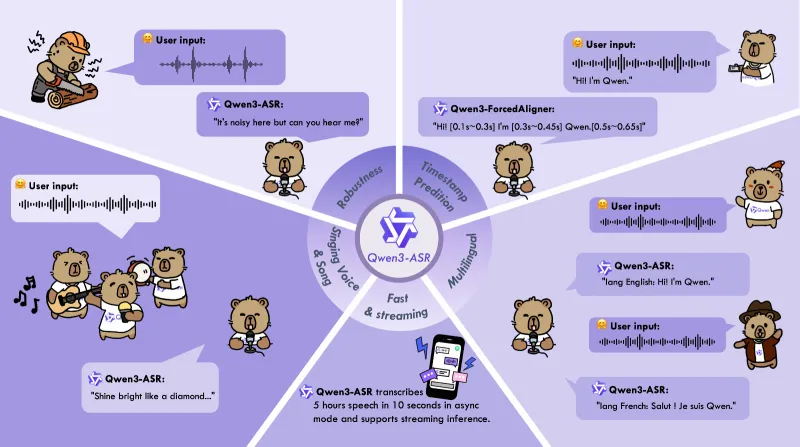

Qwen3-ASR是由阿里云通义千问(QwenLM)团队完全开源的一站式语音识别(ASR)与语音-文本强制对齐解决方案,基于Qwen3-Omni多模态大模型基座研发,是一套集语音转写、语言自动识别(LID)、流式/离线推理、歌唱语音识别、高精度时间戳对齐于一体的全栈语音工具集,以开源模型权重、完整推理代码、微调脚本、部署方案的形式开放,采用Apache-2.0开源协议,支持商用与非商用场景的自由使用、二次开发与私有化部署。

该项目核心包含三大模型组件,分别面向不同性能与场景需求:高精度旗舰版语音识别模型Qwen3-ASR-1.7B、轻量高效版语音识别模型Qwen3-ASR-0.6B,以及创新的多语言语音-文本强制对齐模型Qwen3-ForcedAligner-0.6B。项目打破了传统开源ASR模型语言覆盖少、方言支持弱、复杂场景鲁棒性差、无法输出精准时间戳、流式与离线模型分离的行业痛点,实现了单模型兼容多场景、多语言、多推理模式,性能在开源ASR领域达到SOTA(当前最优)水平,1.7B版本精度可直接对标头部闭源商用ASR API,0.6B版本则实现了精度与推理效率的最优平衡,兼顾端侧部署、高并发服务等多元化需求。

Qwen3-ASR的核心定位是普惠化、工业化、全场景的开源语音基础设施,既满足科研人员的模型研究、算法验证需求,也适配企业用户的私有化部署、业务集成、定制化微调需求,同时面向个人开发者提供开箱即用的快速推理、Web演示工具,降低语音技术的使用门槛,让多语言、多方言、高鲁棒性的语音识别能力可被全人群便捷使用。

二、功能特色

(一)超广语言与方言覆盖

Qwen3-ASR的两大核心ASR模型支持30种通用国际语言+22种汉语方言,总计52种语言与方言类型,同时兼容各国英语口音、中英混读、方言与普通话混读场景,语言识别与转写一体化完成,无需额外搭配语言分类模型。

国际语言包含中文、英语、阿拉伯语、德语、法语、西班牙语、葡萄牙语、印尼语、意大利语、韩语、俄语、泰语、越南语、日语、土耳其语、印地语、马来语、荷兰语、瑞典语、丹麦语、芬兰语、波兰语、捷克语、菲律宾语、波斯语、希腊语、匈牙利语、马其顿语、罗马尼亚语等;汉语方言覆盖粤语、吴语、闽南语,以及安徽、东北、福建、甘肃、贵州、河北、河南、湖北、湖南、江西、宁夏、山东、陕西、山西、四川、天津、云南、浙江等地域方言,是目前开源ASR模型中汉语方言支持最全面的方案之一。

强制对齐模型Qwen3-ForcedAligner-0.6B支持中、英、粤、法、德、意、日、韩、葡、俄、西11种主流语言的语音-文本时间戳对齐,覆盖全球核心使用语言,满足跨语言内容标注、字幕制作、语音分析需求。

(二)全场景高鲁棒性识别

复杂声学环境适配:支持低信噪比、远场录音、压缩音频、背景噪音、多人混响等场景,对老人语音、儿童语音、快速口语、模糊发音的识别精度显著优于同类开源模型。

歌唱语音专项优化:可直接转写带背景音乐的完整歌曲,中文歌唱词错误率(WER)低至13.91%,英文歌唱词错误率低至14.60%,解决传统ASR模型无法处理带伴奏演唱语音的痛点,适配音乐内容分析、歌词提取、翻唱内容转写场景。

长音频兼容:单条音频最大支持20分钟(1200秒)离线转写,无需手动分段,强制对齐模型支持最长5分钟(300秒)音频的时间戳预测,满足讲座、会议、播客、访谈等长内容处理需求。

非语音过滤:自动识别并剔除静音、环境杂音、非人声片段,仅保留有效语音内容转写,提升结果整洁度。

(三)流式与离线统一推理

采用动态注意力窗口机制,单模型同时支持流式推理与离线推理,无需切换模型或修改架构。流式推理支持2秒音频分块输入,首包响应延迟低,适配实时语音对话、直播字幕、电话实时转写等低延迟场景;离线推理支持完整音频一次性输入,适配文件批量转写、音视频后期处理等非实时场景,两种模式精度无明显衰减,降低开发者的模型适配成本。

(四)高精度语音-文本强制对齐

Qwen3-ForcedAligner-0.6B是业内首个基于大语言模型(LLM)的非自回归(NAR)多语言强制对齐模型,可输出字、词、句、段落任意粒度的时间戳,时间戳预测平均偏移量远低于MFA、NeMo Forced Aligner、WhisperX等传统方案,在人工标注测试集上的累积平均偏移量相对降低67%~77%。该模型支持跨语言、语码切换场景的对齐,无需针对不同语言单独训练对齐模型,是语音数据集标注、字幕精准生成、语音片段剪辑、司法语音取证的核心工具。

(五)极致推理效率与高并发能力

0.6B轻量模型首token响应时间低至92ms,在128并发场景下,每秒可完成2000秒语音的转写,吞吐量达到常规方案的2000倍,适配云端高并发服务、端侧设备(手机、嵌入式设备)、边缘计算节点部署;1.7B模型在保持旗舰精度的同时,通过vLLM优化可实现大规模批量推理,兼顾性能与效率。项目原生适配vLLM推理引擎,支持异步服务、容器化部署,进一步提升并发处理能力。

(六)开箱即用的全流程工具链

项目提供完整的Python核心包、命令行工具、Gradio Web Demo、Docker部署脚本、微调代码、API兼容接口,支持transformers原生推理、vLLM高性能推理、DashScope云端API调用三种使用方式,无需从零搭建推理框架;同时提供音频格式自动重采样、VAD语音活动检测、长音频智能分段、结果后处理、SRT字幕生成等配套能力,用户仅需简单配置即可完成从音频输入到文本/字幕输出的全流程。

(七)支持自定义微调与场景优化

开放完整微调脚本与数据格式规范,支持用户使用自有语音数据进行全参数微调或LoRA微调,可针对医疗、法律、金融、教育等专业领域的术语、口音、场景进行优化,提升垂直领域识别精度;同时支持通过上下文提示词(Prompt)增强专业词汇识别,无需微调即可快速适配特定业务场景。

三、技术细节

(一)整体模型架构

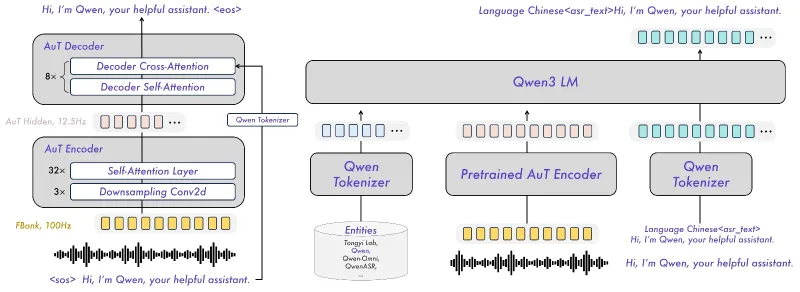

Qwen3-ASR系列模型基于Qwen3-Omni多模态基座与自研AuT语音编码器构建,采用“语音编码+语义理解+文本生成/时间戳预测”的端到端架构,核心分为两大部分:

AuT语音编码器:基于注意力编解码(AED)结构设计,对128维Fbank音频特征进行8倍下采样,生成12.5Hz帧率的语音令牌,采用1秒至8秒动态闪存注意力窗口,同时满足流式短分块与离线长音频的推理需求,编码器参数分别为300M(1.7B ASR模型配套)、180M(0.6B ASR模型配套),兼顾特征提取能力与计算效率。

大语言模型主干:分别基于Qwen3-1.7B与Qwen3-0.6B文本大模型,搭配特征投影层,将语音编码器输出的声学特征与文本语义特征对齐,实现语音到文本的映射;强制对齐模型则基于该架构,将任务转换为非自回归时间戳预测,摒弃传统自回归逐token生成模式,大幅提升对齐速度与精度。

(二)模型规格与核心参数

项目核心模型的关键参数与能力对比如下表:

| 模型名称 | 参数量 | 支持语言/方言 | 最大音频时长 | 推理模式 | 核心定位 | 典型部署场景 |

|---|---|---|---|---|---|---|

| Qwen3-ASR-1.7B | 1.7B+300M | 30种语言+22种汉语方言 | 1200秒(20分钟) | 离线/流式统一 | 高精度旗舰版 | 云端服务、专业转写、高要求业务场景 |

| Qwen3-ASR-0.6B | 0.6B+180M | 30种语言+22种汉语方言 | 1200秒(20分钟) | 离线/流式统一 | 轻量高效版 | 端侧设备、高并发服务、边缘计算 |

| Qwen3-ForcedAligner-0.6B | 0.6B+180M | 11种主流语言 | 300秒(5分钟) | 非自回归(NAR) | 高精度时间戳对齐 | 语音标注、字幕制作、语音片段分析 |

(三)训练策略与数据体系

模型采用四阶段训练流程,结合大规模多模态语音数据与专项优化数据:

基座预训练:基于Qwen3-Omni的多模态预训练权重,继承通用语义理解与音频特征提取能力;

语音适配训练:使用千万小时级别的多语言、多方言语音-文本对齐数据,优化声学特征与文本的映射关系;

复杂场景增强:加入噪声语音、远场语音、歌唱语音、压缩音频、方言混读等专项数据,提升鲁棒性;

对齐任务微调:针对强制对齐模型,使用高精度时间戳标注数据,优化非自回归时间戳预测能力。

训练数据中,中文与英语数据占主导,同时包含35%的多语言数据、30%的复杂场景功能数据,确保模型在通用场景与特殊场景下的均衡表现。

(四)推理优化技术

动态注意力窗口:根据推理模式自动调整注意力范围,流式模式使用短窗口降低延迟,离线模式使用长窗口保留上下文信息;

vLLM适配优化:支持PagedAttention技术,提升显存利用率与批量推理速度,支持高并发请求处理;

音频预处理自动化:原生支持16kHz单声道音频自动重采样,兼容mp3、wav、m4a、mp4、mov、mkv等音视频格式,无需用户手动格式转换;

结果后处理:内置幻觉内容过滤、重复文本剔除、标点符号自动补全、格式规范化能力,提升转写文本的可用性。

(五)性能基准表现

通用语音识别:在LibriSpeech、GigaSpeech、WenetSpeech等权威开源 benchmark 上,1.7B模型词错误率(WER)优于所有同规模开源ASR模型,0.6B模型在小参数量模型中排名前列;

汉语方言识别:在粤语、22种地域方言测试集上,模型精度断层领先同类开源方案,部分场景超越闭源商用API;

口音英语识别:覆盖16种国家与地区英语口音,测试集词错误率低于商用API与主流开源模型;

强制对齐:在时间戳精度测试中,各项指标优于MFA、NFA、WhisperX,支持更细粒度、更灵活的对齐输出。

四、应用场景

(一)内容创作与媒体处理

音视频字幕生成:为短视频、影视剧、播客、网课、直播自动生成文本转写与SRT格式字幕,支持歌唱语音、多语言混读内容的字幕制作,大幅提升内容生产效率;

语音内容二次创作:将访谈、演讲、有声书、播客的语音转写为文本,用于文案整理、内容摘要、关键词提取、文本剪辑再创作;

音乐内容分析:提取歌曲歌词、翻唱内容转写,适配音乐平台、短视频创作者的歌词自动匹配需求。

(二)企业办公与协作

会议实时转写:线下/线上会议流式转写,实时生成会议纪要,支持多语言参会者发言识别,兼容会议室远场录音、网络电话音频;

口述文档整理:支持律师、医生、记者、研究员的口述内容转写,替代手动打字,提升工作效率;

客服语音质检:电话客服、在线语音客服的通话录音批量转写,结合关键词提取、语义分析完成服务质量检测、合规核查。

(三)教育与学习场景

在线教育字幕:网课、外教课程、多语言教学视频的字幕生成,帮助学生理解内容,适配听力障碍用户;

语言学习辅助:外语、方言发音对比、口语练习转写,帮助学习者纠正发音、核对表达准确性;

课堂内容记录:教室录音转写,生成课堂笔记,方便学生复习与知识点梳理。

(四)司法与公共服务

语音证据处理:执法记录仪、监控录音、庭审音频的高保真转写,输出精准文本与时间戳,作为司法证据辅助材料;

政务语音服务:政务热线、便民服务语音的转写与归档,提升公共服务记录的规范化与可追溯性;

档案数字化:老旧语音档案、口述历史录音的批量转写,实现语音资料的文本化存储与检索。

(五)智能硬件与端侧应用

实时语音助手:手机、智能音箱、车载设备、翻译机的端侧语音识别,无需联网即可完成转写,保护隐私;

录音笔配套软件:专业录音笔的本地转写功能,提升设备核心竞争力;

嵌入式设备:工业语音控制、无障碍辅助设备的语音指令识别,适配低算力硬件环境。

(六)科研与数据标注

语音算法研究:科研人员基于开源权重研究多语言语音识别、方言处理、强制对齐算法,推动语音技术学术发展;

语音数据集构建:利用强制对齐模型快速生成大规模语音-文本-时间戳标注数据,降低数据集制作成本,提升标注精度。

五、使用方法

(一)环境准备

基础环境要求:Python 3.8及以上版本,支持Linux、macOS、Windows系统;推荐使用CUDA 11.7及以上版本的NVIDIA显卡加速推理,无GPU环境可使用CPU推理(速度较慢)。

依赖工具安装:需提前安装FFmpeg,用于音视频格式解析与重采样,Ubuntu/Debian系统执行

sudo apt update && sudo apt install ffmpeg,macOS执行brew install ffmpeg,Windows从FFmpeg官网下载后添加至系统PATH。项目克隆与依赖安装:

# 克隆官方仓库 git clone https://github.com/QwenLM/Qwen3-ASR.git cd Qwen3-ASR # 安装核心依赖 pip install -r requirements.txt # 如需vLLM高性能推理,额外安装 pip install vllm

(二)模型获取

支持从ModelScope(国内优先)、Hugging Face下载模型权重,提供命令行一键下载方式:

ModelScope下载(以1.7B模型为例):

modelscope download --model Qwen/Qwen3-ASR-1.7B --local_dir ./models/Qwen3-ASR-1.7B

Hugging Face下载(以0.6B模型为例):

huggingface-cli download Qwen/Qwen3-ASR-0.6B --local_dir ./models/Qwen3-ASR-0.6B

强制对齐模型下载:

modelscope download --model Qwen/Qwen3-ForcedAligner-0.6B --local_dir ./models/Qwen3-ForcedAligner-0.6B

(三)基础离线推理

使用transformers原生接口进行单音频转写,核心代码示例:

from qwen_asr import QwenASRInference

# 初始化推理器

inferencer = QwenASRInference(

model_path="./models/Qwen3-ASR-1.7B",

device="cuda" # CPU环境设为"cpu"

)

# 音频转写

result = inferencer.transcribe(

audio_path="./test.wav",

language="auto", # 自动识别语言,也可指定zh/en/yue等

stream=False # 离线推理设为False

)

# 输出结果

print("转写文本:", result["text"])

print("语言类型:", result["language"])(四)流式推理

实时音频流转写代码示例,适配麦克风输入、实时流数据:

from qwen_asr import QwenASRStreamInference

# 初始化流式推理器

stream_infer = QwenASRStreamInference(

model_path="./models/Qwen3-ASR-0.6B",

device="cuda"

)

# 模拟流式分块输入(每块2秒音频)

for chunk in audio_chunks:

segment_result = stream_infer.infer_chunk(chunk)

print("实时转写:", segment_result["text"])

# 结束流,获取完整结果

final_result = stream_infer.finish()(五)语音-文本强制对齐

使用ForcedAligner生成时间戳,核心代码示例:

from qwen_asr import QwenForcedAligner

aligner = QwenForcedAligner(

model_path="./models/Qwen3-ForcedAligner-0.6B",

device="cuda"

)

# 输入音频与对应文本,生成时间戳

align_result = aligner.align(

audio_path="./test.wav",

text="需要对齐的文本内容",

language="zh"

)

# 输出字/词级时间戳

print("时间戳结果:", align_result["timestamps"])(六)Web Demo本地启动

项目内置Gradio可视化界面,一键启动本地演示,支持网页端上传音频、实时录音、查看转写与对齐结果:

python examples/gradio_demo.py

启动后访问本地http://127.0.0.1:7860即可使用。

(七)Docker容器化部署

使用项目提供的Docker配置快速构建部署环境,避免环境依赖冲突:

# 构建镜像 docker build -t qwen3-asr ./docker # 启动容器,挂载模型与音频目录 docker run -it --gpus all -v ./models:/app/models -v ./audio:/app/audio -p 7860:7860 qwen3-asr

(八)模型微调

使用项目finetuning/目录下的脚本进行自定义微调,步骤为:数据格式转换→配置微调参数→启动训练→模型导出,支持全参数微调与LoRA轻量微调,适配小样本垂直场景优化,详细配置参考项目finetuning/README.md文档。

(九)云端API调用

国内用户可通过阿里云DashScope平台调用Qwen3-ASR云端API,无需本地部署,适合无GPU、快速接入的场景,需申请API Key,通过HTTP或SDK调用,支持长音频异步处理、批量转写。

六、常见问题解答

无GPU环境能否运行模型?

可以运行,将设备参数设置为cpu即可完成推理,但CPU推理速度远低于GPU,1.7B模型不建议在CPU上处理长音频,仅适合短音频测试;轻量0.6B模型在主流CPU上可完成短音频基础转写,长音频建议使用GPU或云端API。

支持哪些音频格式,出现格式报错如何处理?

原生支持wav、mp3、m4a、flac等音频格式,以及mp4、mov、mkv等视频格式的音频轨道提取;出现格式报错通常是FFmpeg未安装或未配置系统PATH,重新安装FFmpeg并确认终端可直接调用ffmpeg命令即可解决,无需修改代码。

方言识别精度不理想如何优化?

首先确认音频质量,避免严重失真、强噪音的录音;其次可指定具体方言标签(如yue代表粤语),而非使用auto自动识别;专业方言场景可收集少量标注数据,通过LoRA微调提升精度;也可通过上下文提示词加入方言常用词汇,增强模型识别效果。

流式推理出现延迟高、结果不连贯的问题?

优先使用0.6B轻量模型,降低算力压力;确保GPU显存充足,避免显存不足导致的推理卡顿;音频分块大小设置为2秒,与模型最优分块规格匹配;关闭不必要的后处理功能,提升实时响应速度。

强制对齐模型时间戳偏移较大如何调整?

确保输入的文本与音频内容完全一致,无增删、修改、错别字;优先使用清晰的人声音频,避免强背景音乐、多人混响;指定正确的语言类型,避免跨语言误识别;长音频可按自然语句分段对齐,提升单段精度。

模型下载速度慢、中断如何解决?

国内用户优先使用ModelScope下载,相比Hugging Face速度更稳定;使用命令行下载工具的断点续传参数(ModelScope与huggingface-cli均原生支持),中断后重新执行命令即可继续下载;也可手动从平台网页下载权重文件,放置到指定目录。

显存不足无法加载模型怎么办?

使用0.6B轻量模型替代1.7B模型,降低显存占用;开启量化推理(支持8bit、4bit量化),在QwenASRInference初始化时设置load_in_8bit=True;使用vLLM引擎,其显存管理效率高于原生transformers;清理系统显存占用,关闭其他GPU进程。

转写结果出现无意义文本、重复内容如何处理?

开启项目内置的后处理功能,自动过滤幻觉内容与重复文本;降低音频噪声,使用降噪工具预处理音频;指定明确的语言类型,避免auto模式下的语言误判导致的结果异常;专业场景可加入领域提示词,引导模型输出规范文本。

如何批量处理大量音频文件?

编写循环脚本遍历音频目录,调用transcribe接口批量处理;使用vLLM批量推理接口,提升并发处理速度;使用项目提供的Qwen3-ASR-Toolkit工具,支持多线程并行处理,自动完成长音频分段与结果合并。

七、相关链接

GitHub主仓库(核心代码、文档、使用指南):https://github.com/QwenLM/Qwen3-ASR

技术报告(完整技术细节、性能测试、架构说明):https://arxiv.org/abs/2601.21337

ModelScope模型集合(国内快速下载全部模型权重):https://modelscope.cn/collections/Qwen/Qwen3-ASR

Hugging Face模型集合(国际平台模型权重):https://huggingface.co/collections/Qwen/qwen3-asr

配套工具仓库(长音频处理、多语言工具集):https://github.com/QwenLM/Qwen3-ASR-Toolkit

八、总结

Qwen3-ASR是阿里云通义千问团队打造的工业化级开源语音识别与强制对齐解决方案,以三大核心模型为基础,凭借52种语言与方言覆盖、流式离线统一推理、歌唱语音识别、高精度时间戳对齐、高并发高效推理的核心能力,在开源ASR领域实现了性能与实用性的双重突破,既拥有对标闭源商用API的精度水平,又提供完整开源代码、模型权重与部署方案,降低了多语言语音技术的使用与研发门槛,可直接适配内容创作、企业办公、教育学习、司法服务、智能硬件、科研标注等全场景需求,同时支持自定义微调与私有化部署,兼顾普惠性与定制化能力,是当前开源生态中最全面、最具落地价值的语音识别工具集之一。

版权及免责申明:本文由@AI工具箱原创发布。该文章观点仅代表作者本人,不代表本站立场。本站不承担任何相关法律责任。

如若转载,请注明出处:https://www.aipuzi.cn/ai-news/qwen3-asr.html