Trusted MCP:火山引擎推出的可信模型上下文协议,强化组件身份验证与端到端通信安全

一、Trusted MCP是什么?

Trusted MCP(Trusted Model Context Protocol,可信模型上下文协议)是火山引擎推出的开源项目,其核心是在标准MCP协议基础上,为AI服务组件间的通信增加“信任机制”。

标准MCP协议是AI领域用于模型上下文交互的通用规范,就像“AI组件对话的语法规则”,确保不同组件(如调用方Client、服务提供方Server、协调方Host)能顺畅交换信息。但标准MCP未解决“对话双方是否可信”“对话内容是否被篡改”等安全问题——比如,恶意组件可能伪装成合法Server骗取数据,或拦截传输中的指令进行篡改。

Trusted MCP的作用,就是给这套“语法规则”加上“安全补丁”:通过身份验证让组件证明“我是谁”,通过加密技术让对话“只有双方能懂”,通过远程证明(在机密环境中)确保“对方运行在安全环境中”。简单说,它让AI组件间的通信从“裸聊”变成“加密且验明身份的对话”,从根本上防范身份伪造、数据泄露、流量劫持等风险。

二、功能特色

Trusted MCP的核心价值在于对标准MCP的“安全增强”和“场景适配”,具体特色如下:

1. 组件身份双向验真,杜绝“冒名顶替”

所有参与通信的组件(Client、Server)必须通过“公私钥签名”证明身份:

Server启动时会用自己的私钥生成“身份证书”,Client通过预存的Server公钥验证证书合法性,确认“对方确实是我要找的Server”;

反之,Client也会向Server提交身份证明,避免恶意Client伪造请求。

这种“双向验证”机制,从源头杜绝了恶意组件伪装成合法角色混入通信的风险。

2. 端到端数据加密,防止“窃听篡改”

通信过程中,所有数据(包括请求指令、模型响应、上下文信息)会经过两层保护:

传输加密:用AES-256对称加密算法对数据加密,只有通信双方持有会话密钥才能解密,即使被第三方拦截也无法读取内容;

完整性校验:每条消息都会附加“数字指纹”(SHA-256哈希值),接收方通过比对指纹确认数据未被篡改(比如恶意修改模型返回结果)。

3. 双环境部署,兼顾“灵活与安全”

Trusted MCP支持两种部署模式,满足不同场景的安全需求,具体对比如下表:

| 部署环境 | 核心安全能力 | 性能影响 | 适用场景 |

|---|---|---|---|

| 普通环境 | 身份验证+数据加密+完整性校验 | 微乎其微(毫秒级) | 开发调试、内部测试、非敏感场景 |

| 机密计算环境 | 普通环境能力+远程证明验证 | 首次连接延迟1-2秒,后续无影响 | 生产环境、医疗/金融等敏感数据处理 |

表:Trusted MCP部署环境对比

其中,“远程证明”是机密环境的核心增强:它能验证通信对端是否运行在“可信机密计算环境”(如火山引擎AICC平台)中——简单说,就是确认对方的硬件和软件未被篡改,从底层确保服务“本身是安全的”。

4. 低代码集成,兼容“现有MCP应用”

开发者无需重构现有基于MCP的代码,仅需替换少量初始化逻辑即可启用Trusted MCP。例如,原MCP代码中用FastMCP创建服务,替换为TrustedMCP类后,所有安全功能会自动生效,学习成本极低。

5. 深度适配火山生态,降低“落地门槛”

与火山引擎AICC(机密计算平台)、火山方舟(大模型服务平台)无缝对接:

可直接调用火山方舟的大模型API,无需额外开发适配逻辑;

在火山AICC环境中部署时,远程证明验证可直接复用平台的可信基础设施,无需自建验证服务。

三、技术细节

Trusted MCP的安全能力基于成熟的密码学和机密计算技术实现,核心技术逻辑如下:

1. 身份验证:公私钥体系如何“验明正身”?

采用RSA 4096位非对称加密算法实现身份验证,流程如下:

密钥生成:每个组件(Client/Server)生成一对公私钥——私钥像“身份证原件”,必须本地安全存储(如加密硬盘、密钥管理服务);公钥像“身份证复印件”,可公开给通信对端。

签名与验证:组件发送消息时,会用私钥对“身份信息(如服务名称、版本)+ 消息内容”进行签名;接收方用对端的公钥解密签名,若解密结果与消息内容一致,则确认身份合法。

这种机制的核心优势是:公钥无法伪造私钥签名,因此只要公钥是可信的(如预先通过安全渠道获取),就能100%确认对端身份。

2. 数据传输安全:加密与校验如何“双保险”?

数据从发送到接收需经过3个步骤:

会话密钥协商:通信建立初期,Client和Server用RSA算法交换“临时密钥”,最终协商出一个对称会话密钥(AES-256密钥)——这个过程中,即使临时密钥被拦截,第三方也无法破解会话密钥;

数据加密:用会话密钥对实际数据(如用户提问、模型回答)加密,生成“密文”;

完整性校验:对密文计算SHA-256哈希值(“数字指纹”),并将密文和哈希值一起发送。

接收方收到后,先比对哈希值确认密文未被篡改,再用会话密钥解密得到原始数据,确保“内容真实且只有自己能懂”。

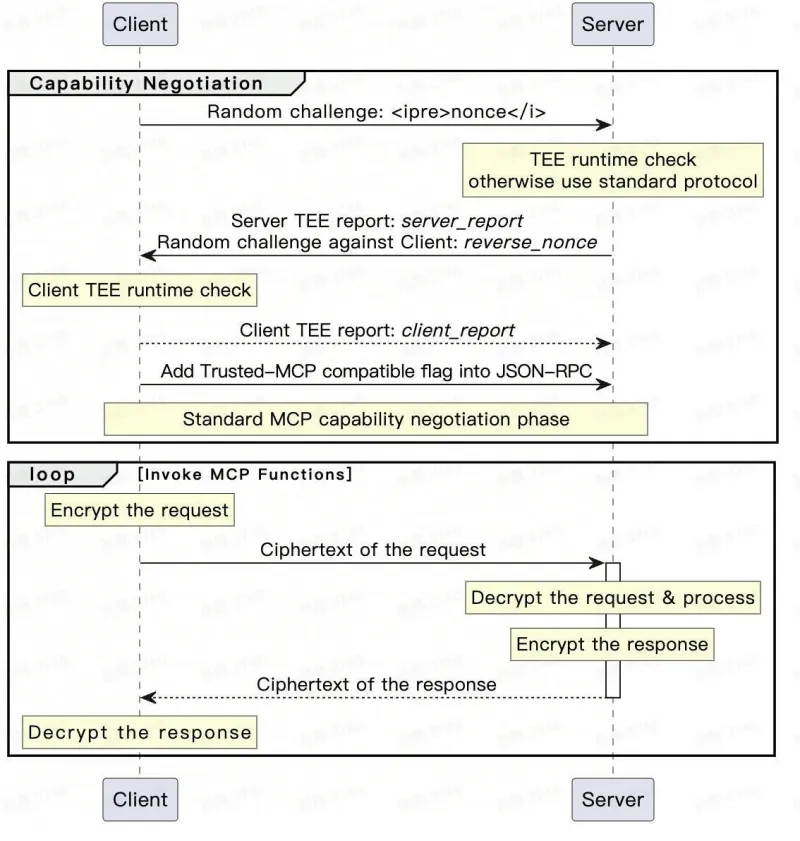

3. 远程证明(机密环境):如何确认“对方在安全环境中”?

在火山引擎AICC等机密计算环境中,Trusted MCP通过“远程证明”验证对端环境的可信度,流程如下:

Server生成证明:运行在机密环境中的Server,会向环境的硬件安全模块(如Intel SGX的Enclave)请求“证明报告”,报告包含:硬件厂商签名(证明硬件可信)、Server代码哈希(证明代码未被篡改)、环境配置信息(如内存加密状态);

Client验证证明:Client收到报告后,通过火山引擎AICC的“验证服务”(第三方可信机构)确认报告合法性——若验证通过,说明Server确实运行在“未被篡改的机密环境”中,可安全通信;若未通过,则拒绝连接。

这种机制从硬件层确保Server的运行环境“干净”,即使Server被恶意攻击,攻击者也无法获取内存中的敏感数据(如会话密钥、用户隐私)。

4. 代码架构:核心模块如何分工?

项目代码结构清晰,核心模块如下:

bytedance/jeddak_trusted_mcp/:主模块,包含TrustedMCP类,封装了身份验证、安全通道创建等核心逻辑,是开发者直接调用的入口;bytedance/jeddak_secure_channel/:安全通道模块,实现会话密钥协商、数据加解密、哈希校验等功能,是通信安全的“执行层”;bytedance/tks/:密钥管理模块,负责加载公私钥、存储会话密钥,支持与火山KMS(密钥管理服务)集成;demo/:示例代码目录,包含普通环境(server.py/local_client.py)和机密环境(aicc_server.py/aicc_client.py)的可运行案例,方便开发者快速上手。

四、应用场景

Trusted MCP适用于所有基于MCP协议的AI交互场景,尤其在以下场景中能发挥核心价值:

1. 大模型服务调用:保护用户隐私与服务可信性

当用户通过Client调用第三方大模型Server时(如调用火山方舟的豆包大模型),Trusted MCP可解决三大问题:

防止“钓鱼Server”:用户Client通过身份验证确认对接的是官方Server,避免被伪造服务骗取提问内容;

保护“敏感提问”:用户的医疗咨询、金融决策等隐私问题经加密传输,即使传输链路被监控,第三方也无法解密;

确保“结果真实”:模型返回的回答经完整性校验,避免被恶意篡改(如修改投资建议、诊断结果)。

2. 多智能体协作:防止恶意智能体混入系统

在多智能体系统中(如企业内部的客服智能体、数据分析智能体、审批智能体协同工作),Trusted MCP可:

验证每个智能体的身份(如“客服智能体A”“数据分析智能体B”),防止未授权智能体接入;

加密智能体间的交互数据(如用户投诉内容、分析结果),避免敏感信息在内部流转时泄露;

确保指令传达准确(如“审批通过”指令未被篡改),保障业务流程可靠。

3. 敏感行业AI服务:满足合规与隐私保护要求

在医疗、金融、政务等对数据安全要求极高的行业:

医疗场景:患者病历数据在AI诊断系统(Server)与医院Client间加密传输,且Server运行在机密环境中,符合《个人信息保护法》对医疗数据的保护要求;

金融场景:用户交易数据在AI风控模型(Server)与银行Client间传输时,通过远程证明确保模型运行环境未被篡改,避免风控规则被恶意绕过;

政务场景:企业申报数据在AI审核系统与政务平台间加密交互,防止数据泄露或被篡改,保障政务流程公正。

4. 跨组织AI能力共享:安全对接外部服务

当企业需要调用外部合作伙伴的AI能力(如第三方的图像识别、自然语言处理服务)时,Trusted MCP可:

通过身份验证确认合作方的合法性(避免对接“假服务”);

加密传输企业的业务数据(如待识别的图像、待分析的文本),防止商业机密泄露;

验证合作方服务的运行环境(通过远程证明),确保其AI模型未被植入恶意逻辑(如窃取数据的后门)。

五、使用方法

Trusted MCP基于Python开发,推荐使用uv(高性能Python包管理工具)管理环境,以下是详细使用步骤:

1. 环境准备

安装Python 3.11及以上版本(需支持机密计算相关库的编译);

安装

uv# 适用于Linux/macOS,Windows可参考uv官方文档 curl -LsSf https://astral.sh/uv/install.sh | sh

克隆项目代码:

git clone https://github.com/volcengine/AICC-Trusted-MCP.git cd AICC-Trusted-MCP

2. 编译与安装SDK

Trusted MCP提供Python SDK,可通过uv编译安装:

# 编译SDK(生成dist目录下的安装包) uv build # 安装SDK到当前环境 uv add bytedance_jeddak_trusted_mcp # 或直接通过uv sync一键完成依赖安装和SDK编译(推荐) uv sync

3. 代码集成:从标准MCP迁移到Trusted MCP

只需替换服务初始化代码,原有业务逻辑(如发送请求、处理响应)无需修改,示例如下:

| 标准MCP代码(不安全) | Trusted MCP代码(安全增强) |

|---|---|

python<br># 导入标准MCP模块<br>from mcp.server.fastmcp import FastMCP<br># 创建普通服务<br>mcp_server = FastMCP(name="医疗诊断服务")<br># 定义接口(示例)<br>@mcp_server.endpoint("diagnose")<br>def diagnose(medical_record: str):<br> return ai_model.analyze(medical_record)<br> | python<br># 导入Trusted MCP模块<br>from bytedance.jeddak_trusted_mcp import TrustedMCP<br># 创建可信服务(自动启用身份验证和加密)<br>trusted_server = TrustedMCP(name="医疗诊断服务")<br># 接口定义完全不变<br>@trusted_server.endpoint("diagnose")<br>def diagnose(medical_record: str):<br> return ai_model.analyze(medical_record)<br> |

表:标准MCP与Trusted MCP代码对比

4. 部署与运行

根据场景选择部署环境,以下是两种环境的详细步骤:

(1)普通环境部署(开发调试用)

适合功能验证、内部测试等非敏感场景,无需依赖机密计算资源。

生成密钥对(每个组件需独立密钥):

# 生成Server私钥(保存到本地,权限设置为仅当前用户可读写) openssl genrsa -out ./server_private.pem 4096 # 从Server私钥导出公钥(提供给Client验证身份) openssl rsa -pubout -in ./server_private.pem -out ./server_public.pem # 生成Client私钥和公钥(步骤同上) openssl genrsa -out ./client_private.pem 4096 openssl rsa -pubout -in ./client_private.pem -out ./client_public.pem

启动Server:

# 配置说明: # --private-key:Server私钥路径 # --public-key-path:Client公钥路径(用于验证Client身份) # --host/--port:服务地址和端口 uv run python demo/server.py \ --private-key ./server_private.pem \ --public-key-path ./client_public.pem \ --host 0.0.0.0 --port 8000

启动Client:

# 配置说明: # --server-url:Server地址 # --private-key:Client私钥路径 # --server-public-key:Server公钥路径(用于验证Server身份) # 若需调用火山方舟大模型,需设置API密钥 export LLM_API_KEY="your_volc_ark_api_key" uv run python demo/local_client.py \ --server-url http://127.0.0.1:8000/mcp \ --private-key ./client_private.pem \ --server-public-key ./server_public.pem

测试通信:Client启动后,输入测试消息(如“患者发烧38度,咳嗽”),若Server返回加密处理后的响应,说明部署成功。

(2)机密计算环境部署(生产环境用)

需依赖火山引擎AICC平台(提供机密计算实例),适合处理敏感数据。

准备火山资源:

demo/server_config.json(Server配置):{ "instance_id": "your_aicc_instance_id", "ak": "your_access_key", "sk": "your_secret_key", "region": "cn-beijing", "port": 8000 }demo/client_config.json(Client配置):{ "server_instance_id": "your_aicc_instance_id", // 需与Server实例ID一致 "ak": "your_access_key", "sk": "your_secret_key", "region": "cn-beijing", "server_url": "http://your_server_ip:8000/mcp" }登录火山引擎控制台,开通AICC服务并创建机密计算实例(参考火山AICC文档);

获取实例信息:实例ID、AK(访问密钥)、SK(密钥)、区域(如cn-beijing);

准备配置文件:

在AICC实例中启动Server:

# 需在火山AICC实例内部运行,读取server_config.json uv run python demo/aicc_server.py --config ./demo/server_config.json

启动Client(可在本地或其他环境):

# 配置火山方舟API密钥(若需调用大模型) export LLM_API_KEY="your_volc_ark_api_key" # 读取client_config.json,自动验证Server的机密环境 uv run python demo/aicc_client.py --config ./demo/client_config.json

验证远程证明:Client启动后,会自动向火山AICC验证服务请求验证Server的环境,若输出“远程证明验证通过”,则表示通信双方均处于可信环境,可安全传输敏感数据。

六、常见问题解答(FAQ)

Trusted MCP会影响原有MCP应用的性能吗?

影响极小。普通环境中,加密和签名操作仅增加毫秒级延迟,对用户体验无感知;机密环境中,首次连接因远程证明会增加1-2秒延迟,但后续通信性能与普通环境一致,适合生产场景。

如何确保公私钥的安全性?

开发环境可临时用本地文件存储密钥,但生产环境必须使用密钥管理服务(如火山引擎KMS):私钥存储在KMS中,调用时通过API临时获取,避免本地文件泄露风险。

普通环境和机密环境的代码能复用吗?

完全可以。两种环境的业务逻辑代码(如接口定义、数据处理)完全一致,仅配置文件和启动参数不同,便于开发环境到生产环境的无缝迁移。

除了火山方舟,Trusted MCP支持其他大模型平台吗?

支持。Trusted MCP的核心是通信安全,与具体大模型平台无关,只需在Client中修改模型调用的API地址和参数,即可对接其他平台(如OpenAI、阿里云灵积等)。

远程证明失败可能是什么原因?

常见原因包括:Server未运行在火山AICC实例中、实例ID或AK/SK配置错误、实例已过期或被篡改。可通过火山引擎控制台检查实例状态,或查看Client日志中的具体错误信息。

项目的开源许可证是什么?允许商业使用吗?

采用MIT许可证,允许免费使用、修改和商业分发,只需保留原始版权声明和许可证文件,无商业使用限制。

七、相关链接

八、总结

Trusted MCP是火山引擎为解决AI组件通信安全问题推出的开源方案,通过扩展标准MCP协议,提供身份双向验证、端到端数据加密、远程证明等核心能力,可有效防范身份伪造、数据篡改、隐私泄露等风险。它支持普通环境与机密计算环境部署,集成简单且兼容现有MCP应用,适用于大模型服务调用、多智能体协作、敏感行业数据处理等场景。依托火山引擎生态,该项目为AI通信安全提供了实用、低成本的解决方案,且基于MIT许可证开源,便于开发者自由使用和二次开发。

版权及免责申明:本文由@AI工具箱原创发布。该文章观点仅代表作者本人,不代表本站立场。本站不承担任何相关法律责任。

如若转载,请注明出处:https://www.aipuzi.cn/ai-news/trusted-mcp.html