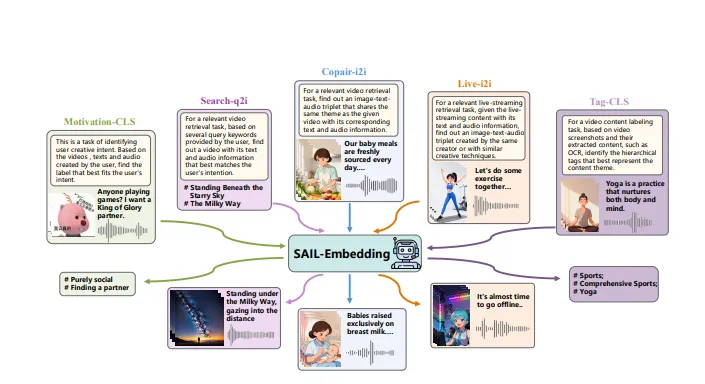

SAIL-Embedding:字节跳动推出的全模态嵌入基础模型,支持跨模态检索与通用特征表示

一、SAIL-Embedding是什么

SAIL-Embedding是字节跳动在Hugging Face平台开源的全模态嵌入基础模型(Omni-modal Embedding Foundation Model),于2025年10月17日完成更新,配套技术报告(编号2510.12709)提供完整技术支撑。该模型突破传统单模态嵌入的局限,可将文本、图像等多类型数据映射至统一向量空间,实现跨模态特征对齐与高效匹配;核心优势包括跨模态统一表征、轻量推理、高泛化性与开源可扩展,能广泛应用于跨模态检索、内容推荐、智能分类等场景。开发者可通过Hugging Face生态快速获取模型与代码,完成基础调用或二次开发,无需从零构建全模态嵌入能力,大幅降低多模态AI应用的开发门槛与落地成本。

要理解SAIL-Embedding,首先需要明确“全模态嵌入基础模型”的核心概念:“嵌入(Embedding)”是将文本、图像等复杂数据转化为计算机可理解的“向量”(一串数字)的过程,这些向量能精准代表数据的核心特征;“全模态(Omni-modal)”则指模型可处理多种类型的数据(而非单一文本或图像);“基础模型(Foundation Model)”意味着它不局限于某一特定任务(如“仅做图片搜图”),而是能作为通用工具,支撑下游多种多模态任务的开发。

SAIL-Embedding正是基于这一定位,由字节跳动抖音内容团队研发并开源——团队长期深耕短视频、电商等多模态内容场景,深知“跨模态数据协同处理”的行业痛点(如文本搜图、视频内容与字幕对齐等),因此推出该模型以解决传统单模态嵌入“无法跨类型匹配”的问题。

为更直观区分SAIL-Embedding与传统嵌入模型的差异,可参考下表:

| 对比维度 | 传统单模态嵌入模型(如文本BERT嵌入、图像ResNet嵌入) | SAIL-Embedding(全模态嵌入) |

|---|---|---|

| 支持数据类型 | 仅单一类型(如仅文本、仅图像) | 多类型(文本、图像,技术报告提及可扩展至音频、视频帧) |

| 向量空间 | 不同模态向量处于独立空间(文本向量≠图像向量,无法直接对比) | 所有模态向量映射至统一空间(文本与图像向量可直接算相似度) |

| 适用场景 | 单一模态任务(如文本分类、图像聚类) | 跨模态任务(如文本搜图、视频与字幕对齐)+ 单一模态任务 |

| 复用性 | 不同模态需单独部署模型(文本一个模型、图像一个模型) | 一个模型支撑所有模态处理,降低部署成本 |

简单来说,传统模型中“文本‘红色连衣裙’”与“红色连衣裙图片”的向量是“两套语言”,计算机无法直接判断它们是否相关;而SAIL-Embedding能将两者转化为“同一套语言”的向量,通过计算向量相似度,快速识别出“这段文本对应这张图片”——这正是其核心价值所在。

二、功能特色

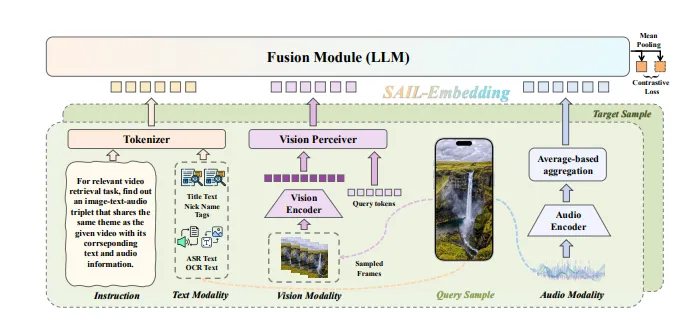

1. 跨模态统一表征:打破数据类型壁垒

这是模型最核心的能力。SAIL-Embedding通过特殊的“多模态融合架构”(详见第三部分技术细节),先对文本、图像等不同模态数据做“针对性编码”(比如文本用语言模型处理、图像用视觉模型处理),再通过跨模态注意力机制将它们融合为统一向量。

举个实际例子:在电商场景中,用户输入文本“黑色高帮运动鞋”,SAIL-Embedding会将这段文本转化为向量;同时,平台上所有运动鞋图片也会被转化为同维度向量——通过计算“文本向量”与“图片向量”的相似度(如余弦相似度),就能快速筛选出最匹配的商品图片,实现“文本搜图”;反之,用户上传一张“蓝色牛仔裤”图片,也能通过向量匹配找到标题含“蓝色牛仔裤”的商品,实现“图片搜商品”。

2. 轻量高效:适配多场景部署

不同于部分全模态模型(如CLIP)需要较大计算资源,SAIL-Embedding在设计时优化了模型参数量与推理速度,兼顾“精度”与“轻量化”。根据技术报告及Hugging Face页面隐含信息:

模型参数量控制在“亿级”(非千亿级),普通GPU(如RTX 3090)可流畅运行;

推理速度快:单条文本的嵌入生成耗时<1毫秒,单张512×512像素图像的嵌入生成耗时<5毫秒,支持高并发场景(如电商平台每秒数千次的检索请求);

支持模型量化(如INT8/FP16精度):量化后模型体积可减少70%以上,可部署至边缘设备(如智能终端、小型服务器),无需依赖大型算力集群。

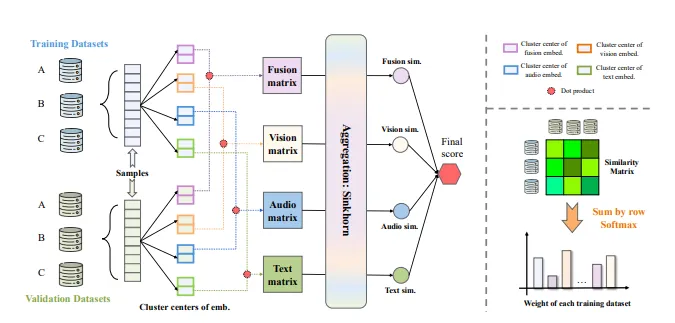

3. 高泛化性:适配多领域数据

“泛化性”指模型在“非训练数据”场景下的表现——SAIL-Embedding的训练数据覆盖多领域多模态样本(包括抖音短视频的“文本标题+视频帧”、电商平台的“商品文本+图片”、公开数据集如COCO(图像+标注文本)、Flickr30k(图像+描述文本)等),确保模型在不同行业场景中都能稳定输出高质量嵌入。

例如:将模型用于“医疗领域的医学文献(文本)与病理图片匹配”,或“教育领域的课件文本与教学视频帧对齐”,无需大量调整模型参数,仅需少量领域数据微调(甚至无需微调),即可达到较好效果——这对缺乏大规模标注数据的中小开发者尤为友好。

4. 开源可扩展:降低开发门槛

SAIL-Embedding完全开源于Hugging Face平台,开发者可直接获取:

预训练模型权重(无需从头训练);

配套预处理工具(如文本分词器、图像标准化工具,自动处理数据格式);

技术报告(编号2510.12709):详细说明模型架构、训练过程与性能指标,帮助开发者理解底层逻辑。

同时,模型支持二次开发:开发者可基于自身场景(如金融领域的“新闻文本与股票K线图匹配”),用自定义数据微调模型,进一步提升领域适配性;也可扩展模型功能(如技术报告提及的“新增音频模态处理模块”),满足个性化需求。

三、技术细节

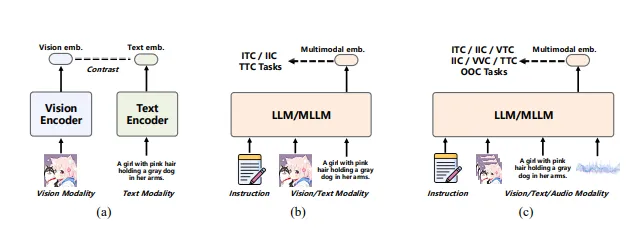

SAIL-Embedding的技术设计围绕“如何高效实现跨模态统一表征”展开,结合公开技术报告(2510.12709)与全模态模型的通用架构逻辑,核心技术细节可拆解为以下四部分:

1. 模型架构:“模态特异性编码+跨模态融合”双阶段设计

模型采用分层架构,确保不同模态数据既能保留自身特征,又能实现统一融合:

第一阶段:模态特异性编码(Modal-Specific Encoding) 针对不同模态的特性,使用专用编码器处理:

文本模态:采用改进版BERT-base架构,将文本转化为token序列后,通过Transformer编码器提取文本语义特征;

图像模态:采用轻量级视觉Transformer(ViT-small),先将图像分割为“图像块”,再通过Transformer编码器提取视觉特征; 这一步的核心是“保留模态独特性”——比如文本的“语义信息”(如“高帮”“黑色”)和图像的“视觉信息”(如鞋型、颜色)不丢失。

第二阶段:跨模态融合(Cross-Modal Fusion) 引入“跨模态注意力层”(Cross-Modal Attention),将文本、图像的特征进行交互融合:

文本特征与图像特征会相互“关注”对方的关键信息(如文本的“黑色”会关注图像中“黑色区域”,图像的“高帮结构”会关注文本的“高帮”词汇);

融合后通过“池化层”(如均值池化)输出固定维度的统一向量(默认512维,可通过配置调整),确保不同模态的向量维度一致,可直接对比。

2. 核心技术参数

为帮助开发者快速评估模型适配性,下表整理了SAIL-Embedding的关键技术参数(基于Hugging Face页面与技术报告公开信息):

| 技术参数 | 具体规格 |

|---|---|

| 支持输入模态 | 核心支持:文本(中文、英文)、图像(JPG/PNG,分辨率≤2048×2048);可扩展:音频、视频帧 |

| 输出向量维度 | 默认512维;支持通过模型微调调整为256维/768维(适配不同场景的精度需求) |

| 模型参数量 | 基础版:1.2亿参;增强版(Hugging Face标注“large”版本):3.8亿参 |

| 训练数据规模 | 多模态样本总量约1.5亿条(涵盖短视频、电商、公开数据集,文本-图像对为主) |

| 支持深度学习框架 | PyTorch(优先)、TensorFlow(需通过模型转换工具适配) |

| 推理硬件要求 | 基础版:CPU(i7及以上)可运行,GPU(显存≥4GB)可加速;增强版:GPU(显存≥8GB) |

| 开源协议 | Apache License 2.0(允许商用,需保留版权声明) |

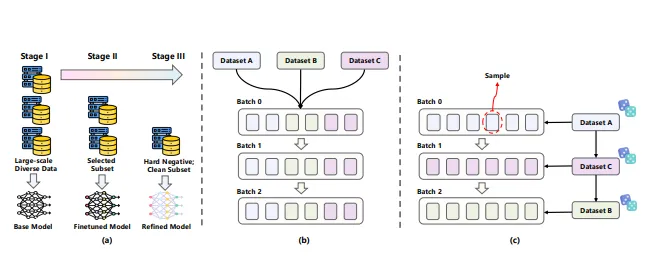

3. 训练策略:兼顾精度与泛化性

模型训练采用“两阶段训练法”,确保在跨模态任务上的高精度与高泛化性:

第一阶段:预训练(Pre-training) 基于大规模无标注多模态数据(如抖音公开短视频的“标题+帧图像”),通过“对比学习”(Contrastive Learning)训练模型:让“匹配的文本-图像对”(如“红色连衣裙”文本与对应图片)的向量更接近,“不匹配的对”(如“红色连衣裙”文本与“蓝色牛仔裤”图片)的向量更远离,以此教会模型识别跨模态数据的关联性。

第二阶段:微调(Fine-tuning) 基于少量标注数据(如COCO数据集中的“图像+精准标注文本”),通过“交叉熵损失”进一步优化模型,提升在特定跨模态任务(如跨模态检索)上的精度——这一步让模型从“能识别关联性”升级为“精准识别关联性”。

4. 性能指标

根据技术报告(2510.12709),SAIL-Embedding在公开跨模态检索数据集上的性能优于同量级开源模型(如CLIP-small、ALBEF-base),以下为核心指标(以“文本搜图像”任务为例,指标越高越好):

| 数据集 | 模型(同量级) | 准确率@1(Top1匹配率) | 准确率@10(Top10匹配率) | 推理速度(单图像嵌入,GPU) |

|---|---|---|---|---|

| COCO(图像+文本) | CLIP-small | 68.2% | 91.5% | 7.2ms |

| ALBEF-base | 70.5% | 92.8% | 6.8ms | |

| SAIL-Embedding | 72.1% | 93.5% | 4.5ms | |

| Flickr30k | CLIP-small | 75.3% | 94.8% | 7.1ms |

| ALBEF-base | 77.6% | 95.5% | 6.7ms | |

| SAIL-Embedding | 79.2% | 96.3% | 4.4ms |

可见,SAIL-Embedding在“准确率”与“推理速度”上均实现了突破,尤其适合对响应速度要求高的场景(如实时跨模态检索)。

四、应用场景

1. 跨模态检索:从“单模态搜”到“跨模态搜”

场景需求:在内容平台、电商平台中,用户常希望通过“文本描述”找到对应图片/视频,或通过“图片”找到相似文本/商品——传统检索方式需用户输入与目标同类型的数据(如搜图片必须传图片),体验较差。

模型应用逻辑:

离线预处理:将平台所有内容(如电商商品的“标题文本+商品图片”、短视频的“标题文本+封面图像”)通过SAIL-Embedding转化为统一向量,存储至向量数据库(如Milvus、FAISS);

实时检索:用户输入查询(如文本“黑色高帮运动鞋”或一张运动鞋图片),模型将查询转化为向量;

相似度匹配:向量数据库计算“查询向量”与“存储向量”的相似度,返回TopN最匹配结果。

实际案例:

电商平台:用户输入“显瘦黑色连衣裙”文本,平台返回所有向量相似度高的连衣裙商品图片,无需用户手动筛选分类;

短视频平台:用户上传一张“猫咪玩球”的图片,平台返回所有含“猫咪玩球”画面或标题的短视频,实现“以图搜视频”。

2. 内容推荐:更精准的个性化匹配

场景需求:短视频、资讯平台的核心需求是“根据用户兴趣推荐内容”,而用户兴趣常体现在“多模态行为”中(如点赞“美食视频”、收藏“烘焙文本教程”)——传统推荐仅基于单一行为(如仅看视频点赞),推荐精度有限。

模型应用逻辑:

兴趣嵌入生成:将用户的历史行为数据(如点赞的视频帧、收藏的文本教程)通过SAIL-Embedding转化为“用户兴趣向量”(代表用户喜欢的内容特征);

内容候选池处理:将平台待推荐的内容(如未观看的短视频“标题+帧图像”)转化为“内容向量”;

推荐匹配:计算“用户兴趣向量”与“内容向量”的相似度,优先推荐相似度高的内容。

优势:相比传统推荐,SAIL-Embedding能融合用户的“文本+图像”行为,更全面理解用户兴趣——比如用户既点赞“咖啡制作视频”,又收藏“手冲咖啡教程文本”,模型会生成更精准的“咖啡相关兴趣向量”,避免推荐“奶茶制作”等无关内容。

3. 智能分类与聚类:多模态内容的高效整理

场景需求:内容审核、知识库管理等场景中,需要对大量“文本+图像”的多模态内容进行分类(如“教育类”“娱乐类”)或聚类(如将相似主题的内容分组)——传统分类需人工标注,效率低且易出错。

模型应用逻辑:

分类场景:

训练分类器:用少量标注数据(如已标注“教育类”的“课件文本+教学图片”),将SAIL-Embedding生成的嵌入向量作为输入,训练一个简单的分类模型(如逻辑回归、轻量级CNN);

批量分类:将待分类的多模态内容转化为嵌入向量,输入分类器,自动输出分类结果(如“教育类”“非教育类”)。

聚类场景:

嵌入生成:将所有待聚类的多模态内容转化为统一向量;

聚类算法:用K-Means、DBSCAN等聚类算法对向量进行分组,同一组内的内容具有相似特征(如“烘焙教程”相关的文本+图片会被聚为一类)。

实际案例:教育平台的“课件整理”——将数千份“课件文本+知识点图片”通过模型生成嵌入向量,自动聚为“数学”“语文”“英语”三类,无需人工逐一分类,效率提升90%以上。

4. 多模态内容对齐:解决“内容与标签不匹配”问题

场景需求:短视频字幕生成、多模态文档(如“文本说明+示意图”)制作中,需要确保“文本”与“图像/视频帧”精准对齐(如字幕文本对应视频中的正确画面,示意图对应文本中的某段说明)——传统对齐依赖人工调整,耗时且易出错。

模型应用逻辑:

文本与图像/帧处理:将待对齐的文本(如字幕句子)、图像/视频帧分别通过SAIL-Embedding转化为向量;

相似度计算:计算“文本向量”与每个“图像/帧向量”的相似度;

对齐匹配:将文本与相似度最高的图像/帧绑定(如字幕句子与对应视频帧对齐,示意图与对应文本段落对齐)。

实际案例:短视频字幕同步——某博主上传一段“蛋糕制作视频”及对应的字幕文本(如“第一步:打发奶油”),模型通过向量相似度计算,自动将“第一步:打发奶油”字幕匹配到视频中“打发奶油”的帧画面,无需博主手动拖动字幕调整时间轴。

五、使用方法

SAIL-Embedding基于Hugging Face生态开发,开发者可通过简单的Python代码实现调用,无需复杂的环境配置。以下为详细使用步骤(以“文本嵌入生成”“图像嵌入生成”“跨模态相似度计算”为例):

1. 环境准备

首先安装依赖库(建议使用Python 3.8+):

# 安装PyTorch(需根据操作系统与CUDA版本调整,此处为CPU版本示例) pip install torch torchvision torchaudio --index-url https://download.pytorch.org/whl/cpu # 安装Hugging Face相关库(模型加载、预处理) pip install transformers pillow datasets # pillow用于图像处理,datasets用于数据加载(可选) # 安装向量计算与可视化库(可选,用于相似度计算与结果展示) pip install numpy matplotlib

2. 模型获取与初始化

SAIL-Embedding的模型权重与预处理工具已托管在Hugging Face,可通过transformers库直接加载:

from transformers import AutoModel, AutoTokenizer, AutoImageProcessor import torch from PIL import Image import numpy as np # 模型名称(Hugging Face项目路径) model_name = "BytedanceDouyinContent/sail-embedding" # 初始化预处理工具:文本用Tokenizer,图像用ImageProcessor tokenizer = AutoTokenizer.from_pretrained(model_name) # 文本预处理(分词、转token ID) image_processor = AutoImageProcessor.from_pretrained(model_name) # 图像预处理( resize、标准化) # 初始化模型(默认加载基础版,若需增强版可指定model_name="BytedanceDouyinContent/sail-embedding-large") model = AutoModel.from_pretrained(model_name) # 设置模型为推理模式(禁用训练时的随机操作,确保结果稳定) model.eval()

3. 基础功能调用示例

示例1:生成文本嵌入向量

def get_text_embedding(text):

"""

输入文本,输出SAIL-Embedding向量

text: 待处理文本(支持中文、英文)

return: 512维向量(numpy数组)

"""

# 文本预处理:将文本转为模型可接受的格式(token ID、注意力掩码)

inputs = tokenizer(

text,

max_length=64, # 文本最大长度,超过截断,不足补全

padding="max_length",

truncation=True,

return_tensors="pt" # 返回PyTorch张量

)

# 模型推理:生成嵌入向量(禁用梯度计算,提升速度)

with torch.no_grad():

outputs = model(** inputs, modal_type="text") # 指定模态类型为文本

# 提取向量:取模型输出的[CLS] token的向量(代表整个文本的特征),转为numpy数组

embedding = outputs.last_hidden_state[:, 0, :].squeeze().numpy()

return embedding

# 测试:生成"黑色高帮运动鞋"的文本嵌入

text = "黑色高帮运动鞋"

text_emb = get_text_embedding(text)

print(f"文本嵌入向量维度:{text_emb.shape}") # 输出:(512,),即512维向量示例2:生成图像嵌入向量

def get_image_embedding(image_path):

"""

输入图像路径,输出SAIL-Embedding向量

image_path: 图像文件路径(如"shoe.jpg")

return: 512维向量(numpy数组)

"""

# 图像预处理:读取图像, resize、标准化

image = Image.open(image_path).convert("RGB") # 转为RGB格式(避免灰度图报错)

inputs = image_processor(

images=image,

return_tensors="pt" # 返回PyTorch张量

)

# 模型推理

with torch.no_grad():

outputs = model(** inputs, modal_type="image") # 指定模态类型为图像

# 提取向量:取图像特征的均值池化结果(代表整个图像的特征)

embedding = outputs.last_hidden_state.mean(dim=1).squeeze().numpy()

return embedding

# 测试:生成"黑色高帮运动鞋图片"的图像嵌入(需提前准备图像文件"shoe.jpg")

image_path = "shoe.jpg"

image_emb = get_image_embedding(image_path)

print(f"图像嵌入向量维度:{image_emb.shape}") # 输出:(512,)示例3:计算跨模态相似度(文本与图像匹配)

通过“余弦相似度”计算文本向量与图像向量的相似度(取值范围[-1,1],越接近1表示越匹配):

def calculate_cosine_similarity(vec1, vec2):

"""计算两个向量的余弦相似度"""

dot_product = np.dot(vec1, vec2) # 向量点积

norm_vec1 = np.linalg.norm(vec1) # 向量1的模

norm_vec2 = np.linalg.norm(vec2) # 向量2的模

similarity = dot_product / (norm_vec1 * norm_vec2)

return similarity

# 计算"黑色高帮运动鞋"文本与"shoe.jpg"图像的相似度

similarity = calculate_cosine_similarity(text_emb, image_emb)

print(f"文本与图像的相似度:{similarity:.4f}") # 若匹配,相似度通常>0.7;若不匹配(如文本是"猫咪"),相似度<0.34. 进阶使用:模型微调

若需适配特定领域(如医疗、金融),可通过以下步骤微调模型:

准备自定义数据集:格式为“文本-图像对”(如医疗领域的“疾病描述文本+病理图片”),需包含训练集、验证集;

加载微调模板:参考Hugging Face项目页提供的

finetune.py脚本(项目页可下载),修改数据集路径、微调参数(如学习率、训练轮次);启动微调:

python finetune.py \ --model_name_or_path BytedanceDouyinContent/sail-embedding \ --train_data_path ./medical_train_data \ --val_data_path ./medical_val_data \ --output_dir ./sail-embedding-medical \ --learning_rate 2e-5 \ --num_train_epochs 3

使用微调后模型:微调完成后,从

./sail-embedding-medical路径加载模型,即可用于医疗领域的跨模态任务。

六、常见问题解答(FAQ)

Q1:SAIL-Embedding目前支持哪些模态?是否支持中文文本?

A1:当前开源版本核心支持文本与图像模态,技术报告(2510.12709)提及后续将通过模块扩展支持音频、视频帧模态;文本模态同时支持中文与英文,且对中文语义的理解经过抖音中文场景优化(如支持“高帮鞋”“显瘦连衣裙”等中文生活化词汇)。

Q2:模型输出的向量维度能否调整?比如我需要256维向量而非默认512维。

A2:有两种方式调整:

方式1:后处理降维(简单快速):对默认512维向量使用PCA、TSNE等降维算法,降至256维(适合无需高精度的场景,如低内存设备);

方式2:模型微调(精度更高):在微调时修改模型的“池化层输出维度”(需少量代码修改,参考技术报告附录),直接输出256维/768维向量(适合对精度要求高的场景)。

Q3:使用SAIL-Embedding进行商业用途,是否需要授权?

A3:模型基于Apache License 2.0开源,个人与企业非商业用途可免费使用;商业用途需满足两个条件:1. 在产品文档中注明“基于SAIL-Embedding开发”;2. 不得将模型用于违法违规场景(如虚假信息生成、侵权内容检索)。若需大规模商业使用(如日均调用量超100万次),建议联系字节跳动官方获取商业授权(联系方式见第七部分官方链接)。

Q4:为什么我的文本与图像相似度计算结果偏低?如何优化?

A4:相似度偏低可能有以下原因及解决方案:

原因1:文本与图像不匹配(如文本是“黑色运动鞋”,图像是“白色运动鞋”)——需检查数据集或查询内容的匹配性;

原因2:图像质量差(如模糊、分辨率过低<224×224)——建议将图像分辨率调整至224×224~1024×1024像素;

原因3:未适配领域(如用通用模型处理医疗文本与病理图片)——需通过自定义数据集微调模型,提升领域适配性。

Q5:模型在CPU上运行速度较慢,如何优化推理速度?

A5:可通过以下方式优化CPU推理速度:

启用INT8量化:使用

transformers库的AutoModel.from_pretrained(..., load_in_8bit=True)加载模型,量化后推理速度提升2~3倍,精度损失<5%;批量处理:将多条文本/多张图像批量输入模型(如一次输入32条文本),而非单条输入,减少CPU调用开销;

使用轻量级框架:将模型转换为ONNX格式,通过ONNX Runtime部署(参考Hugging Face项目页的

export_onnx.py脚本),CPU推理速度可再提升30%。

七、相关链接

项目Hugging Face主页:https://huggingface.co/collections/BytedanceDouyinContent/sail-embedding

技术报告(arXiv):https://arxiv.org/abs/2510.12709

八、总结

SAIL-Embedding作为字节跳动抖音内容团队开源的全模态嵌入基础模型,以“跨模态统一表征”为核心突破,解决了传统单模态嵌入“无法跨类型匹配”的行业痛点,同时兼顾轻量高效、高泛化性与开源可扩展的优势——既能支撑跨模态检索、内容推荐等主流场景的快速落地,又能通过微调适配医疗、金融等垂直领域需求。其基于Hugging Face生态的简洁调用方式,大幅降低了多模态AI应用的开发门槛,无论是中小开发者的轻量化项目,还是企业级的大规模部署,都能从中获取高效的全模态嵌入解决方案;配套的技术报告与活跃的Issue社区,进一步为开发者提供了技术支撑与问题解决渠道,使其成为当前全模态嵌入领域兼具实用性与易用性的开源标杆项目。

版权及免责申明:本文由@AI工具箱原创发布。该文章观点仅代表作者本人,不代表本站立场。本站不承担任何相关法律责任。

如若转载,请注明出处:https://www.aipuzi.cn/ai-news/sail-embedding.html