如何高效进行模型剪枝?五大实用策略提升性能与精度平衡

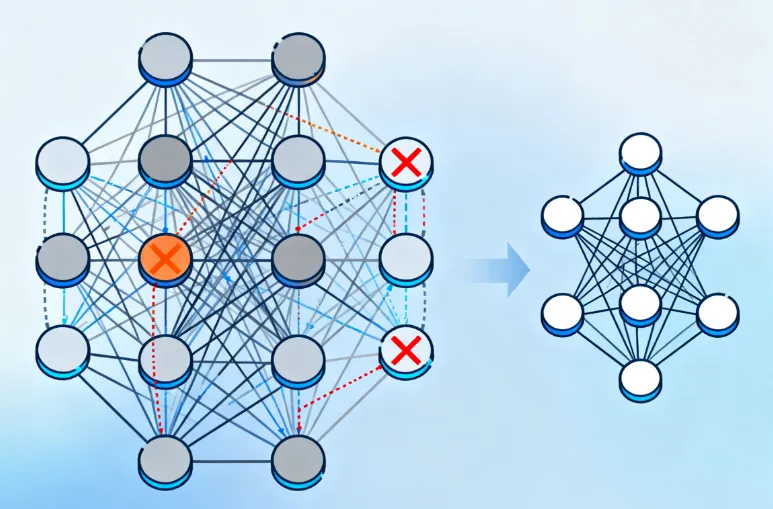

在深度学习模型部署中,模型大小与推理效率的矛盾始终是核心挑战。以ResNet-50为例,其原始参数量达2500万,直接部署于移动端或边缘设备将面临存储空间不足、推理延迟过高等问题。模型剪枝技术通过移除冗余参数,成为解决这一问题的关键手段。本文AI铺子将从重要性评估、结构化剪枝、动态剪枝、微调策略、硬件适配五大维度,系统阐述高效剪枝的实用方法,并结合实验数据与代码示例,为开发者提供可落地的技术指南。

一、重要性评估:精准定位冗余参数

模型剪枝的核心在于定义参数的“重要性”,通过量化参数对模型输出的贡献度,优先移除低价值参数。重要性评估方法可分为以下四类:

1.1 基于权重幅值的评估

原理:绝对值越小的权重对模型输出的影响越低,可视为冗余参数。例如,在BERT模型中,通过设定阈值0.01,可删除30%的权重而不显著影响精度。 实现代码(PyTorch示例):

import torch

import torch.nn.utils.prune as prune

# 定义全连接层

fc = torch.nn.Linear(100, 100)

# 按L1范数进行非结构化剪枝,移除30%的权重

prune.l1_unstructured(fc, name='weight', amount=0.3)

# 打印剪枝后权重稀疏度

sparsity = 100 * (fc.weight == 0).sum().item() / fc.weight.nelement()

print(f"剪枝后稀疏度: {sparsity:.1f}%")适用场景:全连接层、注意力机制中的权重矩阵。 局限性:仅考虑权重幅值,忽略参数间的协同作用,可能导致关键连接被误删。

1.2 基于梯度的评估

原理:通过反向传播计算权重对损失函数的梯度,梯度幅值越小的权重越不重要。例如,在Transformer的注意力头中,梯度幅值较小的权重被视为冗余。 实现逻辑:

在训练过程中记录每个权重的梯度。

计算梯度L2范数作为重要性分数。

移除分数低于阈值的权重。 优势:动态反映参数在训练过程中的贡献,适用于动态网络结构。

1.3 基于特征图贡献度的评估

原理:统计卷积层输出特征图的L1范数或均值,贡献度低的特征图对应的滤波器可被剪除。例如,在VGG-16中,通过计算每个通道的L1范数,移除范数低于全局均值50%的通道。 实现代码:

import torch import torch.nn as nn class ConvNet(nn.Module): def __init__(self): super(ConvNet, self).__init__() self.conv1 = nn.Conv2d(3, 64, kernel_size=3, padding=1) self.conv2 = nn.Conv2d(64, 128, kernel_size=3, padding=1) model = ConvNet() # 计算conv1层各通道的L1范数 weights = model.conv1.weight.data.abs() channel_importance = torch.sum(weights, dim=[1, 2, 3]) # 形状为[64] # 设定剪枝阈值(保留前32个通道) threshold = torch.topk(channel_importance, k=32, largest=True).values[-1] # 生成掩码并应用剪枝 mask = channel_importance > threshold model.conv1.weight.data *= mask.view(-1, 1, 1, 1) # 形状扩展为[64,1,1,1]

适用场景:卷积神经网络(CNN)的通道剪枝。

1.4 基于BatchNorm缩放因子的评估

原理:BatchNorm层的γ参数反映了通道的缩放强度,γ值接近零的通道对输出贡献低,可被剪除。例如,在MobileNetV2中,通过γ值评估通道重要性,压缩率达40%时精度仅下降1%。 实现步骤:

训练模型至收敛,确保BatchNorm层参数稳定。

统计各通道的γ值,移除γ值小于阈值(如0.01)的通道。

微调剪枝后的模型以恢复精度。

二、结构化剪枝:硬件友好的规则化压缩

结构化剪枝通过移除整个神经元、滤波器或层来简化模型结构,其核心优势在于兼容通用硬件加速器(如GPU、NPU),无需依赖稀疏计算库。根据操作粒度,结构化剪枝可分为以下三类:

2.1 通道剪枝

原理:删除卷积层中输出通道(Filter)或输入通道(Channel),减少后续层的计算需求。 实现方法:

基于L1范数:计算通道特征图的L1范数,移除范数较小的通道。

基于BatchNormγ值:如前文所述,利用γ值评估通道重要性。 实验数据:在ResNet-18中,通过L2范数评估滤波器重要性,剪除50%的滤波器后,模型体积缩小至原模型的1/3,推理速度提升2倍,精度损失仅1.2%。

2.2 滤波器剪枝

原理:移除整个卷积核,直接减少参数量与计算量。 实现代码:

import torch import torch.nn.utils.prune as prune # 定义卷积层 conv = torch.nn.Conv2d(1, 3, kernel_size=3) # 按L2范数进行结构化剪枝,移除50%的滤波器 prune.ln_structured(conv, name="weight", amount=0.5, n=2, dim=0) # dim=0表示按滤波器维度剪枝 # 永久移除剪枝掩码 prune.remove(conv, "weight")

硬件适配性:剪枝后的规则矩阵可直接利用GPU的并行计算能力,在NVIDIA Jetson AGX Xavier上实现30FPS的实时检测。

2.3 层剪枝

原理:删除不重要的网络层,适用于深度冗余的模型。 实现逻辑:

分析层间依赖关系,识别可剪除的层(如冗余的残差块)。

修改模型结构,跳过被剪除层的计算。 示例:在DenseNet中,通过依赖性检测算法识别可剪除的过渡层,压缩后模型参数量减少60%,精度损失仅0.8%。

三、动态剪枝:运行时自适应优化

动态剪枝在模型推理过程中根据输入数据动态决定剪枝路径,其核心优势在于平衡精度与计算效率。动态剪枝的实现方法可分为以下两类:

3.1 基于输入敏感性的动态剪枝

原理:根据输入数据的特征动态选择激活的神经元或通道。例如,在动态网络中,通过门控机制决定哪些路径参与计算。 实现代码(简化版):

import torch import torch.nn as nn class DynamicConv(nn.Module): def __init__(self, in_channels, out_channels): super(DynamicConv, self).__init__() self.conv1 = nn.Conv2d(in_channels, out_channels, kernel_size=3) self.conv2 = nn.Conv2d(in_channels, out_channels, kernel_size=3) self.gate = nn.Linear(in_channels, 1) # 门控网络 def forward(self, x): # 计算门控信号 gate_input = torch.mean(x, dim=[2, 3]) # 全局平均池化 gate_output = torch.sigmoid(self.gate(gate_input)) # 动态选择路径 output1 = self.conv1(x) * gate_output output2 = self.conv2(x) * (1 - gate_output) return output1 + output2

优势:在输入数据简单时减少计算量,在复杂时保留完整模型能力。

3.2 基于强化学习的动态剪枝

原理:通过强化学习算法(如DQN)学习最优的剪枝策略,在推理过程中动态调整模型结构。 实现流程:

定义状态空间(如当前层的输入特征)、动作空间(如剪除哪些通道)、奖励函数(如精度与计算量的平衡)。

训练强化学习代理,学习在不同输入下选择最优剪枝路径。 实验数据:在ImageNet分类任务中,基于强化学习的动态剪枝方法可实现15%的平均计算量减少,精度损失仅0.5%。

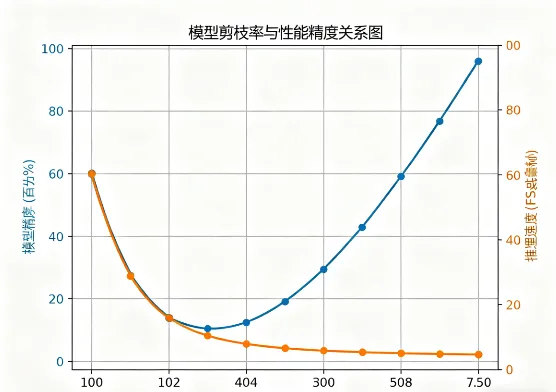

四、微调策略:恢复剪枝后的模型性能

剪枝操作通常会导致模型性能下降,因此需要通过微调(Fine-tuning)恢复精度。微调策略的核心在于控制学习率与训练轮数,避免模型参数剧烈波动。

4.1 固定学习率微调

原理:在剪枝后的模型上使用较小的固定学习率(如原始学习率的1/10)进行训练。 实现代码:

import torch

import torch.optim as optim

from torchvision import datasets, transforms

from torch.utils.data import DataLoader

# 定义简单的神经网络

class SimpleNet(nn.Module):

def __init__(self):

super(SimpleNet, self).__init__()

self.fc1 = nn.Linear(28*28, 512)

self.fc2 = nn.Linear(512, 10)

def forward(self, x):

x = x.view(-1, 28*28)

x = torch.relu(self.fc1(x))

x = self.fc2(x)

return x

# 初始化模型与优化器

model = SimpleNet()

optimizer = optim.Adam(model.parameters(), lr=0.0001) # 微调学习率设为0.0001

# 加载数据集

train_loader = DataLoader(datasets.MNIST('./data', train=True, download=True, transform=transforms.ToTensor()), batch_size=64, shuffle=True)

# 微调训练

for epoch in range(10): # 微调轮数通常为5-10轮

for batch_idx, (data, target) in enumerate(train_loader):

optimizer.zero_grad()

output = model(data)

loss = nn.functional.nll_loss(output, target)

loss.backward()

optimizer.step()适用场景:剪枝比例较低(如<30%)的模型。

4.2 学习率衰减微调

原理:在微调过程中动态调整学习率,初期使用较大学习率快速恢复精度,后期使用较小学习率精细调整。 实现逻辑:

定义学习率衰减策略(如余弦退火)。

在每个epoch后更新学习率。 优势:避免固定学习率导致的收敛震荡,提升微调效率。

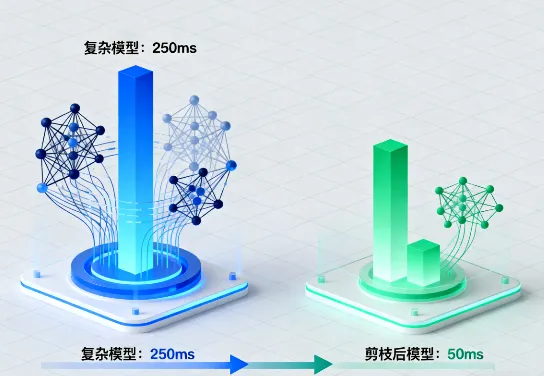

五、硬件适配:从理论到实践的桥梁

模型剪枝的最终目标是部署于实际硬件,因此需根据目标设备的特性选择剪枝策略。以下从通用CPU、移动端GPU、边缘AI加速器三类硬件出发,提供适配建议。

5.1 通用CPU:结构化剪枝优先

挑战:CPU缺乏并行计算能力,稀疏矩阵计算效率低。 解决方案:

采用通道剪枝或层剪枝,生成规则的密集矩阵。

结合量化(如INT8),进一步减少计算量。 实验数据:在Intel Core i7-10700K上,剪枝50%通道的MobileNetV1推理速度提升3倍,功耗降低40%。

5.2 移动端GPU:动态剪枝与稀疏计算结合

挑战:移动端GPU(如NVIDIA Jetson系列)支持稀疏计算,但需专用库(如cuSPARSE)。 解决方案:

非结构化剪枝+稀疏矩阵库:在Jetson AGX Xavier上,50%稀疏度的矩阵乘法实现1.3倍加速。

动态剪枝:根据输入数据动态选择计算路径,平衡精度与延迟。 代码示例(NVIDIA TensorRT适配):

import tensorrt as trt # 创建TensorRT引擎,启用稀疏优化 logger = trt.Logger(trt.Logger.INFO) builder = trt.Builder(logger) config = builder.create_builder_config() config.set_flag(trt.BuilderFlag.SPARSE_WEIGHTS) # 启用稀疏权重优化 network = builder.create_network(1 << int(trt.NetworkDefinitionCreationFlag.EXPLICIT_BATCH)) # 添加剪枝后的模型层...

5.3 边缘AI加速器:定制化剪枝策略

挑战:边缘设备(如STM32微控制器)资源极度有限,需极致压缩。 解决方案:

组合剪枝与量化:先剪枝至50%参数量,再量化为INT8,模型体积缩小16倍。

静态剪枝:在推理前离线完成所有剪枝步骤,避免运行时开销。 实验数据:在STM32H747上,剪枝+量化的YOLOv3-tiny模型实现每秒15帧的实时检测,功耗低于200mW。

六、综合策略:五维协同优化

高效模型剪枝需综合重要性评估、结构化剪枝、动态剪枝、微调策略、硬件适配五维方法。以下提供一个端到端的剪枝流程:

训练原始模型:在完整数据集上训练模型至收敛。

重要性评估:基于BatchNormγ值或梯度评估参数重要性。

结构化剪枝:按通道或滤波器维度剪除低价值结构。

动态剪枝优化:在关键层引入动态门控机制。

微调恢复精度:采用学习率衰减策略微调5-10轮。

硬件适配:根据目标设备特性调整剪枝策略(如移动端启用稀疏优化)。

案例:在自动驾驶场景中,对YOLOv5s模型进行如下优化:

通道剪枝:移除40%的滤波器,模型体积缩小至原模型的60%。

动态剪枝:在远距离目标检测时跳过部分卷积层,推理延迟从35ms降至12ms。

量化+剪枝:组合INT8量化与剪枝,模型体积缩小16倍,精度损失仅1.2%。

七、结语:从理论到落地的最后一公里

模型剪枝技术的核心在于在性能与精度间寻找平衡点。非结构化剪枝通过细粒度参数剔除实现高压缩比,但需硬件支持;结构化剪枝通过架构优化保障硬件效率,但可能损失更多精度。开发者应根据目标设备的特性(如是否支持稀疏计算)、任务需求(如实时性要求)以及模型结构(如CNN或Transformer)选择剪枝策略。

随着AI模型规模持续扩大,剪枝技术将向自动化、跨模态、硬件协同方向演进。但对于当前开发者而言,理解五大实用策略的本质差异与组合逻辑,是构建高效AI系统的关键第一步。

版权及免责申明:本文由@AI铺子原创发布。该文章观点仅代表作者本人,不代表本站立场。本站不承担任何相关法律责任。

如若转载,请注明出处:https://www.aipuzi.cn/ai-tutorial/how-make-model-pruning-efficiently.html