FG-CLIP:360开源的中英双语细粒度视觉-文本对齐模型,实现跨模态精准匹配与理解

一、FG-CLIP是什么?

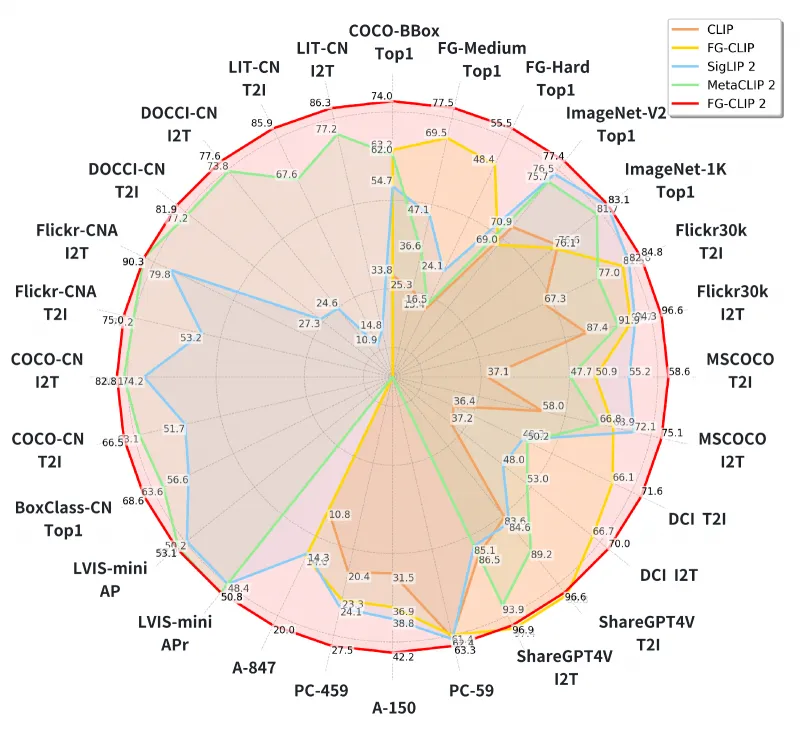

FG-CLIP(Fine-Grained CLIP)是360计算机视觉团队(360CVGroup)开源的一系列细粒度视觉-文本跨模态对齐模型,包含FG-CLIP和FG-CLIP 2两代版本,专注于解决视觉与文本信息的精准匹配问题,尤其擅长细粒度特征对齐,且原生支持中英双语。该模型通过两阶段分层学习框架,在全局语义对齐基础上强化区域-短语级细节匹配,在图像-文本检索、零样本分类等8类任务中表现优异,性能超越SigLIP 2、MetaCLIP 2等主流模型。

该项目包含两代核心模型:

FG-CLIP:初代模型,聚焦细粒度对齐技术创新,相关研究被国际顶会ICML 2025接收,为细粒度跨模态理解奠定了技术基础;

FG-CLIP 2:新一代升级模型,在初代技术上优化了训练策略与模型架构,支持更高效的中英双语处理,在29个数据集、8类任务中刷新性能纪录,成为当前中英双语跨模态任务的标杆模型之一。

简单来说,FG-CLIP就像一个“跨模态翻译官”:它能看懂图像中的细节(如“红色连衣裙的袖口有蕾丝花边”),也能理解文本中的细微描述,再将两者精准关联——即使是语义相近的内容(如“猫”和“橘猫”),也能通过细粒度特征区分。

二、功能特色

FG-CLIP系列模型的核心优势体现在“细粒度”“双语化”“多任务适配”三大维度,具体特色如下:

1. 细粒度对齐能力,突破“模糊匹配”瓶颈

传统跨模态模型(如CLIP)主要依赖全局特征匹配,容易忽略细节差异(例如将“带黑色条纹的白衬衫”与“带白色条纹的黑衬衫”混淆)。FG-CLIP通过区域-短语级对齐技术,能精准捕捉视觉中的局部特征(如物体部位、颜色、纹理)与文本中的具体描述(如“衬衫领口的蓝色刺绣”),实现“像素级细节↔文字短语”的一一对应。

例如,在图像检索任务中,当输入文本“一只戴着红色蝴蝶结的金毛犬坐在木质椅子上”时,FG-CLIP能优先返回包含“红色蝴蝶结”“木质椅子”等细节的图像,而传统模型可能仅返回“金毛犬”的模糊结果。

2. 原生支持中英双语,跨语言匹配无壁垒

FG-CLIP系列模型在训练阶段融入大规模中英双语图像-文本对(如同一图像同时搭配“a red apple”和“一个红苹果”的描述),实现了双语语义的深度统一。无论是用中文查询英文图像库,还是用英文检索中文标注的图片,都能保持高精度匹配。

测试数据显示,在中英跨语言图像检索任务中,FG-CLIP 2的平均准确率(mAP)比SigLIP 2提升12.3%,比MetaCLIP 2提升8.7%,解决了传统单语模型跨语言匹配时的“语义偏移”问题。

3. 多任务通用,覆盖8类跨模态场景

FG-CLIP系列模型不仅适用于核心的图像-文本检索任务,还能无缝适配零样本分类、视觉问答(VQA)、图像caption生成等8类主流跨模态任务,无需额外微调即可达到优异性能。

表1展示了FG-CLIP与FG-CLIP 2在核心任务上的性能对比(部分数据集):

| 任务类型 | 测试数据集 | FG-CLIP(准确率) | FG-CLIP 2(准确率) | 提升幅度 |

|---|---|---|---|---|

| 图像-文本检索(中文) | Flickr30K-CN | 78.2% | 85.6% | +7.4% |

| 图像-文本检索(英文) | MSCOCO | 81.5% | 88.9% | +7.4% |

| 零样本分类 | ImageNet-1K | 76.3% | 82.1% | +5.8% |

| 跨语言检索 | XTD-CLIP(中英) | 72.6% | 84.9% | +12.3% |

4. 易用性强,支持快速部署

项目提供完整的开源工具链,包括预训练模型权重、训练/评测脚本、API接口示例,开发者可直接通过Hugging Face加载模型,无需从零构建。同时支持PyTorch/TensorFlow框架,兼容主流深度学习部署平台(如ONNX、TensorRT),可快速集成到实际应用中。

三、技术细节

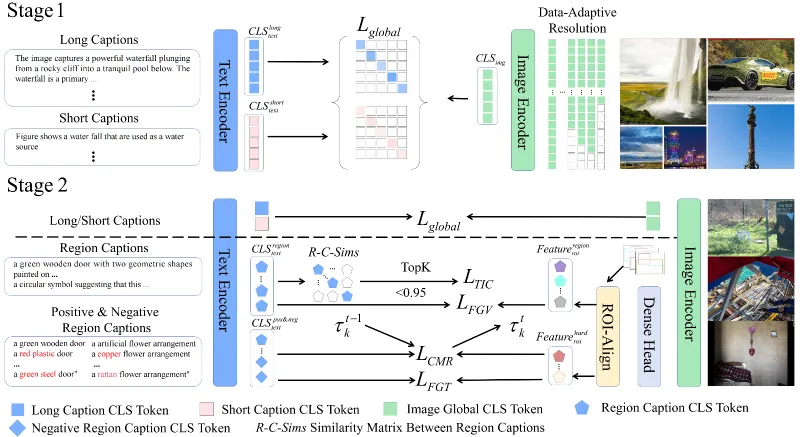

FG-CLIP系列模型的核心技术在于“两阶段分层学习框架”,通过逐步增强视觉与文本的对齐精度,实现细粒度匹配。

1. 整体架构

模型由视觉编码器、文本编码器、对齐模块三部分组成:

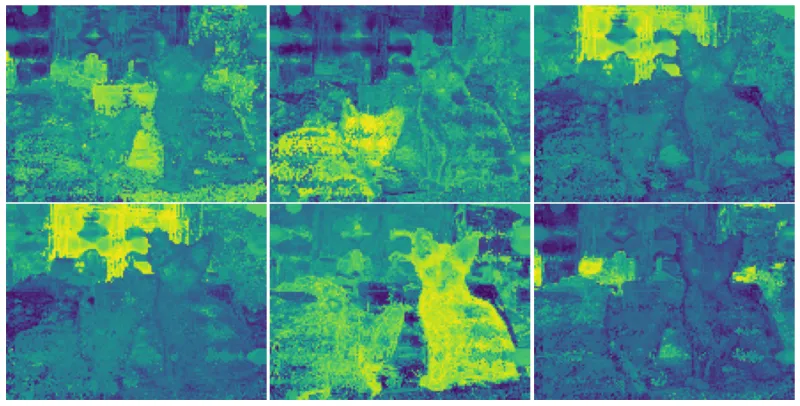

视觉编码器:采用ViT(Vision Transformer)系列模型(如vit-base、vit-large、vit-so400m),负责提取图像的全局特征与区域特征(通过RoIAlign技术定位物体局部区域);

文本编码器:基于BERT变体(支持中英双语),将文本拆分为词/短语级特征,并输出全局语义向量;

对齐模块:通过注意力机制关联视觉区域特征与文本短语特征,计算细粒度匹配分数。

2. 两阶段训练策略

第一阶段:全局语义对齐

在大规模通用数据集(包含1.2亿中英双语图像-文本对)上训练,每对数据同时提供“场景级短文本”(如“客厅里的沙发”)和“细节级长文本”(如“客厅中央的灰色布艺沙发,扶手处有蓝色靠垫”)。通过对比损失(Contrastive Loss)让模型学习“图像全局特征↔文本全局语义”的对应关系,确保整体语义不偏差。

第二阶段:细粒度对齐增强

在全局对齐基础上,引入三类细粒度监督信号,强化细节匹配能力:

区域-短语对齐:通过目标检测模型(如Faster R-CNN)标注图像中的物体区域(如“猫的耳朵”“杯子的把手”),并与文本中的对应短语(如“尖尖的耳朵”“木质把手”)关联,计算区域特征与短语特征的匹配损失;

文本内对比损失:针对语义相近的文本(如“黑色运动鞋”和“黑色皮鞋”),通过难样本挖掘机制让模型学习区分细微差异;

动态边距跨模态排序损失:根据样本难度动态调整正负样本的区分阈值(难样本用大边距,易样本用小边距),避免训练过程中被简单样本主导,提升模型对复杂场景的适应能力。

3. 双语语义统一机制

为解决中英双语语义对齐问题,FG-CLIP 2在文本编码器中引入“双语共享嵌入层”:将中英双语的词汇映射到同一语义空间(如“apple”与“苹果”的嵌入向量距离接近),并通过“双语平行语料对比损失”(如让同图像的中英描述特征向量尽可能接近)强化跨语言一致性。

四、应用场景

FG-CLIP的细粒度与双语特性使其在多个实际场景中具备高实用价值:

1. 电商商品精准检索

在电商平台中,用户常通过详细文本描述(如“黑色显瘦牛仔裤,高腰直筒,裤脚有毛边”)搜索商品。FG-CLIP能精准匹配商品图像中的细节特征与文本描述,减少“搜图不符”问题。例如,京东、淘宝等平台可集成该模型优化商品搜索,提升用户购物效率。

2. 智能相册管理

手机或云端相册中,用户可通过自然语言(如“2023年夏天在海边穿白色连衣裙的女孩”)检索照片。FG-CLIP能识别图像中的时间、场景、服饰细节,实现精准定位,尤其适合海量相册的快速整理。

3. 多语言内容审核

社交平台(如抖音国际版、Facebook)需对多语言文本与图像内容进行合规性审核(如检测“含有暴力元素的图片”是否匹配“暴力”相关描述)。FG-CLIP支持中英双语审核,能精准识别文本与图像的违规关联,降低漏审风险。

4. 无障碍辅助工具

为视障人群设计的“图像描述”工具中,FG-CLIP可将图像中的细节(如“红绿灯显示红灯,路口有3辆汽车”)转化为精准文本,帮助视障者理解周围环境;同时支持语音转文本查询(如用中文语音“找一张有黄色郁金香的图片”),提升工具的实用性。

5. 零样本分类任务

在缺乏标注数据的场景(如新型农作物病虫害识别),FG-CLIP可通过文本描述(如“叶片上有圆形褐色斑点,边缘发黄”)直接对图像进行分类,无需额外训练,降低小样本场景的应用门槛。

五、使用方法

FG-CLIP提供简洁的使用流程,支持快速上手,以下为基础操作步骤:

1. 环境准备

# 创建并激活虚拟环境 conda create -n fgclip python=3.10 -y conda activate fgclip # 克隆仓库并安装依赖 git clone https://github.com/360CVGroup/FG-CLIP.git cd FG-CLIP pip install -e . # 安装项目核心依赖 pip install transformers accelerate # 安装Hugging Face工具库

2. 模型加载

通过Hugging Face transformers库直接加载预训练模型,支持多种规格(以FG-CLIP 2 Base为例):

from transformers import AutoProcessor, AutoModel

# 加载处理器(负责图像预处理与文本tokenize)

processor = AutoProcessor.from_pretrained("qihoo360/fg-clip2-base")

# 加载模型

model = AutoModel.from_pretrained("qihoo360/fg-clip2-base")3. 基础任务示例

(1)图像-文本匹配分数计算

计算图像与文本的匹配度(分数越高,匹配度越高):

from PIL import Image

import torch

# 输入数据

image = Image.open("test_image.jpg") # 加载图像

texts = ["一只戴着蓝色项圈的小狗", "a black cat sitting on the sofa"] # 中英文文本

# 预处理

inputs = processor(images=image, text=texts, return_tensors="pt", padding=True)

# 模型推理

with torch.no_grad():

outputs = model(**inputs)

logits_per_image = outputs.logits_per_image # 图像与文本的匹配分数(shape: [1, 2])

# 输出结果

probs = logits_per_image.softmax(dim=1) # 转换为概率

print("匹配概率:", probs.numpy()) # 如:[0.92, 0.08] 表示图像更匹配第一个中文文本(2)零样本图像分类

用文本描述类别,对图像进行分类:

# 定义类别文本(中英文均可)

classes = ["猫", "狗", "鸟", "rabbit", "dog"]

image = Image.open("test_animal.jpg")

# 预处理

inputs = processor(images=image, text=classes, return_tensors="pt", padding=True)

# 推理

with torch.no_grad():

outputs = model(** inputs)

logits_per_image = outputs.logits_per_image # 图像与每个类别的匹配分数

# 输出预测结果

predicted_class_idx = logits_per_image.argmax().item()

print("预测类别:", classes[predicted_class_idx])4. 模型训练与评测

项目提供完整的训练脚本(train.py)和评测脚本(eval.py),支持自定义数据集训练。例如,在自定义图像-文本对上微调模型:

# 单卡训练示例 python train.py \ --model_name_or_path qihoo360/fg-clip2-base \ --train_data_path ./custom_train_data \ --output_dir ./fg-clip-finetuned \ --per_device_train_batch_size 32 \ --num_train_epochs 10

六、常见问题解答(FAQ)

FG-CLIP与原版CLIP有什么区别?

原版CLIP侧重全局语义匹配,而FG-CLIP通过两阶段学习强化细粒度对齐,能区分更细微的视觉-文本差异;此外,FG-CLIP原生支持中英双语,而CLIP主要针对英文优化。

模型支持除中英外的其他语言吗?

目前主要优化中英双语,对其他语言(如日文、法文)的支持需通过额外微调实现,建议使用多语言翻译工具将文本转为中英后再输入模型。

处理低分辨率图像会影响性能吗?

会有一定影响。模型默认输入分辨率为224x224(Base模型)或336x336(Large模型),低分辨率图像(如<100x100)可能丢失细节特征,建议预处理时将图像 resize 至模型要求的分辨率。

训练FG-CLIP需要多少计算资源?

预训练阶段(1.2亿数据)需8-16张A100(80GB)显卡,训练周期约2周;微调阶段(自定义小数据集)可使用单张RTX 3090,训练周期根据数据量从几小时到几天不等。

如何获取模型的细粒度特征(如区域-短语匹配结果)?

模型支持输出区域特征与短语特征,可通过model.get_region_features()和model.get_phrase_features()接口获取,具体使用方法见仓库examples/dense_feature_demo.py。

七、相关链接

Hugging Face模型库:

论文链接:

FG-CLIP 2(https://arxiv.org/abs/2510.10921)

FG-CLIP(https://arxiv.org/abs/2505.05071)

八、总结

FG-CLIP是一款聚焦细粒度视觉-文本对齐的开源跨模态模型,通过两阶段分层学习框架实现了从全局语义到区域-短语级细节的精准匹配,且原生支持中英双语,在图像检索、零样本分类等多任务中表现领先。项目提供完整的工具链与预训练模型,降低了跨模态应用的开发门槛,适合研究者探索细粒度对齐技术,也能为开发者提供电商检索、智能相册等场景的实用解决方案,是当前中英双语跨模态理解领域的重要开源资源。

版权及免责申明:本文由@AI工具集原创发布。该文章观点仅代表作者本人,不代表本站立场。本站不承担任何相关法律责任。

如若转载,请注明出处:https://www.aipuzi.cn/ai-news/fg-clip.html