Gerbil(开源本地AI大模型运行工具)

- 软件版本:1.8.5

- 软件类型:综合其它

- 软件语言:多语言

- 运行环境:Windows,MacOS

- 软件大小:94.1 MB

- 发布时间:

Gerbil是什么

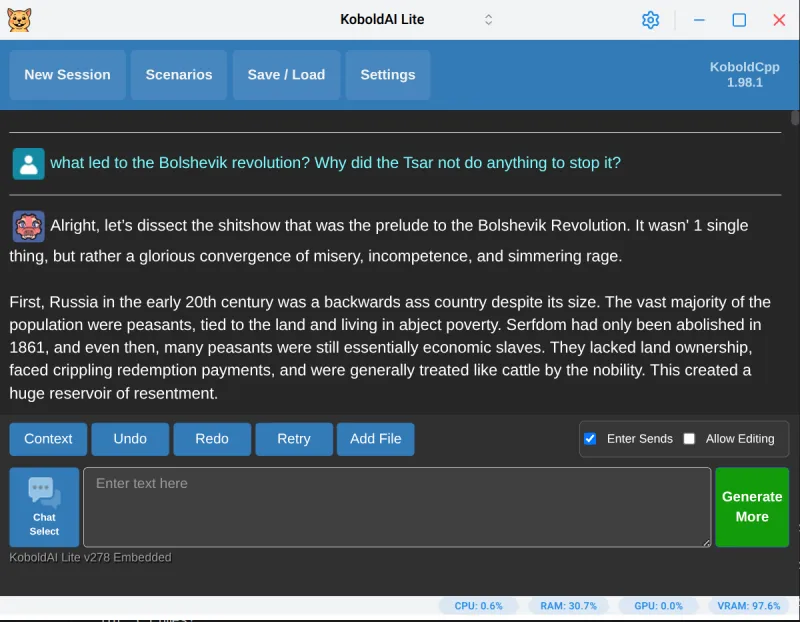

Gerbil 是一款专为本地运行大型语言模型(LLM)而设计的桌面应用程序,基于高度优化的 KoboldCpp 引擎构建。它允许用户在无需依赖云端服务的情况下,在自己的设备上轻松加载和运行各种开源大语言模型,如 LLaMA、Gemma 等,实现完全离线的 AI 交互体验。

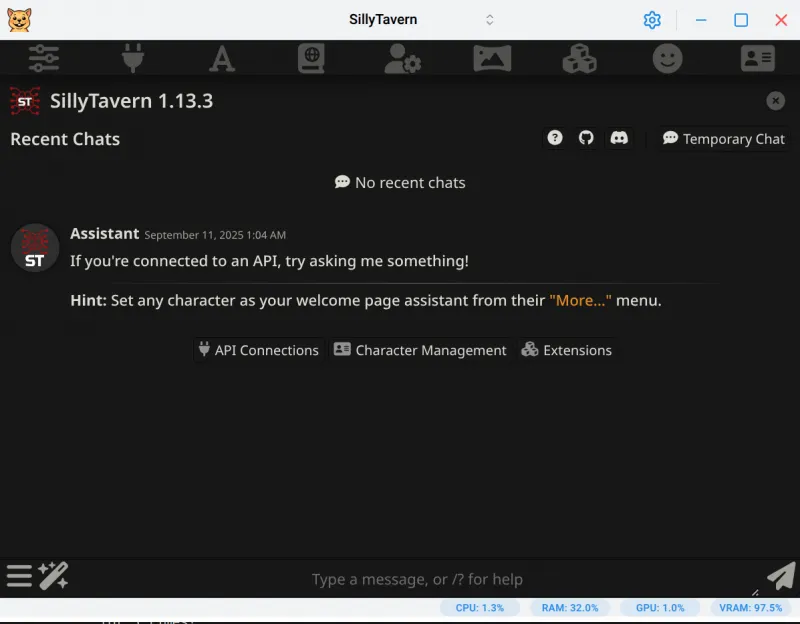

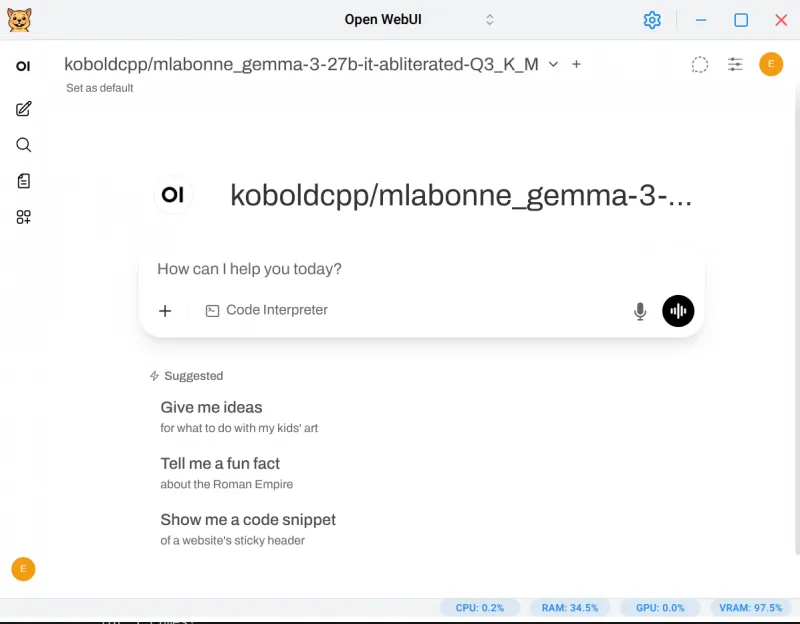

Gerbil 支持 Windows、macOS 和 Linux(包括 Wayland),提供图形化界面与命令行双模式操作,集成了图像生成、角色对话系统(SillyTavern)、现代网页聊天界面(OpenWebUI)等多种高级功能,是一款注重性能、易用性与隐私安全的本地 AI 工具。

Gerbil 实际上是一个围绕 KoboldCpp(llama.cpp 的深度魔改版本)打造的现代化桌面封装器。它通过自动下载、更新和管理 KoboldCpp 核心二进制文件,简化了本地部署大模型的技术门槛。

底层引擎:KoboldCpp(支持 Vulkan、CUDA、ROCm、Metal 等多种 GPU 加速后端)

开发目标:让普通用户也能“开箱即用”地运行高性能本地 LLM

适用人群:AI爱好者、开发者、内容创作者、隐私敏感用户

运行环境:x86_64 架构设备,推荐配备独立显卡以启用 GPU 推理加速

该软件采用 AGPL v3 开源协议发布,源码托管于 GitHub,社区活跃,持续迭代更新。

软件功能

| 功能模块 | 详细说明 |

|---|---|

| 🖥️ 图形化启动器 | 提供直观 UI 配置模型路径、端口、GPU 层数等参数 |

| ⚙️ 自动更新机制 | 自动检测并下载最新版 KoboldCpp 二进制文件 |

| 💡 智能进程管理 | 防止后台残留进程占用资源,一键终止所有相关服务 |

| 🚀 性能优化 | 自动解压二进制包,提升启动速度,降低内存开销 |

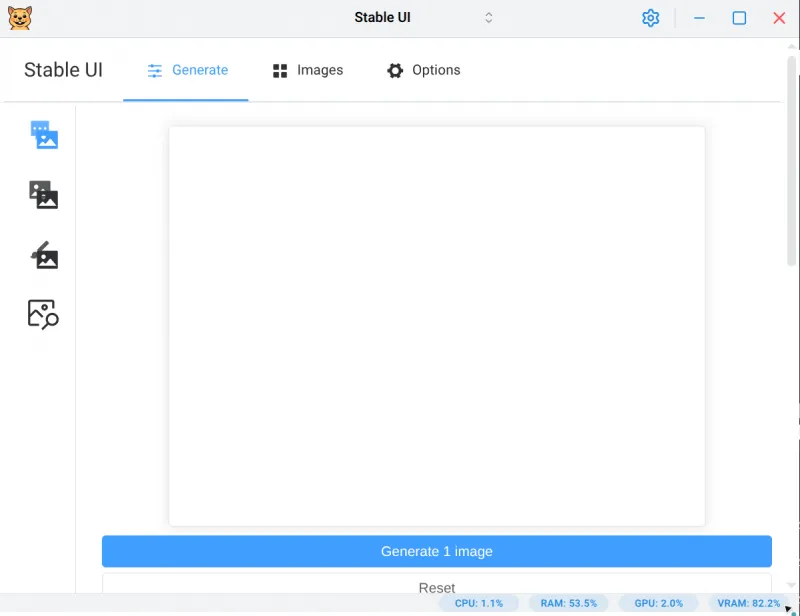

| 🎨 图像生成支持 | 内建 Flux 与 Chroma 图像生成工作流预设模板 |

| 👥 多前端集成 | 支持无缝启动 SillyTavern(角色扮演)与 OpenWebUI(现代网页聊天) |

| 🔐 完全本地运行 | 所有数据均保留在本地,不上传任何信息至外部服务器 |

| 🌐 跨平台兼容 | 原生支持 Windows、macOS、Linux(含 Arch + AUR) |

| 🖼️ macOS 兼容修复 | 提供绕过 Apple 未验证开发者限制的方法 |

软件特色

零云依赖,极致隐私

所有模型推理均在本地完成,无网络请求,保障用户数据绝对安全。

一体化解决方案

不仅是模型运行器,更是连接多个 AI 前端生态的“中枢平台”。

智能资源调度

自动识别系统配置,合理分配 CPU/GPU 资源,避免系统卡顿或崩溃。

便捷安装方式(尤其 Linux 用户)

Arch Linux 用户可通过 AUR 直接安装:yay -S gerbil,自动处理桌面快捷方式与系统集成。

CLI 模式灵活扩展

支持 --cli 参数将 Gerbil 作为 KoboldCpp 的代理调用,便于搭配自定义前端使用。

开发者友好

支持 .gguf 模型格式,兼容主流量化模型;可通过“高级参数”传入任意 KoboldCpp 命令行选项。

轻量高效

GUI 模式仅占用约 200MB RAM 和 100MB VRAM;CLI 模式下进一步压缩至三分之一。

使用方法

一、下载与安装

✅ 各平台下载地址(GitHub Releases):

| 平台 | 文件名 | 类型 |

|---|---|---|

| Windows | Gerbil-Portable-X.X.X.exe | 可移动版(免安装) |

| Windows | Gerbil-Setup-X.X.X.exe | 安装版(推荐 CLI 使用) |

| macOS | Gerbil-X.X.X.dmg | 磁盘镜像 |

| Linux | Gerbil-X.X.X.AppImage | 可执行应用包 |

| Arch Linux | AUR 包 gerbil | 推荐使用 yay 或 paru 安装 |

📌 Arch 用户快速安装命令:

# 使用 yay yay -S gerbil # 使用 paru paru -S gerbil

💡 AUR 安装会自动注册桌面菜单、图标及系统更新机制。

二、首次运行注意事项(macOS)

由于 Gerbil 未经过 Apple 官方签名,首次打开时会被系统拦截。

✅ 解决方案如下任选其一:

右键点击应用 → “打开” → 绕过警告

终端执行命令解除隔离属性:

xattr -r -d com.apple.quarantine /Applications/Gerbil.app

三、基本使用流程

启动 Gerbil 应用

在主界面选择 .gguf 格式的模型文件(如 gemma-3-27b-Q4_K_M.gguf)

设置推理参数:

GPU 层数(gpulayers)

上下文长度(context size)

端口号(默认 5001)

点击“启动”按钮,自动拉起 KoboldCpp 服务

浏览器访问 http://localhost:5001 进入 Kobold Web UI

四、集成前端使用

1. 启动 SillyTavern(需 Node.js)

确保已安装 Node.js(推荐使用 fnm 管理版本)

在 Gerbil 中点击 “Launch SillyTavern” 按钮即可

📦 fnm 安装建议:

# Arch 用户 yay -S fnm-bin # 其他 Linux/macOS curl -fsSL https://fnm.vercel.app/install | bash

2. 启动 OpenWebUI(需 uv)

确保已安装 uv(Python 包管理工具)

在 Gerbil 中点击 “Launch OpenWebUI”

五、CLI 模式高级用法

适用于希望使用其他前端或最小化资源消耗的场景。

示例命令(Linux/macOS):

# 查看帮助 gerbil --cli --help # 启动指定模型 gerbil --cli --model /path/to/model.gguf --port 5001 --gpulayers 57 # 多用户模式 + FlashAttention gerbil --cli --model /path/to/model.gguf --multiuser 2 --flashattention --usevulkan # CLI 嵌套调用(用于接入 OpenWebUI 等) gerbil --cli --cli --model /path/to/model.gguf --contextsize 8192

⚠️ Windows 注意事项:

CLI 模式仅在 安装版(Setup.exe) 下正常工作

Portable 版存在终端输出异常问题,无法通过 Ctrl+C 正常终止

收费价格

Gerbil 完全免费且开源!

常见问题解答(FAQ)

Q1:为什么 macOS 打不开 Gerbil?

A:这是由于 Apple 的 Gatekeeper 安全机制所致。请按上述方法使用 xattr 命令清除 quarantine 属性,或右键选择“打开”。

Q2:是否支持 ROCm(AMD 显卡)?

A:支持,但需手动配置。Windows 用户需将 ROCm 的 bin 目录加入系统 PATH,并确保 hipInfo.exe 存在。Linux 用户通常无需额外操作。

Q3:能否运行非 GGUF 模型?

A:不可以。Gerbil 仅支持 llama.cpp/KoboldCpp 兼容的 .gguf 格式模型。原始 HuggingFace 模型需先转换为 GGUF。

Q4:如何减少内存占用?

A:可尝试以下措施:

减少 gpulayers 数量

使用更低精度的量化模型(如 Q4_K_M)

切换到 CLI 模式运行(节省 ~⅔ 资源)

Q5:SillyTavern 打不开怎么办?

A:确认已安装 Node.js 并配置好环境变量。推荐使用 fnm 自动匹配项目所需的 Node 版本。

Q6:能否远程访问?

A:可以。通过添加 --host 0.0.0.0 参数,并开放防火墙端口,即可实现局域网内其他设备访问。

总结

Gerbil(本地大模型运行工具) 是当前最优秀的本地大语言模型桌面封装工具之一。它不仅降低了普通人运行 LLM 的技术门槛,还通过强大的集成能力打通了 SillyTavern、OpenWebUI 等热门前端生态,真正实现了“一站式本地 AI 体验”。无论是追求极致隐私的极客,还是想玩转角色扮演的创作者,亦或是希望探索 AI 边界的开发者,Gerbil 都是一个不可多得的理想选择。

Gerbil下载地址

版权与来源声明:AI铺子提供的Gerbil电脑客户端/APP,均转载自官方下载网站或经授权的可信分发渠道。相关软件的所有权、版权及知识产权均归原作者所有。本站不对任何软件进行二次修改或附加捆绑,确保文件的原始性与完整性。我们强烈建议用户支持正版软件,并通过官方渠道获取Gerbil最新版本和专业技术支持。