LM Studio(开源本地大模型部署管理工具)

- 软件版本:0.3.24

- 软件类型:综合其它

- 软件语言:简体中文

- 运行环境:Windows,MacOS,Linux

- 软件大小:516.6 MB

- 发布时间:

LM Studio是什么

LM Studio 是一款专为本地大语言模型(LLM)部署、运行和管理设计的桌面应用程序,支持 macOS、Windows 和 Linux 系统。它提供了一个简单、灵活的界面,让用户可以轻松下载、运行和管理本地语言模型,如 gpt-oss、Llama、Qwen、Mistral、DeepSeek R1 等。LM Studio 还支持与 MCP 服务器 连接,实现更强大的模型扩展能力。

LM Studio 是一个面向开发者和研究人员的本地语言模型管理工具,其核心目标是让用户能够在本地环境中高效运行和测试各种开源大语言模型。它不仅支持多种主流模型格式(如 llama.cpp(GGUF) 和 MLX(仅限 Apple Silicon Mac)),还提供 API 接口、文档交互、模型服务等功能,适合从初学者到高级用户的广泛人群。

软件功能

1. 模型下载与运行

支持从 Hugging Face 搜索并下载主流 LLM 模型。

提供本地运行支持,无需联网即可使用。

2. 模型管理

可以查看、删除、配置本地模型。

支持多种模型格式:llama.cpp(GGUF)、MLX(Mac)等。

3. 模型服务与 API

提供 OpenAI 类似的本地模型服务接口。

支持 REST API,可用于集成到用户自己的应用或脚本中。

4. 文档交互(RAG)

支持在本地离线状态下与文档进行交互,即“检索增强生成”(RAG)。

可上传文档并直接在聊天界面中进行问答。

5. MCP 服务器连接

支持安装和连接 MCP 服务器,实现模型功能扩展。

开发者可参考文档开发自己的 MCP 插件。

6. 聊天界面

提供简洁的聊天界面,支持多轮对话、上下文管理。

支持 Markdown 格式输出。

软件特色

1. 跨平台支持

完美兼容 macOS(Apple Silicon)、Windows(x64/ARM64) 和 Linux(x64)。

2. 本地运行,隐私安全

所有数据和模型均运行在本地,确保数据隐私与安全。

3. 开源友好

支持多种开源模型格式,适合研究与开发使用。

4. 高性能优化

利用 Apple MLX 框架(Mac)或 llama.cpp(跨平台)实现高效推理。

使用方法

1. 安装软件

在本站下载对应操作系统的安装包。

安装后启动 LM Studio。

2. 下载模型

在软件内搜索并下载所需模型(如 Llama、Qwen 等)。

模型将自动下载到本地目录。

3. 加载与运行模型

在模型管理界面选择已下载模型并加载。

使用聊天界面进行对话或调用 API 接口。

4. 使用文档交互功能

点击“上传文档”按钮,上传 PDF、TXT、DOCX 等格式文件。

在聊天界面中输入问题,模型将基于文档内容回答。

5. 配置 MCP 服务器(可选)

安装 MCP 插件并通过软件界面连接服务器。

实现模型功能扩展(如代码执行、知识库查询等)。

6. 使用 API 接口(开发者)

启动模型服务后,通过本地或网络访问 REST API。

可用于集成到 Web 应用、Python 脚本等。

收费价格

LM Studio 是一款完全免费的开源软件,用户无需支付任何费用即可下载和使用全部功能。目前没有提供付费版本或订阅服务,所有功能均对公众开放。

注意:虽然软件本身免费,但运行大语言模型可能对硬件有一定要求(如内存、显存等),建议使用较高配置的设备以获得更好的体验。

总结

LM Studio 是一个功能强大且易于使用的本地大语言模型工具,适合希望在本地环境中高效运行和测试开源 LLM 的用户。无论是用于研究、开发还是日常使用,LM Studio 都是一个值得尝试的优秀工具。

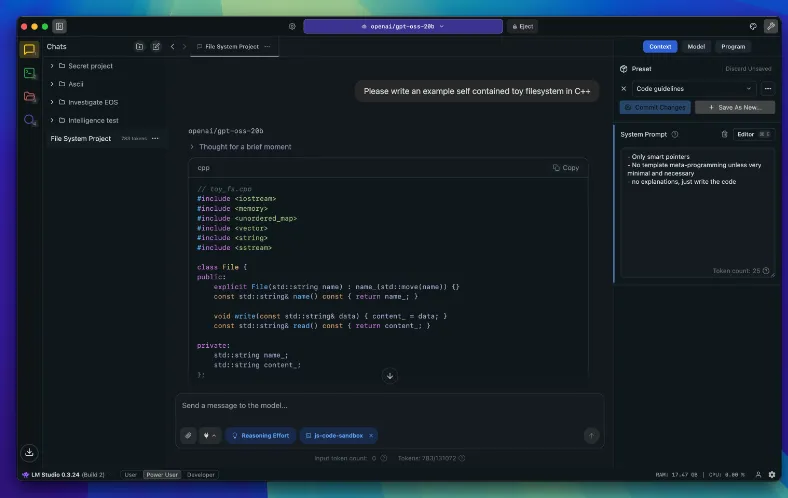

软件截图

LM Studio下载地址

版权与来源声明:AI铺子提供的LM Studio电脑客户端/APP,均转载自官方下载网站或经授权的可信分发渠道。相关软件的所有权、版权及知识产权均归原作者所有。本站不对任何软件进行二次修改或附加捆绑,确保文件的原始性与完整性。我们强烈建议用户支持正版软件,并通过官方渠道获取LM Studio最新版本和专业技术支持。