CV基础知识全解析:像素、卷积、特征提取一次搞明白

计算机视觉(Computer Vision, CV)作为人工智能的核心领域,其技术基础建立在像素处理、卷积运算与特征提取三大支柱之上。本文AI铺子将从底层原理出发,系统解析这三个关键概念的技术内涵、数学实现及工程应用,帮助读者构建完整的CV知识体系。

一、像素:计算机视觉的基石

1.1 像素的定义与表示

像素(Pixel)是数字图像的最小组成单元,代表图像在二维平面上的一个离散采样点。每个像素通过亮度值(灰度图像)或颜色向量(RGB彩色图像)存储信息:

灰度图像:单通道,像素值范围通常为0(黑)到255(白)。

RGB图像:三通道,每个通道值范围0-255,组合后表示1670万种颜色(256³)。

示例:一张1080P(1920×1080)的RGB图像包含约207万像素,每个像素由3个字节(R、G、B)存储,总数据量为1920×1080×3≈6.2MB(未压缩时)。

1.2 像素的数学模型

像素的操作可抽象为矩阵运算。设图像为 ,其中 ( H ) 为高度,( W ) 为宽度,( C ) 为通道数:

灰度图像:

,

。

RGB图像:

,

。

常见操作:

像素访问:

image[100, 200, 0]获取第100行、200列的红通道值。通道分离:通过切片操作提取单通道,如

R = image[:,:,0]。

1.3 像素级操作的应用

1.3.1 图像增强

直方图均衡化:通过非线性变换重新分配像素值,提升对比度。

import cv2

import numpy as np

img = cv2.imread('low_contrast.jpg', 0) # 读取灰度图

equ = cv2.equalizeHist(img)

cv2.imwrite('enhanced.jpg', equ)伽马校正:调整像素值非线性关系,公式为

。

1.3.2 噪声处理

高斯噪声:模拟传感器噪声,通过正态分布随机值叠加:

noise = np.random.normal(0, 25, img.shape).astype(np.uint8) noisy_img = cv2.add(img, noise)

中值滤波:用邻域像素中值替代中心像素,有效去除椒盐噪声:

denoised = cv2.medianBlur(noisy_img, 5) # 5×5邻域

二、卷积:从数学运算到视觉特征提取

2.1 卷积的定义与计算

卷积(Convolution)是通过对输入信号与卷积核的滑动点积运算,实现局部特征提取的数学操作。在CV中,输入为图像 ( I ),卷积核为 ( ),输出特征图 ( O ) 的计算如下:

关键参数:

核大小(Kernel Size):常见3×3、5×5,影响感受野。

步长(Stride):滑动步长,默认为1。

填充(Padding):在图像边缘补零,保持空间尺寸。

示例:3×3卷积核在5×5图像上以步长1、填充1计算,输出仍为5×5。

2.2 卷积的工程实现

2.2.1 手动实现

import numpy as np def conv2d(image, kernel): H, W = image.shape k_size = kernel.shape[0] pad = k_size // 2 padded = np.pad(image, ((pad, pad), (pad, pad)), 'constant') output = np.zeros((H, W)) for i in range(H): for j in range(W): output[i,j] = np.sum(padded[i:i+k_size, j:j+k_size] * kernel) return output # 示例:边缘检测核 kernel = np.array([[-1, -1, -1], [-1, 8, -1], [-1, -1, -1]]) image = np.random.randint(0, 256, (10, 10)) result = conv2d(image, kernel)

2.2.2 深度学习框架实现

PyTorch中通过nn.Conv2d实现高效卷积:

import torch import torch.nn as nn conv = nn.Conv2d(in_channels=1, out_channels=16, kernel_size=3, stride=1, padding=1) input_tensor = torch.randn(1, 1, 64, 64) # (batch, channel, height, width) output = conv(input_tensor) # 输出形状: (1, 16, 64, 64)

2.3 卷积核的类型与作用

2.3.1 预定义卷积核

| 卷积核类型 | 数学表示(3×3) | 作用 | 应用场景 |

|---|---|---|---|

| 边缘检测 | 突出亮度突变区域 | 图像分割预处理 | |

| 模糊(均值) | 平均邻域像素,降低噪声 | 图像预处理 | |

| 锐化 | 增强高频细节 | 医学影像增强 |

2.3.2 可学习卷积核

在CNN中,卷积核参数通过反向传播自动优化。例如,VGG16网络的第一层包含64个3×3卷积核,每个核学习不同的低级特征(如边缘、纹理)。

2.4 卷积的变体与优化

2.4.1 深度可分离卷积(Depthwise Separable Conv)

将标准卷积分解为深度卷积(逐通道卷积)和点卷积(1×1卷积),大幅减少参数量:

标准卷积参数量:

。

深度可分离参数量:

。

MobileNet示例:在ImageNet分类任务中,深度可分离卷积使模型参数量减少8倍,推理速度提升3倍。

2.4.2 空洞卷积(Dilated Conv)

通过在卷积核元素间插入零值扩大感受野,不增加参数量:

# PyTorch实现空洞卷积 dilated_conv = nn.Conv2d(1, 16, kernel_size=3, stride=1, padding=2, dilation=2) # 实际感受野: 5×5 (等效于标准卷积但参数量更少)

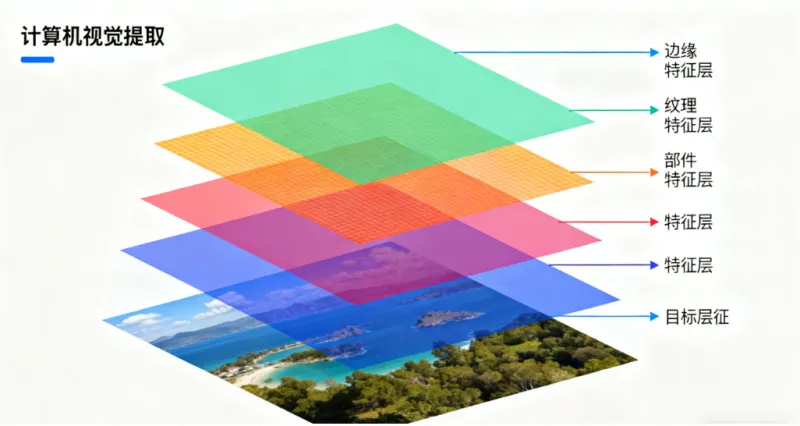

三、特征提取:从低级到高级的视觉表示

3.1 特征提取的层次化模型

计算机视觉通过多层抽象将像素转化为可解释的特征表示:

低级特征:边缘、角点、颜色块(通过Sobel算子、Canny边缘检测提取)。

中级特征:纹理、局部形状(通过SIFT、HOG描述子编码)。

高级特征:语义类别、空间关系(通过CNN深层激活值表示)。

3.2 传统特征提取方法

3.2.1 SIFT(尺度不变特征变换)

步骤:

构建高斯差分金字塔(DoG)检测尺度空间极值。

计算关键点方向(基于梯度直方图)。

生成128维描述子(4×4区域梯度统计)。

应用:图像匹配(如全景拼接)、物体识别。

3.2.2 HOG(方向梯度直方图)

步骤:

将图像划分为细胞单元(如8×8像素)。

计算每个单元的梯度方向直方图(9个bin)。

归一化块内描述子(3×3细胞单元)。

应用:行人检测(Dalal-Triggs算法在INRIA数据集上准确率达99%)。

3.3 基于深度学习的特征提取

3.3.1 CNN的特征层次

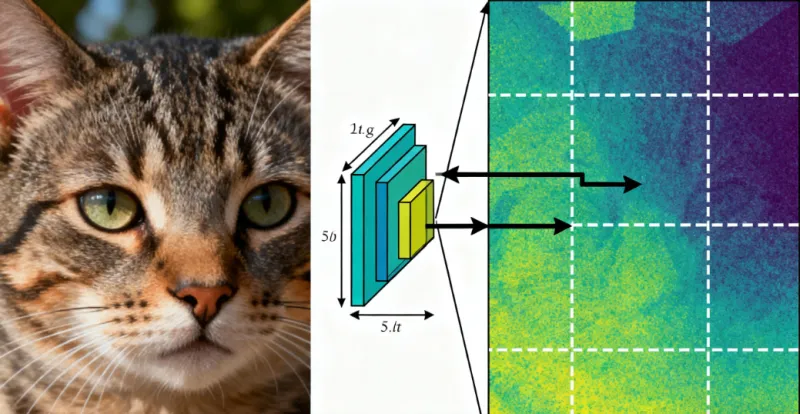

以ResNet-50为例,各层特征可视化如下:

| 网络层 | 特征可视化 | 语义级别 |

|---|---|---|

| Conv1(第一层) | 边缘、颜色块 | 极低级 |

| ResBlock2 | 纹理、局部形状(如车轮、窗户) | 低级 |

| ResBlock4 | 物体部件(如人脸五官、车轮) | 中级 |

| AvgPool(全局池化) | 完整物体类别(如车、人) | 高级 |

3.3.2 预训练模型的特征复用

通过迁移学习利用预训练模型提取特征:

import torchvision.models as models # 加载预训练ResNet(去掉最后全连接层) resnet = models.resnet50(pretrained=True) modules = list(resnet.children())[:-1] # 移除分类层 feature_extractor = nn.Sequential(*modules) # 提取特征 input_tensor = torch.randn(1, 3, 224, 224) features = feature_extractor(input_tensor) # 输出形状: (1, 2048, 7, 7)

3.4 特征可视化与解释

3.4.1 梯度加权类激活映射(Grad-CAM)

通过反向传播计算特征图对分类结果的贡献度:

# PyTorch实现Grad-CAM def grad_cam(model, input_tensor, target_class): input_tensor.requires_grad_(True) output = model(input_tensor) model.zero_grad() one_hot = torch.zeros_like(output) one_hot[0][target_class] = 1 output.backward(gradient=one_hot) # 获取最后一层卷积的梯度与特征图 gradients = model.layer4[-1].conv3.weight.grad features = model.layer4[-1].conv3.activation # 假设保存了激活值 # 计算权重并生成热力图 weights = torch.mean(gradients, dim=[2,3], keepdim=True) cam = torch.sum(weights * features, dim=1, keepdim=True) cam = torch.relu(cam) cam = cv2.resize(cam.squeeze().detach().numpy(), (224,224)) return cam

3.4.2 t-SNE降维可视化

将高维特征投影至2D平面观察类别分布:

from sklearn.manifold import TSNE

import matplotlib.pyplot as plt

# 假设features为N×2048的特征矩阵

tsne = TSNE(n_components=2)

features_2d = tsne.fit_transform(features)

plt.scatter(features_2d[:,0], features_2d[:,1], c=labels)

plt.title("t-SNE Visualization of CNN Features")

plt.show()四、像素-卷积-特征提取的工程实践

4.1 图像分类流水线

数据预处理:

调整大小至224×224。

归一化像素值至[-1,1]。

特征提取:

使用ResNet前4个Block提取特征。

分类头:

全连接层+Softmax输出1000类概率。

4.2 目标检测中的特征融合

以FPN(Feature Pyramid Network)为例,通过多尺度特征融合提升小目标检测:

# 伪代码:FPN特征融合 def fpn(features): # features为[C2, C3, C4, C5](来自ResNet不同层) P5 = nn.Conv2d(2048, 256, 1)(C5) P4 = nn.Conv2d(256, 256, 1)(C4) + nn.Upsample(scale_factor=2)(P5) P3 = nn.Conv2d(256, 256, 1)(C3) + nn.Upsample(scale_factor=4)(P5) return [P3, P4, P5] # 用于后续检测头

4.3 实时语义分割架构

UNet++通过嵌套跳跃连接优化特征传播:

# 简化版UNet++编码器-解码器 class NestedUNet(nn.Module): def __init__(self): super().__init__() self.down1 = DoubleConv(3, 64) self.down2 = Down(64, 128) self.up1 = Up(128+64, 64) # 跳跃连接融合 self.final = nn.Conv2d(64, 1, 1) # 输出单通道分割图 def forward(self, x): x1 = self.down1(x) x2 = self.down2(x1) out = self.up1(x2, x1) return torch.sigmoid(self.final(out))

五、总结

计算机视觉的基础技术链可概括为:像素作为数据载体,通过卷积运算实现局部模式提取,最终构建层次化特征表示。从传统方法(SIFT、HOG)到深度学习(CNN、Transformer),特征提取的效率和语义丰富度不断提升。在实际应用中,需根据任务需求(如实时性、精度)选择合适的特征提取策略,例如:

轻量化场景:MobileNet+深度可分离卷积。

高精度场景:ResNet+FPN多尺度特征融合。

可解释性需求:Grad-CAM特征可视化。

通过深入理解像素、卷积与特征提取的底层逻辑,开发者能够更高效地设计CV系统,平衡性能与资源消耗。

版权及免责申明:本文由@AI工具箱原创发布。该文章观点仅代表作者本人,不代表本站立场。本站不承担任何相关法律责任。

如若转载,请注明出处:https://www.aipuzi.cn/ai-tutorial/372.html