Ollama本地部署AI大模型完整图文教程(含WebUI界面)

随着人工智能技术的飞速发展,越来越多的开发者和研究人员希望能够在本地环境中部署和运行大型语言模型(LLM),以实现更高的隐私保护、更低的延迟以及更灵活的定制能力。Ollama 作为一款专为本地部署大模型而设计的开源工具,凭借其简洁的接口和高效的运行机制,迅速成为本地 AI 开发者的热门选择。本文将手把手带你完成使用Ollama 本地部署 AI 大模型的全过程,不仅涵盖模型的安装、运行与管理,还将详细介绍如何通过WebUI 界面实现更友好的交互体验,让即使是初学者也能轻松上手,快速搭建属于自己的本地 AI 大模型应用环境。

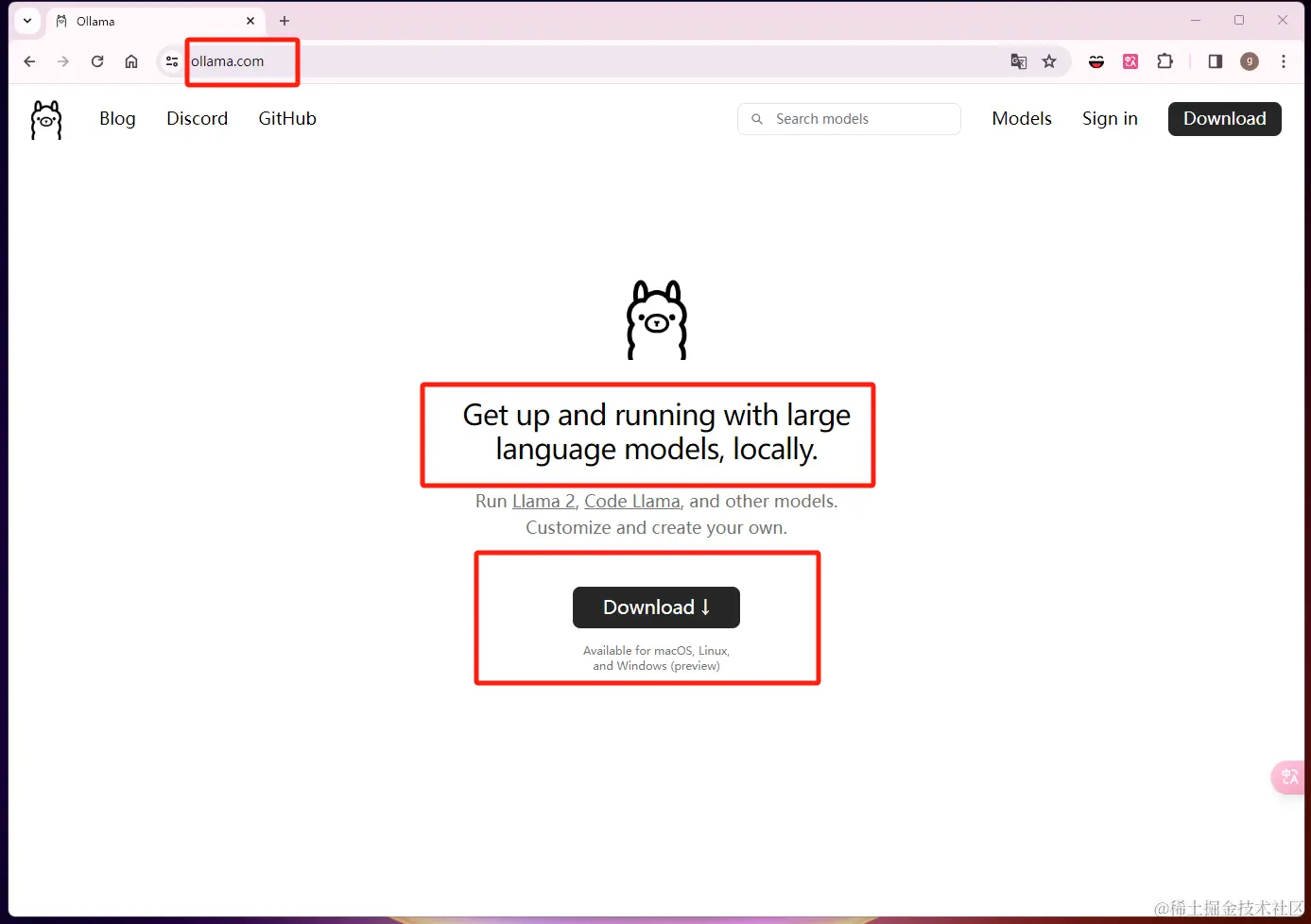

一、什么是 ollama?

在本地启动并运行大型语言模型。运行Llama 2,Code Llama和其他模型。自定义并创建您自己的。

二、why ollama?

能直接运行大模型,与大模型进行对话。

ollama 命令具有管理大模型的能力。

利用 cpu 运行大模型。

本地大模型安全可靠。

终端直接开始聊天。

社区提供了支持 web api 方式访问 WebUI。

如果你还没有尝试过在本地部署过大模型,那么 ollama 非常适合你。

三、准备工作

为了方便起见,先聊设备需求和辅助软件吧。部署大模型硬件还是要尽可能的高一些,因为文件比较大,虽然本地大模型对配置要求已经比较低了。

docker 为了方便部署软件。

存储空间充足的机器,一般来说参数越大,需要配置越好。

良好的网络环境。

四、安装 ollama?

进入 ollama 下载页面,选择自己的系统版本的下载并安装即可。

4.1)检验是否安装成功

输入 Ollama 命令,正常的得出命令行输出,表示已经安装成功,下面有 ollama 的常用命令:

ollama Usage: ollama [flags] ollama [command] Available Commands: serve Start ollama create Create a model from a Modelfile show Show information for a model run Run a model pull Pull a model from a registry push Push a model to a registry list List models cp Copy a model rm Remove a model help Help about any command Flags: -h, --help help for ollama -v, --version Show version information Use "ollama [command] --help" for more information about a command.

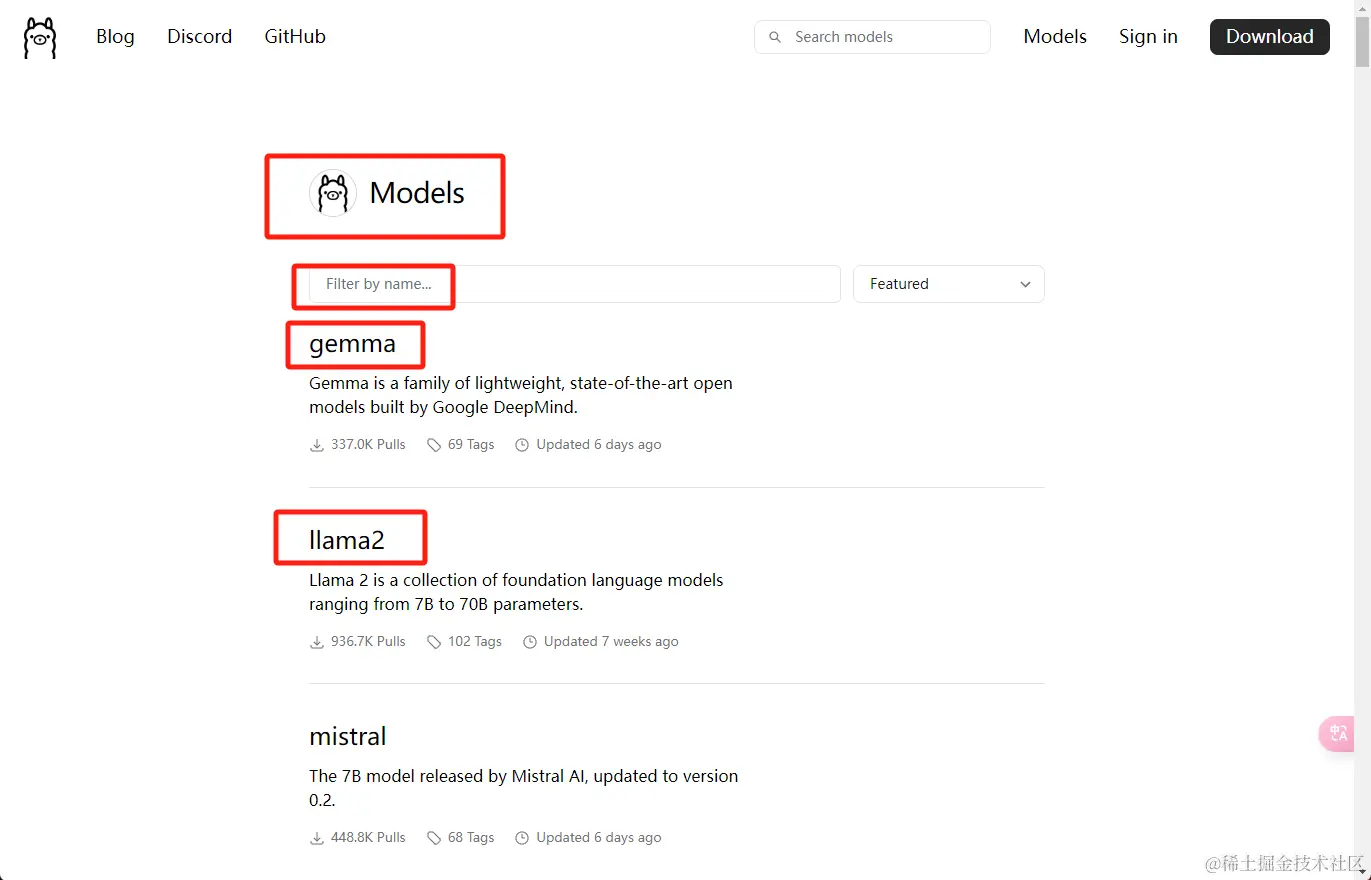

五、ollama 模型库

我们可以在 ollama.com/library 中搜索已有我们想要的模型库。以下是一些流行的模型:

| 模型 | 参数 | 尺寸 | 执行下载 |

|---|---|---|---|

| Llama 2 | 7B | 3.8GB | ollama run llama2 |

| Mistral | 7B | 4.1GB | ollama run mistral |

| Code Llama | 7B | 3.8GB | ollama run codellama |

| Llama 2 Uncensored | 7B | 3.8GB | ollama run llama2-uncensored |

| Llama 2 13B | 13B | 7.3GB | ollama run llama2:13b |

| Llama 2 70B | 70B | 39GB | ollama run llama2:70b |

| Gemma | 2B | 1.4GB | ollama run gemma:2b |

| Gemma | 7B | 4.8GB | ollama run gemma:7b |

这里大概列出了 Llama、Mistral 以及 Gemma 我们景见的模型以及参数以及尺寸大小。由图表可以看出 Gemma 2B 模型的尺寸还是比较小的,初学者入门。

六、运行模型

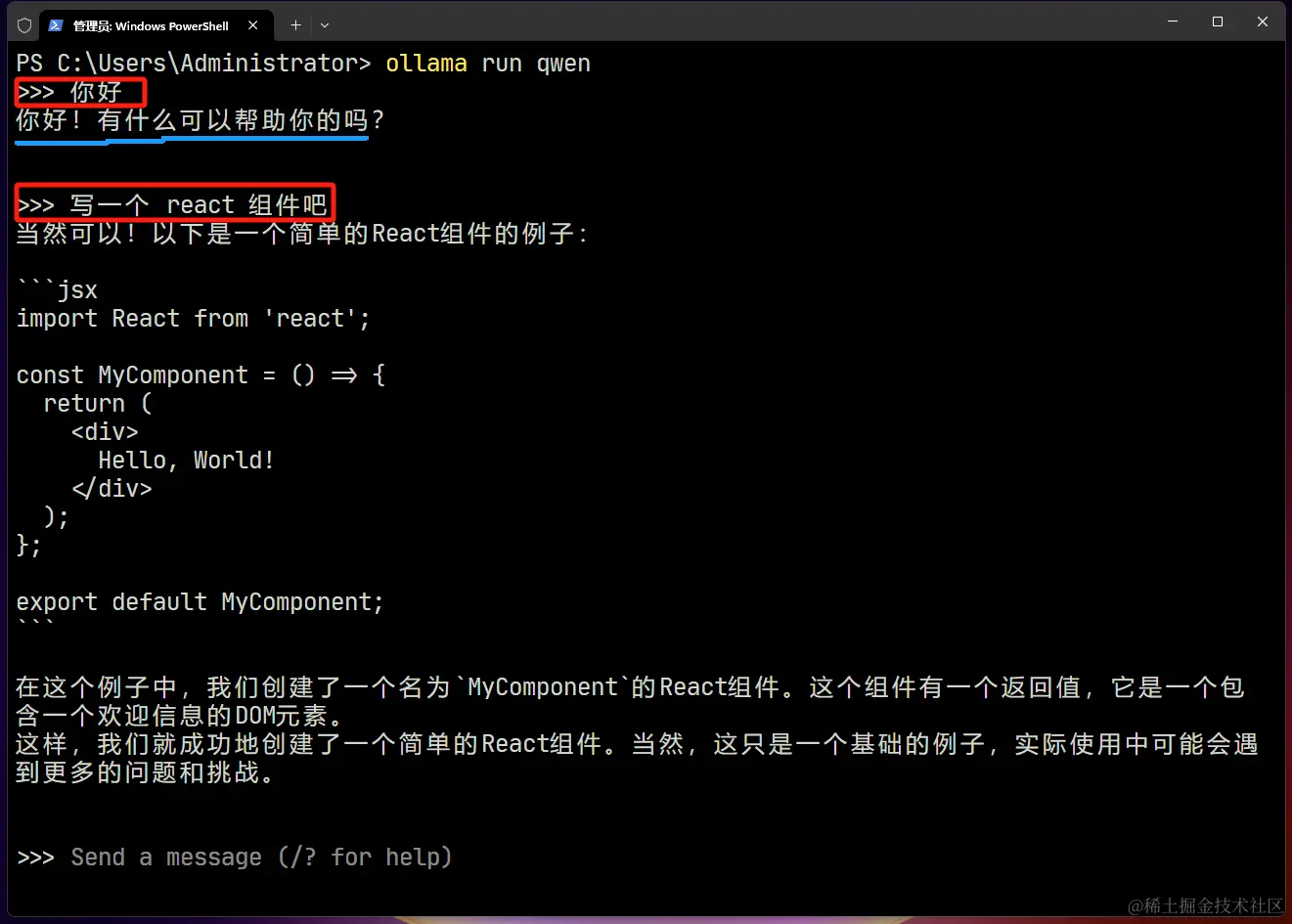

ollama run qwen # 运行千问大模型

因为qwen 模型对中文支持比较好,这里使用 qwen 模型进行聊天

直接使用 run 命令 + 模型名字就可以运行模型。如果之前没有下载过,那么会自动下载。下载完毕之后可以在终端中直接进行对话 qwen 模型了。

6.1)直接在终端中对话:用 ollama 千问模型写一个 React 组件

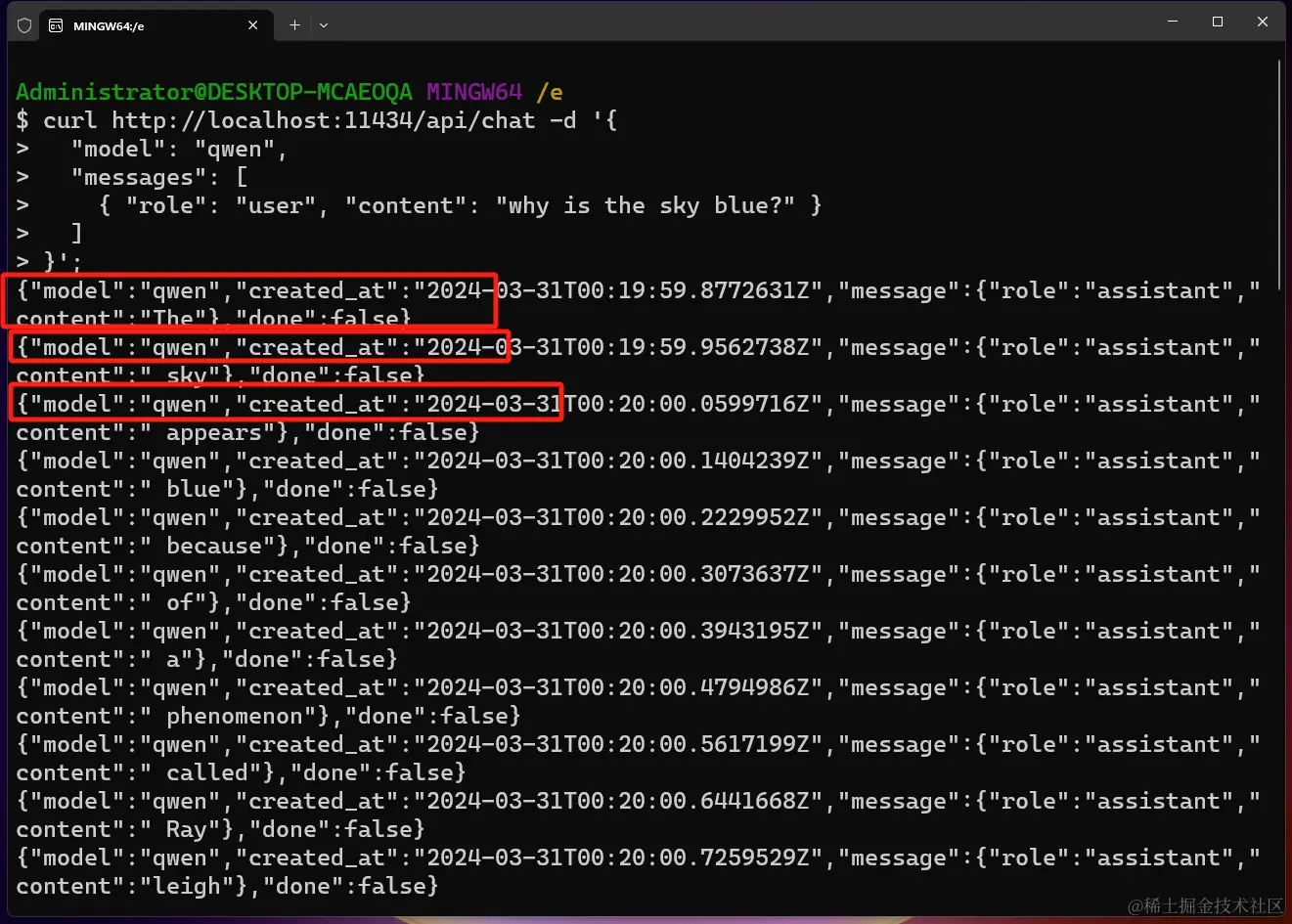

6.2)使用 api 方式运行

curl http://localhost:11434/api/chat -d '{

"model": "qwen",

"messages": [

{ "role": "user", "content": "why is the sky blue?" }

]

}'

api 访问的方式:模型在不断推送字段。我们需要自己处理。

七、推荐 Open WebUI

LLMs用户友好的WebUI(以前的Ollama WebUI)

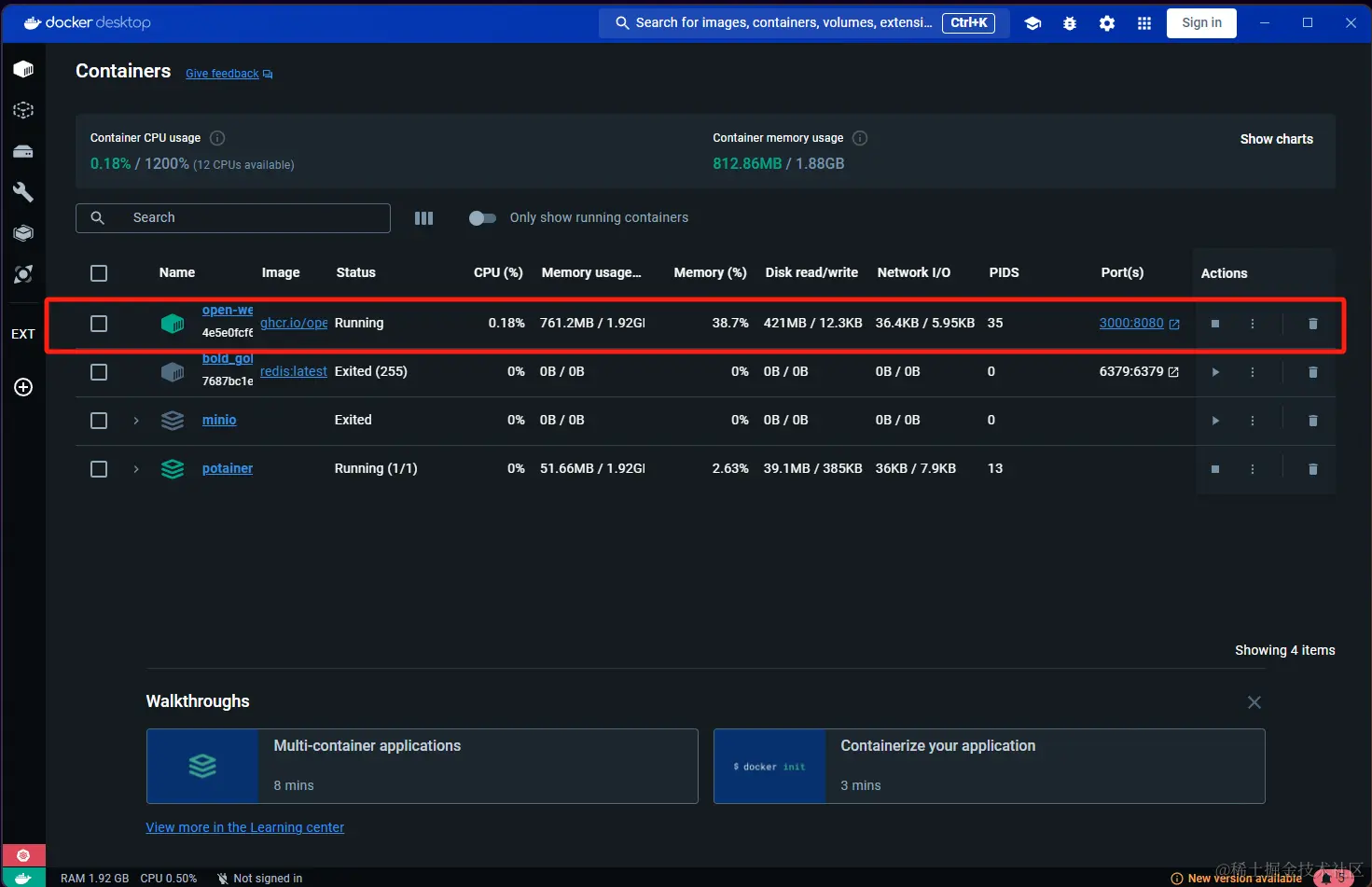

使用 docker 可以方便的部署

docker run -d -p 3000:8080 --add-host=host.docker.internal:host-gateway -v open-webui:/app/backend/data --name open-webui --restart always ghcr.io/open-webui/open-webui:main

注意 3000 时长被其他的开发程序占用,使用需要注意自己的端口是否被占用。

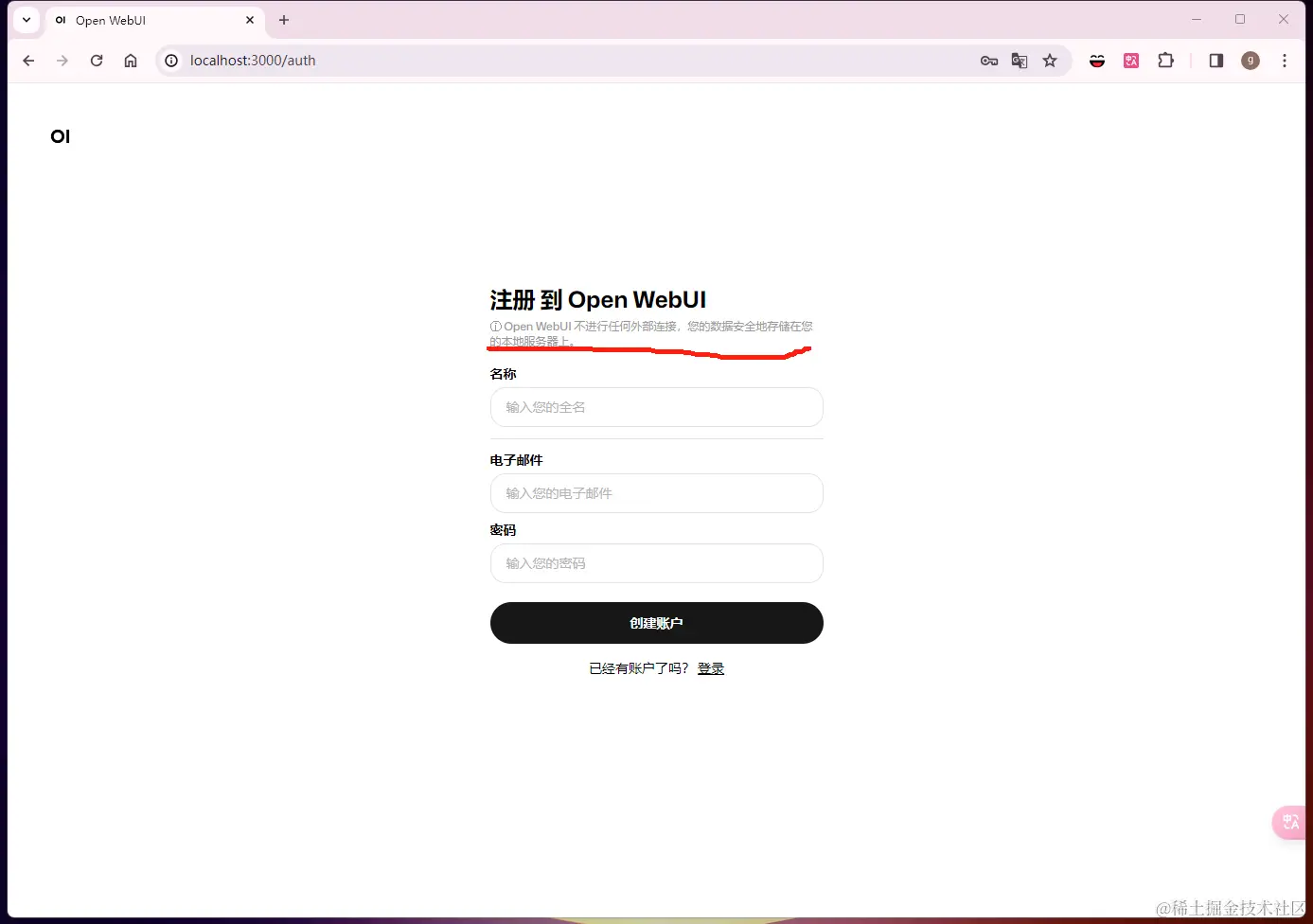

7.1)注册

用户系统注册也是本地的,没有外部链接。

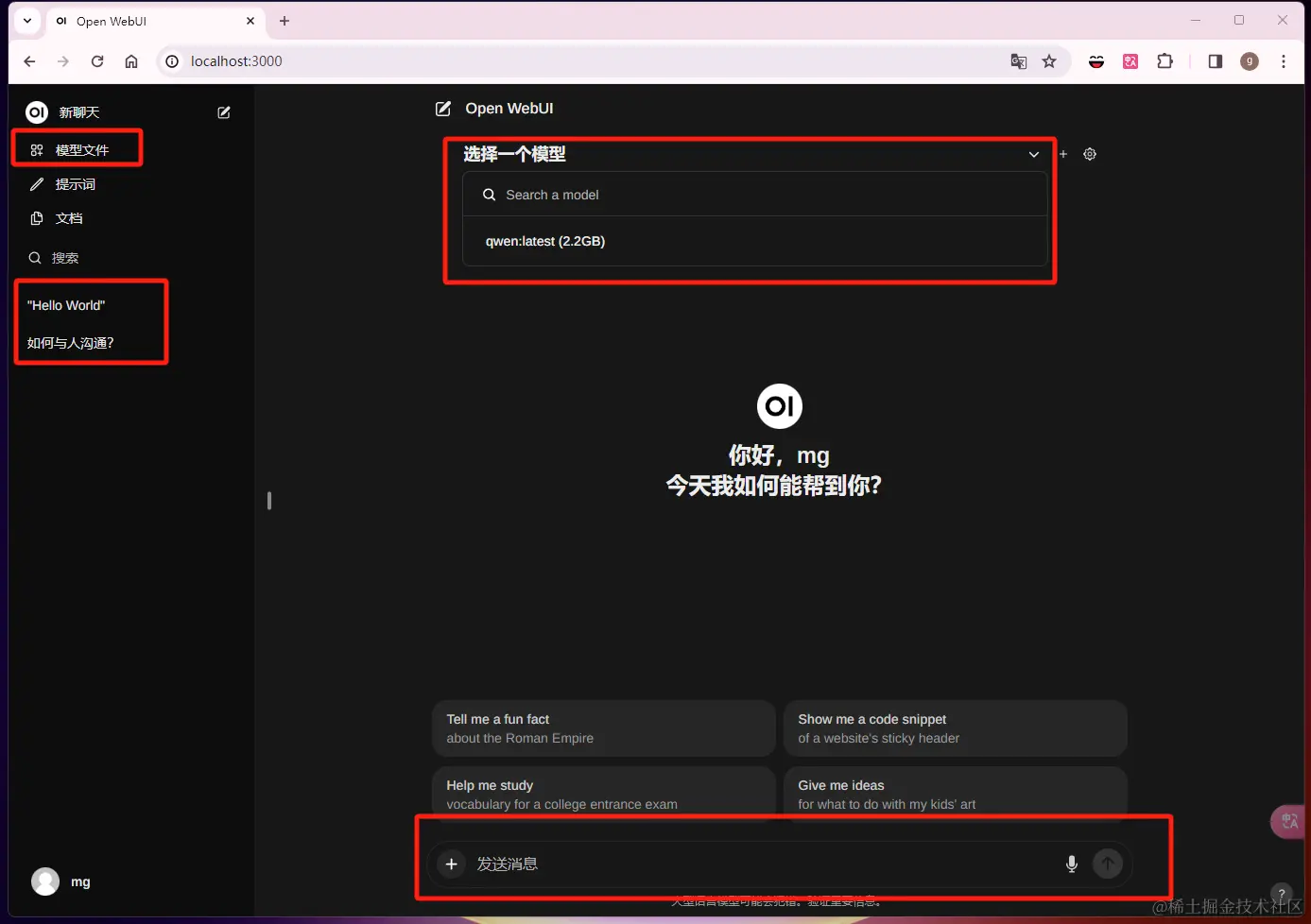

7.2)聊天界面

Open WebUI 聊天界面

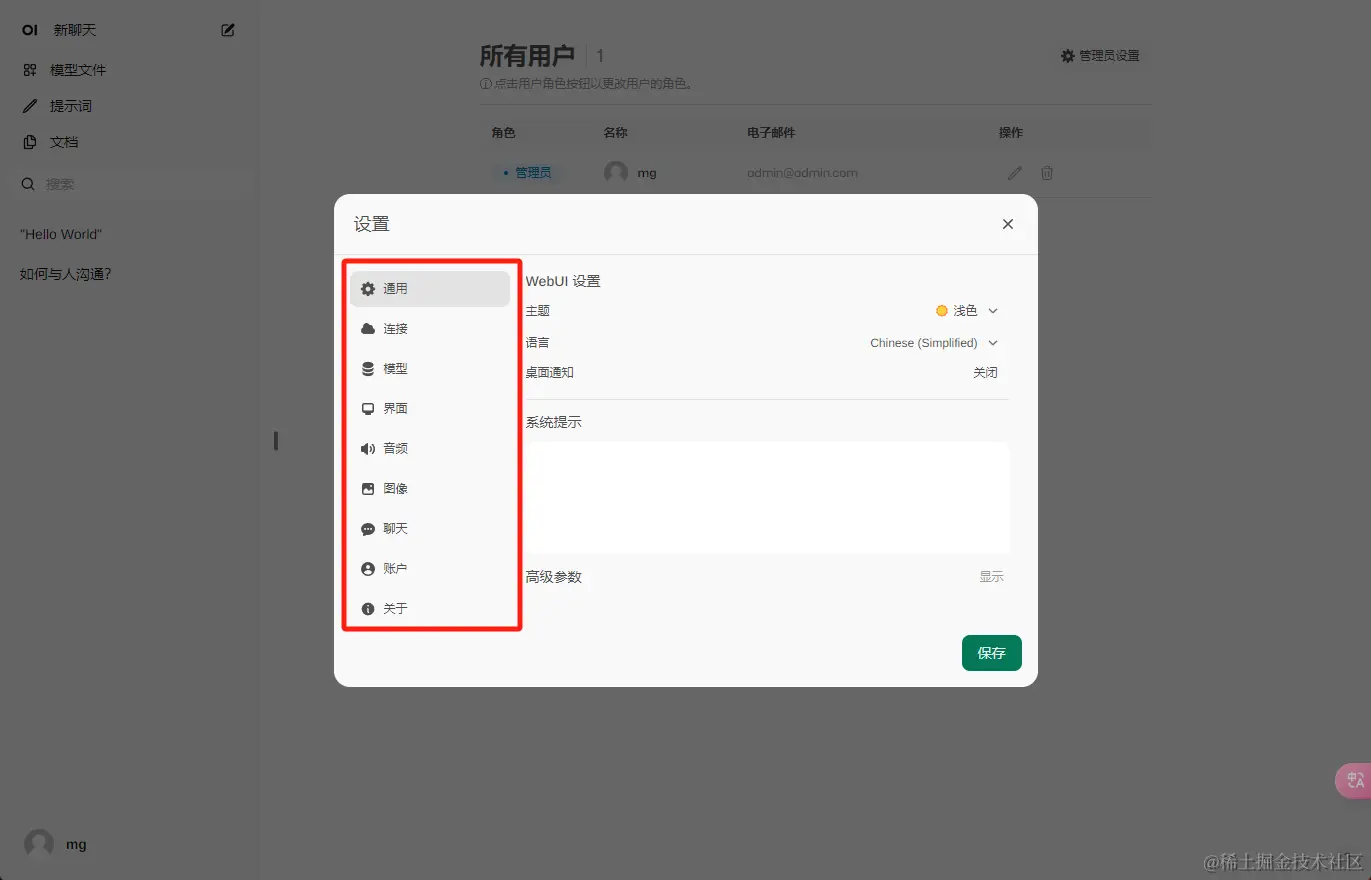

7.3)web ui 配置

八、小结

这是一篇入门 ollama 的文章,当然 ollama 的功能远不止如此,ollama 大部分代码基于 go 开发,熟悉 go 小伙伴很亲切。当然你可以自己构建自己的模型从 GGUF/pyTorch or Safetensors 等等。 ollama 的介绍就到这里了,希望能够帮助到有需要的小伙伴们。

通过本文的详细图文教程,相信你已经掌握了如何使用Ollama 在本地部署 AI 大模型,并成功配置了WebUI 界面,实现了更加直观和便捷的操作体验。Ollama 凭借其轻量高效、开源免费、本地运行等优势,为本地 AI 模型部署提供了极大的便利。无论你是 AI 爱好者、开发者,还是企业技术人员,都可以借助 Ollama 快速搭建起属于自己的本地大模型服务。随着 Ollama 社区的不断发展,未来将支持更多功能和平台,进一步推动本地 AI 技术的应用落地。现在,就让我们开始你的本地 AI 之旅吧!

相关软件下载

Ollama

版权及免责申明:本文来源于#程序员辣条,由@AI工具集整理发布。如若内容造成侵权/违法违规/事实不符,请联系本站客服处理!该文章观点仅代表作者本人,不代表本站立场。本站不承担相关法律责任。

如若转载,请注明出处:https://www.aipuzi.cn/ai-tutorial/69.html