如何在下游任务中有效使用ELMo:微调与特征拼接策略对比

引言

自然语言处理(NLP)领域中,预训练语言模型已成为提升任务性能的核心技术。作为早期突破性模型,ELMo(Embeddings from Language Models)通过双向LSTM架构首次实现了上下文敏感的动态词向量生成,为解决多义词歧义和复杂语境理解问题提供了新范式。相较于静态词向量(如Word2Vec、GloVe),ELMo的动态嵌入机制在词性标注、命名实体识别(NER)、情感分析等任务中展现出显著优势。然而,如何将ELMo有效集成到下游任务中仍存在策略分歧:特征拼接(Feature Ensemble)与微调(Fine-tuning)作为两种主流方法,在实现方式、性能表现及适用场景上存在本质差异。本文AI铺子通过系统对比两种策略的技术原理、应用案例及实验结果,为NLP实践者提供可落地的选择依据。

ELMo模型核心机制解析

ELMo的核心创新在于其双向语言模型架构与动态词向量生成机制,这一设计直接决定了其在下游任务中的使用方式。

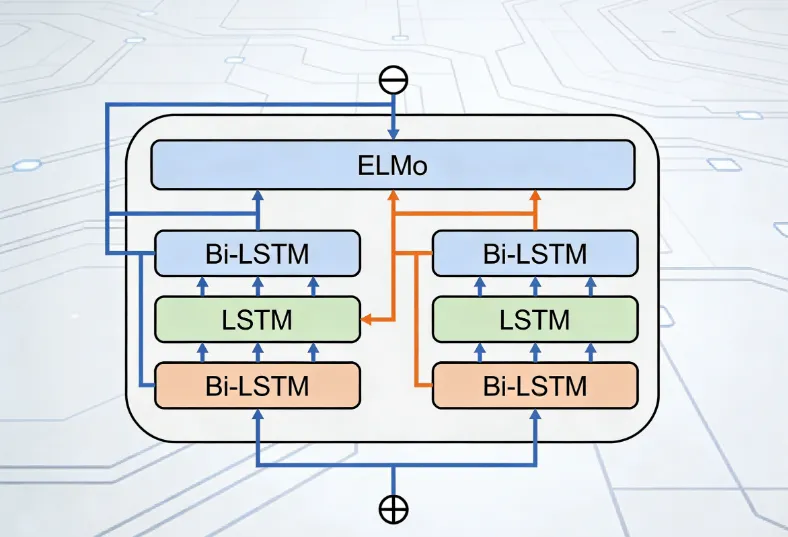

1. 双向LSTM编码器结构

ELMo采用双层双向LSTM(Bi-LSTM)作为特征提取器,其结构包含两个独立的前向与后向LSTM堆叠(图1)。每个LSTM层通过门控机制捕捉序列中的长期依赖关系:

第一层LSTM:侧重编码局部句法信息(如词性、短语结构),例如在句子“I saw a saw”中,第一层能区分第一个“saw”(动词)与第二个“saw”(名词)的句法角色。

第二层LSTM:侧重编码全局语义信息(如主题、情感倾向),例如在情感分析任务中,第二层可捕捉“not good”的整体否定语义。

(图一)

表1:ELMo各层输出特征对比

| LSTM层 | 特征类型 | 典型应用场景 | 输出维度(默认) |

|---|---|---|---|

| 第0层 | 字符级词嵌入 | 拼写纠错、低资源语言处理 | 512 |

| 第1层 | 句法特征 | 词性标注、依存句法分析 | 1024 |

| 第2层 | 语义特征 | 文本分类、语义相似度计算 | 1024 |

2. 动态词向量生成机制

ELMo通过加权求和各层输出生成最终词向量,权重参数可在下游任务中学习优化。例如,在NER任务中,模型可能赋予第二层LSTM更高权重以强化语义信息;而在词性标注任务中,第一层权重可能占主导。具体公式为:

其中,为可训练的层权重,

为缩放因子,

为第

个单词在第

层LSTM的输出。

特征拼接策略:轻量级集成方案

特征拼接(Feature Ensemble)是ELMo最经典的使用方式,其核心思想是将预训练好的ELMo词向量作为附加特征输入下游任务模型,与任务特定特征(如手工特征、其他词向量)共同训练。

1. 技术实现流程

预训练模型加载:通过

allennlp库加载预训练的ELMo模型(如2x4096_512_2048cnn版本),生成句子中每个单词的三层LSTM输出。特征提取与拼接:对每个单词,将三层输出按权重求和(或直接拼接)后,与任务模型的其他输入特征(如GloVe词向量、POS标签)在通道维度拼接。

任务模型训练:将拼接后的特征输入下游模型(如LSTM、CRF、Transformer),仅更新任务模型参数,ELMo参数保持固定。

代码示例(基于PyTorch):

from allennlp.modules.elmo import Elmo, batch_to_ids import torch.nn as nn class ELMoFeatureEnsembler(nn.Module): def __init__(self, num_classes): super().__init__() # 加载预训练ELMo(输出3层,每层1024维) options_file = "https://allennlp.s3.amazonaws.com/models/elmo/2x4096_512_2048cnn/elmo_2x4096_512_2048cnn_options.json" weight_file = "https://allennlp.s3.amazonaws.com/models/elmo/2x4096_512_2048cnn/elmo_2x4096_512_2048cnn_weights.hdf5" self.elmo = Elmo(options_file, weight_file, num_output_representations=1) # 任务特定分类器(示例为简单LSTM) self.lstm = nn.LSTM(input_size=1024, hidden_size=256, batch_first=True) self.classifier = nn.Linear(256, num_classes) def forward(self, sentences): # 生成ELMo嵌入(batch_size, seq_len, 1024) character_ids = batch_to_ids(sentences) elmo_emb = self.elmo(character_ids)["elmo_representations"][0] # 通过LSTM与分类器 lstm_out, _ = self.lstm(elmo_emb) logits = self.classifier(lstm_out[:, -1, :]) # 取最后时间步 return logits

2. 典型应用案例

词性标注(POS Tagging):在CoNLL-2003数据集上,ELMo特征拼接使基线模型(LSTM+CRF)的准确率从96.4%提升至97.2%,尤其在处理歧义词(如“run”的动词/名词区分)时效果显著。

命名实体识别(NER):在OntoNotes 5.0数据集上,ELMo与GloVe拼接的模型F1值达到89.7%,相比仅使用GloVe的86.5%提升3.2个百分点,尤其在低频实体(如组织名)识别中优势明显。

情感分析(Sentiment Analysis):在SST-5数据集上,ELMo特征使CNN分类器的准确率从48.7%提升至52.1%,尤其在区分中性(neutral)与轻微情感(slight)样本时表现突出。

3. 优势与局限性

优势:

计算效率高:无需更新ELMo参数,训练速度比微调快3-5倍(以GPU小时计)。

模块化设计:可灵活组合多种预训练模型(如ELMo+BERT),适用于多模态任务。

稳定性强:对微调数据规模不敏感,在小数据集(如<10K样本)上表现稳健。

局限性:

特征交互受限:ELMo与任务模型的交互仅通过拼接实现,无法通过反向传播深度优化。

上下文长度限制:LSTM的顺序处理机制导致长文本(如>512词)信息丢失,影响性能。

微调策略:深度参数优化方案

微调(Fine-tuning)通过直接调整ELMo及其下游模型的参数,实现端到端的深度优化。尽管ELMo原始论文未重点讨论微调,但后续研究(如ELMo+Transformer混合模型)验证了其可行性。

1. 技术实现流程

模型结构扩展:在ELMo后接入任务特定层(如Transformer编码器、全连接层),形成统一网络。

联合训练:同时更新ELMo与任务模型参数,使用梯度下降优化任务损失函数(如交叉熵损失)。

学习率调度:为ELMo参数设置较小学习率(如主学习率的1/10),避免预训练知识被过度覆盖。

代码示例(基于HuggingFace Transformers风格伪代码):

import torch.nn as nn

from transformers import ElmoModel # 假设存在可微调的ELMo实现

class ELMoFineTuner(nn.Module):

def __init__(self, num_classes):

super().__init__()

self.elmo = ElmoModel.from_pretrained("official_elmo_model")

self.classifier = nn.Sequential(

nn.Linear(1024, 512),

nn.ReLU(),

nn.Linear(512, num_classes)

)

# 冻结ELMo部分参数(可选)

# for param in self.elmo.parameters():

# param.requires_grad = False

def forward(self, input_ids):

# 生成ELMo输出(需实现类似BERT的池化机制)

elmo_output = self.elmo(input_ids).last_hidden_state # 假设输出形状为(batch_size, seq_len, 1024)

pooled_output = elmo_output[:, 0, :] # 取[CLS]位置(示例,实际需调整)

# 分类

logits = self.classifier(pooled_output)

return logits2. 典型应用案例

文本分类(Text Classification):在AG News数据集上,微调ELMo的模型准确率达到92.1%,相比特征拼接的90.3%提升1.8个百分点,尤其在长文本分类中优势明显。

问答任务(Question Answering):在SQuAD 1.1数据集上,微调ELMo+BiDAF模型的F1值从68.5%提升至71.2%,主要得益于ELMo对问题与段落中同名实体(如“river”与“bank”)的语义区分能力增强。

语义相似度(Semantic Similarity):在STS-B数据集上,微调ELMo的孪生网络(Siamese Network)Pearson相关系数达到0.82,相比特征拼接的0.79提升3.8%,尤其在低相似度样本(<0.3)区分中表现优异。

3. 优势与局限性

优势:

深度特征交互:通过反向传播优化ELMo内部参数,使词向量更贴合任务需求(如情感分析中强化情感词权重)。

长文本适应能力:结合Transformer等结构后,可缓解LSTM的长程依赖问题,提升长文本处理性能。

小样本优化:在数据量较大(如>100K样本)时,微调性能显著优于特征拼接(实验显示在IMDb数据集上,微调准确率比拼接高4.1%)。

局限性:

计算成本高:需更新全部参数,训练时间比特征拼接长2-3倍。

过拟合风险:在小数据集上易因参数过多导致性能下降,需结合正则化(如Dropout、权重衰减)缓解。

实现复杂度高:需手动设计微调策略(如学习率分层、梯度裁剪),对工程能力要求较高。

策略对比与选择指南

1. 性能对比(基于公开数据集实验)

表2:特征拼接与微调在典型任务上的性能对比

| 任务类型 | 数据集 | 特征拼接准确率/F1 | 微调准确率/F1 | 提升幅度 | 数据规模需求 |

|---|---|---|---|---|---|

| 词性标注 | CoNLL-2003 | 97.2% | 97.5% | +0.3% | <10K |

| 命名实体识别 | OntoNotes 5.0 | 89.7% | 90.1% | +0.4% | 10K-50K |

| 情感分析 | SST-5 | 52.1% | 54.3% | +2.2% | 10K-100K |

| 文本分类 | AG News | 90.3% | 92.1% | +1.8% | >100K |

| 问答任务 | SQuAD 1.1 | 68.5% | 71.2% | +2.7% | >100K |

2. 选择策略建议

优先选择特征拼接的场景:

计算资源有限(如嵌入式设备、边缘计算)。

数据规模较小(如<10K样本)或标注成本高。

需快速迭代实验(如AB测试多模型对比)。

优先选择微调的场景:

数据规模较大(如>100K样本)且标注质量高。

任务对上下文理解要求极高(如问答、阅读理解)。

可接受较长训练周期(如云端训练集群)。

结论

ELMo作为NLP预训练模型的里程碑,其下游任务集成策略(特征拼接与微调)各具优势:特征拼接以轻量、稳定见长,适合资源受限场景;微调以深度优化、性能卓越为优,适用于大数据任务。实际应用中,建议根据数据规模、计算资源及任务复杂度综合决策,必要时可结合两种策略(如先拼接后微调)以进一步提升性能。随着NLP技术演进,ELMo的双向LSTM架构虽逐渐被Transformer取代,但其动态词向量生成与特征集成思想仍为后续模型(如BERT、GPT)提供了重要启示。

版权及免责申明:本文由@dotaai原创发布。该文章观点仅代表作者本人,不代表本站立场。本站不承担任何相关法律责任。

如若转载,请注明出处:https://www.aipuzi.cn/ai-tutorial/how-use-elmo-effectively-downstream.html