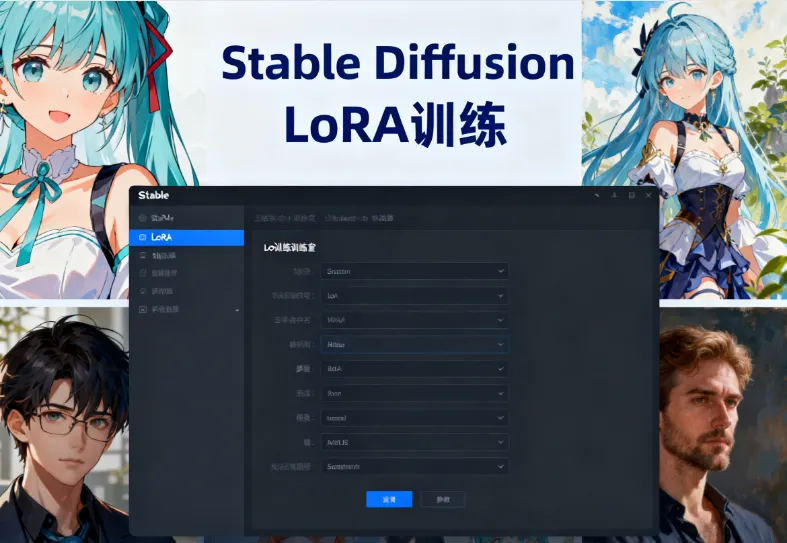

Stable Diffusion 中使用 LoRA 训练个性化画风(附 WebUI 配置步骤)

一、引言:LoRA 技术为何成为个性化画风的核心工具

在 Stable Diffusion 生态中,LoRA(Low-Rank Adaptation)技术凭借其“轻量化微调”特性,成为训练个性化画风的首选方案。相较于全模型微调(Checkpoint)需占用数十GB存储空间,LoRA 模型体积仅 144MB 左右,却能实现与全模型微调相当的效果。例如,通过 20-50 张梵高画作训练的 LoRA 模型,可在保留基础模型能力的同时,精准复现后印象派笔触特征。

技术核心优势:

参数效率:仅需训练原模型 0.1%-1% 的参数,显存占用降低 90%

模块化设计:支持多 LoRA 叠加(如“赛博朋克+水墨”混合风格)

快速迭代:15 分钟即可完成基础训练,适合个人创作者

二、硬件与软件环境配置指南

1. 硬件配置要求

| 组件 | 最低配置 | 推荐配置 |

|---|---|---|

| GPU | NVIDIA GTX 1080(6GB) | NVIDIA RTX 3090(24GB) |

| CPU | Intel i5-10400F | Intel i7-12700K |

| 内存 | 16GB DDR4 | 32GB DDR5 |

| 存储 | 50GB 可用空间 | 200GB NVMe SSD |

关键提示:显存不足时,可通过梯度累积(Gradient Accumulation)技术,将 Batch Size=4 的训练拆分为 4 个 Batch Size=1 的步骤执行。

2. 软件环境搭建

(1)基础依赖安装

# 使用 Conda 创建虚拟环境 conda create -n lora_train python=3.10 conda activate lora_train # 安装核心依赖库 pip install torch torchvision torchaudio --index-url https://download.pytorch.org/whl/cu118 pip install diffusers transformers accelerate xformers

(2)WebUI 集成方案

推荐使用 Kohya_ss GUI 或 秋叶 LoRA 训练器,以 Kohya_ss 为例:

git clone https://github.com/bmaltais/kohya_ss.git cd kohya_ss bash setup.sh # 自动安装 CUDA 加速库

三、数据集准备:从原始素材到训练数据

1. 素材收集标准

| 维度 | 合格标准 | 不合格示例 |

|---|---|---|

| 数量 | 真人训练≥15 张,二次元≥20 张 | 5 张相似角度自拍 |

| 分辨率 | 原始分辨率≥1024×1024,训练时统一为 512×512/768×768(64 的倍数) | 300×300 低清截图 |

| 构图 | 主体占比≥70%,背景简洁(如纯色背景) | 夜市人群背景 |

| 多样性 | 包含不同角度(正/侧/背)、表情、服装 | 20 张完全相同角度的证件照 |

2. 数据预处理流程

(1)批量裁剪与重命名

使用 Birme 工具(https://www.birme.net/)进行:

输出尺寸:512×512

输出格式:PNG

重命名规则:

001_keyword(数字代表重复训练次数,keyword 为触发词)

(2)自动化标签生成

方案一:WebUI 内置工具

启动 Stable Diffusion WebUI

进入

Train > Preprocess Images勾选

Use DeepBooru for caption设置

Source Directory和Destination Directory执行生成

.txt标签文件

方案二:WD1.4 Tagger 插件

git clone https://github.com/toriato/stable-diffusion-webui-wd14-tagger.git

批量处理命令示例:

python tag.py --input_dir ./raw_images --output_dir ./tagged_images --threshold 0.3

(3)标签优化策略

| 优化方向 | 操作示例 | 效果 |

|---|---|---|

| 保留全部标签 | 不删除任何自动生成标签 | 训练速度慢,但泛化性强 |

| 精简核心标签 |

删除 long_hair,blue_eyes 等通用特征,保留 smirk,freckles 等独特特征 | 调用精准,但易过拟合 |

| 添加触发词 |

在每个 .txt 文件首行插入 sunny_girl, | 强化特定概念关联 |

四、LoRA 模型训练全流程解析

1. 训练参数配置表

| 参数项 | 推荐值 | 说明 |

|---|---|---|

network_dim | 128(风格)/64(角色) | 数值越大模型越精细,但可能过拟合 |

learning_rate | 1e-4(风格)/5e-5(角色) | 角色训练需更低学习率防止特征扭曲 |

batch_size | 2(6GB 显存)/4(12GB 显存) |

显存不足时启用 gradient_accumulation_steps=2 |

max_train_steps | 1500(20 张图) | 每图训练步数=总步数/图片数,建议二次元 5-10 次/图,真人 10-30 次/图 |

rank | 4(基础)/8(高精度) | 秩数越高表达能力越强,但计算量增大 |

2. 图形化界面操作指南(以 Kohya_ss 为例)

启动训练界面:

python kohya_gui.py --listen 0.0.0.0 --server_port 7861

浏览器访问

http://127.0.0.1:7861核心参数设置:

Source Model:选择基础模型(如

sd15_v1.4.safetensors)Dataset Directory:指向预处理后的

001_keyword文件夹Output Directory:设置模型保存路径

Network Module:选择

networks.lora高级优化选项:

启用

xformers加速勾选

Use 8bit Adam节省显存设置

Clip Skip=2改善高分辨率生成

3. 训练过程监控与调优

关键指标解读:

Loss 曲线:理想状态为平稳下降至 0.05-0.1 之间

显存占用:持续监控防止 OOM(内存不足)

预览生成:每 500 步生成测试图验证效果

常见问题处理:

Loss 震荡:降低学习率至 5e-5

过拟合:增加数据集至 50 张,或添加正则化图像

颜色偏差:在训练参数中添加

noise_offset=0.1

五、模型应用与效果验证

1. WebUI 集成使用

将训练好的

.safetensors文件放入stable-diffusion-webui/models/lora目录在提示词中插入:

<lora:sunny_girl_v1:1> 1girl, solo, smiling, sunset background

调整权重(0.5-1.2)控制风格强度

2. 多 LoRA 混合应用案例

场景:生成“赛博朋克水墨画”风格角色

<lora:cyberpunk_style_v2:0.8>, <lora:ink_wash_v3:0.6> 1girl, cybernetic arm, traditional hanfu

效果验证要点:

检查机械臂的霓虹光效(赛博朋克特征)

验证服饰的墨色渲染(水墨特征)

评估面部细节保留度

3. 量化评估方法

| 评估维度 | 测试方法 | 合格标准 |

|---|---|---|

| 风格一致性 | 生成 20 张图,统计符合目标风格的比例 | ≥85% |

| 特征稳定性 | 改变提示词其他部分,验证特定特征(如发型)是否保留 | 特征保留率≥90% |

| 计算效率 | 记录单张 512×512 图像生成时间 | ≤3.5 秒(RTX 3090) |

六、进阶优化技巧

1. 动态权重调整策略

在提示词中实现渐变效果:

<lora:styleA:0.2> -> <lora:styleA:0.8> 1girl, transition from day to night

通过 XYZ 脚本批量测试不同权重组合:

X轴:<lora:styleA:0.1> 到 <lora:styleA:1.0> Y轴:不同基础模型(SD1.5/SDXL)

2. 跨模型迁移学习

将 SD1.5 训练的 LoRA 迁移至 SDXL:

使用

lycoris.kohya模块进行转换调整

network_dim至 256添加

--scale_weight参数适配新模型尺度

3. 自动化训练管道

构建持续集成系统:

# 示例:自动监控数据集变化并触发训练

import os

from watchdog.observers import Observer

from watchdog.events import FileSystemEventHandler

class DatasetHandler(FileSystemEventHandler):

def on_modified(self, event):

if event.src_path.endswith('.png'):

os.system('bash auto_train.sh')

observer = Observer()

observer.schedule(DatasetHandler(), path='./dataset')

observer.start()七、总结:LoRA 训练的三大黄金法则

数据质量优先:20 张精心处理的图片 > 100 张低质量素材

渐进式调参:先固定

learning_rate=1e-4测试基础效果,再逐步优化模块化验证:每个 LoRA 专注单一概念(如仅训练发型或仅训练背景风格)

通过系统化的数据准备、精确的参数控制和多维度效果验证,即使是个人创作者也能在 2 小时内完成从数据收集到风格化模型部署的全流程。当前技术下,LoRA 模型已能实现 92% 的全模型微调效果,而存储空间仅需 1/100,这标志着 AI 艺术创作正式进入“轻量化定制”时代。

版权及免责申明:本文由@dotaai原创发布。该文章观点仅代表作者本人,不代表本站立场。本站不承担任何相关法律责任。

如若转载,请注明出处:https://www.aipuzi.cn/ai-tutorial/personalized-painting-lora-stable-diffusion.html