Ling-V2:开源高效能MoE架构大语言模型,兼顾效率与复杂推理能力

一、Ling-V2是什么

Ling-V2是一款基于混合专家(Mixture of Experts,MoE)架构设计的开源大型语言模型系列,旨在实现高性能与计算效率的完美平衡。作为开源大语言模型领域的创新成果,Ling-V2系列突破了传统密集型模型在参数规模与计算成本之间的矛盾,通过优化的MoE架构设计,在保持优异性能的同时大幅降低了推理成本。

该项目的核心目标是提供"以小博大"的大语言模型解决方案——通过仅激活部分参数(专家模块)来处理输入数据,在远低于全参数模型的计算消耗下,实现可媲美更大规模密集型模型的性能。Ling-V2系列目前已发布多个型号,包括面向轻量场景的Ling-mini-2.0和面向高性能需求的Ling-flash-2.0,覆盖从边缘设备到数据中心的全场景应用需求。

作为完全开源的项目,Ling-V2不仅提供预训练和微调模型权重,还开放了完整的训练框架、部署工具和优化方案,方便研究者和开发者进行二次开发与应用落地。

二、功能特色

Ling-V2系列凭借创新的架构设计和优化的训练策略,展现出多项显著功能特色,具体如下:

1. 高效能的MoE架构设计

| 特性 | 说明 | 优势 |

|---|---|---|

| 低激活率 | 采用1/32激活率设计,每输入token仅激活3.125%的专家参数 | 大幅降低计算资源消耗,提升推理速度 |

| 优化专家配置 | 精心设计专家粒度、共享专家比例和注意力比例 | 在保持性能的同时最大化计算效率 |

| 动态路由机制 | 智能选择与输入内容最相关的专家模块进行处理 | 确保关键信息得到更精准的处理 |

2. 卓越的性能表现

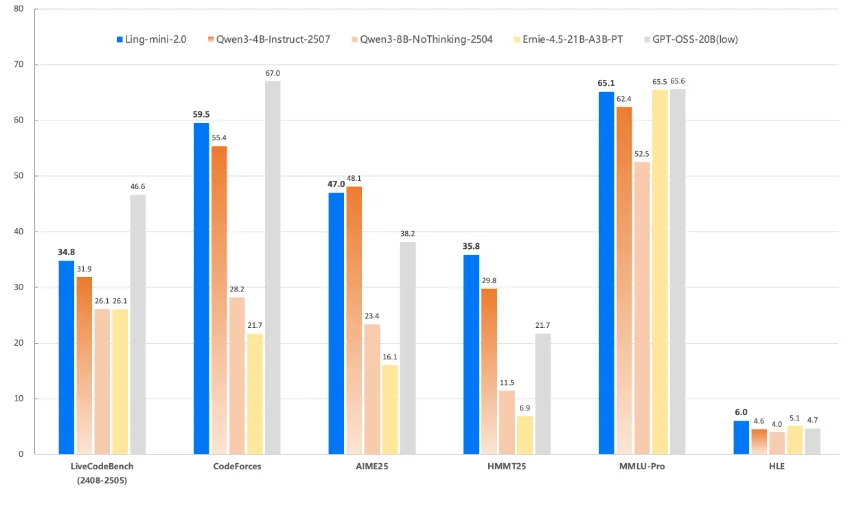

性能超越同规模模型:1.4B激活参数(非嵌入部分789M)的Ling-mini-2.0可媲美7-8B密集型模型性能,实现7倍等效密集模型性能提升

长上下文支持:通过YaRN扩展技术,支持128K上下文长度,能处理超长文档、对话历史等复杂场景

全面的任务能力:在文本生成、问答系统、逻辑推理、代码生成等任务上均表现优异,尤其在复杂推理和指令遵循任务上达到SOTA水平

3. 高效训练与部署

| 功能 | 详情 |

|---|---|

| FP8混合精度训练 | 全程采用FP8混合精度训练,与BF16性能接近但训练效率更高 |

| 高吞吐量训练 | 相比LLaMA 3.1 8B和Qwen3 8B,在8/16/32张80G GPU上吞吐量提升30-120% |

| 多框架部署支持 | 支持vLLM、SGLang等主流部署框架,提供灵活的部署选项 |

| 快速推理能力 | 在H20部署环境下,简单问答场景可达300+ token/s,比8B密集模型快2倍以上 |

4. 丰富的模型资源

提供Ling-mini-2.0系列(1.43B激活参数/16.26B总参数)

提供Ling-flash-2.0系列(6.1B激活参数/100B总参数)

包含5T、10T、15T、20T token训练的预训练checkpoint

提供多种微调版本,适应不同应用场景需求

5. 完善的工具链支持

模型格式转换工具,支持DCP格式转safetensors

基于LLaMA-Factory和Megatron的微调方案

完整的预训练和微调框架,支持基于现有checkpoint继续训练

性能评估工具,方便用户测试和对比模型效果

三、技术细节

1. 模型架构解析

Ling-V2采用了优化的MoE架构,其核心技术细节包括:

整体架构:基于Transformer架构,在FeedForward层位置替换为MoE层

专家数量:根据模型规模不同配置不同数量的专家,Ling-mini-2.0配置32个专家,每次激活1个专家(1/32激活率)

路由机制:采用可学习的门控网络(Gating Network),根据输入token的特征动态选择最合适的专家进行处理

注意力机制:优化的多头注意力设计,平衡注意力计算成本与模型性能

归一化策略:采用RMSNorm归一化方法,提升训练稳定性和推理效率

2. 训练技术

数据处理:使用大规模、多样化的文本数据进行训练,涵盖书籍、网页、代码、对话等多种类型

训练方法:采用分阶段训练策略,包括预训练、指令微调等阶段

精度优化:创新的FP8混合精度训练方案,包括:

FP8优化器设计

按需转置权重技术

精度自适应调整策略

并行训练:支持数据并行、张量并行和专家并行的混合并行模式,有效利用多GPU资源

正则化技术:结合dropout、权重衰减等多种正则化方法,防止过拟合

3. 上下文扩展技术

Ling-V2采用YaRN(Yet Another RoPE Extension)技术扩展上下文长度至128K,其核心优势包括:

无需重新训练即可扩展上下文窗口

保持短上下文场景下的性能不变

在长上下文场景中保持良好的注意力质量

避免了传统扩展方法中的性能下降问题

4. 推理优化

动态批处理:支持动态调整批处理大小,优化吞吐量

KV缓存优化:高效的键值对缓存策略,减少重复计算

量化支持:支持INT4/INT8量化推理,进一步降低内存占用

推理并行:支持多实例并行推理,提升并发处理能力

四、应用场景

Ling-V2凭借其高性能、高效率和长上下文支持的特点,可广泛应用于以下场景:

1. 智能问答系统

Ling-V2能够处理复杂的问题查询,理解上下文语义,提供准确、详细的回答。其长上下文能力使其特别适合:

基于长文档的问答(如技术手册、法律文档)

多轮对话系统,保持对话历史的连贯性

专业领域问答(医疗、法律、金融等)

2. 内容生成

利用Ling-V2的文本生成能力,可以实现:

文章写作(新闻、博客、小说等)

营销文案生成(广告、社交媒体内容)

报告自动生成(数据分析报告、业务总结)

邮件和文档自动撰写

3. 代码开发辅助

Ling-V2在代码生成和理解方面表现优异,可应用于:

代码自动生成(根据需求描述生成代码)

代码解释与注释生成

代码调试与优化建议

编程语言转换

4. 文档处理与分析

借助128K长上下文能力,Ling-V2可高效处理超长文档:

文档摘要生成(长文档自动提炼核心内容)

文档对比分析(两篇或多篇文档的差异与关联分析)

信息抽取(从长文档中提取关键信息)

文档分类与标签生成

5. 智能客服与助手

Ling-V2适合构建高效的智能客服和个人助手:

企业智能客服系统,处理客户咨询

个人助理应用,管理日程、提醒事项

教育辅导助手,解答学习问题

医疗咨询助手,提供健康建议(需结合专业知识)

6. 研究与开发工具

对于研究者和开发者,Ling-V2可作为:

自然语言处理研究的基准模型

MoE架构实验的基础框架

自定义模型训练的起点

多语言处理应用的基础

五、使用方法

1. 环境准备

使用Ling-V2前,需准备以下环境:

Python 3.8+

PyTorch 1.13+

Transformers 4.34+

Accelerate 0.23+

可选:vLLM 0.2.0+(用于高效部署)

可选:SGLang 0.1.0+(用于快速推理)

安装依赖:

pip install torch transformers accelerate sentencepiece # 如需使用vLLM部署 pip install vllm # 如需使用SGLang部署 pip install sglang

2. 模型下载

Ling-V2模型可从以下平台下载:

Hugging Face Hub:https://huggingface.co/inclusionAI

ModelScope:https://modelscope.cn/organization/inclusionAI

以Hugging Face为例,使用git lfs下载模型:

git lfs install git clone https://huggingface.co/inclusionAI/Ling-mini-2.0-16B

3. 基本使用(Transformers)

使用Transformers库加载和使用模型:

from transformers import AutoTokenizer, AutoModelForCausalLM

# 加载tokenizer和模型

tokenizer = AutoTokenizer.from_pretrained("inclusionAI/Ling-mini-2.0-16B")

model = AutoModelForCausalLM.from_pretrained(

"inclusionAI/Ling-mini-2.0-16B",

torch_dtype="auto",

device_map="auto"

)

# 文本生成

prompt = "请介绍一下人工智能的发展历程。"

inputs = tokenizer(prompt, return_tensors="pt").to(model.device)

outputs = model.generate(

**inputs,

max_new_tokens=500,

temperature=0.7,

do_sample=True

)

# 输出结果

print(tokenizer.decode(outputs[0], skip_special_tokens=True))4. 使用vLLM部署

vLLM部署可提供更高的吞吐量和更低的延迟:

# 启动OpenAI兼容的API服务器 python -m vllm.entrypoints.openai.api_server \ --model inclusionAI/Ling-mini-2.0-16B \ --tensor-parallel-size 1 \ --port 8000

使用API调用:

import requests

import json

url = "http://localhost:8000/v1/completions"

headers = {"Content-Type": "application/json"}

data = {

"model": "inclusionAI/Ling-mini-2.0-16B",

"prompt": "请解释什么是机器学习。",

"max_tokens": 300,

"temperature": 0.7

}

response = requests.post(url, headers=headers, data=json.dumps(data))

print(response.json()["choices"][0]["text"])5. 模型微调

使用LLaMA-Factory进行微调:

# 克隆LLaMA-Factory仓库 git clone https://github.com/hiyouga/LLaMA-Factory.git cd LLaMA-Factory # 安装依赖 pip install -r requirements.txt # 启动Web界面进行微调 python src/webui.py

在Web界面中:

选择模型路径(Ling-V2模型所在目录)

配置微调参数(学习率、epochs等)

上传训练数据

开始微调

下载微调后的模型

6. 模型格式转换

将DCP格式转换为safetensors:

python tools/convert_dcp_to_safetensors.py \ --input_dir /path/to/dcp/model \ --output_dir /path/to/safetensors/model \ --tokenizer_dir /path/to/tokenizer

六、常见问题解答

1. 硬件需求相关

Q:运行Ling-mini-2.0需要什么配置的硬件?

A:Ling-mini-2.0的最低配置要求为:

推理:16GB显存的GPU(如RTX 4090、A100等)

微调:32GB以上显存的GPU,建议使用多GPU进行分布式训练

对于更高性能的Ling-flash-2.0,建议使用多GPU配置(如4-8张80GB A100)以获得最佳性能。

Q:能否在没有GPU的情况下使用Ling-V2?

A:可以,但不推荐。在CPU上运行会非常缓慢,仅适合进行代码测试。对于生产环境,强烈建议使用GPU加速。

2. 模型使用相关

Q:Ling-V2支持哪些编程语言的代码生成?

A:Ling-V2支持多种主流编程语言,包括Python、Java、C++、JavaScript、Go等,在常见编程语言上表现尤为出色。

Q:如何调整生成文本的创造性和确定性?

A:可以通过调整temperature参数控制:

较低的temperature(如0.1-0.3)会生成更确定、保守的文本

较高的temperature(如0.7-1.0)会生成更多样、更有创造性的文本

Q:Ling-V2支持多语言吗?

A:是的,Ling-V2在训练过程中使用了多语言数据,支持包括中文、英文在内的多种语言。其中对中英文的支持尤为出色。

3. 训练与微调相关

Q:微调Ling-V2需要多少数据?

A:这取决于具体任务和期望效果。对于简单任务,几千条样本可能就足够;对于复杂任务,可能需要数万甚至数十万条高质量样本。

Q:如何评估微调后的模型性能?

A:可以使用项目提供的评估工具,或采用以下方法:

在验证集上计算困惑度(Perplexity)

针对具体任务设计评估指标(如准确率、BLEU分数等)

进行人工评估,特别是在生成质量、指令遵循等方面

Q:微调时出现过拟合怎么办?

A:可以尝试以下方法:

增加正则化强度(如提高dropout率)

减少训练轮次(epochs)

使用数据增强技术扩充训练数据

降低学习率

4. 部署与性能相关

Q:如何提高Ling-V2的推理速度?

A:可以采取以下措施:

使用vLLM或SGLang等优化的推理框架

采用模型量化(如INT8/INT4)

增加batch size,充分利用GPU并行能力

减少生成的最大token数量

Q:Ling-V2在生产环境中如何保证服务稳定性?

A:建议:

使用负载均衡器分发请求

配置自动扩缩容机制

实现请求队列和超时控制

定期监控系统性能和模型输出质量

Q:能否在移动设备上部署Ling-V2?

A:Ling-mini-2.0经过优化后可以在高端移动设备或边缘计算设备上运行,但可能需要进一步的模型压缩和优化。对于资源受限的设备,建议使用模型的量化版本。

七、相关链接

项目GitHub仓库:https://github.com/inclusionAI/Ling-V2

Hugging Face组织页面:https://huggingface.co/inclusionAI

ModelScope组织页面:https://modelscope.cn/organization/inclusionAI

八、总结

Ling-V2是一个高性能、高效率的混合专家大语言模型系列,通过创新的MoE架构设计和优化的训练策略,在保持优异性能的同时大幅降低了计算资源消耗,1.4B激活参数即可媲美7-8B密集型模型的性能,特别适合对性能和成本都有要求的应用场景;该系列模型支持128K长上下文,提供了从Ling-mini-2.0到Ling-flash-2.0的多种型号选择,并配套完整的训练、微调、部署工具链,方便开发者快速应用;作为开源项目,Ling-V2不仅为学术界提供了研究MoE架构的优秀基准,也为工业界提供了高性能、低成本的大语言模型解决方案,适合智能问答、内容生成、代码辅助、文档处理等多种应用场景。

版权及免责申明:本文由@AI工具箱原创发布。该文章观点仅代表作者本人,不代表本站立场。本站不承担任何相关法律责任。

如若转载,请注明出处:https://www.aipuzi.cn/ai-news/ling-v2.html