SenseVoice:开源多任务音频基础模型,支持语音识别与声学事件分析

一、SenseVoice是什么

SenseVoice是由阿里通义实验室开源的一款具备强大音频理解能力的音频基础模型,致力于为各类语音及声学相关场景提供高效、精准的技术支撑。该模型基于深度学习技术构建,采用模块化设计理念,可灵活适配语音识别、语种识别、语音情感识别、声学事件分类等多种核心任务,打破了传统单一功能音频模型的局限。

作为一款通用型音频基础模型,SenseVoice依托超过40万小时的多语言、多场景数据训练而成,具备跨语言、跨场景的适配能力。其核心优势在于兼顾了识别精度与推理效率,既能够在复杂声学环境下实现高准确率的音频解析,又通过轻量化架构设计满足了实时交互场景的低延迟需求,目前已成为开源社区中音频处理领域的热门解决方案之一,广泛服务于个人开发者、企业技术团队及科研机构。

二、功能特色

SenseVoice凭借全面的功能覆盖与突出的性能表现,在同类开源模型中形成了显著优势。其核心特色可概括为“多能、精准、高效、易用”四大维度,具体内容如下表所示:

| 特色维度 | 核心表现 | 具体说明 |

|---|---|---|

| 多能性 | 全场景音频任务覆盖 | 集成语音识别(ASR)、语种识别(LID)、语音情感识别(SER)、声学事件分类(AEC)四大核心任务,无需部署多个模型即可实现多维度音频解析 |

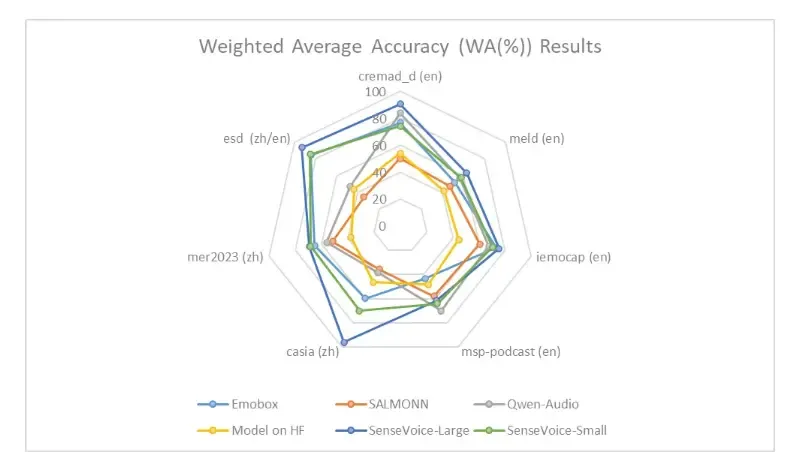

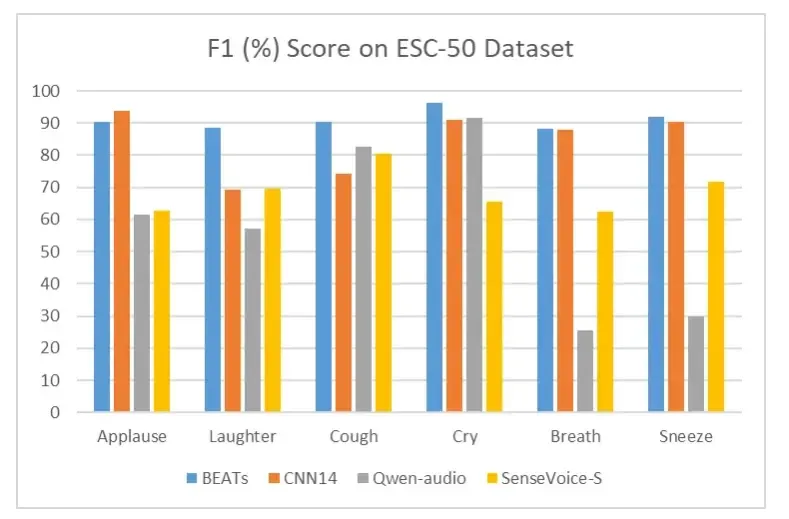

| 精准性 | 识别效果领先 |

1. 语音识别:支持50多种语言,在多语种测试集上准确率优于Whisper模型; 2. 情感识别:在公开测试数据上性能达到或超越当前最佳模型; 3. 事件检测:可精准识别音乐、掌声、笑声等10余种常见声学事件 |

| 高效性 | 低延迟+高并发 |

1. 推理速度:SenseVoice-Small模型处理10秒音频仅需70ms,是Whisper-Large的15倍; 2. 部署效率:支持多并发请求处理,适配高流量业务场景 |

| 易用性 | 全链路开发支持 |

1. 微调便捷:提供完整微调脚本与策略,可快速适配长尾样本场景; 2. 多端部署:支持Python、C++、Java等多语言客户端; 3. 轻量化适配:衍生多种轻量化部署方案,支持边缘设备 |

三、技术细节

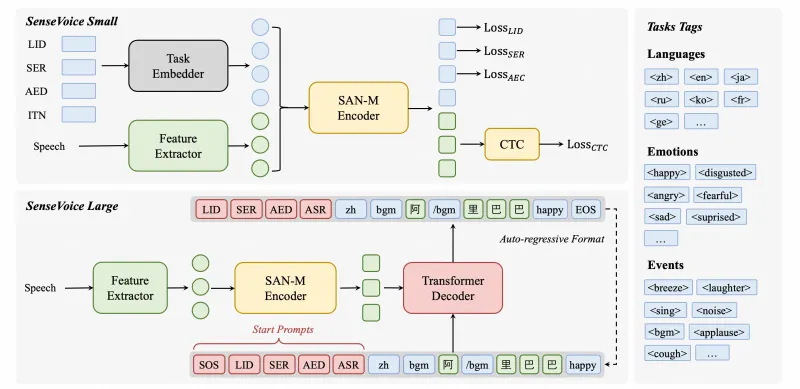

1. 模型架构设计

SenseVoice采用非自回归端到端框架,区别于传统自回归模型的序列生成方式,其通过并行计算实现音频特征的同步解析,大幅降低了推理延迟。模型整体由三大核心模块构成:

音频特征提取模块:采用改进型Mel频谱分析技术,将原始音频信号转换为高维度特征向量,同时引入注意力机制强化关键声学特征的捕捉,提升对噪声环境的鲁棒性;

多任务学习模块:基于共享编码器-独立解码器架构,通过硬参数共享方式提取通用音频特征,再针对语音识别、情感识别等不同任务设计专属解码器,实现多任务的高效协同学习;

后处理优化模块:集成ITN(Inverse Text Normalization)文本规整、情感标签映射、声学事件分类校准等功能,通过规则引擎与神经网络结合的方式优化输出结果,提升文本可读性与分类准确性。

2. 训练数据与优化策略

训练数据规模:模型训练基于超过40万小时的多源数据,涵盖50余种语言的语音样本(含中文、英文、日语、韩语、粤语等主流语种),同时包含不同场景下的声学事件数据(如室内对话、户外环境、音乐现场等)及情感标注数据(如喜悦、愤怒、悲伤等情感类别);

数据增强技术:采用随机音量调整、背景噪声叠加、语速变换、音高偏移等数据增强手段,扩充训练样本多样性,提升模型对复杂环境的适配能力;

优化器与训练策略:使用AdamW优化器进行参数更新,采用学习率余弦退火策略避免过拟合,同时引入知识蒸馏技术,将大型预训练模型的知识迁移至轻量化模型中,在保证精度的前提下压缩模型体积。

3. 关键技术优势

低延迟推理技术:非自回归架构减少了序列依赖带来的计算开销,结合模型量化(支持3位、4位、5位、8位量化)与 tensorrt 加速技术,在V100 GPU上可实现526倍的加速比;

多语言适配技术:通过跨语言预训练与语种自适应微调,构建统一的语言模型空间,支持“auto”模式下的自动语种识别与精准转录;

热词增强技术:集成基于CPPN的神经网络热词增强模块,可通过少量热词样本训练实现特定词汇的识别精度提升,适用于专业术语、人名地名等个性化场景。

四、应用场景

SenseVoice凭借全面的功能与高效的性能,已在多个领域展现出广泛的应用价值,典型场景如下:

1. 智能语音交互领域

智能音箱/语音助手:支持多语言语音指令识别、用户情感状态判断(如通过语气识别用户满意度),同时可检测环境中的声学事件(如儿童哭声、玻璃破碎声)触发相应服务;

车载语音系统:基于低延迟推理能力,实现实时语音导航指令识别、电话通话转录,结合车内声学事件检测(如喇叭声、碰撞声)提升驾驶安全辅助能力。

2. 内容创作与媒体领域

视频字幕生成:自动识别视频中的语音内容并生成多语言字幕,同时可标注说话人的情感倾向(如演讲中的激昂、低沉等语气);

音频内容分析:对播客、访谈节目等音频内容进行结构化解析,提取关键语音信息、识别背景音乐与听众反应(如掌声、笑声),辅助内容摘要生成。

3. 企业服务与办公领域

会议纪要自动生成:实时转录会议中的多语言发言内容,区分不同发言人的情感状态,同时过滤环境噪声干扰,生成结构化会议纪要;

客服质量监控:通过语音情感识别判断客服与用户的沟通情绪(如用户愤怒、客服耐心度),结合声学事件检测(如争吵声、挂断声)实现服务质量自动评分。

4. 公共安全与智能家居领域

声学安防监测:部署于智能家居或公共区域,通过声学事件检测识别异常声音(如咳嗽声、呼救声、火灾警报声),及时触发预警机制;

无障碍辅助工具:为听障人群提供实时语音转文字服务,支持多语言适配,同时可通过情感识别反馈说话人的情绪状态,增强沟通有效性。

5. 边缘计算与嵌入式场景

基于SenseVoice.cpp、sherpa-onnx等轻量化部署方案,可运行于Raspberry Pi、iOS、Android等边缘设备,适用于离线语音控制、便携式音频分析等场景。

五、使用方法

SenseVoice提供多种使用方式,涵盖直接推理、微调训练与服务部署,满足不同用户的需求。以下为核心使用方法说明:

1. 环境准备

首先需安装必要的依赖库,推荐使用Python 3.8及以上版本:

# 安装FunASR(包含SenseVoice依赖) pip install funasr==1.0.0 # 安装其他依赖 pip install torch==1.13.1 modelscope==1.9.5

2. 直接推理(基础使用)

支持任意格式音频输入(时长建议≤30秒),可实现语音识别、情感识别、声学事件检测等综合解析:

from model import SenseVoiceSmall

from funasr.utils.postprocess_utils import rich_transcription_postprocess

# 加载模型(支持从modelscope或本地加载)

model_dir = "iic/SenseVoiceSmall" # modelscope模型地址

m, kwargs = SenseVoiceSmall.from_pretrained(

model=model_dir,

device="cuda:0" # 支持cuda或cpu,cpu推理速度较慢

)

m.eval()

# 推理执行

res = m.inference(

data_in="example/en.mp3", # 音频文件路径

language="auto", # 语种选择:"zh", "en", "yue", "ja", "ko", "nospeech"或"auto"

use_itn=False, # 是否开启文本规整(如数字转中文)

ban_emo_unk=False, # 是否屏蔽未知情感标签

**kwargs

)

# 结果后处理与输出

result = rich_transcription_postprocess(res[0][0]["text"])

print("解析结果:", result)推理结果说明

输出结果包含语音文本、情感标签、声学事件信息,示例格式如下:

解析结果: [喜悦] 今天天气真好![音乐]

其中“[喜悦]”为情感识别结果,“[音乐]”为声学事件检测结果。

3. 模型微调(个性化适配)

当基础模型无法满足特定场景需求(如专业领域术语识别、特定口音适配)时,可通过微调进行优化,具体步骤如下:

步骤1:准备微调数据

需按照指定格式整理训练数据,支持两种输入方式:

音频+文本对:适用于语音识别微调,格式为

{"audio": "path/to/audio.wav", "text": "对应文本", "language": "zh"};带情感/事件标注数据:适用于情感识别/事件检测微调,格式为

{"audio": "path/to/audio.wav", "text": "语音文本", "emotion": "喜悦", "event": "掌声"}。

步骤2:运行微调脚本

使用官方提供的微调脚本启动训练:

# 从GitHub克隆FunASR仓库(包含微调脚本) git clone https://github.com/modelscope/FunASR.git cd FunASR/examples/sensevoice/sv_train # 启动微调(需修改配置文件中的数据路径、模型路径等参数) python train.py --config configs/sensevoice_small_finetune.yaml

步骤3:加载微调后模型

微调完成后,可加载本地模型进行推理:

model_dir = "path/to/finetuned_model" # 微调后模型路径 m, kwargs = SenseVoiceSmall.from_pretrained(model=model_dir, device="cuda:0")

4. 服务部署(生产环境)

SenseVoice提供完整的服务部署链路,支持多并发请求处理,以下为两种主流部署方式:

方式1:Python服务部署

基于FastAPI构建基础服务:

from fastapi import FastAPI, File, UploadFile

from model import SenseVoiceSmall

import tempfile

app = FastAPI()

# 预加载模型

model_dir = "iic/SenseVoiceSmall"

m, kwargs = SenseVoiceSmall.from_pretrained(model=model_dir, device="cuda:0")

m.eval()

@app.post("/audio_analysis")

async def audio_analysis(file: UploadFile = File(...)):

# 保存上传文件

with tempfile.NamedTemporaryFile(suffix=".wav", delete=False) as f:

f.write(await file.read())

audio_path = f.name

# 推理

res = m.inference(data_in=audio_path, language="auto",** kwargs)

result = rich_transcription_postprocess(res[0][0]["text"])

return {"result": result}

# 启动服务

if __name__ == "__main__":

import uvicorn

uvicorn.run(app, host="0.0.0.0", port=8000)方式2:高性能部署(Triton GPU)

适用于高并发、低延迟的生产场景,结合Triton Inference Server与TensorRT加速:

参考官方文档准备Triton部署配置:https://github.com/modelscope/FunASR/blob/main/runtime/triton_gpu/README.md

启动Triton服务并发送请求:

# 启动服务 tritonserver --model-repository=./model_repo # 发送请求(使用Python客户端) python client.py --audio_path=example/en.mp3

方式3:边缘设备部署(sherpa-onnx)

支持在iOS、Android、Raspberry Pi等设备部署,以Python客户端为例:

# 安装sherpa-onnx pip install sherpa-onnx # 运行推理 sherpa-onnx --model=SenseVoiceSmall.onnx --audio=example/en.mp3

六、常见问题解答

1. 基础使用问题

Q1:音频输入有哪些格式要求?支持多长时长的音频?

A1:SenseVoice支持MP3、WAV、FLAC等主流音频格式,无特殊采样率要求(模型内部会自动进行采样率转换)。直接推理模式下建议输入音频时长≤30秒,若需处理长音频,可通过分块切割的方式(参考“流式SenseVoice”项目)实现伪流式处理。

Q2:“language”参数设置为“auto”时,语种识别的准确率如何?支持哪些小众语种?

A2:“auto”模式下的语种识别准确率可达98%以上(针对50余种支持的主要语种)。目前模型优先支持中文、英文、日语、韩语、粤语等主流语种,对于小语种(如越南语、泰语)的支持依赖于具体训练数据覆盖,可通过补充小语种数据微调提升识别效果。

Q3:CPU环境下推理速度如何?是否支持离线使用?

A3:CPU环境下,SenseVoice-Small模型处理10秒音频约需500-800ms(取决于CPU性能),若需提升速度可采用模型量化(如8位量化)或使用SenseVoice.cpp方案。模型支持完全离线使用,只需提前下载模型文件至本地即可。

2. 微调与优化问题

Q4:微调模型需要多少标注数据?对硬件有什么要求?

A4:微调数据量取决于任务类型与需求精度:语音识别任务建议至少准备10小时标注数据,情感识别/事件检测任务建议至少准备5000条标注样本。硬件方面,推荐使用具有8GB以上显存的GPU(如RTX 3090、V100),CPU微调速度极慢,不建议采用。

Q5:如何提升特定词汇(如专业术语、人名)的识别准确率?

A5:可通过两种方式优化:1. 采用热词增强功能,使用“SenseVoice Hotword”模型(https://www.modelscope.cn/models/dengcunqin/SenseVoiceSmall_hotword),导入热词列表进行训练;2. 在微调数据中增加包含特定词汇的样本,通过微调让模型学习词汇特征。

Q6:微调后模型精度下降怎么办?

A6:可能原因及解决方案:1. 过拟合:增加训练数据量、使用数据增强、调整正则化参数;2. 数据分布不匹配:确保微调数据与应用场景的数据分布一致;3. 训练参数不当:调整学习率(建议缩小10-100倍)、增加训练轮次。

3. 部署与性能问题

Q7:多并发场景下如何优化服务性能?

A7:可采用以下策略:1. 使用Triton GPU部署方案,结合TensorRT加速与批处理(batch inference)功能;2. 采用模型量化(如FP16、INT8)减少计算开销;3. 部署负载均衡器,分散并发请求至多个模型实例。

Q8:SenseVoice与Whisper模型相比,各有哪些优势?

A8:两者的核心差异如下表所示:

| 对比维度 | SenseVoice | Whisper |

|---|---|---|

| 推理速度 | 快(10秒音频70ms) | 慢(10秒音频1050ms) |

| 多任务支持 | 集成ASR、LID、SER、AEC | 主要支持ASR、LID |

| 轻量化 | 模型体积小,支持边缘部署 | 模型体积大,边缘部署难度高 |

| 微调便捷性 | 提供完整微调脚本,支持快速适配 | 微调流程复杂,对数据要求高 |

Q9:部署过程中遇到“模型加载失败”如何解决?

A9:可按以下步骤排查:1. 检查模型路径是否正确,确保模型文件完整(可重新从modelscope或Hugging Face下载);2. 检查依赖库版本是否兼容(推荐使用官方指定的torch、modelscope版本);3. 若为GPU环境,检查CUDA版本是否与torch版本匹配;4. 若为边缘设备,确认模型格式是否适配(如onnx格式需对应sherpa-onnx部署方案)。

4. 功能扩展问题

Q10:是否支持流式语音识别?如何实现?

A10:支持通过“流式SenseVoice”项目实现伪流式处理,该方案通过分块(chunk)方式接收音频数据,采用截断注意力机制减少延迟,同时支持CTC前缀束搜索与热词增强。

Q11:能否同时输出语音识别结果与情感标签?

A11:可以。基础推理模式下,通过rich_transcription_postprocess函数处理后,输出文本中会包含情感标签(如“[愤怒]”)与声学事件标签(如“[咳嗽]”),无需额外配置。

七、相关链接

| 链接类型 | 地址 | 说明 |

|---|---|---|

| 核心代码仓库 | https://github.com/FunAudioLLM/SenseVoice | 包含模型源码、推理脚本、基础部署文档 |

| ModelScope模型库 | https://www.modelscope.cn/models/iic/SenseVoiceSmall | 模型下载、在线演示、微调教程 |

| Hugging Face仓库 | https://huggingface.co/FunAudioLLM/SenseVoiceSmall | 模型下载、英文文档、社区交流 |

| 在线演示(ModelScope) | https://www.modelscope.cn/studios/iic/SenseVoice | 网页端体验语音识别、情感识别等功能 |

| 在线演示(Hugging Face) | https://huggingface.co/spaces/FunAudioLLM/SenseVoice | 英文界面在线演示,支持多语言测试 |

| 论文地址 | https://arxiv.org/abs/2407.04051 | FunAudioLLM论文 |

| 轻量化部署文档 | https://k2-fsa.github.io/sherpa/onnx/sense-voice/index.html | sherpa-onnx部署方案教程,支持多语言客户端 |

八、总结

SenseVoice作为一款开源多任务音频基础模型,通过非自回归架构设计与多任务学习技术,实现了语音识别、语种识别、情感识别与声学事件分类的一体化支持,在识别精度、推理速度与易用性上形成了均衡优势。其不仅支持50多种语言的高准确率识别,还通过轻量化部署方案适配从云端服务器到边缘设备的全场景需求,同时提供完整的微调与服务部署工具链,降低了个性化适配门槛。无论是个人开发者构建音频处理原型,还是企业打造高并发语音服务,SenseVoice都能提供高效可靠的技术支撑,成为当前开源音频处理领域的优选方案之一。

版权及免责申明:本文由@AI铺子原创发布。该文章观点仅代表作者本人,不代表本站立场。本站不承担任何相关法律责任。

如若转载,请注明出处:https://www.aipuzi.cn/ai-news/sensevoice.html