OmniVinci:NVIDIA开源的全模态理解大语言模型,高效融合视觉、音频与文本信息

一、OmniVinci是什么?

OmniVinci是由NVIDIA等机构开发的开源全模态理解大语言模型(Omni-Modal Understanding LLM),旨在通过创新架构与高效数据构建,实现对视觉(图像、视频)、音频、文本信息的统一理解与联合推理。该模型以仅0.2T训练tokens的高效成本,在跨模态基准测试中显著优于同类模型,支持机器人、医疗AI、智能工厂等多领域应用,为开发者与研究社区提供了高性能、易部署的全模态智能解决方案。

在人工智能领域,“多模态理解”一直是突破机器智能边界的核心方向——人类通过视觉、听觉、语言等多种感官协同认知世界,而让机器具备类似能力,需要模型能同时处理并关联图像、视频、音频、文本等不同类型的信息。OmniVinci正是为解决这一问题而生的开源项目。

OmniVinci专注于“全模态理解”的大语言模型(LLM)。与传统单模态模型(如仅处理文本的GPT系列)或部分多模态模型(如仅支持图像+文本的CLIP)不同,它首次实现了对视觉(静态图像、动态视频)、音频(语音、环境声)、文本(自然语言) 三种核心模态的“端到端统一理解”:不仅能单独解析每种模态的内容,更能捕捉模态间的关联(如视频画面与背景音的同步、图像内容与描述文本的匹配),并基于跨模态信息进行复杂推理。

作为开源项目,OmniVinci的代码、模型权重及技术文档均公开可获取,旨在降低全模态智能的应用门槛,推动学术界与工业界在跨模态感知、推理领域的创新。其核心目标可概括为:让机器像人类一样,通过“看、听、读”的协同,更自然地理解世界并响应需求。

二、功能特色

OmniVinci的核心竞争力体现在“全模态融合能力”与“高效实用性”两大维度,具体特色如下:

1. 全模态统一理解,覆盖多场景输入

OmniVinci支持的输入类型包括:

视觉:静态图像(JPG、PNG等格式)、动态视频(MP4、AVI等格式,支持分辨率自适应);

音频:语音片段(WAV、MP3等格式)、环境声(如机器运转声、自然界声音);

文本:自然语言指令、对话历史、结构化文档(如表格、公式描述)。

更重要的是,它能处理“多模态混合输入”(如“一段包含背景音乐的视频+问题文本”“一张X光片+患者症状描述+监护仪音频”),并输出连贯的文本响应,实现“输入-理解-推理-输出”的端到端闭环。

2. 跨模态对齐能力强,推理精度领先

“模态对齐”是多模态模型的核心挑战——即让视觉、音频、文本在统一的语义空间中“可比较、可关联”。OmniVinci通过创新架构设计,显著提升了这一能力,具体表现为:

能精准匹配“视频画面与同期音频”(如识别视频中“关门动作”与音频中“砰的声响”是同一事件);

能关联“图像内容与文本描述”(如根据商品图片+用户评价文本,总结商品优缺点);

能基于跨模态信息推理(如根据“一段工厂设备运行视频+异常噪音音频”,诊断设备故障原因)。

在权威基准测试中,OmniVinci的性能显著优于同类模型(如下表):

| 测试任务 | 评估指标 | OmniVinci 得分 | Qwen2.5-Omni 得分 | 优势幅度 |

|---|---|---|---|---|

| 跨模态综合理解(DailyOmni) | 综合评分 | 66.5 | 47.5 | +19.0 |

| 音频任务(MMAR) | 准确率 | 58.4 | 56.7 | +1.7 |

| 视频任务(Video-MME) | 推理得分 | 68.2 | 64.3 | +3.9 |

3. 训练效率极高,部署成本低

传统多模态模型为覆盖全模态能力,往往需要海量训练数据(如1T以上tokens),导致训练成本高、部署门槛高。OmniVinci通过优化数据质量与模型架构,仅使用0.2T训练tokens(约为Qwen2.5-Omni的1/6),就实现了更优性能。这一特性带来两大优势:

训练成本低:中小团队也能基于该模型进行微调或二次开发;

部署门槛低:支持在消费级GPU(如NVIDIA RTX 4090)上运行,无需依赖超大规模计算集群。

4. 开源生态友好,支持灵活扩展

OmniVinci完全开源,提供:

完整的模型训练、微调代码;

适配Hugging Face

transformers等主流框架的接口;针对不同场景的示例脚本(如视频推理、音频分析);

详细的技术文档与社区支持。

开发者可基于此扩展功能,例如添加新的模态(如传感器数据)、优化特定场景(如医疗影像分析)等。

三、技术细节

OmniVinci的高性能源于三大核心技术创新:架构设计、数据构建、训练优化,三者协同实现了“高效全模态理解”。

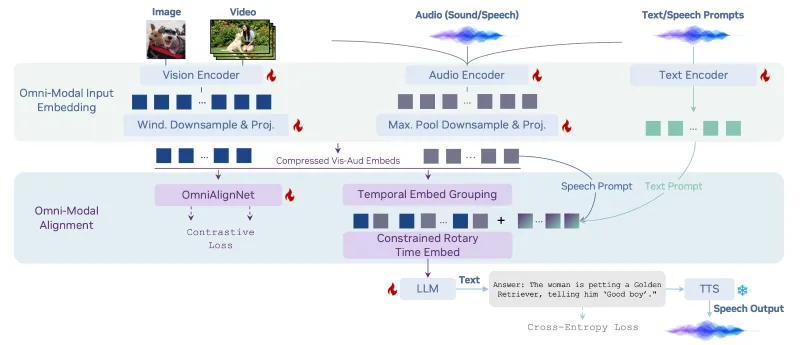

1. 模型架构:全模态语义对齐的核心设计

OmniVinci的架构以“统一语义空间”为核心,通过三个关键模块实现跨模态融合:

| 技术模块 | 核心功能 | 创新点 |

|---|---|---|

| OmniAlignNet | 对齐视觉、音频与文本的语义表示 | 采用“双注意力机制”:模态内注意力捕捉单模态细节,模态间注意力关联跨模态信息,解决传统模型“模态隔离”问题。 |

| Temporal Embedding Grouping | 处理动态时序信息(如视频帧顺序、音频波形变化) | 将时序信号按“语义片段”分组(如视频中“开门-取物-关门”为一组动作),增强对“时间关联事件”的捕捉能力。 |

| Constrained Rotary Time Embedding | 在全模态嵌入中编码绝对时间信息 | 约束旋转位置编码的范围,避免长时序信号中“时间信息稀释”,提升视频/音频长片段的理解精度。 |

具体工作流程:

当输入多模态信息时,模型首先通过专用编码器(图像编码器、视频帧编码器、音频波形编码器、文本Tokenizer)将不同模态转换为特征向量;随后,OmniAlignNet通过双注意力机制将这些向量映射到统一语义空间,同时Temporal Embedding Grouping与Constrained Rotary Time Embedding处理时序关联;最后,由LLM解码器基于融合后的特征生成文本响应。

2. 数据构建:高质量全模态对话数据集

模型性能的基础是数据。OmniVinci构建了一套包含2400万条样本的全模态对话数据集,其特点如下:

多模态覆盖:包含单模态数据(纯文本对话、纯图像描述、纯音频转写)与全模态数据(视频+音频+文本对话、图像+音频+指令等);

场景多样性:覆盖日常生活(如家庭监控视频分析)、工业场景(如设备运行监控)、医疗场景(如医学影像+病历)等10+领域;

合成与清洗结合:部分数据通过“人工标注+AI合成”生成(如用AI为视频自动生成问答对),并通过严格清洗(过滤噪声、修正错误关联)保证质量。

这种“模态互补、场景丰富”的数据分布,使模型能学习到更通用的跨模态关联规律。

3. 训练优化:高效利用数据的训练策略

为在有限数据(0.2T tokens)中实现高性能,OmniVinci采用了“分阶段训练+动态权重调整”策略:

预训练阶段:先在大规模单模态数据(文本、图像、音频)上训练基础编码器,确保单模态理解能力;

对齐训练阶段:在多模态数据上训练OmniAlignNet等模块,重点优化模态间的关联学习;

微调阶段:针对下游任务(如视频问答、音频诊断)动态调整各模态权重(如医疗场景中提升图像权重),增强任务适配性。

此外,模型采用混合精度训练与知识蒸馏技术,进一步降低计算成本。

四、应用场景

基于全模态理解能力,OmniVinci可广泛应用于需要“跨模态感知与推理”的场景,以下为典型案例:

1. 机器人领域:环境感知与交互

机器人在复杂环境中工作时,需同时处理视觉(摄像头画面)、音频(语音指令、环境声)与文本(预设任务)信息。例如:

家庭服务机器人:通过OmniVinci解析“用户手势(视觉)+语音指令‘拿水杯’(音频)+厨房布局图(文本)”,规划取物路径;

工业巡检机器人:结合“设备运行视频(视觉)+异常噪音(音频)+设备参数表(文本)”,实时诊断故障并生成维修建议。

2. 医疗AI:多源诊断辅助

医疗场景中,诊断往往依赖“医学影像(如CT、X光)+患者描述(文本)+监护仪音频(如心跳声)”的协同分析。OmniVinci可:

结合“肺部CT影像(视觉)+患者咳嗽音频(音频)+病历文本”,辅助医生判断是否为肺炎;

分析“手术视频(视觉)+器械碰撞声(音频)+手术步骤说明(文本)”,自动记录手术关键节点。

3. 智能工厂:设备监控与预警

工厂设备的稳定运行需要实时监控“设备状态视频(视觉)+运行声音(音频)+操作规程(文本)”。例如:

生产线监控:通过视频识别设备部件磨损(视觉)、音频捕捉异常振动声(音频),结合设备维护手册(文本),提前预警故障;

安全生产:识别视频中“员工未戴安全帽(视觉)”+ 音频中“警报声(音频)”,自动触发安全提示。

4. 教育领域:多媒体内容理解

在线教育中,课程内容常包含“教学视频(视觉+音频)+课件文本”,OmniVinci可:

为学生生成“视频重点片段(视觉)+老师讲解音频转写(文本)”的总结笔记;

基于“学生观看视频的表情(视觉)+提问语音(音频)”,判断学习难点并推送针对性讲解。

5. 内容创作:跨模态素材处理

创作者在制作视频、音频内容时,需处理多模态素材,OmniVinci可:

为短视频自动生成“画面描述(视觉)+背景音乐风格(音频)”的标签,辅助平台推荐;

根据“小说文本”自动生成“场景画面描述(视觉)+音效建议(音频)”,辅助影视剧本创作。

五、使用方法

OmniVinci提供了简洁的部署与推理流程,支持开发者快速上手。以下为详细步骤:

1. 环境配置

硬件要求

最低配置:NVIDIA GPU(显存≥16GB,如RTX 3090)、CPU≥8核、内存≥32GB;

推荐配置:NVIDIA GPU(显存≥24GB,如RTX 4090/A100),支持更快推理。

软件依赖

操作系统:Linux(Ubuntu 20.04+)或Windows(需WSL2);

框架:Python 3.10+、PyTorch 2.0+、Hugging Face

transformers、datasets、accelerate。

安装步骤

# 1. 克隆仓库(或直接下载模型) git clone https://github.com/NVlabs/OmniVinci.git cd OmniVinci # 2. 下载模型权重(通过Hugging Face) huggingface-cli download nvidia/omnivinci --local-dir ./models/omnivinci --local-dir-use-symlinks False # 3. 安装依赖(使用conda创建环境) bash ./scripts/environment_setup.sh omnivinci_env conda activate omnivinci_env

2. 推理示例

OmniVinci支持视频(含音频)、音频、图像三种模态的推理,以下为典型场景示例:

示例1:视频+文本推理(分析视频内容)

from transformers import AutoModelForCausalLM, AutoProcessor

import cv2

# 加载模型与处理器

model = AutoModelForCausalLM.from_pretrained("./models/omnivinci", trust_remote_code=True)

processor = AutoProcessor.from_pretrained("./models/omnivinci", trust_remote_code=True)

# 输入:视频文件+文本问题

video_path = "./examples/sample_video.mp4"

question = "视频中人物在做什么?背景音是什么?"

# 读取视频帧(每2秒取一帧,降低计算量)

video = []

cap = cv2.VideoCapture(video_path)

fps = cap.get(cv2.CAP_PROP_FPS)

frame_interval = int(fps * 2)

while cap.isOpened():

ret, frame = cap.read()

if not ret:

break

if cap.get(cv2.CAP_PROP_POS_FRAMES) % frame_interval == 0:

video.append(cv2.cvtColor(frame, cv2.COLOR_BGR2RGB))

cap.release()

# 构造输入并推理

inputs = processor(images=video, text=question, return_tensors="pt").to("cuda")

outputs = model.generate(**inputs, max_new_tokens=200)

response = processor.decode(outputs[0], skip_special_tokens=True)

print("回答:", response)

# 示例输出:视频中人物在组装零件,背景音是机器运转的嗡嗡声。示例2:音频+文本推理(分析音频内容)

from transformers import AutoModelForCausalLM, AutoProcessor

import librosa

# 加载模型与处理器(同上)

model = AutoModelForCausalLM.from_pretrained("./models/omnivinci", trust_remote_code=True)

processor = AutoProcessor.from_pretrained("./models/omnivinci", trust_remote_code=True)

# 输入:音频文件+文本问题

audio_path = "./examples/sample_audio.wav"

question = "这段音频中包含哪些声音?可能是什么场景?"

# 读取音频(采样率16kHz)

audio, sr = librosa.load(audio_path, sr=16000)

# 构造输入并推理

inputs = processor(audios=audio, text=question, return_tensors="pt").to("cuda")

outputs = model.generate(** inputs, max_new_tokens=150)

response = processor.decode(outputs[0], skip_special_tokens=True)

print("回答:", response)

# 示例输出:音频中包含雨声、雷声和窗户晃动的声音,可能是暴雨天气下的室内场景。示例3:图像+文本推理(分析图像内容)

from transformers import AutoModelForCausalLM, AutoProcessor

from PIL import Image

# 加载模型与处理器(同上)

model = AutoModelForCausalLM.from_pretrained("./models/omnivinci", trust_remote_code=True)

processor = AutoProcessor.from_pretrained("./models/omnivinci", trust_remote_code=True)

# 输入:图像文件+文本问题

image_path = "./examples/sample_image.jpg"

question = "图中物体是什么?结合标签‘厨房’,它的用途是什么?"

# 读取图像

image = Image.open(image_path).convert("RGB")

# 构造输入并推理

inputs = processor(images=image, text=question, return_tensors="pt").to("cuda")

outputs = model.generate(**inputs, max_new_tokens=100)

response = processor.decode(outputs[0], skip_special_tokens=True)

print("回答:", response)

# 示例输出:图中物体是搅拌机,在厨房中用于搅拌食材(如面粉、蛋液)。3. 微调方法(针对特定场景)

若需针对特定场景优化模型(如医疗影像分析),可使用项目提供的微调脚本:

# 准备自定义数据集(需遵循项目数据格式) python ./scripts/prepare_custom_dataset.py --data_dir ./my_medical_data --output_dir ./formatted_data # 启动微调(单GPU) python ./scripts/finetune.py \ --model_name_or_path ./models/omnivinci \ --data_path ./formatted_data \ --output_dir ./finetuned_omnivinci_medical \ --num_train_epochs 3 \ --per_device_train_batch_size 2

六、常见问题解答(FAQ)

1. OmniVinci支持哪些输入格式?

图像:JPG、PNG、BMP等常见格式,分辨率无严格限制(模型会自动 resize);

视频:MP4、AVI、MOV等格式,最长支持30分钟(超过建议分段处理);

音频:WAV、MP3、FLAC等格式,采样率建议16kHz(模型会自动转换);

文本:UTF-8编码的自然语言,支持中英文等多语言。

2. 运行OmniVinci需要多大显存?

图像推理:单张图像约需8GB显存;

音频推理:10分钟音频约需10GB显存;

视频推理:1分钟视频(30帧)约需16GB显存;

多模态混合推理(如视频+音频+文本):建议24GB以上显存。

3. 与其他多模态模型(如GPT-4V、Qwen2.5-Omni)相比,OmniVinci的优势是什么?

开源免费:可完全本地部署,无API调用限制;

全模态覆盖:同时支持视频、音频、图像,而部分模型仅支持图像+文本;

训练效率高:用更少数据实现更优性能,适合二次开发;

部署灵活:支持消费级GPU,无需依赖云服务。

4. 模型支持多语言吗?

目前主要优化中文与英文,对其他语言(如日语、法语)的支持正在完善中。开发者可通过多语言数据微调扩展支持范围。

5. 训练数据是否包含隐私信息?

项目明确说明,训练数据经过严格脱敏处理,剔除了个人身份信息(如人脸、声音特征)、隐私场景(如家庭内部未公开视频)等内容,符合数据隐私法规(如GDPR)。

七、相关链接

GitHub仓库:https://github.com/NVlabs/OmniVinci

Hugging Face模型页:https://huggingface.co/nvidia/omnivinci

技术报告(arXiv):https://arxiv.org/abs/2510.15870

NVIDIA官方介绍:https://developer.nvidia.com/omnivinci

示例数据集:https://huggingface.co/datasets/nvidia/omnivinci-demo-data

八、总结

OmniVinci作为NVIDIA推出的开源全模态理解大语言模型,通过创新的架构设计(如OmniAlignNet)、高质量的全模态数据集(2400万样本)与高效训练策略(0.2T tokens),实现了视觉、音频、文本的统一理解与跨模态推理,在多项基准测试中表现优于同类模型。其开源特性与低部署门槛,为机器人、医疗、工业等领域提供了实用的全模态智能解决方案,既适合开发者快速集成应用,也为研究人员探索跨模态智能提供了可靠的基础工具。

版权及免责申明:本文由@AI工具箱原创发布。该文章观点仅代表作者本人,不代表本站立场。本站不承担任何相关法律责任。

如若转载,请注明出处:https://www.aipuzi.cn/ai-news/omnivinci.html