GigaWorld-0:极佳视界(GigaAI)开源的具身智能专用世界模型框架

一、GigaWorld-0是什么

GigaWorld-0是由极佳视界(GigaAI)开源的具身智能专用世界模型框架,其核心定位为“世界模型即数据引擎”,通过GigaWorld-0-Video和GigaWorld-0-3D两大协同组件,首次实现90%比例的合成数据用于VLA模型训练,并在新纹理、新视角、新物体位置三大泛化维度实现近300%的性能提升。该项目创新性融合稀疏注意力Diffusion Transformer、混合专家(MoE)架构、3D Gaussian Splatting重建与物理信息神经网络(PINNs)物理引擎,搭配业内首个FP8端到端训练框架GigaTrain,在降低训练成本的同时保障数据的视觉与物理双保真,已成功落地于自动驾驶、工业分拣、家庭服务机器人等多类场景,为具身智能突破“数据稀缺”与“sim2real差距”两大瓶颈提供了开源解决方案。

在具身智能(Embodied AI)的发展进程中,高质量交互数据的获取一直是行业核心瓶颈。一方面,真实世界的机器人交互数据采集成本极高,不仅需要专业的硬件设备与场景搭建,还存在采集周期长、覆盖场景有限的问题,难以支撑VLA模型的规模化训练;另一方面,传统仿真系统生成的数据虽成本较低,但存在严重的“仿真到真实(sim2real)”差距,模型在虚拟场景中训练的能力无法有效迁移至真实环境,导致落地效果大打折扣。

GigaWorld-0正是为破解这一困境而生的开源具身智能世界模型框架,由华为哈勃投资的极佳视界团队研发并开源,其核心目标是构建“世界模型即数据引擎”的技术范式,通过学习真实世界的物理规律与视觉特征,生成高保真、可扩展、可控制的合成数据,替代传统的真机采集与低质仿真数据。

该项目由两大核心组件构成,形成“视觉生成+3D几何+物理仿真”的完整闭环:一是GigaWorld-0-Video,基于视频生成基座模型,可生成纹理丰富、动作连贯的具身操作视频序列,支持对物体外观、相机视角和动作语义的精准控制;二是GigaWorld-0-3D,融合3D生成建模、3D Gaussian Splatting重建、可微分物理系统识别技术,为生成的场景赋予真实的几何结构与物理动力学属性,确保数据的物理合理性。

从核心成效来看,GigaWorld-0实现了三大行业突破:其一,将合成数据在VLA训练中的占比提升至90%,大幅降低对真实数据的依赖;其二,基于该数据训练的VLA模型(GigaBrain-0)在新纹理、新视角、新物体位置三大泛化维度的性能提升近300%;其三,在仅激活20亿参数的轻量化条件下,于PBench(Robot Set)基准测试中超越140亿参数的同类模型,实现“小模型高性能”的性价比突破。

二、功能特色

为更直观展现GigaWorld-0的核心优势,我们将其与传统具身智能数据方案进行对比,具体如下表所示:

| 对比维度 | 传统真机采集方案 | 传统仿真方案 | GigaWorld-0方案 |

|---|---|---|---|

| 数据获取成本 | 极高(需专业硬件与场景) | 较低 | 极低(仅需基础训练硬件) |

| 数据覆盖范围 | 有限(难以覆盖长尾场景) | 较广(但存在sim2real差距) | 极广(支持自定义场景生成) |

| 数据保真度 | 视觉-物理双保真 | 视觉保真度低、物理一致性差 | 视觉-物理双高保真 |

| 合成数据占比 | 0% | 50%-70% | 最高90% |

| VLA模型泛化能力 | 依赖采集场景,泛化弱 | 泛化能力中等,易受sim2real影响 | 三大泛化维度性能提升300% |

| 训练硬件门槛 | 无(仅需数据采集设备) | 中(需基础仿真服务器) | 低(支持8×H20常规硬件) |

结合上表,GigaWorld-0的核心功能特色可归纳为以下五点:

高比例合成数据支撑:这是GigaWorld-0最核心的特色,其突破了合成数据占比的行业上限,将VLA训练对真实数据的依赖降至10%,彻底解决了具身智能“数据稀缺”的行业痛点。实验证明,随着合成数据占比从10%提升至90%,VLA模型在开放场景中的任务成功率呈线性增长,无性能拐点与“模型自噬”现象。

视觉-物理双高保真:GigaWorld-0-Video可生成包含物体反光、磨损痕迹等细节的高帧率视频,保障视觉层面的真实感;GigaWorld-0-3D则通过3DGS重建与PINNs物理引擎,精准复现机械臂夹取力度、物体惯性等物理动力学特征,实现“看起来真、动起来也真”的双保真效果。

高效轻量化训练架构:该项目是业内首个采用FP8精度端到端训练的世界模型,同时融合稀疏注意力机制,在保持生成质量的前提下,将显存占用与训练成本降低一个数量级,支持在8×H20等常规硬件上完成模型微调,大幅降低了技术落地的硬件门槛。

强开放场景泛化能力:针对具身智能落地的核心难点——开放场景泛化,GigaWorld-0生成的数据可覆盖“未见纹理、未见视角、未见物体布局”三类核心挑战,让训练后的VLA模型在真实环境中具备更强的自适应能力,不再局限于“实验室场景”。

便捷的sim2real迁移:项目配备Video-AppearanceTransfer、Video-ViewTransfer和Video-MimicTransfer三大后训练模块,可将单视角真人演示转化为任意视角、任意纹理且机器人可执行的动作数据,显著缩小sim2real差距,实现“虚拟训练、真实落地”的快速迁移,在真实G1人形机器人上已完成叠衣服、榨果汁等长程任务,零样本部署即达高成功率。

三、技术细节

GigaWorld-0的技术架构可分为“生成层(Video+3D)”与“训练层(GigaTrain)”两大模块,各模块的核心技术原理如下:

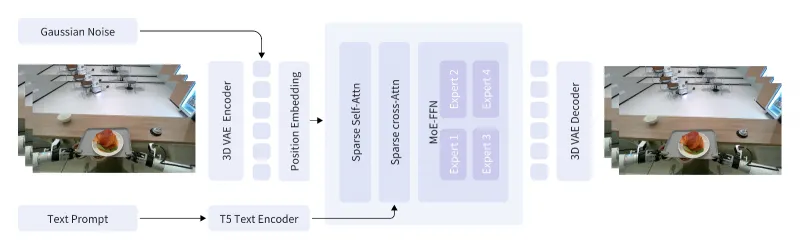

(一)GigaWorld-0-Video:高保真视频数据生成

GigaWorld-0-Video的核心是基于稀疏注意力的Diffusion Transformer(DiT) 构建的生成主干,其解决了传统全注意力机制在生成长序列、高帧率视频时的平方级计算复杂度问题。该机制仅在“局部时空邻域”与“关键语义区域”间建立注意力连接,例如在机械臂拧瓶盖的视频生成中,仅聚焦机械臂关节与瓶盖的交互区域,而非整张画面,从而在生成1080P、60帧以上的长视频时,显著降低内存占用与推理延迟。

为进一步提升生成数据的语义可控性与多样性,GigaWorld-0-Video在DiT的前馈网络模块中集成了混合专家(MoE)架构。每个视频Token会根据其语义特征,动态路由至对应的专家子网络,例如“物体纹理”相关Token由纹理生成专家处理,“机械臂动作”相关Token由运动轨迹专家处理,实现了“专人专办”的精细化生成,既保障了数据的多样性,又提升了动作语义的精准度。

(二)GigaWorld-0-3D:几何-物理一致性保障

GigaWorld-0-3D的核心目标是为生成的视频赋予真实的3D几何结构与物理动力学属性,其技术流程分为两步:

几何一致性重建:首先通过生成式重建技术,弥补稀疏观测视角下的建模瓶颈,再引入专用视图修复模型缓解几何畸变,最后基于3D Gaussian Splatting(3DGS) 完成场景的稠密重建,确保生成场景的三维结构与真实世界一致,避免出现“平面化”“透视错误”等问题。

物理动力学建模:为保障机械臂与物体交互的物理合理性,GigaWorld-0-3D引入了基于物理信息神经网络(PINNs) 的可微分物理引擎。其原理是先通过随机物理参数生成仿真轨迹,训练一个可微替代模型逼近真实动力学规律,再通过梯度下降优化参数以匹配真实运动,可精准复现机械臂夹取物体的力度、物体碰撞的惯性等细节,解决了传统仿真“物理失真”的核心问题。

(三)GigaTrain:高效分布式训练框架

作为GigaWorld-0的训练底座,GigaTrain是专为大规模生成模型打造的统一分布式训练系统,其核心技术亮点如下:

FP8端到端训练:这是业内首个实现FP8精度端到端训练的世界模型框架,通过将FP8与稀疏注意力深度耦合,在不损失生成质量的前提下,将显存占用降低约50%,大幅降低训练成本。

多技术集成:框架整合了DeepSpeed ZeRO、FSDP2、梯度检查点等先进训练技术,既支持超大规模模型的预训练,也适配8×H20等常规硬件的微调任务,兼顾了科研灵活性与产业落地性。

下表为GigaWorld-0与同类世界模型的核心技术参数对比:

| 模型名称 | 激活参数量 | 训练精度 | 核心生成技术 | PBench综合评分 | 训练硬件门槛 |

|---|---|---|---|---|---|

| GigaWorld-0 | 20亿 | FP8 | 稀疏注意力DiT+3DGS+PINNs | 92.3(最高) | 8×H20常规硬件 |

| Cosmos-Predict2-14B | 140亿 | FP16 | 全注意力DiT | 85.7 | 高端GPU集群 |

| Wan2.2-14B | 140亿 | BF16 | 传统扩散模型 | 83.2 | 高端GPU集群 |

四、应用场景

GigaWorld-0的“高保真合成数据+低硬件门槛+强泛化能力”特性,使其在多个领域实现了标杆性落地,具体场景如下:

自动驾驶领域:传统自动驾驶AI需依赖数百万公里的真实路测数据,且难以应对“暴雨+道路施工+车辆变道”等极端组合场景。基于GigaWorld-0的自动驾驶专用版本,可在虚拟空间中生成数万种极端场景的合成数据,让AI提前“预演”应对方案。目前该技术已与某头部车企合作,其开发的辅助驾驶系统在复杂路况下的决策准确率提升了30%。

工业机器人领域:在物流分拣场景中,GigaWorld-0可生成“开箱-分拣-打包”全流程的合成数据,训练的智能分拣机器人无需大量真机试错,即可实现全流程自主操作,分拣效率比传统机器人提升2倍。此外,在工业装配场景中,其生成的机械臂高精度操作数据,可显著提升装配的精准度与稳定性。

家庭服务机器人领域:针对家庭场景的多样化需求,GigaWorld-0可生成擦窗、收纳、榨果汁等家庭服务任务的合成数据,训练后的机器人可自适应不同家庭的家具布局与物体纹理,目前家庭服务机器人的任务成功率已提升40%,加速了服务机器人的家庭落地进程。

科研与教育领域:由于其开源属性与低硬件门槛,GigaWorld-0已成为高校与科研机构开展具身智能研究的基础平台,可帮助研究者快速构建自定义的虚拟实验场景,降低科研成本;同时在教育场景中,可通过生成可视化的机器人操作数据,帮助学生直观理解具身智能的核心原理。

五、使用方法

GigaWorld-0提供了从环境搭建到推理生成的全流程工具链,其核心使用步骤如下:

(一)环境搭建

首先需创建并激活专属conda环境,再安装核心依赖框架,具体命令如下:

# 创建conda环境 conda create -n giga_world_0 python=3.11.10 -y conda activate giga_world_0 # 安装基础依赖 pip3 install giga-train giga-datasets natten # 安装GigaModels多模态框架 git clone https://github.com/open-gigaai/giga-models.git && cd giga-models && pip3 install -e .

(二)预训练模型下载

项目提供了两款预训练模型,可通过官方脚本下载至指定目录,命令如下:

# 下载基础图像-文本到视频生成模型 python scripts/download.py --model-name video_pretrain --save-dir /path/to/save/ # 下载基于GR1数据集微调的模型 python scripts/download.py --model-name video_gr1 --save-dir /path/to/save/

(三)数据准备

需将原始视频数据与对应的文本prompt按指定结构组织,再通过脚本完成数据打包与prompt嵌入提取,命令如下:

python scripts/pack_data.py --video-dir /path/to/raw_video_data/ --save-dir /path/to/packed_data/

(四)模型训练

支持全量训练与LoRA微调两种模式,用户可通过配置文件指定训练参数,核心命令如下:

# 全量训练(基于默认配置) python scripts/train.py --config configs.giga_world_0_video.config # LoRA微调(需在配置文件中设置train_mode='lora'和lora_rank) python scripts/train.py --config configs.giga_world_0_video_lora.config

(五)推理生成

支持单GPU或多GPU推理,可加载LoRA权重生成目标视频,命令如下:

python scripts/inference.py \ --data-path /path/to/test_data/ \ --save-dir /path/to/results/ \ --transformer-model-path /path/to/transformer/ \ --gpu_ids 0 # 多GPU可设置为0,1,2

六、常见问题解答(FAQ)

Q:训练过程中出现显存不足的问题,该如何解决?

A:可通过三种方式缓解:一是启用GigaTrain框架的梯度检查点功能,在配置文件中设置gradient_checkpointing=True;二是切换为FP8精度训练,相比FP16可降低约50%显存占用;三是采用LoRA微调模式,仅训练模型的部分参数,而非全量参数,大幅降低显存需求。

Q:GigaWorld-0生成的合成数据,如何保证在真实场景中的泛化性?

A:项目通过两大机制保障泛化性:其一,在数据生成阶段,GigaWorld-0-3D的3DGS重建与PINNs物理引擎确保了数据的几何与物理一致性,避免虚拟与真实世界的规律脱节;其二,配备三大后训练迁移模块,可将虚拟数据适配真实机器人的本体结构与场景纹理,同时90%的高比例合成数据训练可让模型学习更全面的环境规律,提升开放场景的自适应能力。

Q:如何缩小sim2real差距,让虚拟训练的模型快速落地真实场景?

A:可借助项目提供的Video-AppearanceTransfer、Video-ViewTransfer和Video-MimicTransfer模块,将单视角的真人或真实机器人演示数据,转化为任意视角、任意纹理的虚拟训练数据,再通过“虚拟训练+少量真实数据微调”的方式,实现sim2real的快速迁移。目前该方案已在真实G1人形机器人上验证,零样本部署即可实现叠衣服等长程任务的高成功率。

Q:GigaWorld-0是否支持自定义场景的生成?

A:支持。用户可通过修改配置文件中的“场景参数”“物体属性”“动作语义prompt”等字段,自定义生成特定场景的具身交互数据,例如家庭场景的“取牛奶”、工业场景的“螺丝装配”等,满足不同领域的个性化需求。

七、相关链接

GitHub代码仓库:https://github.com/open-gigaai/giga-world-0

GigaTrain训练框架仓库:https://github.com/open-gigaai/giga-train

八、总结

GigaWorld-0是一款面向具身智能的开源世界模型框架,其以“世界模型即数据引擎”为核心定位,通过GigaWorld-0-Video与GigaWorld-0-3D的协同工作,首次实现90%比例的合成数据用于VLA模型训练,并在三大泛化维度实现近300%的性能提升,既解决了具身智能“数据稀缺”的行业痛点,又通过3DGS重建、PINNs物理引擎与迁移模块缩小了sim2real差距;同时其配套的GigaTrain框架实现了FP8端到端训练,大幅降低了硬件门槛,支持在常规硬件上完成模型训练与微调,且在仅20亿参数的轻量化条件下,于权威基准测试中超越大参数量同类模型,实现了性能与成本的平衡;此外,该项目已在自动驾驶、工业分拣、家庭服务等多场景完成标杆性落地,为具身智能的规模化、低成本、高泛化落地提供了开源的技术底座,也为科研与产业界搭建了具身智能研究的通用平台。

版权及免责申明:本文由@AI工具箱原创发布。该文章观点仅代表作者本人,不代表本站立场。本站不承担任何相关法律责任。

如若转载,请注明出处:https://www.aipuzi.cn/ai-news/gigaworld-0.html